かたやコンバージョン、かたや検索エンジン。対象は違えど、最適化が目的であることは共通しています。

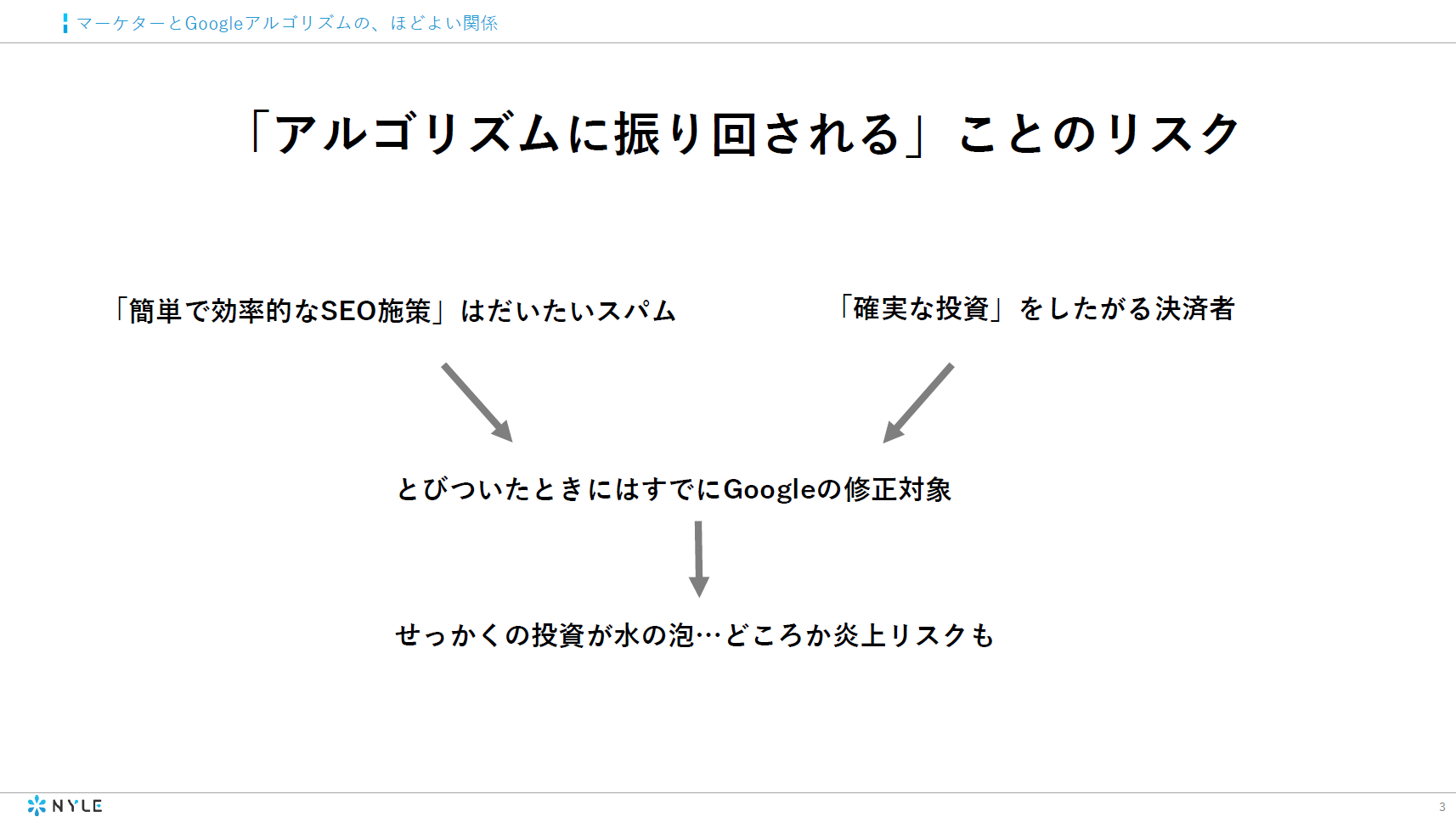

しかし、CROとSEOはそれぞれがマイナスの影響を与えてしまうといった考え方も散見されます。過去においてはそういった状況が生まれていたかもしれませんが、現在はそれぞれが補い合う(むしろ高め合う)といった関係性のほうが正しいと感じています。特にSEOは「Search Experience Optimization」であるという認識も浸透し、ユーザーに目を向ける施策と考えるべきでしょう。

今回はCROとSEOの関係性を改めて考えさせられる記事を紹介します。

※CRO=コンバージョン率最適化

※SEO=検索エンジン最適化

※今回の記事は、14,000文字弱と非常に長いものとなっておりますので、ぜひまとまった時間のある時に読んでいただければと思います。

検索意図に沿わない記事をGoogleはどのように評価するか

Webサイトへのトラフィックが急増した際の喜びは驚くべきものだ。

その理由は、ソーシャルメディアで拡散されているからかもしれないし、検索エンジンからのトラフィックが継続的に増加しているからかもしれない。

しかし、Webサイトの分析ツールのアカウントにログインした後、大きな衝撃を受けるかもしれない。

そして、

一気に落胆してしまうこともあるだろう。

なぜなら、そうしたページビューの増加が、あなたのビジネスに何一つ貢献していないことがわかったからだ。

・・・。

コンバージョンがまったくない、といった場合もあり得る。

そして、あなたはその理由を探るべく、より深い分析を行う。

ここで明らかになった事実は、上位表示させたいと願っている、あなたのビジネスにとって重要なターゲットキーワードからのトラフィックがまったくないということだった。

かのブライアン・ディーン氏(https://backlinko.com/)でさえ、この状況に陥ったことがある。彼は、「高品質 バックリンク(high quality backlinks)」というキーワードをターゲットに設定し、「ゲスト投稿をしないで高品質なバックリンクを獲得する方法(How to Get High Quality Backlinks[Without Guest Posting])」という記事を作成した。

その後、何が起こったのだろうか?

この記事は、「ハイになる方法(how to get high)」というキーワードで6位に表示されることからスタートした。

非常におもしろい。

しかし、その後、このキーワードにおける順位は12位まで下降した。

さらに、14位まで下降する。

そして、25位。最終的には33位まで下降した。

ターゲットキーワードとの関連性がなく、エンゲージメントの低い記事はいずれ順位が下降する

なぜGoogleは、「ハイになる方法(how to get high)」というキーワードで、彼の記事の順位を下降させたのだろうか?

彼の記事はターゲットキーワードとの関連性がなかったのだ。ハイになりたい人は、リンク構築などに全く興味が無いはずだ。

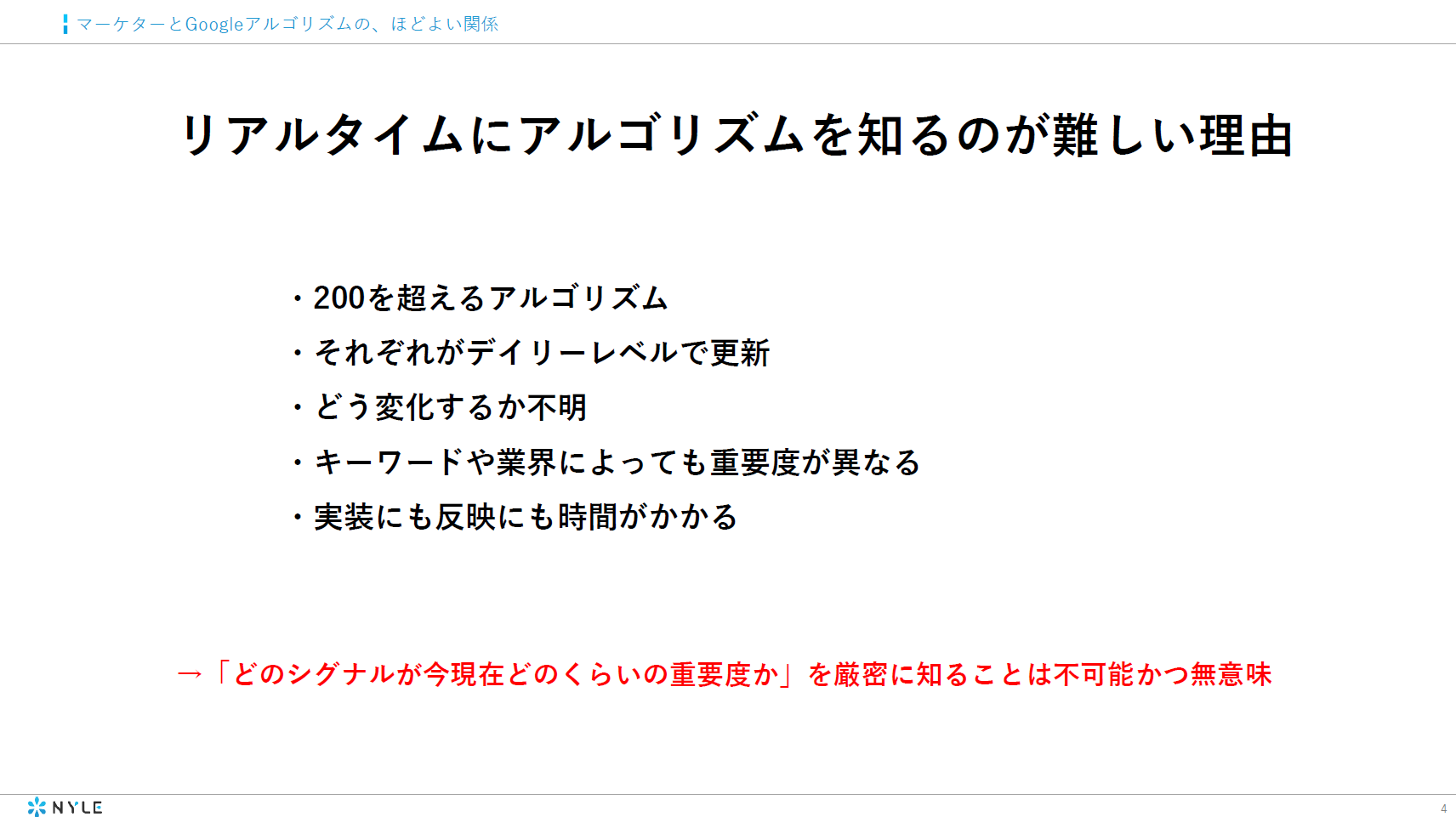

しかし、Googleのアルゴリズムは、どのようにして彼の記事を上位表示し、その後に順位を下降させるという判断を下したのだろうか?

ブライアン氏は、その答えを彼のGoogleアナリティクスのデータから発見している。彼のサイトにおける、ページの平均滞在時間は2分57秒だった。

しかし、「ゲスト投稿をしないで高品質なバックリンクを獲得する方法」の記事においては、平均の半分以下であった。たったの1分12秒である。

この記事へのエンゲージが低いと言えることは明らかではないだろうか? ハイになりたい人たちは、通常、バックリンクについて気にも留めていないだろう。

つまり、インターネット上の全ての人々があなたの顧客ではないのである(私が初めてのビジネスをローンチした際、同じ過ちをしていた)。あなたは、SEOとCROにおけるターゲット・オーディエンスを定義する必要がある。そのために、ペルソナの作成が有益だろう。

多くのキーワードから流入を獲得するだけでは、多くの利益を上げられない

しかし、私が最も主張したい内容は、「多くのキーワードから流入を獲得するだけでは、多くの利益を上げられない」、ということだ。コンバージョンの最適化も必要になるのだ。

あなたのサービスやプロダクトに興味がある、質の高い訪問客を獲得するためには、業界特有のキーワード(※)をターゲットに設定する必要がある。これこそが、コンバージョン最適化である。

※ロングテールキーワードのコンバージョン率は高い

ショートテールとロングテールのコンバージョン率を表すグラフ。ロングテールになるほど、コンバージョン率は高くなる。

より多くの顧客を獲得するために、一定のトラフィックを失う必要があることも覚悟すべきだ。

にわかには信じられないだろうか?

そういった方のために、1つの例を挙げてみよう。

ウィリアム・リード氏は、彼の顧客のWebサイトの流入成長がゆっくりと鈍化していることに気がついた。6ヶ月間で、10-13%しか成長しなかったのである。

分析を進めたところ、月間の検索数が50,000のキーワードで1ページ目に表示されていることを発見した。しかし、このキーワードは、彼のクライアントのサービスと深い関係のないキーワードであった。

そして、ウィリアム氏と彼のクライアントは、このキーワードの順位をゆっくりと下げることを試みた。また、偶然訪れたわけではない、訪問する意図を持った人々からのトラフィックを獲得することに集中した。

この施策を行うことで、ウィリアム氏のクライアントのWebサイトのトラフィックは減少していった。

しかし、彼らの利益は増加した。

馬鹿げた話しだろうか?

SEOとCROを組み合わせ、高い利益の獲得を実現する

下記のグラフを見てほしい。

※1 Revenue・・・収益

※2 Ranking・・・順位

この事実は、「最初からあなたの労力と費用をコンバージョン目的のための施策に費やすべき」ということを意味しているのだろうか?

いや、そうではない。

一定の訪問客がいなければ、最適化の対象すらいなくなってしまうからだ。

これが、私がKISSMetrics、CrazyEgg、そしてNeilPatel.comにて、Webサイトの最適化を行い、100,000人の訪問客を獲得することに注力した理由だ。しかし、トラフィックが成長するかたわら、オプトインとリードマグネットを用い、リードの獲得の準備も進めていた。下記にコンバージョンファネルを記載する。

CRO(コンバージョン率最適化)とSEO(検索エンジン最適化)はお互いを傷つけ合うものではない。自社におけるこの2つの部署は互いに施策を進め、コンバージョン・ファネルを通じて、高い利益獲得を実現すべきなのだ。

SEOとCROにおける、3つのステージとフレームワーク

「CRO(コンバージョン率最適化)とSEO(検索エンジン最適化)は共存共栄でき、高い利益獲得を実現できること」を明らかにすることが、この記事の目的である。

その目的を達成するため、3つのステージのフレームワークを用意した。より多くのバックリンクを獲得すべき段階か、より多くのランディングページを作成すべき段階かを判断し、コンバージョン率の最適化とWebサイトの最適化を導くためだ。

ステージ1:十分に練られたコンテンツ・マーケティングとリンクビルディング・キャンペーンの実施。

あなたのWebサイトに掲載しているページの多くは、顧客の生活に価値を与え、信頼を獲得し、業界内の権威を確立するために存在している。

ファネルの上部に位置する、話題になるような高品質のブログを思い浮かべてほしい。

NeilPatel.comでもいい(もちろん)。Quick Sprout、Copyblogger、ProBloggerでも良いだろう。

こうしたサイトが全ての記事において、商品(無料トライアルも含む)や有料コースの紹介をユーザーに表示しているだろうか?

そんなことをすれば、ユーザーは不快に思うことだろう。

Webサイトのエンゲージメントを下げ、結局は売上も減少してしまうことだろう。

お金を稼ぐことがビジネスを行う唯一の目的であるべきではない。ターゲットオーディエンスの人生に価値を提供することも目的とすべきだ。

ラミット・セシ氏がI Will Teach You To Be Richのサイトで、98%のコンテンツを無料で提供しているのはそのためだ。

私は98%のコンテンツを無料で提供している。私が無料で提供しているコンテンツが、他のどの有料コンテンツよりも優れた内容になることを目指している。

私もユーザーに価値を提供するためのコンテンツ作成に数千ドルを投じ、それらを無料で公開している。これが、コンバージョンファネルにおける第一歩となるのだ。

Mozのメンバーは、かつて、SEO目的のページとコンテンツマーケティングがコンバージョンを導くものと信じていた。こうしたページに訪れた新規の訪問者が、無料トライアルを試し、Mozのソフトウェアを購買し、APIの利用契約を結んでくれると考えていたのだ。

その後、Mozのメンバーは、このような短絡的な考えは良くないと気づき始めた。彼らには、訪問客をコンバージョンへと促す、よく練られたランディングページが必要だったのだ。

マーケターとして、検索者のクエリを満たすためのみに設計された、教育的なコンテンツ(下記のMozのページのように)から何を得られると考えるだろうか?

- 検索者のクエリを満足させるために設計されている。

- リンク、共有、エンゲージメントの構築を狙っている。

- コールトゥアクションは存在しない。

ターゲットオーディエンスを教育し、彼らが課題を乗り越える手助けをする。

ただ、それだけだ。

そして、どのような結果をもたらすか、あなたはすでに理解しているはずだ。

あなたのWebサイトを訪問し、記事を読むだけのユーザーもいるだろう。

もちろん、記事にコメントを残したり、ソーシャルメディアでシェアをしてくれたり、何らかの方法でWebサイトとの交流を行ったりするユーザーもいるだろう。

しかし、大多数のユーザーは記事を読み、去っていくはずだ。

「90-9-1のルール」をご紹介しよう。90%のオーディエンスはただの傍観者であり、あなたのコンテンツへの関わりは薄いだろう。

この段階で行える唯一の戦略は、コンテンツのアップグレードやリード獲得を、初回訪問者に対しEメールアドレスとの引き換えに提供することだ。こうすることで、再訪問によるトラフィックを生み出してくれるメンバーを獲得することになる。

あなたはこう考えるかもしれない。

「無料のコンテンツを提供したところで、私のビジネスにおけるROIはどうなるのか?無料トライアルの利用獲得でもないのに?」

あなたのオーディエンスへ価値を無料で提供することは、コンバージョンファネルの初期段階における関係性として非常に良好である。見込み客をファネルの内側へと導き、さらに奥へと促すことも可能だ。

自然検索からの流入の多くは、あなたのブランドへの信頼性を構築するものであり、それは無料のトライアルを開始する前に必要とされるものだ。Mozの場合、ユーザーが彼らの製品の無料トライアルを申し込む前に、平均で7.5回の訪問があるという。

こうした、無料トライアルの前段階の訪問は、MozのWebサイトのどこで発生するのだろうか?

ランド・フィッシュキン氏の言葉を引用しよう。

(無料トライアルの前段階の訪問は)4/5回はコンテンツで発生する。製品ページでもなければ、価格表やその他ファネルのどのページでもない。その内の2回はソーシャルからの訪問であり、自然検索からの流入は非常に少なく、残りの1回か2回はダイレクトの流入だ。

もし、コンバージョンに注力した考えを持っているのであれば、Webサイトへの訪問の多くが無駄なものであると考えるかもしれない。自然検索からの流入の多くが、コンバージョンにつながっていないという考えだ。

しかし、MozのWebサイトへ2~3回しか訪問していないユーザーが無料トライアルを開始したらどうなるだろうか?

おそらく、彼らの多くがMozの無料トライアルを十分に使いこなすことができず、有料版へのアップグレードも行わないだろう。

そのため、Mozはコンテンツマーケティングとコンバージョンファネルを明確に線引している。

これにより、高品質のコンテンツを作成し、バックリンクを獲得し、コンバージョン最適化を考慮し、SEOを実践するという、ビジネス上の大きなインパクトにつながるだろう。

この形式のWebサイトの最適化は、Webサイトの信頼性にポジティブに作用し、Google目線での権威性の獲得にもつながるだろう。

コンバージョン最適化を目的として商品ページを作成した場合でも、そのページへのリンクビルディングを行わずに、ターゲットキーワードで1ページ目に表示されることもあるだろう。

この説明のためにECサイトでの例を挙げたい。

下記は「men’s tuxedos(男性用タキシード)」の検索結果だ。Nordstrom’sのページが1位に表示されている。このページが最も多くのリンクやソーシャルメディアでのシェアを獲得しているからではない。Nordstrom’sのSEOとサイト全体の権威性が理由となっている。

ランド・フィッシュキン氏の解説を記載しよう。

Nordstrom’sはオンライン・オフラインの両方で高い評判を得ている。ブランド自体とWebサイト全体におけるポジティブな指標だ。

- 上位表示とコンバージョンの両方が必要

- 価値のある情報と明確なコンバージョンの導線

- ホストドメインが構築してきた権威性を活用している

新しくECサイトを構築する計画がある人は、「相手がNordstrom’sでは・・・。」と考えるかもしれない。「Nordstrom’sのようなこの業界における権威性はないし、予算だって比較にならない」と。

新しいECサイトが毎月何百万ドルも稼いでいるAmazonのような相手に打ち勝つことは可能だろうか?

答えは、Yesだ。

ブライアン・ディーン氏が紹介している、クリス・ローセン氏の例は非常に興味深い。デンマークのとあるECサイトが、一単語も記事を書かずに上位に表示されたのだから。彼が保有するJustBuyIt.comは消費者向けの電気商材を扱っている。

彼は、全くコンテンツを書かずに、どのようにして上位表示を達成したのだろうか?

彼は、業界内で引っ越し、または、閉鎖されたWebサイトへのリンクを貼っているサイトを探した。そして、そうしたサイトのオーナーに連絡をとり、自身の商品・カテゴリーページにリンクを設置することを依頼したのだ。

ブライアン・ディーン氏はこれを、Moving Man’s Methodと呼んでいる。SEOにおいて、鍵となる方法だろう。1時間ほどの作業でクリス氏はJustBuyItの被リンク数を劇的に上昇させることができた。

コンテンツに関連性のあるリンクを獲得したことで、そうしたリンクからの流入とコンバージョンを大きく向上させた。

ブライアン・ディーン氏作成の下記の動画を視聴すれば、こちらのリンクビルディングの手法がより良く理解できるだろう。

Youtube:Advanced SEO Strategy That Gets Results

SEOとWebサイトの最適化・コンテンツマーケティングについて理解を深めたいのであれば、下記の2記事をおすすめする。

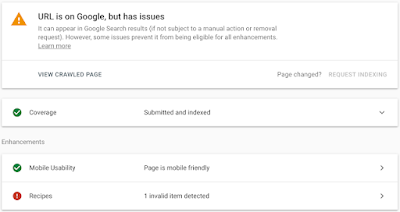

この段階では、SEOの技術的な最適化も行うべきだろう。検索エンジンにあなたのWebサイトをインデックスしやすくしてくれるようにすることが目的だ。私が執筆した、「ビギナー向け技術的SEOのスタートガイド(英語)」を参照して欲しい。

- Technical:テクニカル

技術的なSEO。この領域のSEOは、検索エンジンがあなたのコンテンツをクロールし、インデックスしやすくするための施策がメインとなる。

- Off-Page:外部施策

サイト外のSEO。この領域のSEOは、外部のWebサイトからあなたのサイトへのリンクを獲得するための施策がメインとなる。関連性があり、権威性のあるWebサイトからの自然なリンクは、「そのWebサイトへの投票」となり、検索エンジンによる信頼性の獲得につながる。

- On-Page:内部施策

サイト上のSEO。この領域のSEOは、Webサイト上のコンテンツ作成がメインとなり、関連するキーワードへの最適化を目指すことになる。訪問者への「ユーザー体験」をより良いものにすることが鍵となる。

SEOとコンテンツマーケティングの施策を行うことで、Webサイトの最適化の結果、トラフィックが上昇していくことだろう。これは、オンラインとオフラインの両方で、広告への費用を抑えることにつながるだろう。

備考:インプレッションがベースとなるモデルのビジネスを行うWebサイトについて

このステージ以上のことを望む必要はないだろう。なぜなら、より多くの時間をユーザーがあなたのWebサイトで過ごし、直帰率を下げ、多くのトラフィックが生まれること自体がコンバージョンとなるためだ。

Googleアナリティクスでこちらをゴールに設定しよう。コンバージョンファネルを意識しつつ、より多くのトラフィックを獲得し、Webサイトの最適化に注力しよう。

広告の設置場所のテストも必要だ。私が執筆した「バナー広告をより多くの人に見てもらうために」を、まずは参照して欲しい。コンバージョンファネルとコンバージョンの最適化を検討するさいに、大きな手助けとなるはずだ。

備考:SEOの成果を見極めるために3ヶ月間待ち、その後、ステージ2に進むといったやり方を私は推奨しない。可能であれば、Webサイト最適化、SEO、コンテンツマーケティング、コンバージョン最適化は、並行して行われることが理想だ。

Webサイトの最適化とオンラインマーケティングに唯一の方法などはない。広告の予算が潤沢にある場合、ランディングページを作成し、広告キャンペーンを行い、多くのリード獲得を目指せばいい。これは効果的なコンバージョン最適化の手法である。しかし、インバウンドマーケティングは、伝統的なアウトバウンドマーケティングと比べ、リードあたりのコストが62%も少ないという事実(参照)を知っておくべきだろう。

ステージ2:CROの無いSEOは存在しない。逆もまた然りだ。両者は手を取り合って進めることができるのだろうか?

権威性の構築と関連のあるコンテンツからのリンク獲得を行い、ブランド構築のためのコンテンツ作成も完了している段階だろう。願わくば、十分な量のEメールリストを保持しており、Webサイトへのトラフィックも順調に伸びている状態が望まれる。

これは、まさに、ビジネスを開始する前にターゲットとなるオーディエンス間で評判を構築しているためのアプローチである。

しかし、Webサイトの最適化とSEO戦略を用いてトラフィックを獲得する理由はどこにあるのだろう?

自然検索からのコンバージョンを獲得するために他ならない。より正確に表現すると、自然検索の流入から収益を得るためである。

あなたは、自身のWebサイトを、ただコストを垂れ流す存在にはしたくないはずだ。

CROをSEOの敵と考えるべきではない。両者は共存することが可能なチームであるのだ。

オンラインの体験の90%が検索から開始されるが、マーケティング費用の全てを検索結果における上位表示を獲得するためだけに使うことはできないだろう。

特定のキーワードにおける順位とは、究極的には虚しい指標となってしまう。あなたはすでに、自然検索へのスムーズなナビゲーションと最高の体験の提供に注力すべきことを理解しているはずだ。そうすれば、顧客があなたのWebサイトに何のために訪問したかが理解できるようになる。

CROの重要性を説明するために、私自身のビジネスの事例を紹介したい。

Crazy EggというWebサイトの事例だが、こちらのトップページの最適化を行うために、CROのエキスパート達を雇用した。

彼らはコンバージョン率を30%高めるという偉大な結果を残した。

どのようにして彼らはこの数字を達成したのだろうか?

彼らは、簡潔であったトップページを長文形式の訴求コンテンツに変容させた。改修されたページは20倍ほどの長さになった。

※トップページを改修し、長文化した図

私は長い形式のコンテンツの効果を信じていたため、非常に喜んでいた。長いマーケティングコピーであれば、ユーザーのあらゆる疑問や目的に対応できると考えていたのだ。そして、それは常にコンバージョンにおいても良い結果を生むと考えていた。

この時までは・・・。

長い形式のトップページのヒートマップを見てみると、ページ下部(価格が記載されている箇所)に向かってエンゲージメントを獲得できているわけではないということに気がつく。

※ヒートマップの色が赤から青に変わるにつれ、エンゲージメントが下がっていることを示す

Copyhackersのジョアンナ氏の説を引用したい。

彼女はセグメント化した顧客のSEO調査を行い、また、テスト用に4つのタイプのトップページを作成した。

そう。短いコンテンツも含まれている。

結果はどうだっただろうか?

最も効果的だったコンテンツは、表面的なストーリーのない、簡潔なコンテンツだった。最も効果的だったコンテンツの長さは60%ほどであり、訪問者が抱える主要な関心事と目的には回答できており、コンバージョンファネルに沿って設計されていた。Webサイト最適化の偉大な事例だったと考えている。

自然検索からのトラフィックにおけるコンバージョンは13%も増加した。

そして、長い形式のコピーはあらゆる状況で効果的であるという私の仮説は間違いであったことがわかった。簡潔なマーケティングが成功することについては、「ロングコピー対ショートコピー – どちらがよりベターか?(英語)」に詳細を記載している。

これこそが、私が自身のWebサイトのテストを行うために、CROコンサルタント達を$252,000で雇用した理由である。Webサイトへのトラフィック単体では、ビジネスの成功を判断するためには、信頼できない指標となってしまうのだ。

一日に10,000の流入があるが、数秒で離脱してしまうユーザーが多いという場合、何が原因となっているのだろう?

もしかしたら、CROがSEOにマイナスの影響を与え、自然検索結果からの流入が減少してしまうということを恐れているかもしれない。

そこで、Webページのランキングに影響する要素を見てみよう。そして、CROのテストで必要な箇所も確認してみよう。

- KW(Keyword & On-Page)・・・キーワードとオンページ

- CQ(Content Quality)・・・コンテンツの品質

- DA(Domain Authority)・・・ドメインの権威性

- PA(Page Authority)・・・ページの権威性

- UD(User & Usage Data)・・・ユーザーデータ

- SP(Spam Analysis)・・・スパム分析

CROは上記のSEOに関連する要素のうち、3つの領域の変更にすぎない。よほど怪しい施策を行わない限り、ドメインとページの権威性が失われることはないはずだ。

CROのための変更は、これら3つの要素(キーワードとオンページ、コンテンツの品質、ユーザーデータ)の変更に過ぎない

CROのスプリットテストを行い、ページのコンテンツ、キーワードの使用率などを変更してみよう。

これらの要素を、検索エンジン経由で訪問するユーザーに最も関連するバランスを取ることができれば、コンバージョン率も高まるだろう。

しかし、こうした変更は、ただ単にコンバージョンを増加させるものではない。

コンバージョンの最適化、エンゲージメント、ページ滞在時間なども増加させるだろう。なぜなら、検索経由のユーザーはよりあなたのページに興味を持つはずだからである。

そして、

サイトの滞在時間と直帰率はランキングに影響することをご存知だろう(画像)。

CROのためのキーワードの変更などがSEOにマイナスの影響を与えると考える必要はないだろう。

さらに、SEOとCROのチームが手を取り合いながら議論できる、全体的なマーケティング戦略の施策のための2つのアイデアを紹介したい。

1.検索結果の広告で、実際にユーザーがランディングしたデータを活用する

厳格なテストの結果、あなたの現状のコンテンツはユーザーの意図に即していないことがわかったとする。

この結果を受けて、SEO担当者は何をすべきか?

オーディエンスが実際に使用する用語を含め、検索エンジン経由のユーザーの期待に沿うように、コンテンツの最適化を進めるのだ。Webサイトを居心地のいい場所にし、コンバージョン最適化を用いて目的を明らかにさせるのだ。

ケイト・モーリス氏が、非常に優れた例を提供してくれている。PPCキャンペーンからのCROがオンページSEOにおける改善を提供してくれるという内容だ。

2.ブライアン・ディーン氏による、クラシックな手法だ。彼が作成した、トラフィックを獲得するためのコピーライティングのリストを見てみよう(参照)。

まずは簡単な質問から始めよう。検索結果におけるより多くのクリックを獲得したくはないだろうか?

もちろん、Yesだろう。

より高いCTRはより多くのトラフィックを生み、最終的にはランキングにも影響する。

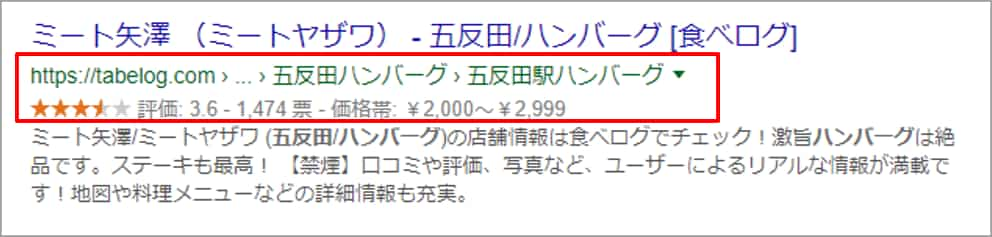

検索結果画面に表示されるスニペットは、メタ・ディスクリプションの内容が反映されることはご存知だろう。

下記で、最適化されたスニペットとそうではないスニペットの比較をしてみよう。

- 上部・・・最適化されていないスニペット

- 下部・・・最適化されたスニペット

どちらがより多くのクリックを獲得できるかは、明らかだろう。

メタ・ディスクリプション内にターゲットキーワードを含めるのはよいことだ。しかし、160文字のテキストで、ユーザーの関心を惹かなければならない。

ユーザーが抱える問題に対するソリューションがあるということを、どのようにして訴求すべきか?

検索結果画面でのCTRを高めた実績のある単語やフレーズを使用するのだ。

そうした単語やフレーズはどこにあるのだろう?

それは、アドワーズの文言の中にある。

こうした広告はマーケティング会社が多くのコストを投じて作られており、300%を超えるROIをもたらしている。

彼らは数千のスプリットテストを行い、顧客へ最も効果的に訴求できる言葉を選び、クリックを獲得している。これを使わない手はない。

あなたのスニペット文をより効果的にするため、こうしたワードをメタ・ディスクリプションに含めるのだ。

例を挙げてみよう。

ブライアン・ディーン氏の「リスト構築」の記事のスニペットを下記に記載する。

※訳:あなたがメーリングリストを作るのに使える、とてつもなく実用的なリスト構築戦略。より多くのメール購読者を得るならこちらをクリック

それほど魅力的な内容ではない。

タイトルタグは見切られており、メタタグの内容も意味をなしていない。

ブライアン氏は彼の記事の主題である「リスト構築」をアドワーズで調べてみた。

そして、「リスト構築」というキーワードは、「Eメールリスト」という単語とよく使われていることを発見した。

彼は、「Eメールリスト」という単語をメタ・ディスクリプションに含めた。

そして、「構築」や「成長」といった単語もよく使用されていた。

こうしたアイデアを自身のメタ・ディスクリプションに含めてみた。

非常にシンプルではなかろうか?

このようにして、ブライアン・ディーン氏は、より多くのクリックを獲得するマーケティングワードのリストを作成したのだ。

ここで、彼の戦略をあなたが行う場合に有用となるツールを紹介しよう。

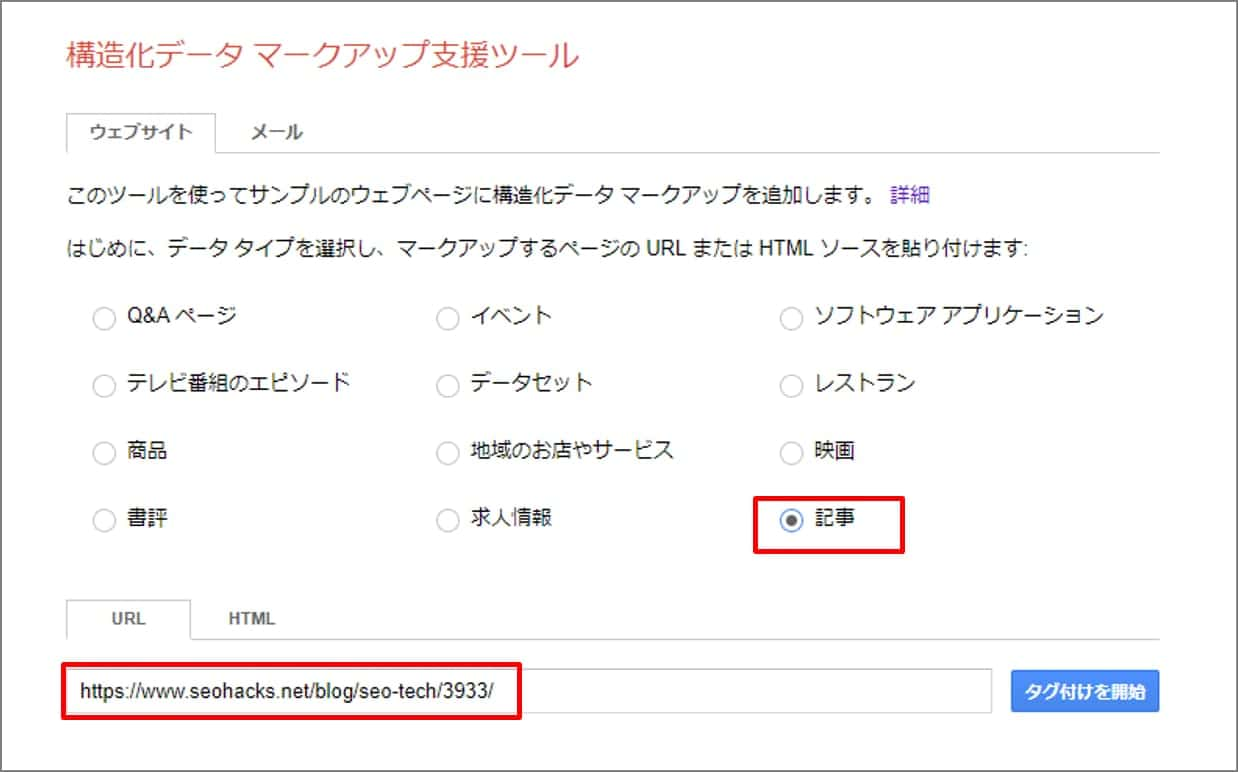

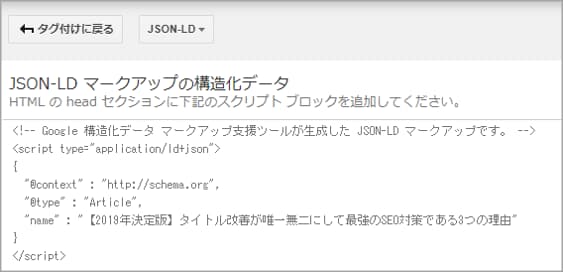

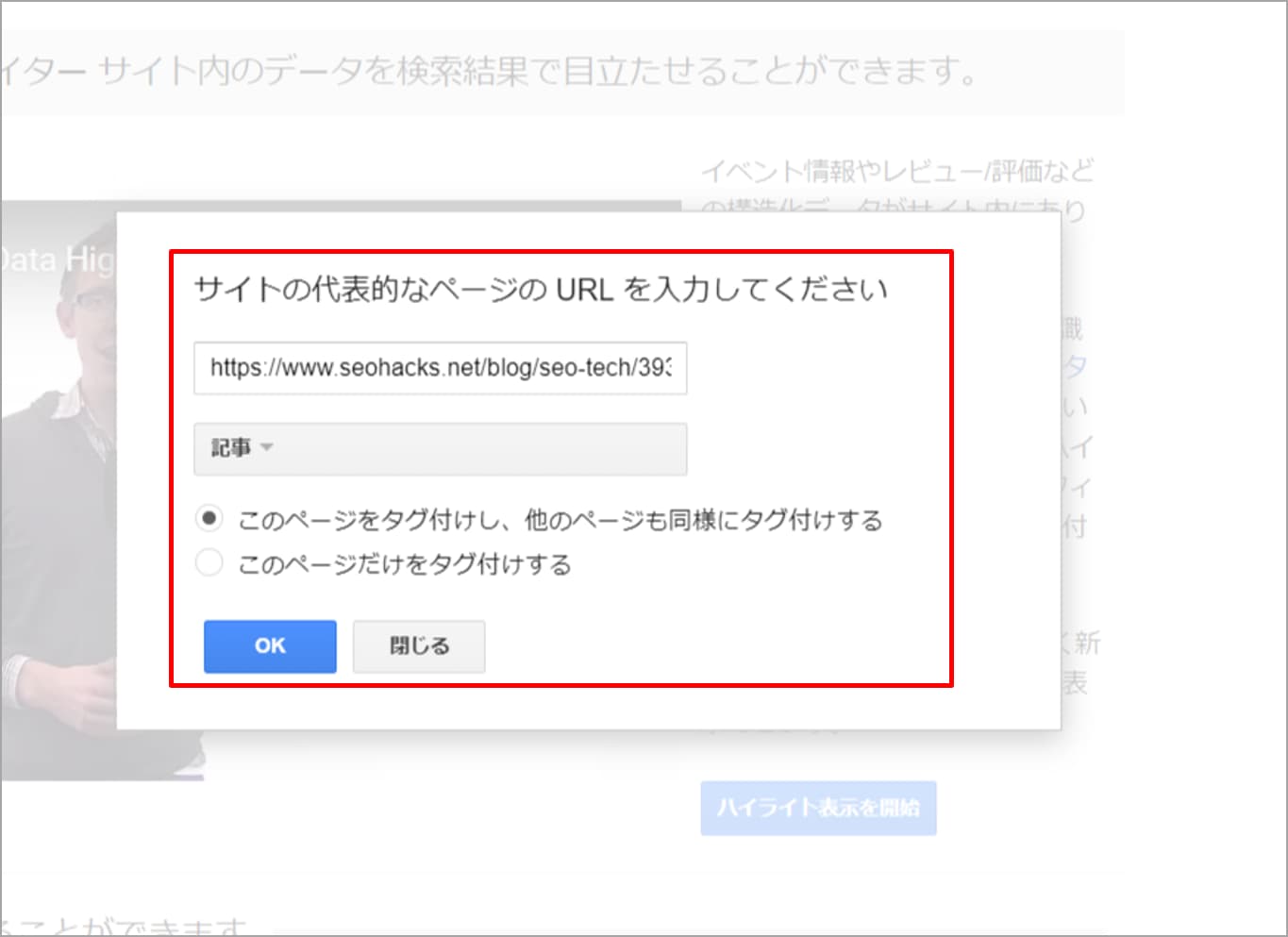

効果のあるメタディスクリプションを作成するためのツール

i.Spyfu.com

(日本語非対応と思われる)

キーワードを入力し、ページ下部までスクロールしよう。

入力したキーワードの全てのアドワーズ広告が表示される。下記は、「keyword research」の結果だ。

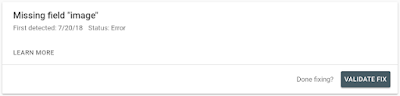

ii.Yoast SEO

ワードプレスを使用しているのであれば、この非常に強力なツールを使用することでメタ・ディスクリプションの編集が容易になるだろう。アドワーズの文言から得たアイデアを組み込めばいい。

※Yoast SEOを使うと、タイトルやメタディスクリプションなどの項目を記事ごとに容易に変更することができる。日本語対応もされている

備考:A/Bテストを行うために、ユーザーごとに違うコンテンツを提供することが、Googleを混乱させてしまうと心配する必要はない。Googleボットにも、ユーザーと同じコンテンツを表示させてあげればよい(クローキングをしないということだ)。

そして、A/Bテストのために使用するURLには、rel=canonicalを設置しよう。その他のアドバイスは、「WebサイトのテストとGoogle検索(Google Webmaster Central Blog)」を参照して欲しい。GoogleもA/Bテストの実施を勧めている。Google自身も彼らのコンテンツに対するテストを行っているのだ。

ステージ3:CROとSEOの争いを終わらせよう。比類なきユーザー体験を訪問者に提供することに注力しよう。

Webサイトを根幹から見つめ直した場合、CROもSEOもユーザーに注力することが求められていることに気がつくだろう。検索エンジンのボットに提供するものではないのだ。検索エンジンのアルゴリズムを騙す行為は、安定的でなく、効果的でもない。

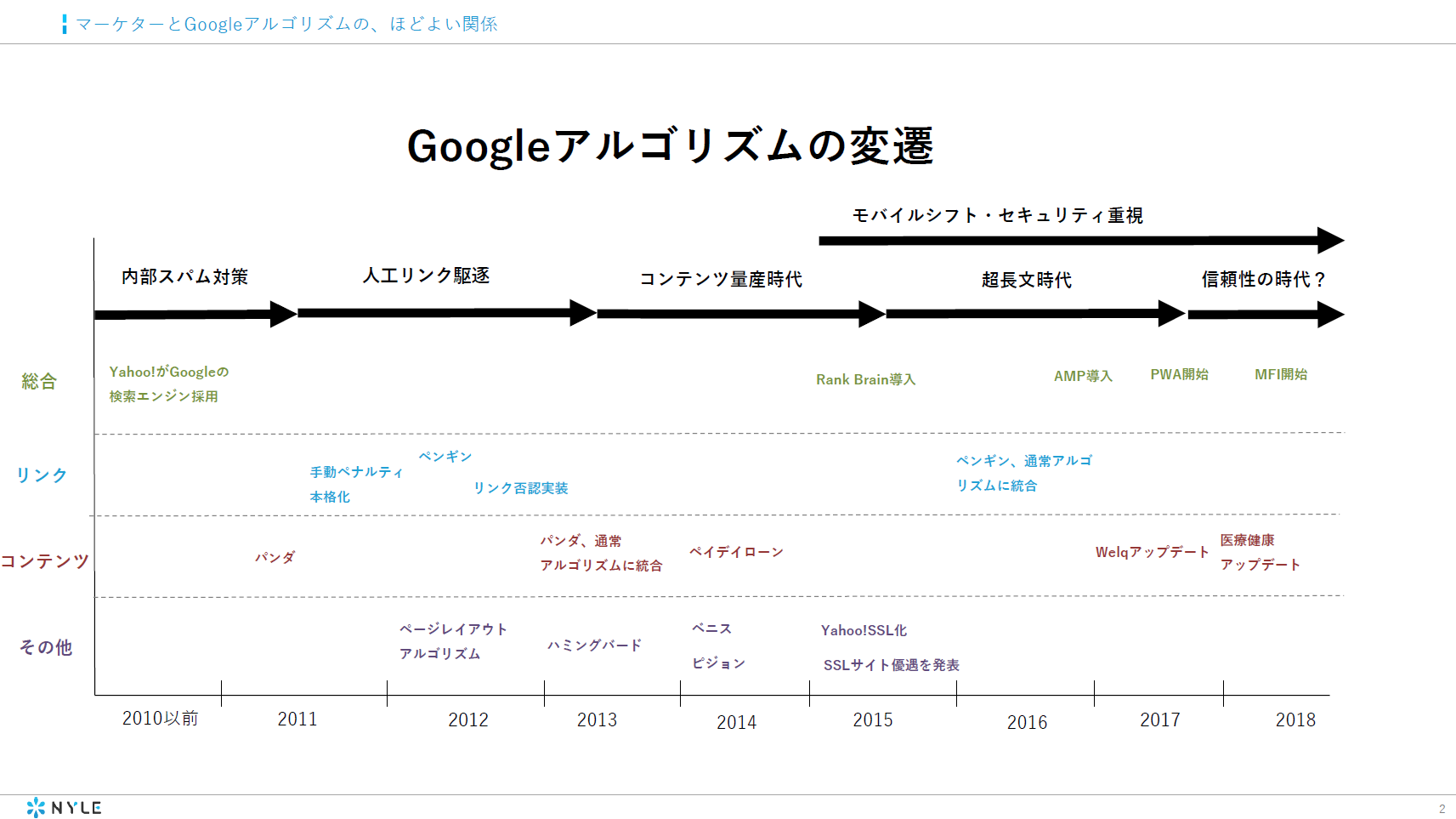

5年前まではCROとSEOに影響を与える異なる要素があり、ユーザー体験は組み込まれていなかった。しかし、Googleのアルゴリズムは常に進化している。

複数のアップデートの結果、SEOとCROは共に最高のユーザビリティを顧客へと届けることに主眼を置くものになった。

ページスピードはランキング決定の重要な要素であり、遅いページはコンバージョンにも影響する(1秒の遅れは売上の7%の喪失に値する)。

付加価値を与える内容と関連性のあるコンテンツは上位表示させるために重要な要素だ。同様に、より多くのコンバージョンを得るためには、強力な価値の提案が必要であり、それは説得力と関連性のあるコピーによって作られる。そうすることでしか、見込み客をコンバージョンファネルの次のステップに導くことができない。

人工的なリンク構築はもはや意味をなさない。権威性のあるページからのリンク獲得が重要だ。コンバージョンへと導くリンクを獲得することは、ランキング上昇の強力な後押しとなる。

適切な見出しタグを使用して、コンテンツの優位性をつける。ユーザーの期待に沿うため、目次の掲載はSEOにおいても有効だ。あなたが届けたいメッセージの順番を注視することになるため、コンバージョンの増加も期待できる。

数千ドルの費用をユーザー体験のために投資することは、理にかなっているだろうか?

ユーザー体験におけるROIについては、下記の動画を視聴して欲しい。

Youtube:The ROI of User Experience

かつて、私はユーザー体験(UX)をSEOの未来だと考えていた。今では、ユーザー体験がどれほど重要か、あなた自身が実感していることだろう。

「オンラインマーケティング(online marketing)」の検索結果を見て欲しい。私のWebサイトであるQuick Sproutが1位に表示されている。ForbesやWikipediaといった、権威のあるサイトよりも上位なのだ。

ページ単位の指標を確認してみると、私の記事が最も多くのリンクを獲得しているわけではないことがわかる。ページの権威性のスコアも、最上位ではない。

しかし、私のWebサイトは最高品質のユーザー体験を提供しているはずだ。独自のグラフィックの作成や各領域のエキスパートを採用するために、$40,000の費用を投資した結果である。

似たような例を紹介しよう。デレック氏は、彼の顧客にアピールするために、エレガントでシンプルなデザイン設計のために、$25,000を彼の新しいブログに投じた。優れた考えを持ち、受領歴のあるデザイナーを徹底的に探したのだ。

パーソナル化された体験をオーディエンスへと届けるその他の例として、パット・フライム氏の例を挙げよう。彼は、135,000名のEメールリストの管理をAweberからInfusionsoft、そして、Convertkitへと変更した。

彼はなぜこのようなことをしたのだろう?

定期購読者にパーソナル化された体験を届けるためだ。彼らの興味に即して、最も関連性のあるコンテンツのみを提供するのだ。

短期的なコンバージョンの増加に注視すべきでない。ネガティブなメッセージのポップアップでEメールのリストを増やしても、長期的な関係を結ぶことはできないだろう。

(訳:あなたの肌を破壊し続ける驚くべき32の物質:健康的な肌を手に入れる)

長期的な成功を目指そう。

あなたが提供する価値に説得されたユーザーの生涯価値は、騙すことによってEメールのリストに追加されたユーザーのそれと比べ、非常に高いものとなるだろう。

顧客により良い体験を提供することは、顧客のロイヤリティにも寄与し、コンバージョンの最適化を導くものだ。ハーバードビジネスレビューによると、カスタマーリテンションを5%あげることが、収益を25%増加させることになる。

これが、ユーザー体験の最適化がCROの中心に位置づけられている理由である。ユーザー体験の重要な要素をベースとして、あなたのWebサイトを設計しよう。

結論:SEOとCROは共存共栄の関係である

Webサイトへのトラフィックが充分でない場合は、ステージ1のキラーコンテンツの作成から取り掛かろう。なぜなら、コンバージョンの最適化は、コールトゥアクションのボタンの色、位置、サイズ、フォントなどの変更によってのみ達成されるものではないのだから。

顧客の調査から始め、自身のブランドをアピールしよう。よく練られた、訴求力のある言葉を作成しよう。ターゲットとなる顧客があなたのブランドを発見すれば、あなたはシンプルなコンバージョンへの道筋を提供する。こうした一連の作業が、コンバージョンの最適化となる。

A/Bテストを行うに足る、十分なトラフィック量はあるだろうか? そうであれば、ステージ2に進んで欲しい。SEOとCROから得られた両方のデータを活かすことで、高いエンゲージメントと売上を達成する手助けとなるだろう。

究極的には、ターゲットオーディエンスのユーザーインテントを満たすことになるのだ。コンバージョンを最適化し、高品質で関連性のあるコンテンツの作成に努め、最高の体験を顧客に提供することだ。

CROとSEOは常に共存できる関係であることを忘れないで欲しい。CROのテストを行い、フラッシュを使用したWebサイトが高いコンバージョンであったとしても、SEOを破滅させるものではない。

ケイト氏は、SEOを安定させたままコンバージョンの最適化を行うための5つのステップを紹介してくれている。

全体的なマーケティング戦略を採用することで、より良質な訪問客を獲得することができる。SEOとCROをうまく統合させることは、あなたのビジネスのオンラインマーケティングの目標達成の手助けとなるはずだ。

この記事を読むことで、CROとSEOは対立するマインドセットではないことをご理解いただけたと思う。

さあ、次はあなたの番だ。あなたのデジタルマーケティングの戦略は、ユーザー体験を考慮に入れたものとなっているだろうか? CROがSEOの手助けとなる(逆もまた然り)事例をお持ちの場合は、ぜひ共有していただきたい。

記事中にもありましたが、Googleのアルゴリズムは常に変化・進化を続けており、検索エンジンを騙す手法は淘汰され続けています。反対に、ユーザーに目を向けるべき傾向は加速し続け、今後もこの傾向は変わらないはずです。

CROもSEOも、その手法や指標は違えど、ユーザー体験を第一に考えることは共通でしょう。

Webサイト最適化の名の下、それぞれの施策を効率よく組み合わせていければ理想ですね。

アイオイクス株式会社では、SEOとCROを中心としたコンサルティングサービスを行っております。

ご興味のある方は、ぜひ一度サービスページをご覧ください。

(@seodanbrooks)

(@seodanbrooks)

John

John