Apple(アップル)はWWDC 2021で、さまざまなニーズに対応するアクセシビリティ機能を発表した。その中には、通常の方法でデバイスに触れたり話したりすることができない人々のための機能も含まれている。Assistive TouchやSound Controlなどの改良により、これらの人々はiPhoneやApple Watchと対話するための新たな選択肢を得る。

Assistive Touchは発表時にも取り上げたが、先日、その詳細が明らかになった。この機能は、Apple Watchを持っている人が、さまざまなジェスチャーを使って片手で操作できるようにするものだ。腕が欠損している人や腕を思いどおりに使えないといった四肢に障がいを持つ人々のコミュニティからの、Apple Watchを気に入っているが、鼻で電話に出るのにはうんざりだという声を同社が耳にしたことから生まれた。

関連記事:Apple Watchに検知した手の動きで操作する「AssistiveTouch」機能が追加

研究チームは、他の指と親指をくっつけたり、手を握りしめたりするジェスチャーをApple Watchが正確に人気する方法を開発した。これらのジェスチャーとそのダブルバージョンは、さまざまなクイックアクションを設定することができる。その中には、ユーザーの手首の動きを模した小さなドットである「モーションカーソル」を開くものもある。

手の不自由な人が多いことを考えると、音声操作に頼らずにジェスチャーでメッセージや通話、健康管理といった基本的な操作を行えるため、とても便利だ。

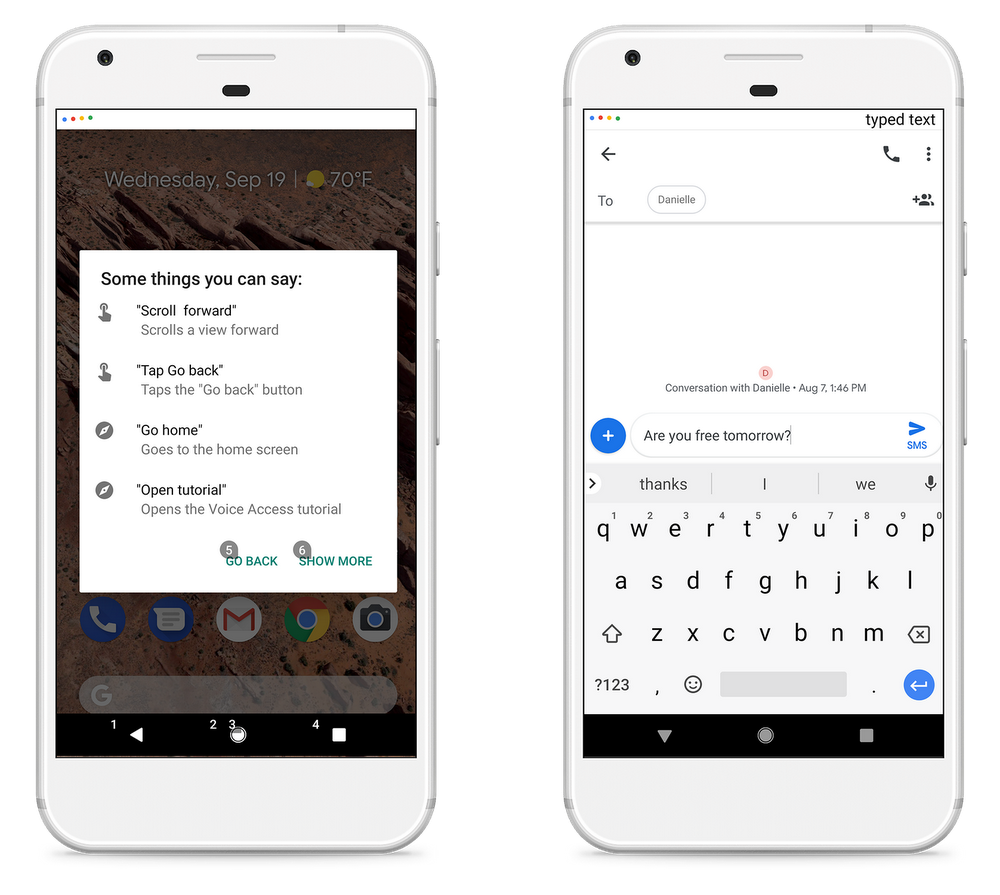

とはいえ、声も誰もが自由に使えるものではない。しかし、流暢に話すことができない人でも、基本的な音をたくさん出すことができるため、それらに意味を持たせてもいい(Siriには無理だけど)。「Sound Control」という新しいアクセシビリティオプションを使えば、これらの音を音声コマンドとして使うことができる。オーディオでもボイスからではなく、Switch Control(スイッチコントロール)からアクセスして、オーディオスイッチを追加する。

画像クレジット:Apple

セットアップメニューでは「click(カチッ)」「cluck(コツッ)」「e(イ)」「eh(エッ)」「k(クッ)」「la(ラァ)」「muh(ムフ)」「oo(ウ)」「pop(ポン)」「sh(シー)」などさまざまな音を選ぶことができる。音を選択すると、システムがその音を正しく理解していることを確認するための簡単なトレーニングプロセスが表示され、その後、アプリの起動、よく使われる質問、他のツールの呼び出しなど、さまざまなアクションを設定することができる。

Apple製品をスイッチシステムで操作したいという方に、同社は大きなサプライズを用意していた。かつてはゲームにしか使えなかったゲームコントローラーが、一般的な用途にも使えるようになる。Xbox Adaptive Controllerは、ボタンやスイッチなどのアクセサリーのハブとグループで、コンソールゲームのアクセシビリティを改善する。この強力なツールは多くの人に利用されており「Fortnite(フォートナイト)」を終えてポッドキャストを聞きたいときに、操作方法を完全に切り替える必要がないことに感謝するに違いない。

画像クレジット:Apple

iOSの機能の中で、アクセシビリティの観点からもう1つ興味深いのが「Walking Steadiness(歩行時の安定性)」だ。この機能は、iPhoneを持っている人なら誰でも利用でき、ユーザーの歩行の安定性を追跡します(ご想像のとおり)。この指標は、1日または1週間を通して追跡することで、人の運動能力がいつどのように向上するのかを実際に把握できる可能性がある。この指標は、Apple Heart and Movement研究で収集された、実際の転倒やそれにつながる不安定な動きなどのデータに基づいている。

最近、義足を装着した人、足の手術をした人、めまいに悩まされている人などは、いつ、どのような場合に転倒の危険性があるのかを知ることは非常に重要だ。本人は自覚していないかもしれないが、夕方以降や階段を上った後、長時間並んだ後などは、動きが安定しない。また、義肢に慣れたり、慢性的な痛みが軽減したりすることで、着実に改善していくこともある。

このデータを実際の理学療法士や医師がどのように利用するかは未知数だが、重要なのは、ユーザー自身が容易に追跡し、理解できることだ。

画像クレジット:Apple

さらにAppleのその他の支援機能として、音声コントロールの新しい言語、ヘッドフォンの音響収容力の向上、双方向補聴器のサポート、そしてもちろん、人工内耳や酸素チューブのメモへの追加がある。同社の担当者がいうように、機能面だけの違いではなく、パーソナライゼーションや楽しさの面でも違いを受け入れたいと考えているようだ。

関連記事

・iOSアプリ内でそれぞれのサブスクの管理や返金が可能に、アップルがStoreKit 2を発表

・iOS 15でSpotlightが大幅強化、アプリのインストールも可能に

・アップルのRealityKit 2で開発者はiPhone写真を使ったAR用3Dモデル作成が可能に

カテゴリー:ヘルステック

タグ:Apple、WWDC、WWDC2021、アクセシビリティ、iOS、Apple Watch

画像クレジット:Apple

[原文へ]

(文:Devin Coldewey、翻訳:Hiroshi Iwatani)

XACは最近のイベントで正式公開されたが、数日前にリークもされていた。デバイスは2つの巨大なプログラマブルボタンと大型の十字ボタンからなっている。後部の3.5 mmポートには、ブローチューブ、ペダル、Microsoft製のアクセサリーなど実に様々な種類のデバイスを接続できる。

XACは最近のイベントで正式公開されたが、数日前にリークもされていた。デバイスは2つの巨大なプログラマブルボタンと大型の十字ボタンからなっている。後部の3.5 mmポートには、ブローチューブ、ペダル、Microsoft製のアクセサリーなど実に様々な種類のデバイスを接続できる。