カメラの中には何があるだろう? レンズ、シャッター、感光面、そしてますます高度になるアルゴリズムのセットだ。物理的なコンポーネントは少しずつ改善されているが、Google、Samsung、そしてAppleは、完全にコードから生み出される精巧な改善に投資を増やし、そして披露している。計算写真学(Computational photography)だけが、今では唯一の実際の戦場なのだ。

このシフトが起きた理由はとても簡単だ。少なくともカメラの動作原理が全く変わってしまうことなしには、カメラが現在のものよりも遥かに良くなることはないからだ。スマートフォンメーカーたちは写真でどのように行き詰まり、それしてそれをどのように乗り越えることを強いられたのだろうか。

バケツが足りない

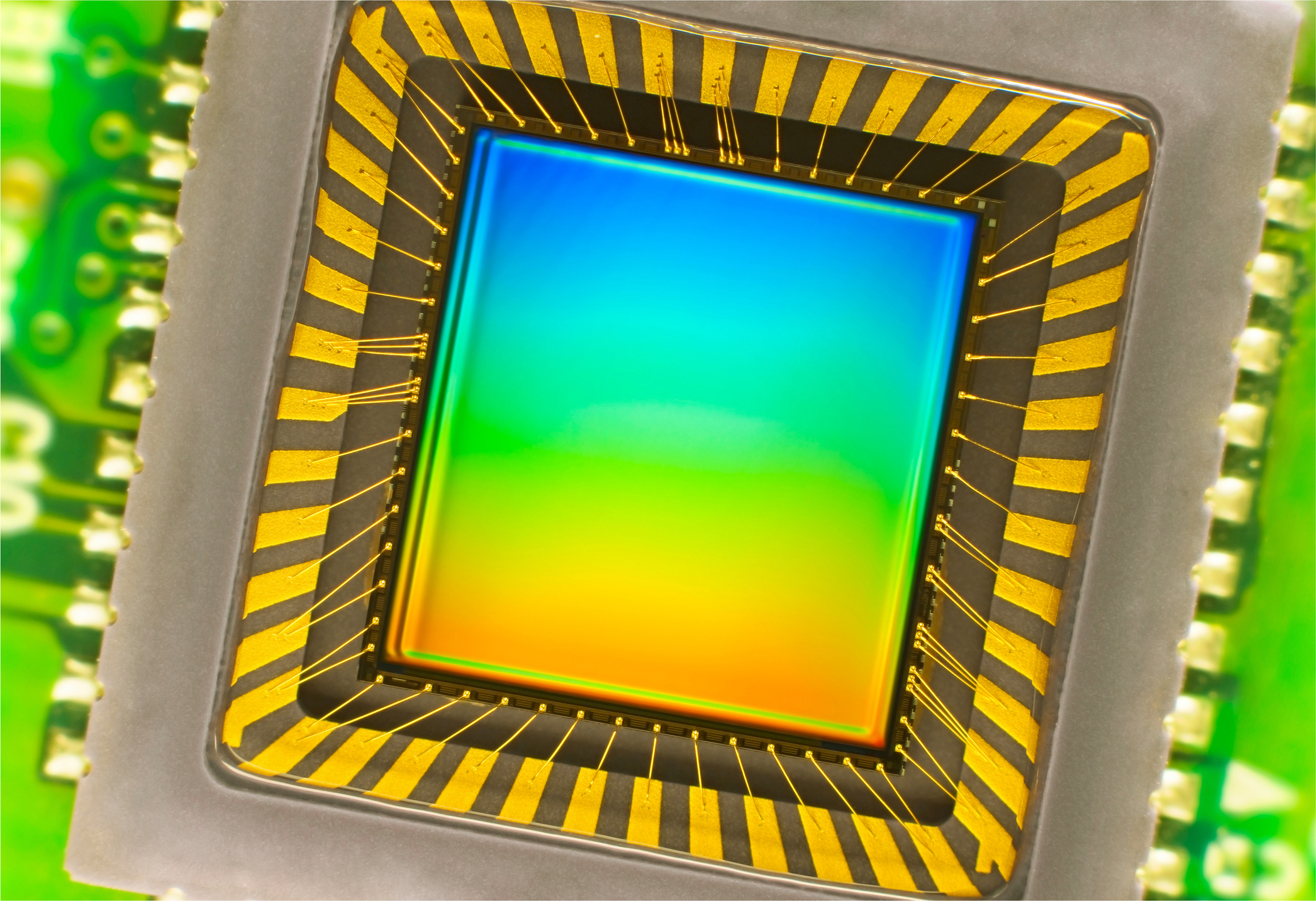

スマートフォンカメラの中のセンサーは本当に素晴らしいものだ。Sony、OmniVision、Samsung、その他のメーカーたちによって成し遂げられた、小さくても感度がよく多才なチップの設計と製造は、真に驚嘆に値する。デジタル写真の進化をその初期から見守っているカメラマンにとって、この顕微鏡でなければ見ることのできない小さなセンサーが提供する品質のレベルは驚愕以外の何物でもない。

しかし、こうしたセンサーにはムーアの法則は存在しない。むしろ、ムーアの法則が現在10ナノメートル以下のレベルで量子論的限界に達しているように、カメラセンサーは遥かに早く物理的な限界に達していた。センサーに当たる光を、バケツの集団に落ちる雨として考えてみよう。より大きなバケツを並べることはできるが、その場合は並べられる数が少なくなる。逆により小さいバケツを並べることもできるが、その場合は個々のバケツは十分な雨を集めることができない。バケツの形を正方形にしたりジグザグに配置したりといったあらゆる工夫を行うこともできるが、最終的には雨粒がとても多ければ、いくらバケツの並びを工夫してもそれを捕え切ることはできない。

もちろんセンサーはますます良くなっているが、そのペースは消費者たちに毎年新しい電話を買わせるほど速くはない(性能が3%良くなっただけのカメラを売ることを想像して欲しい)。しかし電話機メーカーたちはしばしば同じあるいは類似のカメラ構造を採用しているために、そうした改善(例えば最近起きたバックサイドイルミネーションセンサーへの移行など)は全員に共有されている。ということで、センサーだけで他社に先行することはできない。

おそらくレンズを改良できるのでは?それは難しい。レンズは、特に小型のものは、これ以上改良することが難しいあるレベルの洗練度と完成度に達している。スマートフォンのカメラ筐体の内部のスペースが、限られているという言い方は相当控え目な表現だ。そこにはもう1平方ミクロンの余裕もないのだから。どれだけの光が通り抜け、どれほどの歪みが少なくなるかに関してはわずかに改善の余地があるかもしれないが、こうした問題は、ぼぼ最適化され尽くした古い問題なのだ。

より多くの光を集める唯一の方法は、レンズのサイズを大きくすることだ。そのためには、A:ボディから外側に突き出す、B:内部の重要な部品を置換する、またはC:電話機を厚くする、といった方法がある。Appleが受け入れると考えられるオプションはどれだろうか?

振り返ってみると、Apple(およびSamsung、Huaweiなど)は、「上記のいずれでもない」という選択肢Dを選ぶしか無かった。もしより多くの光を受けることができないならば、受け取った光そのものを使って、何とかしなければならないというだけだ。

すべての写真が計算では?

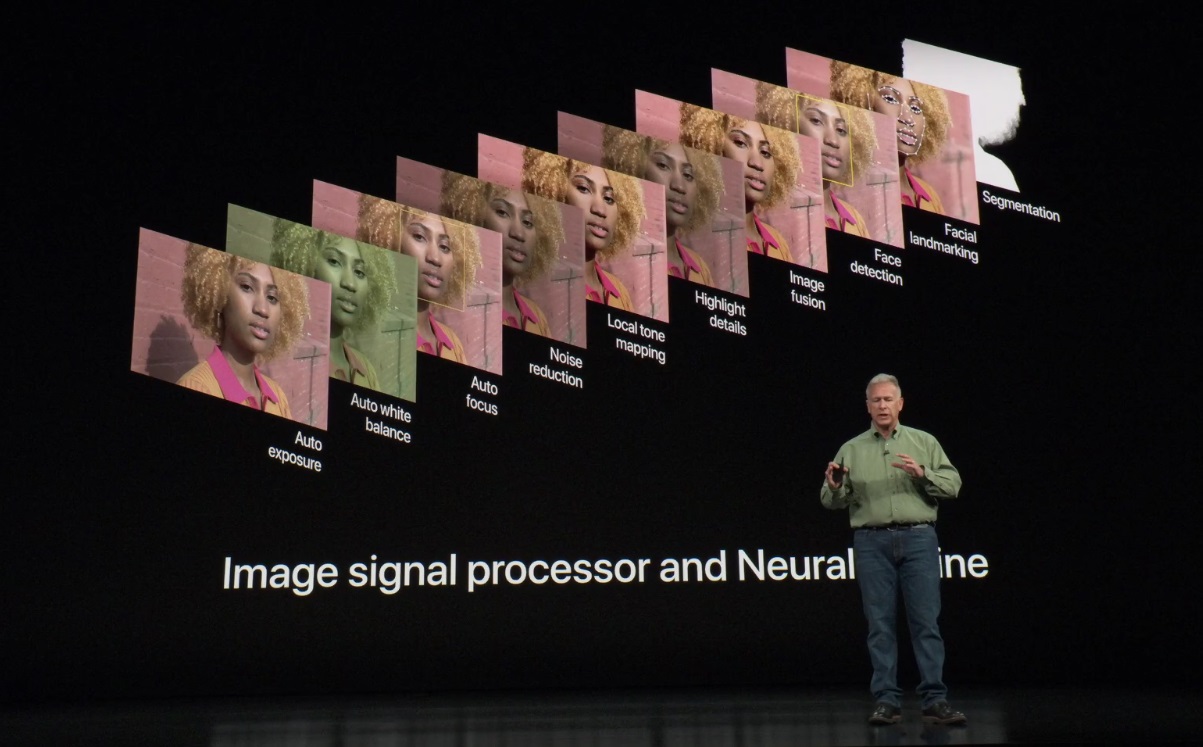

計算写真学(computational photography)の最も広い定義には、まさにあらゆるデジタルイメージングが含まれる。フィルムとは異なり、最も基本的なデジタルカメラでさえ、センサに当たる光を使用可能な画像に変えるための計算が必要だ。そしてカメラメーカー毎にこの計算をする方法は大きく異なっている。このため異なるJPEG処理方法や、RAWフォーマット、そしてカラーサイエンスが生み出されている。

長い間、処理能力の不足もあって、この基本層のさらに上にはほとんど関心が寄せられていなかった。とはいえ確かに、各種のフィルターはあったし、カメラ内で素早くコントラストとカラーを調整する手段はあった。しかし、結局のところ、これらは単にある程度自動化されたパラメータ調整に他ならなかった。

最初に登場した真の計算写真学的機能は、間違いなく、オートフォーカスのための物体識別ならびに追跡機能だった。顔と目の追跡により、複雑な照明やポーズの中で人間を簡単に捕らえることができるようになり、オブジェクトトラッキングによって、フレームを横切って移動する対象に対してシステムがオートフォーカスを行ってくれるために、スポーツやアクション撮影が容易になった。

これらは、画像を改善したり次のステップにわたすために、画像からメタデータを抽出して、それを積極的に利用する初期の例だった。

デジタル一眼レフ(DSLR)カメラでは、オートフォーカスの精度と柔軟性は目立つ機能なので、こうした初期の利用例は理にかなっていた。しかしいくつかのギミックを除けば、こうした「真面目な」カメラたちは一般的に、計算を極めて素朴なやり方で使っていた。より高速のイメージセンサーが意味することは、より速いイメージの転送の必要性であり、カラーと細部の保存などのために余分なサイクルが必要とされるということだ。DSLRはライブビデオや拡張現実には使用されていなかった。そしてかなり最近まで、スマートフォンカメラにも同じことが当てはまっていた。それは今日私たちが知っている多目的メディアツールというよりも、対象を狙って写真を撮影するものだったのだ。

従来のイメージングの限界

様々な場所で行われる実験や、時折生まれる変わり種にもかかわらず、スマートフォンのカメラはほとんど同じままだ。それは数ミリメートルの厚みに収まらなければならず、そのことで可能な光学的手法は限られることになる。センサーのサイズも同様に制限されている。DSLRは23mm×23mmのAPS-Cセンサーを使用することができる(面積は345mm2)。一方iPhone XSはおそらく現在市場にあるもののうちで、最大かつ最新のものだが、その大きさは7mm×5.8mm程度で、その面積は40.6mm2だ。

大雑把に言えば、そのカメラは「通常の」カメラよりも遥かに少ない光量を集めるだけだ。にもかかわらず、ほぼ同じ忠実度や色で場面を再現することを期待されている。ピクセル数もほぼ同じだ。一見これは解決不可能のような問題に見える。

従来的な意味での改善も役に立つ。例えば光学的および電子的なブレ防止によって、ぶれることなしに長時間の露光が可能になり、より多くの光を集めることが可能になる。しかしこれらのデバイスはそれでもなお、無理難題を実現することを迫られているのだ。

幸運にも、既に述べたように、皆は同じボートの中にいる。基本的な制限があるため、AppleやSamsungがカメラを再発明したり、競争相手よりも先行できるクレイジーなレンズ構造を考え出すことはできない。彼らは皆、同じ基本基盤を与えられてきたのだ。

したがって、すべての競争は、これらの企業がその基盤の上に構築するもので構成されている。

ストリームとしての画像

計算写真学における重要な知見は、デジタルカメラのセンサーから来る画像はスナップショットではなく、より一般的に考えられているということだ。従来のカメラでは、シャッターが開閉し、感光媒体をほんの一瞬だけ露光させる。これはデジタルカメラがやっていることではなく、あるいは少なくとも彼らができることではない。

カメラのセンサーには絶えず光が当たっている。前の比喩に戻るなら、雨が絶え間なく一面のバケツの上に降り注いている状態だ、だがもし写真を撮影しないなら、これらのバケツは皆底なしで、だれもその内容をチェックしない。それでも雨は降り続けている。

画像を取得するために、カメラシステムは、雨滴の計数を開始する時点を決め、センサに当たる雨滴を数える。そして計数を終了する時点を決める。従来の写真撮影用途では、これによりシャッタースピードをほぼ任意に短くすることができるが、これは小型センサーではあまり役に立たない。

なぜ、常時記録していないのだろうか?それは理論的には可能だが、それはバッテリを使い果たし多量の熱を発生させてしまうだろう。幸運なことに、ここ数年画像処理チップは、カメラアプリケーションが動作している間、そのストリームの一定の連続部分、例えば最後の60フレームを制限付き解像度でキャプチャできるほど効率的になっている。確かに、それは多少バッテリーを消費するが、それだけの価値がある。

そのストリームにアクセスすることで、カメラはあらゆる種類のことを行うことができる。コンテキスト(状況)を追加するのだ。

ここで言うコンテキストは多くのことを意味する。例えば照明や被写体までの距離などの写真要素だったり、動き、対象、そして意図だったりもする。

コンテキストの簡単な例は、一般にHDR(高ダイナミックレンジ)画像と呼ばれるものだ。この手法では、異なる露光量で連続して撮影された複数の画像を使用して、1回の露出では露出不足または露出過多となった筈の、画像の領域をより正確に撮影する。この場合のコンテキストとは、それらがどの領域であるか、そして画像をインテリジェントに結合する方法を理解するということだ。

これは、非常に古い写真技術である「露出ブラケット」で達成することができるが、もし画像ストリームが常に複数の露出範囲を生成するように設定されているならば、何の予告もなく簡単に実現できる。それはまさに、GoogleとAppleが現在行っていることなのだ。

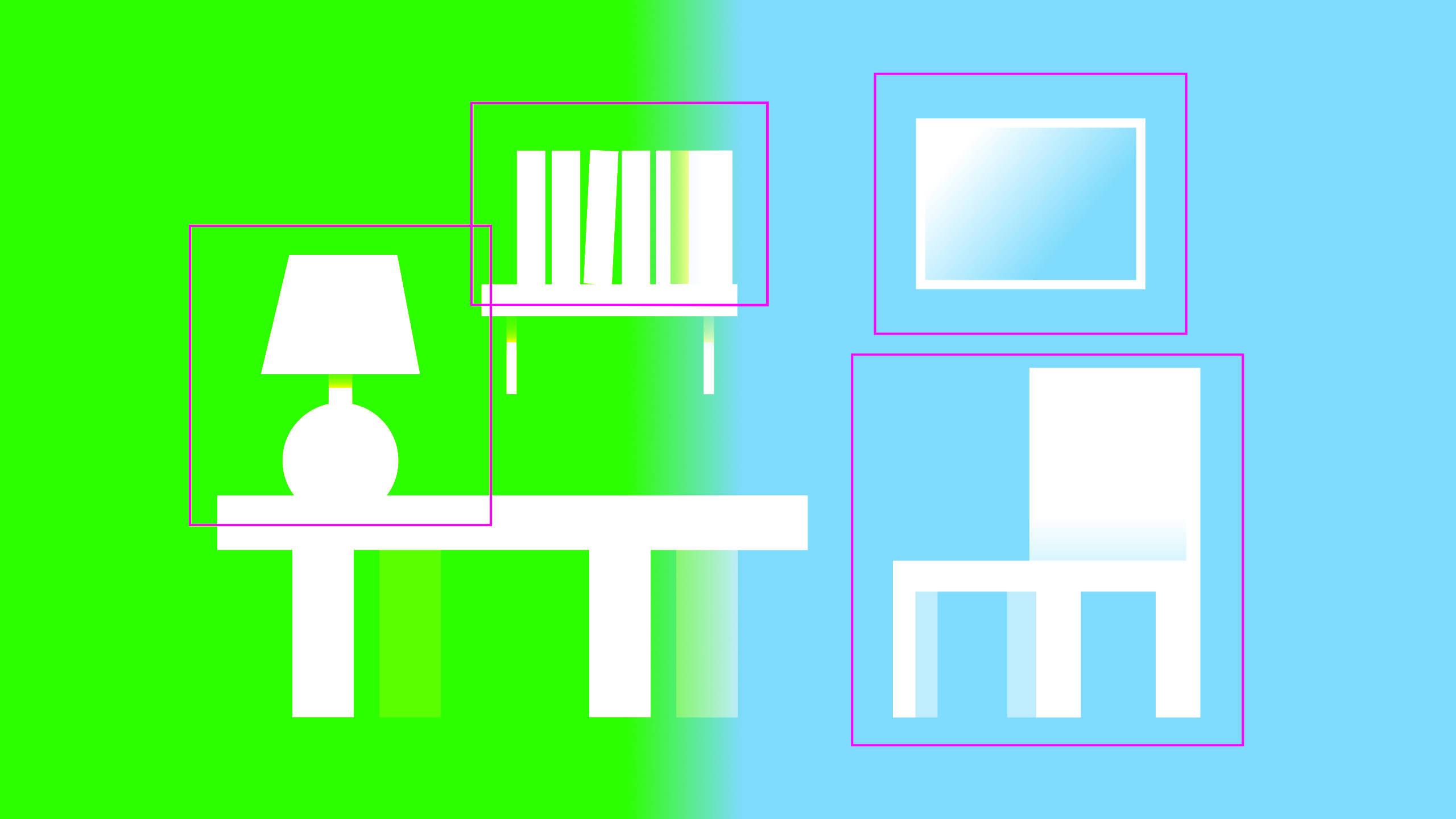

もちろん、より複雑な「ポートレートモード」や、人工的な背景ブラーやボケなどが、ますます一般的になってきている。ここでのコンテキストは、単に顔までの距離だけではなく、画像のどの部分が特定の物理的オブジェクトを構成しているのかということや、そのオブジェクトの正確な輪郭を理解することだ。これは、ストリーム内のモーション、複数のカメラによるステレオ分離、および人間の形状を識別して輪郭を描くように訓練された機械学習モデルから導き出すことができる。

これらの技術は、第一に必要なイメージがまずストリームからキャプチャされている(イメージセンサーとRAMスピードの進化のおかげ)ことと、第二に企業たちが、そうした計算を行う高度に効率的なアルゴリズムを開発し、膨大なデータと計算時間を使って訓練したことによって、ようやく可能となったものだ。

しかし、これらの技術について重要なことは、単にそれらを行うことができるということだけではなく、ある企業は他の企業よりもそれを優れた方法で行うことができるということだ。またこの品質の全ては、注がれたソフトウェアエンジニアリング作業と、芸術的監修の賜物である。

DxOMarkはいくつかの初期の人工的なボケシステムの比較を行った。しかし、結果はやや不満足なものだった。それはどちらがより良く見えたかというよりも、効果をうまく適用できたかそれとも失敗したかという評価になった。計算写真学は、機能が単に動作するというだけで人びとを印象付けることができる位、まだまだ始まったばかりなのだ。後ろ足で立ち上がって歩いている犬を見たときのように、私たちは単にそれが起きたということだけで驚いている。

しかし、Appleはボケ問題に対して、馬鹿げた過剰エンジニアリングだと指摘する人がいるほど力を入れている。単にその効果を再現する方法を学ぶだけではなく、自由に使える計算パワーを用いてそれを生み出す光学現象の仮想的な物理モデルをも作り出した。これは、単に跳ねるボールのアニメーションを作ることと、現実的な重力と弾性体物理をシミュレートすることとの違いに似ている。

なぜそこまでやるのだろうか?Appleは他社にも知られているものは何かを知っているので、計算能力の限界を心配するのは馬鹿げている。ガウスぼかしのようなショートカットを採用している場合、光学現象がどのくらいうまく再現できるかには限界がある。もし光子のレベルでそれをシミュレートしたならば、上手く再現できるレベルに限界はない。

同様に、5枚、10枚、または100枚の画像を1枚のHDR画像に合成するという考え方は馬鹿げたもののように思えるが、写真撮影では情報が多い方が、ほとんどの場合優れているというのが真実だ。これらの計算アクロバットのコストがごくわずかで、結果が明白に違う場合に、デバイスにこうした計算をさせない理由はない。数年後には、それらも普通のことのように見えるようになるだろう。

もし結果がより良い製品であれば、計算パワーとエンジニアリング能力は上手く使われたということだ。ちょうどLeicaやCanonが、たとえば2000ドルのズームレンズのような、安定した光学システムから、なんとかわずかでも性能向上を引き出すために数百万ドルを費やすように、Appleその他の企業は価値を生み出せる場所にお金を使うのだ、ただしガラスではなくシリコンに対して。

ダブルビジョン

私が説明してきた計算写真学の物語と矛盾するように見える1つの傾向は、複数のカメラを含むシステムの出現である。

この手法は、センサに光をあまり加えようとはしない。それは極めて複雑で光学的には高価になり、おそらくはうまくいかないだろう。しかし、長さ方向に少しスペースを空けることができれば(奥行き方向ではない、これは実用的ではないとわかっている)、完全に独立したカメラを最初のものの側に置き、最初のカメラによるものと非常に似た写真を撮ることができる。

もしここでやりたいことが、単にウェインズ・ワールド(米国の喜劇映画の名前)を感知できないスケールで再現すること(カメラ1、カメラ2、….、カメラ1、カメラ2、 …と切り替える)だとしたら、必要なのはこれだけだ。しかし、ほんの僅かの距離だけ離れたイメージを同時に撮影したい者は普通はいない。

これらの2台のカメラは、独立して(広角とズームのように)動作するか、または1つは他のものを増強するために使用されて、複数の入力を持つ単一のシステムを形成する。

1つのカメラからデータを取り出し、それを使って別のカメラのデータを強化することは、想像できると思うが、非常に計算集約的な行為である。同じレンズやセンサーで撮影されていないため、はるかに複雑であることを除けば、複数の露出を行ったHDR問題のようなものではある。最適化することはできるが、それで簡単にはならない。

したがって、第2のカメラを追加することは、実際に物理的手段によって画像化システムを改善する方法ではあるが、最新の計算写真学によって改善できる可能性があるというだけの話だ。そして、より良い写真をもたらすのはその計算画像の品質である。そうでなければ失敗する。16個のセンサーとレンズを備えたLightカメラは、確立された計算写真学の技術を使ってより大きな画像を生み出そうとしながらも、優れた画像を生成することができなかった、野心的な試みの1例である。

光とコード

写真の未来は計算に依存している、光学ではない。これは、パラダイムの大規模な変化であり、カメラを製造または使用するすべての企業が現在取り組んでいるものだ。これにより、既存のDSLRカメラ(ミラーレスシステムに急速に移行している)、電話機、組み込み機器、そして光がキャプチャされて画像に変換されるあらゆる場所に影響が及ぶことになる。

このことは、私たちがこの先耳にするカメラは、ピクセル数や、ISOの範囲、F値などに関する限りは、昨年のものとほぼ同じであることを意味することになるかもしれない。それで問題はない。いくつかの例外を除いて、これらは合理的なレベルで期待できる範囲では既に十分良いものになっているのだ:ガラスはこれ以上きれいにならないし、私たちの視覚もこれ以上精細にはならない。光が私たちのデバイスや眼球を通り過ぎる方法はあまり変わらないだろう。

しかし、それらのデバイスが、光を扱う方法は、驚くべき速度で変化している。これは、冗談のように聞こえる機能や、疑似科学のハッタリや、バッテリーの速い消耗を招くことになるだろう。だがそれも問題ない。私たちがカメラの他の部品に対して前世紀に様々な実験を行って、様々な完成レベルを達成したように、私たちは新しい、品質や私たちが撮影するイメージに、非常に重要な影響を持つ非物理的な「部品」に挑戦するのだ。

[原文へ]

(翻訳:sako)