【編集部注】著者のColin O’DonnellはIntersectionの主任イノベーションオフィサーである。

都市テクノロジーの専門家として、私は実際に人びとが使っている魅力的なスマートシティアプリケーションの例を教えてくれ、と頼まれる機会が多い。しかし正直なところ、実際に指し示すことができるものは多くない ― 少なくとも今の段階では。都市はますます賢くなっている筈だが、利用者の眼から見ると目立って変化しているようには見えない。

これまでの都市のデジタル進化のほとんどは、人びとが見たり、触れたり、使ったりできる部分ではなく、むしろ目に見えないところで進み、市の運営そのものに焦点が当てられて来たのだ。もちろん、行政が水漏れをより良く検知できたり、建物検査の失敗予想の精度を向上させることはとても重要だ。しかし都市居住者たちに対する直接的で個人的な便益としては現れていない。従って、あまりこの分野には進展はないと考える人がいても、不思議ではない。

都市居住者としての私たちが、革新的スマートシティアプリケーションにまだ驚かされていないのは、スマートシティは退屈なものだからだ。これはデータウェアハウスの概念に対して、人びとが顔を輝かせないことと同様の理由だ(OK、そこの人たち落ち着くように)。スマートシティとはゴールへ向かうための手段に過ぎない。真のデジタルシティへの道の、途中の1ステップに過ぎないのだ。

都市が、その住民たちに実際に有形の利便性を提供し、インターネットの可能性完全に実現した都市へ進化していくためには、以下の3つのフェーズを通過することになる。1)まず環境に関するデータを収集する必要がある。2)次にそのデータを処理する必要がある。そして最後に、3)リアルタイムのアクションで反応する必要があるのだ。これを縮めて言うなら:See、Think、Do(見よ、考えよ、行動せよ)ということになる。

See ― インストゥルメンテッドシティ

ここ数十年というもの、私たちはずっとインストゥルメンテッドシティ(センサーなどの機器が行き渡った都市)に住んできた。センサー、センサー、そしてセンサー。今やセンサーはそこらじゅうに溢れている。オフィスのドアから自転車置場、そして街角の信号にもセンサーは埋まっている。全てが定量化されており、これが将来の都市開発の礎になる。何かを変えるためには、まずそれを測定することができるようにする必要がある。

Think ― スマートシティ

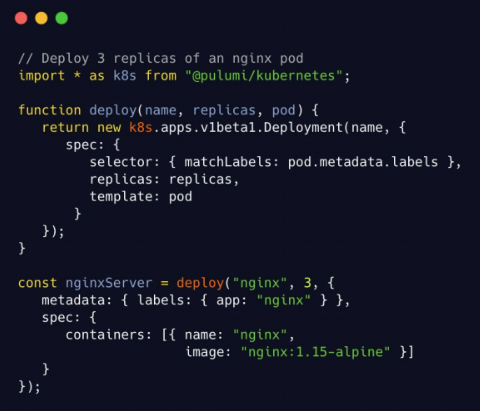

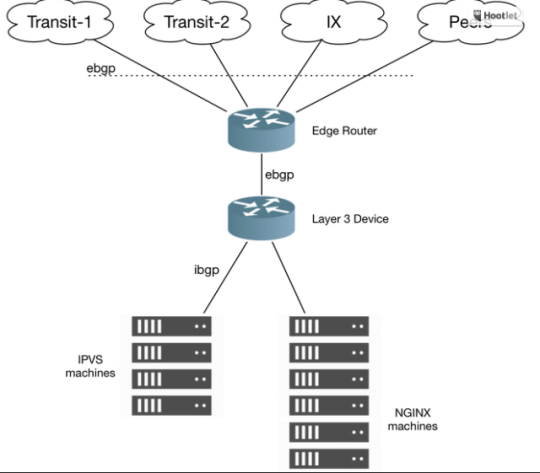

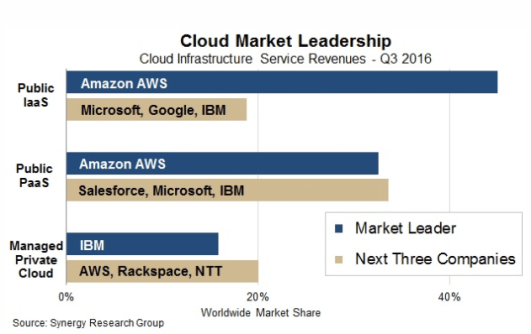

さて、そうして集めたデータをどうするのだろうか? ここが、GEやIBM、そしてAT&Tのような企業たちが、ここ数年注力してきた領域だ。スマートシティでは、センサーが行き渡った都市から発生するデータから洞察を得る。これはデータプラットホーム、アルゴリズム、そしてデータサイエンスを活用して行われる。私たちが測定したものを理解するだけではなく、なぜそれが重要なのかも理解できるようにできる。

私たちは、相関関係と因果関係の構築を行い、人間の行動を予測してテストするためのモデルを作り、なぜある出来事が起きたのか、そして変更がどのような影響を及ぼすのかに関する洞察を得る。AIは、膨大な量のデータを分析し、都市の状況を理解する上で、大きな役割を果たすようになって行くだろう。しかしそれらは皆、今のところ「舞台裏」の仕掛けだ。ちょうど誰もが電子メールやWeb1.0サイトを使い始める前の、インターネットのようなものだと考えてみれば良い。もちろん、それは重要で、世界の働きを変えつつあると思うが、どうして私がそれを気にしなければならないのか? 私には何ができるのか?

Do ― レスポンシブシティ

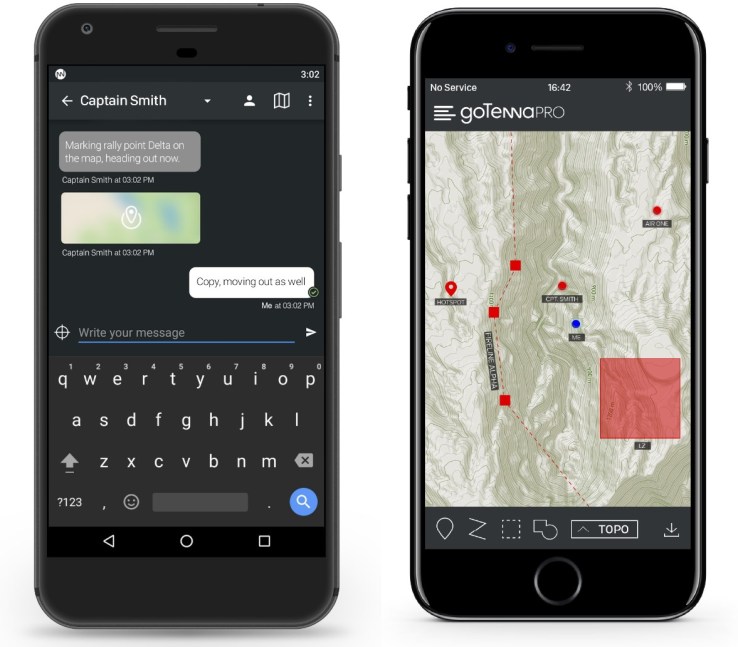

さて、ここから物事は面白くなる。何かが本当に起こり、人びとが違いに気付き、感じるようになる。開発と新製品のチャンスが最も多いステージだ。レスポンシブシティ(反応型都市)とは、その名前が表すように、市民の要求、願望、そして欲望に反応する都市である。この場合の「市民」は労働者でも居住者でも、単なる訪問客でも構わない。すべてがリアルタイムに実行され、アプリケーションを用いたアクティブでリッチな体験となる。

インストゥルメンテッドシティで発生したデータと、スマートシティで得られた洞察を用いて構築されるレスポンシブシティは、ハードウェア、データ、そして基礎サービスの上に載った、アプリケーションレイヤーのようなものだ。

都市では、これらのアプリはインフラストラクチャを操作したり、都市を動的に最適化する振る舞いに影響を与えたりすることに焦点を当てている。目標となる成果は、安全性、利便性、そして効率性はもちろんだが、発見、喜び、そしてコミュニティも対象となる。これらのすべてが、都市を魅力的にするものたちをサポートする。多様な背景を持ち、共通の時間を共有する市民たちにとって、魅力ある場所にするのだ。

これはすべて、デジタル化された制御可能なインフラストラクチャに依存している。そしてそれは急速に実現されつつある。UberとLyftは、予想される輸送ニーズに基づいて、自分たちを先行してデザインしたコネクテッドカーの例だ。

デジタルスクリーンとダイナミックな街頭施設も、レスポンシブなインフラストラクチャの初期の例だ。都市の中で拡張現実レイヤーのように振る舞う可能性と同時に、こうしたプロダクトは街頭の風景内にリアルタイムに情報を挿入し、人びとに情報と影響を与える。そして人びとを様々な方法で支援する:少し考えるだけでも、市民がよりよい移動を行えるようにしたり、市からのお知らせを表示したり、リアルタイムに緊急事態を知らせたり、といった例を挙げることが可能だ。

都市はこうしたトランスフォーメーションへの準備が整っている。デジタルインフラストラクチャー、オートメーション、そしてマシンラーニングによって、要求に対して予測とともに反応する能力が登場し、数百万人の人びとを相手にした結果を最適化することができるようになるだろう。

現代は、都市管理者、社会活動家、そして起業家たちに、大きなチャンスが与えられているのだ。それは新しい経済機会を創造し、行動を変革し、現代都市を真に再定義するために資源を再配分するためのチャンスだ。この革命に必要とされるインフラストラクチャーは、整備されつつあるが、どのようにすれば都市は最終的に、このレスポンシブな最終ステージに進むことができるのだろうか?

効率的なレスポンシブシティへの道を切り拓くためには、都市には以下のものが必要である:

リソース、アクセス、そして成果に対するパートナー

私たちは、都市で可能なことに対する私たちの先入観を捨てて、望ましい成果を考えるところから始めなければならない。都市の管理者たちは、改革の必要がある未使用のリソースやインスラストラクチャーをまず同定する必要があり、それらを民間部門と提携したり協力したりして、利用しやすいものにしなければならない。官民のパートナーシップは、相互の利便性に基いて整理されなけれなならない。例えば、どんな心身状態の人たちに対しても幅広いアクセスを許し、特定の解決方法や、事前に決められた調達手段に固定されないというようなことだ。

人びとのグループを理解し、その行動に影響を与えること

レスポンシブシティはその中に暮らす人びとを反映したものだ。インターネットは私たちに、ビデオや製品、あるいは友人たちを推薦することで、パーソナライゼーションで可能なことを垣間見せてきた。他でもない、あなたという個人 に対して。しかし、都市の体験は本質的に1対多だ。50人が1つの表示を見て、それらを一緒に体験する。しかし個々人は異なる背景を持ち、またおそらく個々人の目的は異なっている。これは興味深い研究分野を拓くものだ。すなわち人びとのグループを理解すること、そして環境の変化に対して彼らがリアルタイムにどのような反応を示すのかを理解するということだ。

環境の変化とは、例えば、オンデマンド歩行者天国のための動的な道路閉鎖のようなものだったり、異なる移動能力を持つ人びとをイベントに向けて最適な経路で案内したり、オープンしたばかりのお店を案内したりというものかもしれない。いずれにせよ、人びとの要求と都市側の要求の間のバランスを、リアルタイムで調整することは、探究すべき新しい刺激的な領域となるだろう。それは都市計画と、ユーザーエクスペリエンスと、行動科学の融合だ。

リアルタイムに行なうこと

レスポンシブシティになることは静的な目標ではなく、常に変化する目標だ。私たちは、過去の固定された単一目的のインフラストラクチャの概念を乗り越える必要がある。人間と都市の変化に合わせて動的にリアルタイムに変化するインフラストラクチャに焦点を当てる必要があるのだ。この焦点は何年もかけて都市が変化するマクロレベルなものだけに対応するのではなく、一瞬一瞬、例えば朝の通勤からランチまでの間という短い単位にも対応する必要がある。

インターネットは、私たちがやっているすべてのことを変えて来た。すなわち私たちが生活する方法、働く方法、遊ぶ方法、情報へのアクセス方法、そしてお互いのコミュニケーションを変えたのだ。しかし、それは常に、その変革の可能性の期待に応え続けて来られたわけではない。私たちはインターネットが、不寛容さを育て、隔離され視野狭窄に陥ったグループを生み出すところを目撃してきた。

そして、現在の住民が生まれる遥か昔に死んでしまった人びとによってデザインされて、その変化が何十年も掛かる都市計画によって測られる都市は、淀んで柔軟性を失ったものになる可能性がある。都市は、それを実際に利用したり、働いたり、生活している人びとを代表するものではない。

しかし、インターネットが都市の中に進出するにつれ、私たちはインターネットをより人間的に、そして都市をよりダイナミックにする機会を得た。

私たちは、異なる文化や背景や能力を持つ人々が、都市に対してだけでなく、人びと同士でもデジタルな相互作用を共有できる、真のコミュニティ体験を構築することができる。私たちは、環境を形作り、リアルタイムで情報を共有し、人びとやリソースをお互いにより良く繋ぎ合わせることができる。私たちには包括的なデジタル都市体験を作り上げる機会が与えられている。そしてそれは、レスポンシブシティから始まるのだ。

FEATURED IMAGE: PRASIT PHOTO/GETTY IMAGES

[原文へ]

(翻訳:sako)