このロックダウン期間中に、膨大な数の人が仕事でビデオ会議を行っている。しかし、燃料を使う通勤手段をデジタルコネクティビティで置き換えると、個人が2時間のビデオ会議で使用するエネルギーは、4マイル(約6.4km)電車に乗る場合に使う燃料よりも大きなものになる。これに加えて、数百万人の学生が、徒歩ではなくインターネットを使って教室に「通って」いる。

一方、デジタル空間の他の領域では、科学者たちが研究を加速するためにアルゴリズムを猛烈な勢いで展開している。にもかかわらず、ひとつの人工知能アプリケーションのパターン学習フェーズが消費するエネルギーは、1万台の自動車が1日で消費するものを上回る可能性があるのだ。

社会のエネルギー使用を変化させるこの壮大な「実験」は、少なくとも間接的には、ある高レベルの事実セットで見ることができる。4月の第1週までに、米国のガソリン使用量は30%減少したが、全体的な電力需要の現象は7%未満だった。この動きは、実際のところ将来の基本的な傾向を示している。移動用燃料の使用量は最終的には回復するだろうが、真の経済成長は電気を燃料として使うデジタル未来に結びついている。

今回の新型コロナウイルス(COVID-19)危機は、経済が最後に崩壊した2008年のような「大昔」のインターネットと比べて、2020年のインターネットがどれほど洗練され、堅牢であるかを浮き彫りにしている。もし当時、全国でロックダウンが行われていたとしたら、現在在宅勤務している数千万人のほとんどが、解雇された約2000万人の集団に加わっていただろう。また当時だったら、何千万人もの学生や生徒が自宅で学習することも、大学や学校にとって現実的なものではなかった。

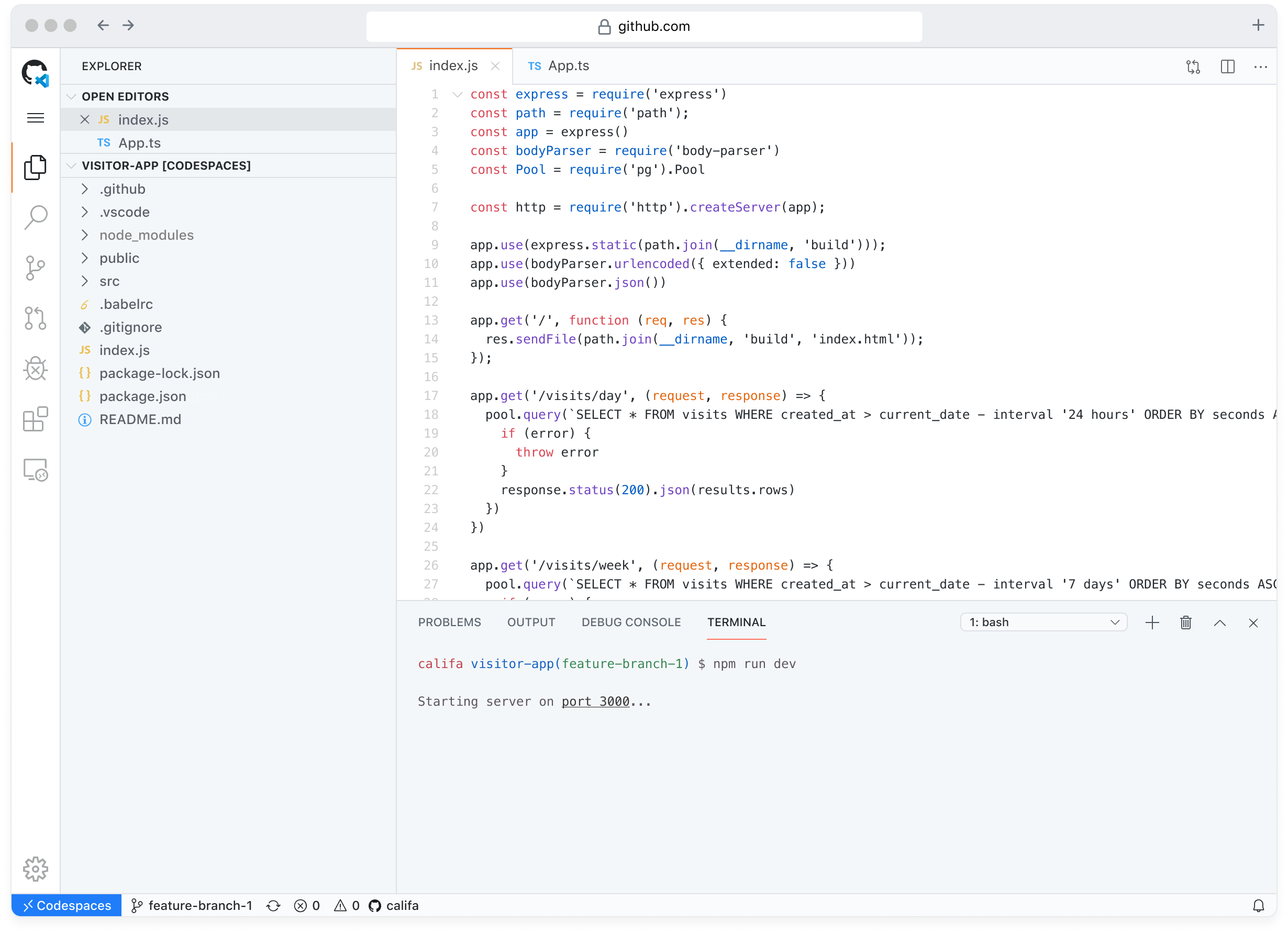

アナリストたちは、あらゆる手段での在宅勤務によるインターネットトラフィックの大幅な増加を様々な場所で発表している。デジタルトラフィックを使った手法は、オンライン食料品からビデオゲーム、そして映画のストリーミングまで、あらゆるものに対して急増している。これまでのところ、システムはすべてを適切に処理しており、クラウドは継続的に利用可能で、散発的な問題が発生する程度だ。

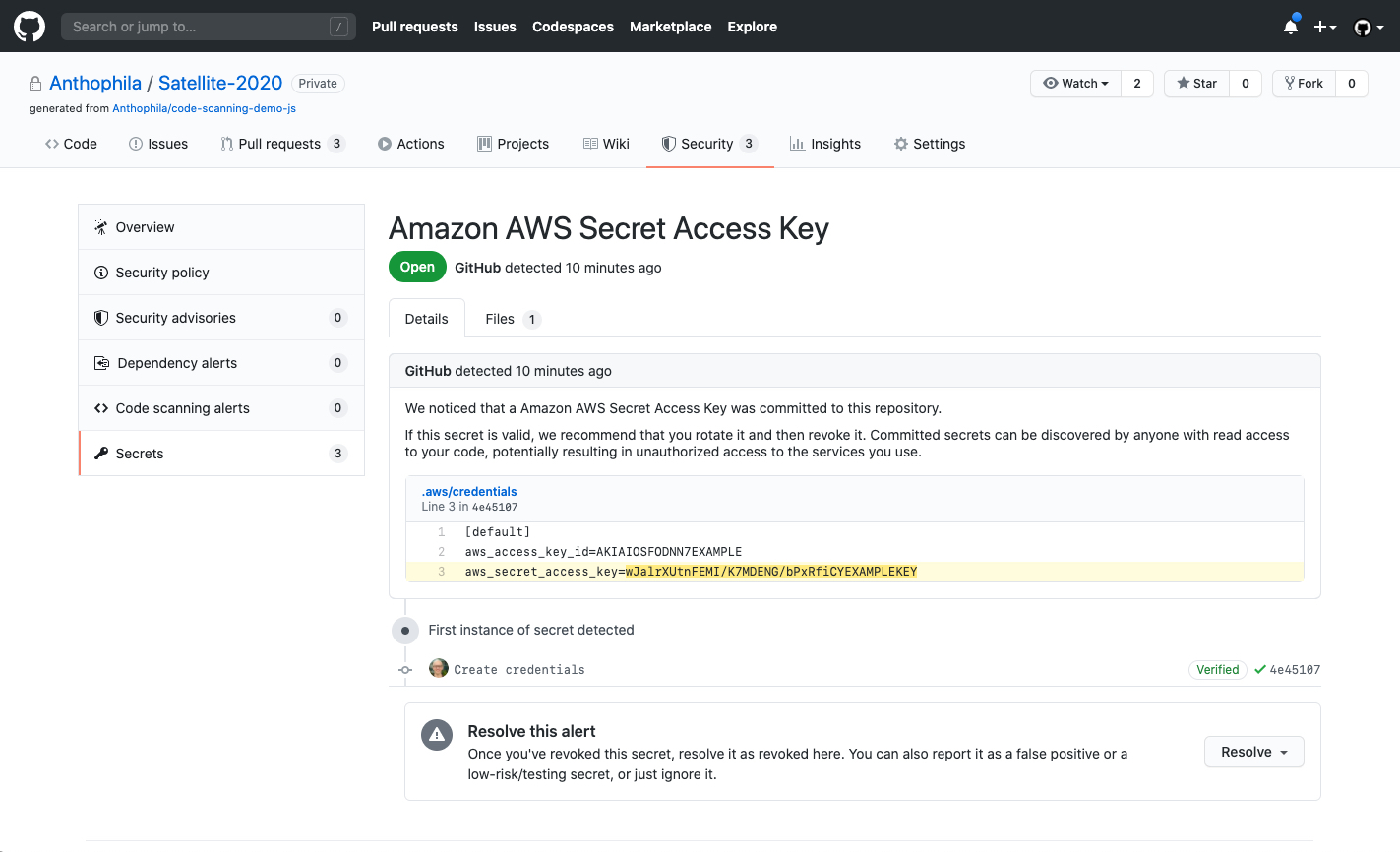

新型コロナウイルス危機に際してのクラウドの役割は、ワンクリックのテレビ会議やビデオチャットだけではない。遠隔医療がついに現実のものになった。例えば、症状を自己診断するためのアプリや、X線診断を強化したり、接触者追跡を支援するAIツールがどんどん登場している。また、クラウドを利用することで、研究者は臨床情報の「データレイク」を迅速に作成し、治療法やワクチンを探求するために展開されている現代のスーパーコンピュータの天文学的な能力を活用できるようになった。

AIとクラウドの未来は、新しい治療法のための超迅速な臨床試験はもちろんのこと、実用的な家庭診断や便利なVRベースの遠隔医療とともに、上記のようなことをたくさんもたらしてくれるだろう。そして、ここに述べたことは、医療の一部ではない残り80%の経済で、クラウドが何を可能にするかについてはまだ何も述べていないのだ。

これらの新機能がもたらしてくれるすべての興奮のために、クラウドコンピューティングの背後にある基盤システムは、エネルギーの需要を増やし続けている。エネルギーを節約するどころか、私たちのAIを利用した作業環境では、これまで以上に多くのエネルギーが使用されている。これは、テクノロジー業界が今後数年間で迅速に評価および検討する必要がある課題なのだ。

新しい情報インフラストラクチャ

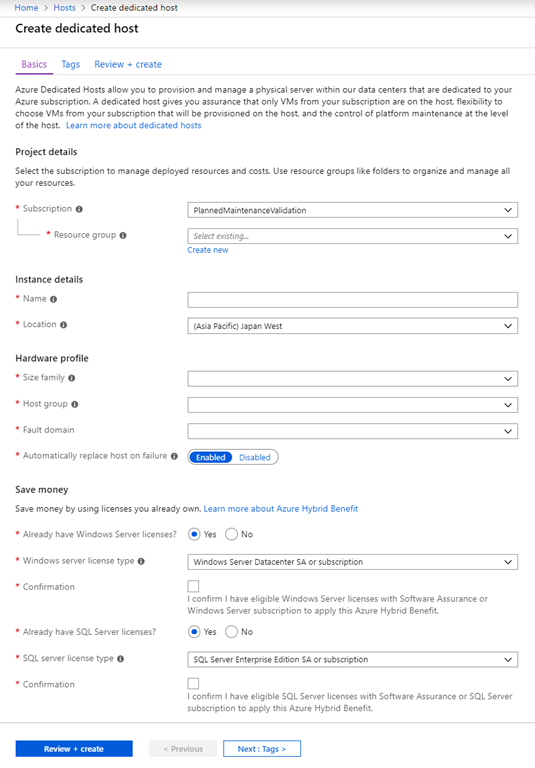

クラウドは重要なインフラストラクチャである。これにより、多くの優先順位が再構成される。ほんの数カ月前には、ハイテク業界の大企業たちは、エネルギー使用量の削減と運用のための「グリーン」エネルギーの推進についての誓約の公言に対して、お互いに肩を並べていた。もちろん、そうした問題は引き続き重要だ。しかし、信頼性と回復性、つまりシステムの可用性(availability)が今や最優先事項となった。

2020年3月、国際エネルギー機関(IEA)の専務理事であるFatih Birol(ファティ・ビロル)氏は、風力発電と太陽光発電の将来について、外交的な控えめな言葉で次のように語っている。「今日、私たちは、デジタル技術への依存度がさらに高まっている社会を目の当たりにしています」そのことは「政策立案者が極端な状況下での柔軟性のある資源の潜在的な可用性を慎重に評価する必要性を強調しています」。新型コロナウイルスの危機に続くだろう経済的に困難な時代には、「可用性」を確保するために社会が支払わなければならないコストがはるかに重要なものになるだろう。

太陽光および風力技術で 高信頼性の電気を提供することは、依然として法外に高価なものだ。太陽光、風力発電が「グリッドパリティ」(既存電力コストと同等もしくはそれ以下になること)になっていると主張する人びとは、現実を見ていない。データによれば、風力発電や太陽光発電のシェアが米国よりもはるかに高い欧州では、送電網のキロワット時(kWh)のコスト全体が約200~300%高くなっていることがわかる。注目すべきは、消費者の大きな負担を横目に、テック企業を含む大規模な産業用電力需要家は、一般的にグリッド平均からの大幅な割引を受けているということだ。

やや単純化していうならば、大手ハイテク企業がスマートフォンにデータを流すための電気代への支払いが少なくて済むように、各消費者が家庭の電力供給に対して多くのお金を払っていることを意味する(私たちは、今回の危機後の世界で、市民がこの非対称性に対してどれほど寛容であるかを見届けることになるだろう)。

そのような多くの現実は、実際には、クラウドのエネルギー動向が個人的な移動と反比例するという事実によって隠されている。個人的な移動を考えると、消費者は自分の車のガソリンタンクを満たすときに、エネルギーの90%が費やされる場所を、文字通り自分の目で見ている。しかし「接続された」スマートフォンに関していえば、エネルギー消費の99%は遠隔地にあるクラウドの、広大なしかしほとんど目に見えないインフラの中に隠されているのだ。

こうした方面に詳しくない人のために説明すると、クラウドを駆動する貪欲なデジタルエンジンは、人の目に触れない何の変哲もない多数の倉庫規模のデータセンターの中に格納されている。そこには膨大な数の冷蔵庫サイズのラックが立ち並び、そこに置かれたシリコンのマシン群が、私たちのアプリケーションを実行し爆発的に増えるデータを処理している。多くのデジタルの専門家でさえ、そうしたラックのひとつひとつが毎年50台のテスラよりも多くの電力を消費していると知ると驚く。さらにこうしたデータセンターは、グラスファイバーで構成された約10億マイル(約16億km)の情報ハイウェイと、400万基の携帯基地局が作り上げる、さらに巨大な目には見えない仮想ハイウェイシステムを通して、データを送受信する(電力消費のさらに激しいハードウェアを備えた)市場と接続されているのだ。

このようにして、数十年前には存在しなかった、グローバルな情報インフラストラクチャは、ネットワークやデータセンターから驚くほどエネルギーを大量に消費する製造プロセスに至るまで、すべての構成要素を数え上げるなら、現在では年間約2000テラワット時(TWh)の電力を使用するシステムにまで成長したのだ。これは、全世界の500万台の電気自動車すべてが、毎年使用する電力の100倍以上の量だ。

これを個人レベルの話にするなら、個別のスマートフォンが年間で使用する平均電力は、典型的な家庭用冷蔵庫が使用するエネルギーよりも大きいことを意味している。そして、このような見積もりはすべて、数年前の情勢に基づいたものだ。

よりデジタル化される未来は、必然的により多くのエネルギーを使用するだろう

一部のアナリストは、近年デジタルトラフィックは急増しているものの、効率性の向上により、データ中心のエネルギー使用量の伸びは鈍化しているか、あるいは横ばいになっていると主張している。しかし、そのような主張は、拮抗する事実に直面している状況だ。2016年以降、ハードウェアと建物 に対するデータセンターの支出が劇的に増えてしているが、そこにはハードウェアの電力密度の大幅な増加も伴っている。

近年、デジタルエネルギーの需要の伸びが鈍化したかどうかとは関係なく、クラウドの急速な拡大が進んでいる。クラウドのエネルギー需要がそれに比例して増加するかどうかは、データの使用量がどれだけ速く増加するか、そしてクラウドの用途に特に大きく依存する。エネルギー需要の大幅な増加は、クラウドの中心的な運用指標 、すなわち可用性を満たすための、エンジニアリングと経済的な課題をはるかに難しいものにする。

過去5年間でその前の10年間全部よりも、広い面積のデータセンターが 建設された。「ハイパースケール」データセンターと呼ばれる新しいカテゴリさえも生まれている。それぞれが100万平方フィート(約9万3000平方メートル)を超える、マシンで満たされた建物のことだ。これらを、1世紀前の不動産用語である「超高層ビルの夜明け」と同じものだと考えて欲しい。しかし、現在の世界には、エンパイアステートビルディング並の大きさの超高層ビルは50棟未満しかないが、地球上には既に約500カ所ほどのハイパースケールデータセンターがある。そして後者は合計すると、6000棟を超える超高層ビルに相当するエネルギーを必要としている。

クラウドトラフィックの成長を推進しているものが何かを推測する必要はない。このリストのトップを占める要因はAI、より多くの動画、特にデータを多用するバーチャルリアリティ(VR)、そしてネットワークの「エッジ」に置かれたマイクロデータセンターの拡大だ。

最近まで、AIに関するほとんどのニュースは、従来の仕事を奪う可能性の側面に焦点を当てたものが多かった。だが真実は、AIは生産性向上を推進するツールの最新版に過ぎない。こうしたツールは、生産性の向上が歴史の中で常に行ったきたことを再現することになる。つまり雇用を拡大し、より多くの人びとのためにより多くの富を生み出すのだ。新型コロナウイルス感染症からの復活の過程では、より多くの雇用や富の生産が必要とされる。だが、それについて話すのはまた別の機会にしよう。現時点では、個人の健康分析やドラッグデリバリーから医学研究や就職活動に至るまで、あらゆる分野の中にAIが果たす役割があることは既に明らかだ。おそらくAIは、最終的には「善い」ものと見なされるようになるだろう。

だがエネルギーに関していえば、AIはデータを大量に使い、電力を大量に消費するシリコンを使用している。そして世界は膨大な数のそのようなAIチップを使用したがっている。一般に、機械学習に費やされる計算能力は、数カ月ごとに倍増している、これはムーアの法則の一種のハイパーバージョンだ。例えば、Facebookは2019年にデータセンターの電力使用量が毎年倍増する主な理由としてAIを挙げている。

近い将来、数週間のロックダウンの最中に、小さな平面スクリーンでのビデオ会議の欠陥を経験した消費者たちが、VRを使ったビデオの時代への準備が整っていることにも期待しなければならないだろう。VRでは画像密度は最大1000倍までに増加し、データトラフィックが約20倍に増加する。進み方は断続的だったが、技術的には準備ができており程なくやってくる高速5Gネットワークは、そうした増加するピクセルを処理する能力を備えている。ただし繰り返しておく必要があるが、すべてのビットは電子であるため、バーチャルリアリティの増加は現在の予測よりも多くの電力需要につながることを意味している。

これに加えて、顧客の近く( エッジ )にマイクロデータセンターを構築する最近の傾向が挙げられる。会議やゲーム用のVR、自動運転車、自動化された製造業、あるいはスマート病院や診断システムなどの「スマート」な物理インフラなどのリアルタイムアプリケーションに、遠隔地のデータセンターからAI駆動のインテリジェンスを届けるには、光の速度は遅すぎるのだ(ヘルスケアにおけるデジタルとエネルギーの密度自身は、既に高く上昇している。病院の単位面積あたりのエネルギー消費量は、他の商業ビルの5倍程度に達しているのだ)。

エッジデータセンターは、この先10年も経たないうちに、10万メガワット(MW)の電力需要を積み上げると予想されている。別の見方をすれば、これはカリフォルニア州全体の電力網の電力容量をはるかに超えている。これらもまた、近年のエネルギー予測のロードマップには載せられていなかったものだ。

デジタルエネルギーの優先順位は変わるのか?

これは関連する質問へとつながる。ポストコロナウイルス時代のクラウド企業は、支出をエネルギー免罪符へと集中させ続けるのだろうか、それとも可用性へと集中させるようになるのだろうか? この場合の免罪符とは、自社施設に対する直接給電以外の場所(海外を含む)に対する、風力、太陽光発電への企業投資のことを指している。それらの遠隔地での投資は、実際には自社の施設に電力を供給していないにもかかわらず、自分たちの施設がグリーン電力であると主張するために「クレジット」されている。

グリーンエネルギーを求める企業が、従来の電力グリッドから物理的に切断して、独自のローカル風力、太陽光発電を構築することを妨げるものは何もない。ただし、それを行って24時間年中無休の可用性を確保することで、施設の電力コストは約400%押し上げられることになる。

購入された免罪符としての電力の現状に関しては、世界の情報インフラは既に世界中の太陽光発電所と風力発電所を合わせた発電量よりも、多くの電力を消費しているということを知っておくと役立つ。したがって、テクノロジー企業にとって(誰にとってもだが)、デジタルエネルギーの使用をすべて相殺するための「クレジット」として購入できる十分な風力、太陽光エネルギーは、もはや地球上に存在しないのだ。

デジタルエネルギーの傾向を研究しているひと握りの研究者は、今後10年間でクラウドによるエネルギー使用量が少なくとも300%増加する可能性があると予測していたが、それは今回の世界的なパンデミックの前のことだ。一方、国際エネルギー機関(IEA)は、その期間における世界の再生可能電力は「単に」倍増するものと予測している。その予測もまた、新型コロナウイルス以前の経済状況下で行われたものだ。現在IEAは、不況がコスト高なグリーンプランへの財政意欲を減らすことを心配している。

だが電気を作り出す技術の課題や議論がどうであれ、情報インフラの運営者にとっての優先順位は、ますます必然的に、可用性を重視するものへと移っていくだろう。それは、クラウドが私たちの経済的な健康にますます密接に結びつくようになってきただけでなく、心と体の健康にも関係を持つようになってきたからだ。

そうした可用性の重視が引き起こす変化は、パンデミックと前例のないシャットダウンからの経済の回復の先に、何がくるかについて(グリーンエネルギーへの自らの取り組みが活発になるという意味で)私たちを楽観的にしてくれるはずだ。Microsoft(マイクロソフト)が、新型コロナウイルス以前に出したエネルギーマニフェストの中で、「人類の繁栄を進めることは……エネルギーの賢い利用と表裏一体である」と述べていたことを評価しよう(このマニフェストの中でマイクロソフトはグリーンエネルギーへの大規模な取り組みを表明している)。私たちのクラウドを中心とする21世紀型インフラストラクチャもこれと同じだ。そして、良い結果へとつながるだろう。

【編集部注】著者のMark Mills(マーク・ミルズ)氏は書籍「Digital Cathedrals: The Information Infrastructure Era」(デジタル大聖堂:情報インフラストラクチャ時代)」の著者であり、Manhattan Instituteのシニアフェロー、ノースウェスタン大学のMcCormick School of Engineeringのファカルティフェロー、並びにエネルギーテックのベンチャーファンドであるのCottonwood Venture Partnersのパートナーである。

[原文へ]

(翻訳:sako)

AlibabaはAmazonと多くの共通点を持つ。両社ともeコマース大企業だ。そしてどちらもクラウドコンピューティング部門を持つ。しかしクラウドコンピューティングへの参入はAlibabaの方がずいぶん遅い。2009年に立ち上げたが、本腰を入れ始めたのは2015年からだ。

AlibabaはAmazonと多くの共通点を持つ。両社ともeコマース大企業だ。そしてどちらもクラウドコンピューティング部門を持つ。しかしクラウドコンピューティングへの参入はAlibabaの方がずいぶん遅い。2009年に立ち上げたが、本腰を入れ始めたのは2015年からだ。