最初にHerokuがリリースされたとき、それが大きなブレークスルーを起こしたことを覚えているだろうか?Qoveryは、コードとクラウドインフラストラクチャの間に抽象化レイヤーを構築することで、その再現をしようとしている。QoveryのユーザーがコードをGitのリポジトリにプッシュすると、Qoveryがそのサービスをユーザーに代わって管理してくれる。

共同創業者でCEOのRomaric Philogène(ロマリック・フィロジェーネ)氏は「これは開発者のためのCaaS(コンテナ・アズ・ア・サービス)プラットフォームだ。Herokuのように、ユーザーは.qovery.ymlファイルを作成して、必要な依存関係を記述するだけだ」という。

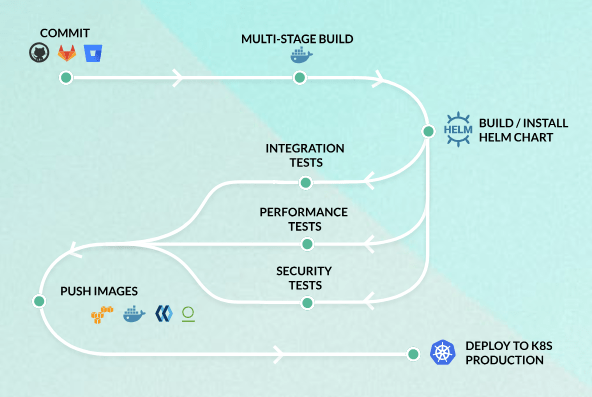

基本的に、QoveryはユーザーのGitリポジトリとクラウドインフラストラクチャのアカウントの間に位置している。同社は、クラウドホスティング自体を管理しているわけではない。QoveryのアカウントをGitHubやGitLab、Bitbucketなどのアカウントに接続すれば、新しいコードをプッシュした際にQoveryが自動的にトリガーされようになる。

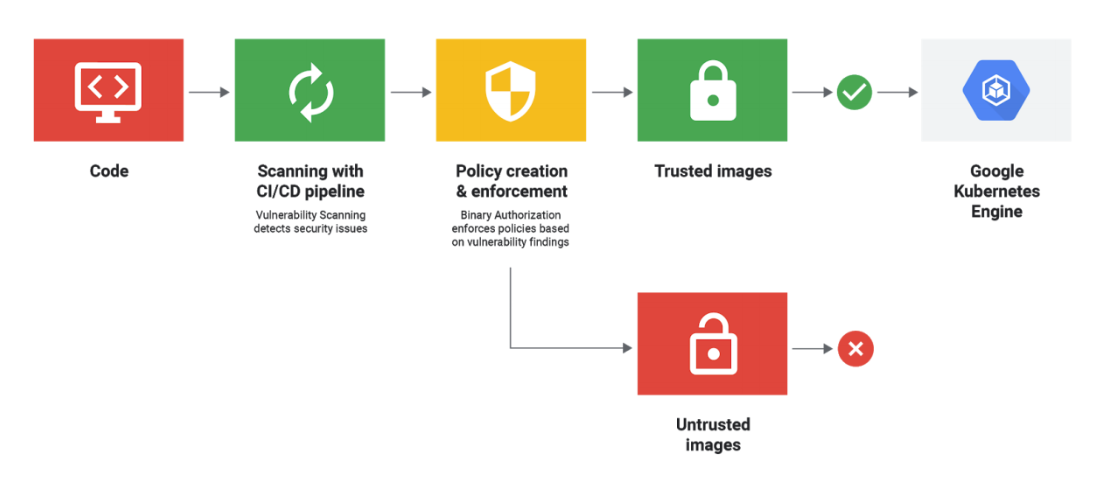

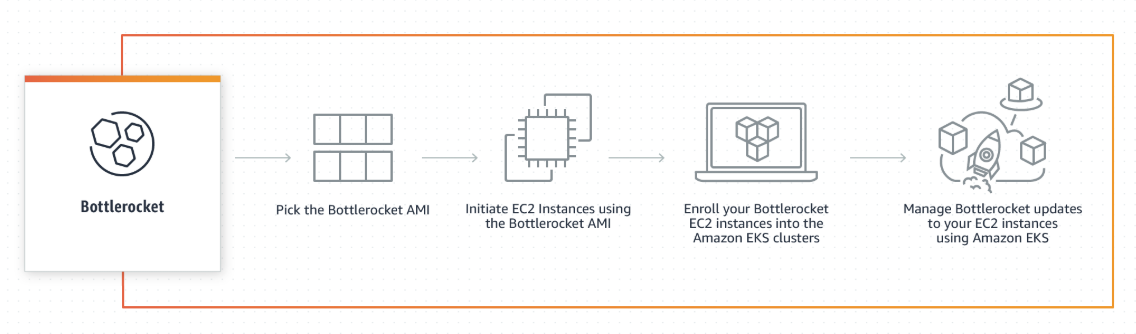

その後、Qoveryが自動的に新たなサーバー、管理されたデータベース、KafkaやRabbitMQのようなブローカーを立ち上げる。デプロイの自動化はTerraformやCI/CD(継続的インテグレーション/継続的デリバリー)のソフトウェアでもできるが、Qoveryはそれをもっと簡単にできるようにする。

さらに重要なのは、Qoveryが複数のクラウドプロバイダーを統合してくれることだ。すでにAmazon Web Servicesに対応しており、現在、DigitalOceanとScalewayのサポートにも取り組んでいる。Google CloudとMicrosoft Azureもロードマップに載っている。

また、ユーザーは各ブランチごとに独自のインフラストラクチャを設計できる点も興味深い。新しい機能を試行するための開発ブランチやステージングブランチがある場合、本番環境を最初から作り直さずに、このブランチ用の新しいサーバーを立ち上げることができる。

そして、これがQoveryの最も重要な機能であることは間違いない。同社によると、クラウドホスティングは今後コモディティ化するという。各プロバイダーは、マネージドデータベースやメッセージブローカーなどを提供することになるとのこと。信頼性た料金、サポートのレベルが、差別化の要因になる。例えば本番用のアプリケーションをAWS上に置き、開発ブランチを別のクラウドプロバイダー上で動かすことを想像して欲しい。

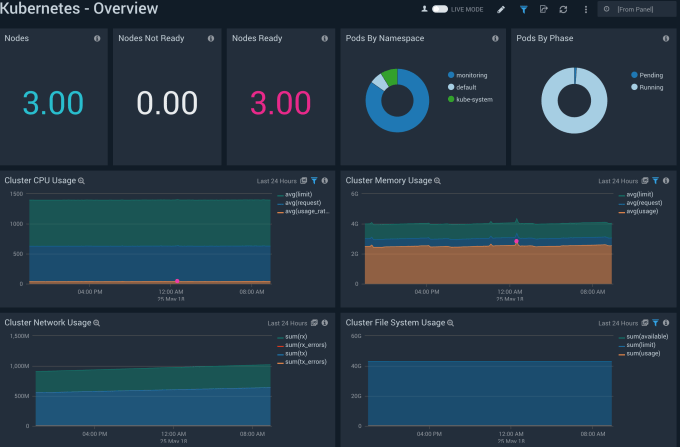

その裏では、QoveryはTerraformとKubernetesに大きく依存し、それらの上にもうレイヤーを追加している。Herokuのモノリシック(一枚岩的)なやり方に比べると、Qoveryのマイクロサービスを軸にゼロから設計されているため、より効率的にスケールすることができる。

Qoveryの料金は、1アプリケーションあたり月額15ドル(約1590円)だ。ただし最近では、1つのサービスのために数十のアプリケーションを動かすことが普通になっているため、すべてをQoveryに切り替えた場合、各アプリケーションに15ドルを支払うことになる。

すでに開発チームと連携するCIツールを使っているところでは、QoveryがビルトインCIサービスの代わりに、そちらを使ってもよい。Qoveryにロックイン効果はないため、独自のDevOpsチームがあるのであれば、使用を止めることもできる。

同社はTechstarsと多数のエンジェル投資家から100万ドル(約1億1000万円)を調達している。

画像クレジット:Qovery

カテゴリー:ソフトウェア

画像クレジット:Qovery

このイベントにおけるCNCFの役割について議論するために、私はCNCFのエグゼクティブディレクターであるDan Kohn氏の話を聞いた。

このイベントにおけるCNCFの役割について議論するために、私はCNCFのエグゼクティブディレクターであるDan Kohn氏の話を聞いた。