Cerebras(セレブラス)に最高があふれている、これまで密かに次世代のシリコンチップ製造を進めて来たこの会社は、Amazonから歯磨き粉を買うことと同じくらい素早く、ディープラーニングモデルを生み出せるようにすることを目指している。

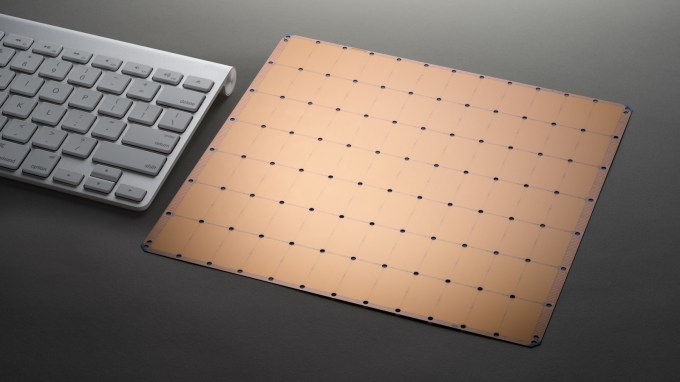

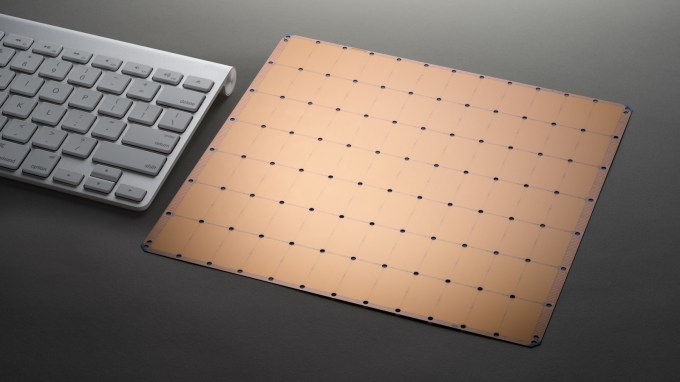

ほぼ3年にわたる沈黙の開発の後、米国時間8月19日、Cerebrasは新しいチップを発表した。それはとてつもない製品だ。その「ウエハースケールエンジン」(Wafer Scale Engine)は、1.2兆個のトランジスタ(史上最大)を持ち、面積は4万6225平方ミリメートル(史上最大)で、18ギガバイトのオンチップメモリ(今日の市場のチップの中で最大)と、40万個プロセッシングコア(おそらく最大だろう)で構成されている。

Cerebrasのウエハースケールエンジンは典型的なMacのキーボードよりも大きい。(提供:Cerebras Systems)

それはスタンフォード大学で開催中のホットチップス会議で大きな驚きを巻き起こした。この会議は製品とそのロードマップを紹介するためのシリコン業界の大きな催しだが、出席者の間からは様々などよめきの声が挙げられた。FortuneのTiernan Rayでこのチップの詳細詳細を読んだり、Cerebras自身によるホワイトペーパーを読んだりすることができる。

これが最高であることはともあれ、Cerebrasがこのマイルストーンにたどり着くために乗り越えなければならなかったいくつもの技術的挑戦は、より興味深いストーリーだと私は思う。今日の午後、私は創業者兼CEOのアンドリュー・フェルドマン(Andrew Feldman)にインタビューを行い、その173人のエンジニアたちが、この数年間Benchmarkやその他のVCから得た1億1200万ドル資金で、何を密かに作ってきたのかについて話を聞いた。

大きくなるということは、挑戦以外の何物でもない

まず、世の中で使われている携帯電話やコンピューターを駆動するチップが、どのように作られるかについて、簡単に背景を説明しよう。TSMCのようなファブメーカーは、標準サイズのシリコンウエハーに、光を利用してトランジスタをエッチングして、それを個別のチップへと分割している。ウエハーは円形で、チップは正方形である。そのためその円形をきれいな個別のチップの並びへと分割するためには、ある程度の幾何学が必要となる。

このリソグラフィプロセスにおける大きな課題の1つは、製造プロセスにエラーが忍び込んでしまうことである。このため品質を検証するためには厳しいテストが必要となり、製造業者は品質の悪いチップを廃棄することを余儀なくされている。チップが小さくコンパクトになるほど、個々のチップが動作不能になる可能性は低くなり、製造業者の歩留まりは向上する。歩留まりが高くなるほど、利益も大きくなるのだ。

Cerebrasは、多数の個別のチップを1つのウエハー上にエッチングするというアイデアを捨て去り、その代わりにウエハー全体を1つの巨大なチップとして使用することにした。これにより、個々のコア同士をすべて、直接接続することができるようになるため、ディープラーニングアルゴリズムの中で使われる重要なフィードバックループの速度が大幅に向上する。だが引き換えに、そうしたチップを製造し管理するために、製造と設計に対して厳しい挑戦が突きつけられることになる。

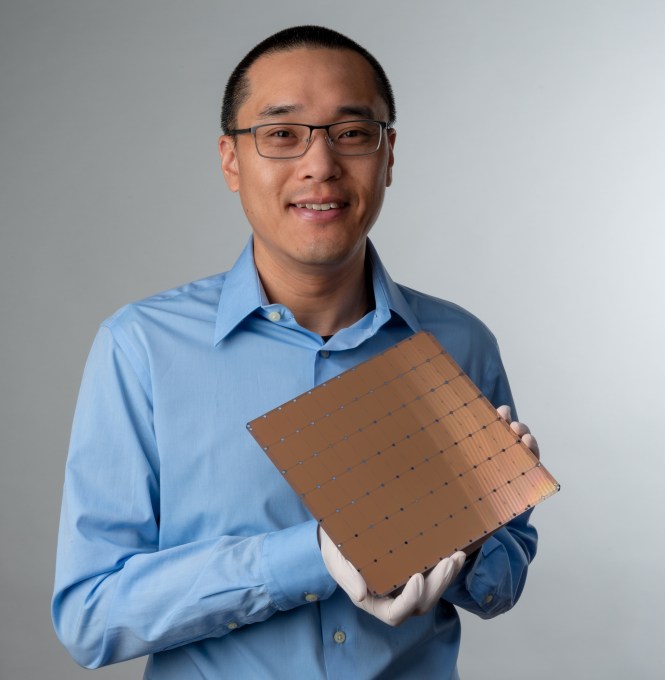

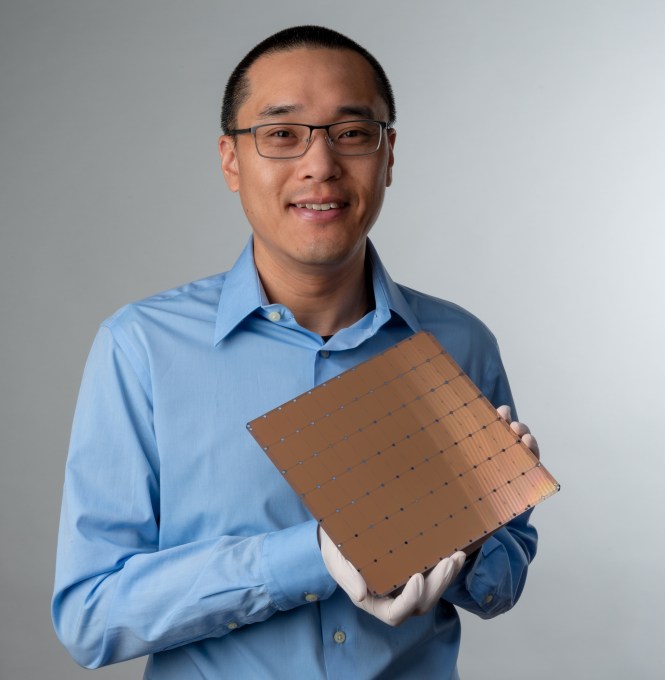

Cerebrasの技術アーキテクチャと設計は、共同創業者のショーン・リー(Sean Lie)氏によって主導された。フェルドマン氏とリー氏は以前、SeaMicroという名のスタートアップで一緒に働いていた(SeaMicroは2012年にAMDに3億3400万ドルで売却された)。(提供:Cerebras Systems)

フェルドマン氏によれば、チームが最初に遭遇した挑戦は、「スクライブライン」(ウエハー上で個々のチップとチップの間にあるギャップ)を横切る通信の処理だった。Cerebrasチップはウエハー全体に広がっているのに、既存のリソグラフィ装置は、シリコンウエハー上に個々のチップがエッチングされつつあるかのように動作する必要があるからだ。そのため同社は、そうした個々のチップがウエハー全体で相互に通信できるようにするための、新しい技法を考案する必要があった。同社はTSMCと協力して、通信用の新しいチャネルを発明しただけでなく、1兆個以上のトランジスタを搭載したチップを扱うための、新しいソフトウェアを作成する必要があった。

2番目の課題は歩留まりだった。シリコンウエハー全体を覆うチップの場合、そのウエハーのエッチングに1つでも欠陥があると、チップ全体が機能しなくなる可能性がある。これはウエハー技術全体に対して何十年も障害として立ち塞がっていた問題なのだ。物理学の法則によって、1兆個を超えるトランジスターを完璧に正確に繰り返しエッチングすることは、本質的に不可能なのである。

Cerebrasは、チップ全体に余分なコアを追加することで生まれる冗長性を使ってこの問題にアプローチした。ウエハー上の隣接するコアにエラーが発生した場合には、この冗長なコアがバックアップとして用いられるのだ。「たった1%、あるいは1.5%の不良コアを取り除くだけで良いのです」とフェルドマンは私に説明した。余分なコアを残すことで、チップは本質的に自己修復を行い、リソグラフィエラーを回避し、ウエハーシリコンチップ全体を実行可能にする。

チップ設計の未知の領域に入る

これらの最初の2つの挑戦(スクライブラインを介したチップ間通信と歩留まりの向上)は、ウエハーチップを研究してきたチップ設計者たちを何十年も困らせてきた。だが、それらはいわば既知の問題であり、フェルドマン氏は、最新のツールを使用してそれらに再アプローチすることによって、予想された問題をより容易に解決することができたと語った。

彼はこの挑戦をエベレスト登山にたとえている「これは最初の登山隊がエベレスト登頂に失敗して『ええい、こんちくしょう、この最初の部分は本当に厄介だ』と言うようなものです。そして次の登山隊がやってきて、こう言うのです『そんなの大した問題じゃないね。最後の100ヤードこそが問題なんだ』と」。

そして実際のところ、フェルドマン氏によれば、Celebrasにとって最も困難な挑戦はそれに続く3つのものだった。なぜならば過去のチップ設計者たちは誰も最初の2つの挑戦(スクライブライン通信と歩留まり)を乗り越えられなかったので、その後に何が待ち構えているかを知ることができなかったのだ。

Cerebrasが直面した3番目の課題は、熱膨張の処理だった。チップは動作中に非常に高温になるが、異なる材料は異なる比率で膨張する。つまり、チップをマザーボードにつなぐコネクタも、両者の間にクラックが発生しないように、正確に同じ比率で熱膨張する必要があるのだ。

フェルドマン氏は言う「どうすればそれに耐えられるコネクターを手に入れることができるのでしょう?それまでにそれをやった人が誰もいなかったので、私たちは材料を発明しなければなりませんでした。そのため私たちは、材料科学の博士を雇い入れて、その違いを吸収できる材料を発明しなければなりませんでした」。

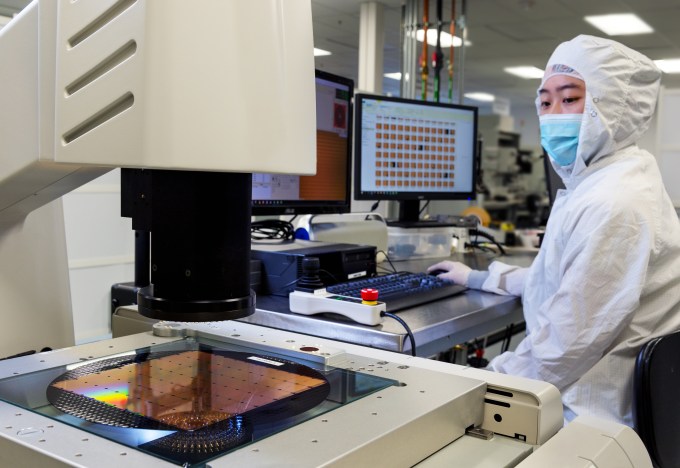

チップが製造されたら、最終顧客(データセンターあるいは消費者向けラップトップ)が使用する製品にチップを組み込むOEM(Original Equipment Manufacturer)業者に出荷するために、チップのテストとパッケージングを行う必要がある。しかしそこにも挑戦課題がある。市場にはウエハー丸ごとのチップを扱えるようにデザインされている機器が皆無なのだ。

Cerebrasは、チップを処理する独自のテストおよびパッケージングシステムを設計した(提供:Cerebras Systems)。

「一体どのようにパッケージングすれば良いのでしょうか?まあ、その答えは、ガラクタを山ほど発明することになるということです。それが真実なのです。このサイズのプリント基板を持っているところはありませんでした。コネクターもありませんでした。コールドプレートもありませんでした。ツールもありません。それらの位置を調整するツールもありません。それらを扱うツールもありません。そしてテストするソフトウェアもありませんでした」とフェルドマン氏は説明する。「誰もやったことがなかったので、この製造フロー全体を設計したのです」。Cerebrasの技術は、販売するチップだけではなく、実際にそれらのチップを製造およびパッケージングするために必要な、すべての関連機械も含んでいるのだ。

そして最後に、1つのチップが提供するこの処理能力は、膨大な電力と冷却を必要とする。Cerebrasのチップは、動作させるために15キロワットの電力を使用する。これは、現代的なサイズのAIクラスターにある程度匹敵するものだが、1つのチップとしては驚異的な量である。そうした電力は、冷却も必要とする。そしてCerebrasはこのような大きなチップに、電力と冷却の両者を提供する、新しい方法を設計する必要があった。

ここではフェルドマン氏が「Z軸の使用」と呼んでいる、チップを縦に置くことでその問題の解決が図られた。そのアイデアは、従来のようにチップ全体に水平に電力と冷却を届けるのではなく、縦に置いたチップ全体に対して電力と冷却が均一で一貫したレベルで届くようにしようというものだ。

ということで、これら、熱膨張、パッケージング、電力/冷却が、次に現れた3つの挑戦だったのである。同社は過去数年間にわたってこの問題に昼夜を問わず取り組んできたのだ。

理論から現実へ

Cerebrasはデモチップを用意している(私はその実物を見たが、それは私の頭のサイズとほぼ同じ大きさだった)、レポートによれば、同社はそのプロトタイプを顧客に提供し始めている。だが、すべての新しいチップの場合と同様に、本当に大きな挑戦は、顧客の需要を満たすために生産を拡大することだ。

Cerebrasにとって、状況は普通のものとは少々違っている。1つのウエハーに非常に多くの計算能力を搭載しているため、顧客は必ずしも数十または数百のチップを購入してそれらをつなぎ合わせて、計算クラスターを作成する必要がない。その代わりに、彼らはそのディープラーニングに対するニーズのために、ほんの一握りのCerebrasチップを必要とするだけだろう。同社にとって、次の主要なフェーズは、規模を拡大しチップを安定して供給できるようにすることだ。これは、独自の冷却技術も含むシステム全体を「アプライアンス」としてパッケージングすることである。

特にディープラーニング処理ワークフローの将来に対する競争が激化する中、Cerebrasテクノロジーのさらなる詳細を、今後数ヶ月以内に聞くことができることを期待しよう。

画像クレジット: Cerebras Systems / Cerebras Systems

[原文へ]

(翻訳:sako)

Elixは、AIやディープラーニングの技術を擁する2016年11月設立のスタートアップ。これまで、AIによる創薬や材料開発、コンピュータービジョン(画像認識)に注力した事業を展開。そのほか、自動運転やADAS(先進運転支援システム)向けのモデル開発、大企業の研究開発部門などの向けたコンサルティング、モデル開発・改良、モデルのライセンス提供なども行っている。

Elixは、AIやディープラーニングの技術を擁する2016年11月設立のスタートアップ。これまで、AIによる創薬や材料開発、コンピュータービジョン(画像認識)に注力した事業を展開。そのほか、自動運転やADAS(先進運転支援システム)向けのモデル開発、大企業の研究開発部門などの向けたコンサルティング、モデル開発・改良、モデルのライセンス提供なども行っている。