すでにゲームやテレビ業界で使われているが、話した人の声で別の言語に変換するスピーチ技術を開発した英国のAIスタートアップPapercup(ペーパーカップ)は、800万スターリングポンド(約11億円)の資金を調達した。

このラウンドはLocalGlobeとSands Capital Venturesが主導し、Sky、GMG Ventures、Entrepreneur First(EF)、BDMIが参加している。Papercupは今回の資金を機械学習研究と、AI通訳動画の品質改善やカスタマイズのための「Human in the loop」(人間参加型)品質管理機能の拡大に追加投入すると話している。

Papercupは、これ以前からエンジェル投資家の支援も受けている。その中には、後にAmazon(アマゾン)に買収されAlexaを誕生させたEvi Technologies(イービー・テクノロジーズ)の創設者William Tunstall-Pedoe(ウィリアム・タンストールペドー)氏や、Uber(ウーバー)で主任サイエンティストとAI担当副社長を務め、現在はGoogle Brain(グーグル・ブレイン)リーダーシップチームの一員であるZoubin Ghahramani(ズービン・ガラマニ)氏も含まれている。

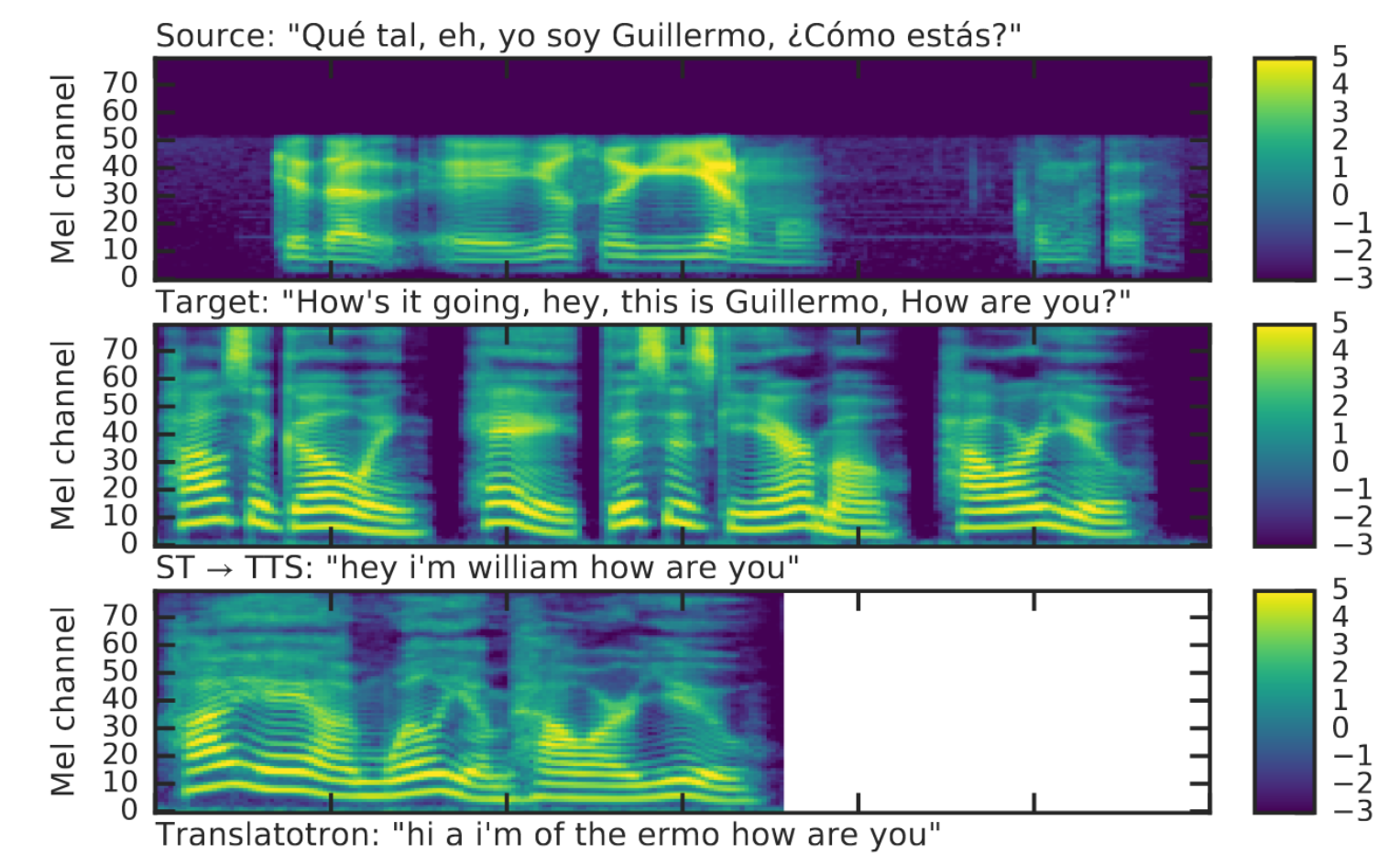

2017年、EFの企業創設者向けアクセラレータープログラム参加中にJesse Shemen(ジェシー・シーメン)氏とJiameng Gao(ジアメン・ガオ)氏が立ち上げたPapercupは、話し手の声や話し方をそのままに別の言語に変換する能力、と同社が説明するAIと機械学習に基づくシステムを開発している。よくあるテキストの読み上げシステムとは異なり、通訳された音声は人間の声と「判別が不可能」だと彼らは主張している。しかも、そこがユニークな点だと思われるが、話し手の声の特徴もできるだけ引き継がれる。

もともとこの技術は、すでにこれを利用しているSky News(スカイ・ニュース)、Discovery(ディスカバリー)、YouTube(ユーチューブ)の人気チャンネル「Yoga with Adriene」、その他の動画を自主制作するクリエイターたちに向けて開発された。その売り文句は、もっとずっと幅広い応用が可能であり、したがって本物の人間による吹き替えに取って代わる安価な手段だと訴えている。

「世界の動画と音声のコンテンツは1つの言語に縛られています」とPapercupの共同創設者でCEOのシーメン氏はいう。「YouTubeの数十億時間分の動画、何百万本というポッドキャスト、Skillshare(スキルシェア)やCoursera(コーセラ)の何万件ものオンライン学習講座、Netflix(ネットフリックス)の何万本もの番組などもそうです。そうしたコンテンツの所有者は、ほぼ全員が世界展開を強く望んでいますが、字幕に勝る簡単で費用対効果の高い方法がまだありません」。

もちろん「予算がたっぷりあるスタジオ」なら、プロ用の録音施設で声優を雇い最高級の吹き替えが可能だが、ほとんどのコンテンツ所有者には高すぎて手が出せない。裕福なスタジオであっても、対応する言語が多ければ、制約が加わわるのが普通だ。

「そのため、ロングテールやそれに準ずるコンテンツ、それはまさに全コンテンツの99%に相当しますが、その所有者は海外のオーディエンスにリーチしたいとき、字幕以上の方法を諦めたり、そもそも不可能だったりします」とシーメン氏。もちろん、そこがPapercupの狙い目だ。「私たちの目標は、翻訳された言葉を、できるだけ元の話し手の声に近づけることです」。

それを実現させるために、Papercupは4つの課題に取り組む必要があったという。1つめは「自然に聞こえる」声だ。つまり、合成音声をできる限り明瞭で人間の声に近づけることだ。2つめの課題は、元の話し手が表現した感情や速度(つまり喜怒哀楽)を失わないこと。3つめは、人の声の特徴を捉えること(たとえばドイツ語でもモーガン・フリーマンが話しているように聞こえるといったように)。そして最後は、翻訳されたセリフを動画の音声に正確に揃えることだ。

シーメン氏はこう説明する。「私たちはまず、できる限り人間に近い、自然に聞こえる音声を作ることから始めました。その目的に沿って技術の洗練させてゆく過程で、私たちは音質の面で飛躍的な技術革新を果たしました。いま作られているスペイン語音声合成システムの中で、私たちのものは最高水準にあります」。

「現在私たちは、さまざまな言語に変換するときに、元の話し手の感情や表現をできるだけ残したままで行う技術に重点を置いています。その中で、これこそが吹き替えの質を左右するものだ気がつきました」。

間違いなくこれが最も大きな難関となるが、次の課題は「話者適応」だ。つまり、話し手の声の特徴を捉えることだ。「それが適応の最終段階です」とPapercupのCEOは話す。「しかし、それは私たちの研究で最初に実現したブレイクスルーでもあります。私たちにはこれを達成できるモデルはありますが、感情や表現に多くの時間をかけています」。

とはいえPapercupは、いずれはそうなるかもしれないものの、完全に機械化されているわけではない。同社では、翻訳された音声トラックの修正や調整に「人間参加型」のプロセスを採り入れている。そこでは、音声認識や機械翻訳のエラーの修正、タイミング調整、さらには生成された音声の感情(喜びや悲しみ)の強調や速度の変更が人の手で行われている。

人間参加型の処理がどれほど必要になるかは、コンテンツのタイプや、コンテンツ所有者のこだわりによって異なる。つまり、どれだけリアルで完璧な吹き替え動画を求めるかだ。逆にいえば、これはゼロサムゲームではないため、大きな規模で考えた場合、大半のコンテンツ所有者は、そこまで高い水準は求めないということだ。

この技術の始まりについて尋ねると、共同創設者でCTOのジアメン・ガオ氏の研究からPapercupはスタートしたとシーメン氏は答えた。ガオ氏は「驚くほど頭が良く、異常なほどに音声処理にのめり込んでいた」という。ガオ氏はケンブリッジ大学で2つの修士号を取得し(機械学習と音声言語技術)、話し手に順応する音声処理に関する論文も書いている。Papercupのようなものを作ることができる可能性に気づいたのは、ケンブリッジ在学中だった。

「2017年の終わり、Entrepreneur Firstで勉強していたときに、私たちは最初のプロトタイプシステムを作りました。前例のないものながら、この技術は使えると感じました」とシーメン氏。「当初、人から聞いた意見から、私たちが作っているものには予想を超える膨大な需要があることを知りました。制作スタジオでの使用を想定して開発しているものの、ほんの一機能に過ぎなかったのですが」。

カテゴリー:人工知能・AI

タグ:Papercup、合成音声、機械翻訳、資金調達

画像クレジット:Papercup

[原文へ]

(翻訳:金井哲夫)