ガンの発見と診断は、それで生計を立てている医療専門家にとってさえ複雑で難しいプロセスである。Googleの研究者たちが開発した新しいツールは、不審なまたは既知の癌性細胞に対する画像検索を提供することによって、このプロセスを改善することができるかもしれない。だがそれは、単純なマッチングアルゴリズム以上のものだ。

多くの場合診断プロセスの一環として行われることは、顕微鏡下で組織サンプルを検査して、ガンの特定の形態を示している可能性のある、特徴的な兆候または形状を探すことだ。ガンも体も全て異なっているので、これは長くて骨の折れるプロセスになる可能性がある。そしてデータを検査する人間は患者の細胞を見るだけではなく、それをデータベース中の(場合によっては書籍に印刷された)既知のガン組織とも見比べなければならない。

これまで何年もの間十分に実証されてきたように、類似の画像をお互いに照合することは、機械学習エージェントにとても適した仕事である。それは、1枚の画像を投入すると視覚的に類似のものを発見してくれる、Googleの画像検索を実現しているものと同じ技術だ。そして、この技術は医療プロセスを自動化するためにも使用されており、コンピューターシステムは自身が認識するように訓練されたパターンまたは特徴を有する、X線またはMRI画像上の領域を強調することができる。

関連記事:中国の医療系スタートアップ、Infervisionが日本進出へ、機械学習と画像認識をがん診断に適用

これらは十分役立つものだが、ガンの病理学の複雑さは2つのサンプルの単純な比較を許してくれない。例えば1つは膵臓から、もう1つは肺から取られたサンプルの場合、視覚的には類似していたとしても2つの状況は完全に異なっている可能性がある。経験豊富な医師の「直感」は機械に置き換えられるべきものではなく、医師もまた自分が置き換えられてしまうかもと悩む必要はない。

こうした可能性と限界の両方に気が付いたGoogleの研究チームは、SMILY(Similar Medical Images Like Yours)というシステムを開発した。これは特に組織検査とガン検査のために重点的に拡張された画像検索システムの1種である。

利用者は、患者からの新しいサンプルをシステムに投入する。染色された組織の切片が広げられた、大きな高精細度のスライド画像だ(この方法は標準化されており、長い間使用されている。そうでなければどうやって2つのサンプルを比較すればいいだろう?)。

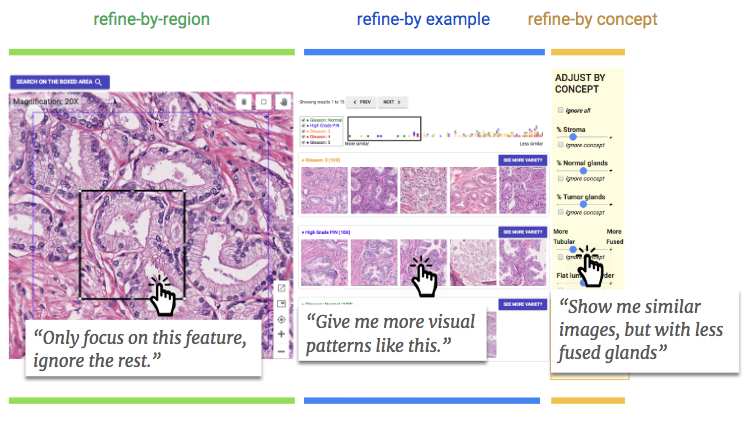

サンプルがツールに投入されたら、医師は通常行うように、それを拡大したり上下左右に眺め回すことができる。興味がそそられるセクションを見つけたら、医師はその周りにボックスを描くことができる。するとSMILYは画像マッチングの魔法を行い、そのボックスの内側の画像をCancer Genome Atlas(タグ付けられ匿名化された膨大なデータベース)全体のデータと比較することができる。

サイドバーに似たような領域が表示され、ユーザーはそれらを簡単に精査することができる。そうした用途に対して、それは役立っている。しかし、SMILYを開発している間に研究者たちは、医者たちが本当に必要としていたものは、もっとはるかに粒度の粗いレベルの情報を得られるようになることだということに気が付いた。全体的な視覚的類似性が唯一の重要なものではないのだ。四角の中のある特徴や、ある種の比率、もしくは細胞のタイプなどが、利用者が探しているものだったりするのだ。

研究者たちが書いているように、

ユーザーが探しているものを実際に見つけるためには、ケースバイケースで検索結果をたどり、絞り込む機能が必要だった。この繰り返し検索の絞り込みの必要性は、医師がしばしば行う「繰り返し診断」を実行する方法に基づいている。すなわち仮説を立て、その仮説を検証するためのデータを収集し、対立する仮説の探索を行い、そして以前の仮説の再検討または再検証を繰り返し行うやりかたである。SMILYが実際のユーザーの真のニーズを満たすためには、ユーザーとの対話に別のアプローチをサポートする必要があることが明らかとなった。

この目的のために、チームはユーザーが興味のあること、つまりシステムが返すべき結果の種類をより厳密に指定できるようにする、拡張ツールを追加した。

まず第1に、ユーザーは彼らが関心のある領域内で1つの形状を選択することができ、システムはそれだけに焦点を合わせて、おそらく気を散らすだけの他の特徴を無視する。

第2に、ユーザーは検索結果の中から有望と思われるものを選択することができ、システムはそれにより近い(ただし最初の照会とはあまり密接に結びついていない)ものを返す。これにより、ユーザーは細胞の複雑な特徴を掘り下げて行くことが可能となり、上で研究者が述べていた「繰り返し」プロセスを行うことができる。

そして第3に、システムは、融合腺や腫瘍前駆細胞などのような一定の特徴が検索結果に存在する場合に、それを理解できるように訓練された。これらは検索に含めることも除外することもできる。したがって、それがあれやこれやの特徴に関連していないと確信している場合には、それらのサンプルを対象から外すことができる。

病理学者を使ったツールの試用の結果は有望なものだった。医師たちは、そのツールに素早く適応し、公式機能を使うだけでなく、結果を検証したり、ある特徴がありふれたものなのか、それとも実際に厄介なものなのかに関する直感が正しいか否かを確かめるために、問い合わせ領域の形を変えたりしていた。「このツールは、診断の正確さを損なうことなく、従来のもののインターフェースよりも好まれていた」と研究者らは論文に記載している。

これは良いスタートだが、明らかにまだ実験段階に過ぎない。診断に使用されるプロセスは慎重に監視され、吟味されている。人びとの命が依存している流れを、ただ好き勝手に新しいツールを持ち込んで、変えてしまうことはできない。むしろ、これは「専門家の意思決定のための、人間とMLの未来の協調システム」に向けての明るいスタートに過ぎない。いつの日か病院や研究センターのサービスとして組み込まれることだろう。

以下で、SMILYについて説明した論文と、医師向けにSMILYを詳細に説明した論文を読むことができる。これらの論文はもともと今年はじめにグラスゴーで開催されたCHI 2019で発表されたものだ。

画像クレジット: Google

[原文へ]

(翻訳:sako)