Facebookが主催するアイトラッキングの認識精度を競う「OpenEDS(Open Eye Dataset)Challenge」は、世界各国からコンピュータビジョンの研究者が挑戦するコンペティションだ。大学などの研究機関も参加するこのコンペの結果が9月30日に発表された。コンペの2つの課題のうち、2D画像の眼球位置を推定する「Semantic Segmentation Challenge(セマンティックセグメンテーションチャレンジ)」では、東京・渋谷に拠点を置くクーガーのチームが提出したAIモデルが世界3位を獲得している。

VR/AR普及のカギ、視線追跡の「精度」と「軽さ」を競う

VR/ARが注目を集める中で、スマートグラスの装着時に視線や眼球の動きを追跡する「アイトラッキング」の需要は高まっている。深層学習の進歩によりアイトラッキング領域でも成功例は出てきている。ただしCPUの性能にはまだ限界があり、リアルタイムでの精度の高い計算には制限がある。

また安定した効率的な機械学習ソリューションを用意するためには、異なる条件下にある何千人ものユーザーから、大量で正確な学習データを取得する必要がある。しかしコスト面でも正確性の面でも、実際には収集できるトレーニングデータの量と品質には制約がある。

VRデバイス「Oculus Rift」や「Oculus Go」などの製品も持つFacebookが、OpenEDS Challengeを開催し、機械学習やコンピュータビジョンの研究者の参加を求めるのには、こうした背景がある。OpenEDS Challengeでは、2つの課題が提示された。

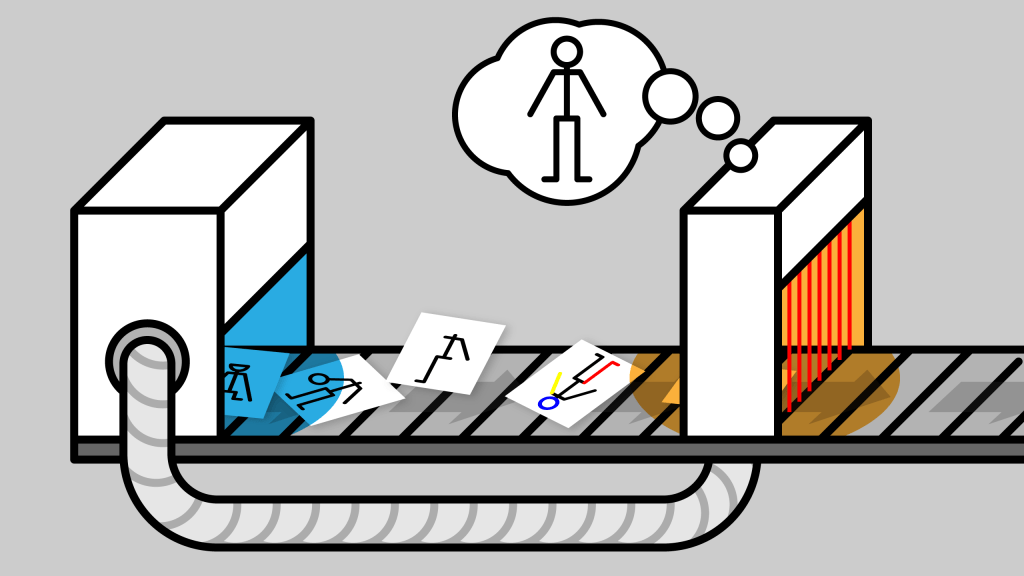

1つは、2D画像から眼の瞳孔や虹彩、強膜、そしてその他の部分の位置を正確に推定する「セマンティックセグメンテーション」。もう1つは、入手が困難な現実の視線データに代わり、現実的な眼の画像を合成して効率的なデータ学習が行えるようにする「Synthetic Eye Generation(シンセティックアイジェネレーション)」だ。

このうちセマンティックセグメンテーションの課題で、クーガーに所属するDevanathan Sabarinathan氏とDr. Priya Kansal氏によるAIモデルが3位にランクイン。さらにこのモデルの独自性が評価され、11月に韓国・ソウルで行われるコンピュータビジョンのカンファレンス「ICCV」ではこのモデルについての論文が採択され、発表が決定している。

既存手法を活用してコンペ条件をクリア、入賞も果たす

セマンティックセグメンテーションの技術は、VR/ARデバイスなどで視線追跡を行うときに、2D画像の正確な認識、つまり眼の重要な領域(強膜、瞳孔、虹彩)とそれ以外の領域をピクセル単位で区分するために必要なものだ。認識の精度の高さとリソース消費の少なさが求められるため、今回のFacebookのコンペでは「モデルの精度」「モデルサイズの軽量化」の視点で審査が行われた。

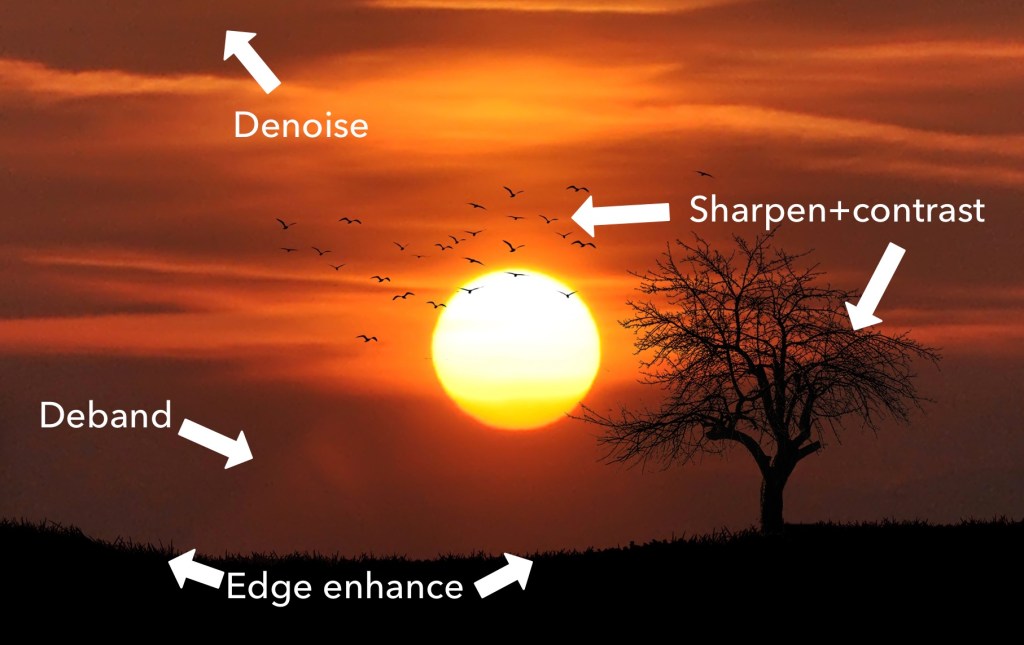

クーガーが発表したEyeNetモデルによる認識結果画像

今回クーガーが発表したモデル「EyeNet(アイネット)」は、7月に米国で開催された別のコンピュータビジョンに関するカンファレンス「CVPR」で同社が発表した、骨格認識のモデル「SkeletonNet(スケルトンネット)」をベースに開発された。OpenEDS Challengeでは、高精度を保ちながら、モデルサイズを2MB以下、モデルのパラメータ数(複雑さ)を40万以下に抑えるという条件をクリアしなければならない。結果、クーガーのモデルは提示されたベースラインをクリアしただけでなく、世界3位を獲得することができた。

ベースラインのモデルの数値:

mIoU: 0.89478

Model Complexity: 416,088.00000

Total Score: 0.76240クーガーのモデルの数値:

mIoU: 0.95112 (6.3%の向上)

Model Complexity: 258,021.00000 (38%の向上)

Total score: 0.97556 (28%の向上)

このコンペティションで上位入賞を果たしたチームは認識精度を上げるうえで、主にデータの前処理での工夫に注力している。クーガーは、インプットデータのどの部分を重視するかを決定する「アテンション機構」の複数使用や、Microsoft Researchが2015年に考案した、高い画像認識能力を持つニューラルネットワークモデル「Residual Network」を組み合わせることなどによって、モデルの精度を向上しながら軽量化も果たしたという。

より自然なコミュニケーションのために人型AIアシスタントを開発

クーガーは2006年の創業。ホンダへのAI学習シミュレータ提供や、Amazonが主催するロボットコンテストAmazon Robotics Challenge(ARC)上位チームへの技術支援、NEDO次世代AIプロジェクトでのクラウドロボティクス開発統括などで知られる。ゲームAI、画像認識AI、ブロックチェーンの分野に強みがあり、現在は人型AIアシスタント「Connectome(コネクトーム)」の開発・提供に力を入れている。

クーガー代表取締役CEOの石井敦氏は「人型AI、バーチャルヒューマンエージェントには、ゲームAIによる生きているように感じるキャラクター性、視覚情報から状況を理解する画像認識能力、情報の信頼性を担保し、安全にデータを扱うブロックチェーン技術の3つすべてが必要」と話す。「当社は3つの分野それぞれで、世界トップクラスの技術を持っている。そのうちの画像認識領域での成果のひとつが、今回のOpenEDS Challengeでの3位入賞だ」(石井氏)

Connectomeは音声認識、映像認識、そして表情やしぐさから感情を認識する機能やジェスチャーを認識する機能を持つ。

コンピュータのモニターやデジタルサイネージで動く「モニターモード」やタブレット、スマホのようなモバイル機器で動く「ARモード」が開発されており、ショッピングセンターやコワーキングスペースなどの施設の案内や利用者とのコミュニケーション、イベント実況などで活用が進められている。

「Siri」や「Googleアシスタント」をはじめ、スマートスピーカーなど音声によるAIアシスタントはある程度、一般化してきたが、わざわざ人間のように振る舞うエージェントを用意するのはまだ、ハードルも高い部分もある。また、中には「機械やキャラクターでも用が足りるのに、必ずしも人型にすることはないのではないか」という論もある。石井氏に人間のようなインターフェースを持つ、バーチャルヒューマンエージェントを開発する意図を聞いてみた。

「ロチェスター大学の研究では、バーチャルヒューマンとASD患者の10代の若者たちが会話するプロジェクトで、患者の60%が実際の人間より話しやすいと回答している。また、南カリフォルニア大学の調査では、音声のみでコミュニケーションを取るときと比較して、バーチャルヒューマンを使った場合、応答率は17%増加し、応答時間は19%増えたという結果もあり、人型が相手の方が利用者が出す情報量が増え、共感が生まれることが分かっている。人型AIの方がコミュニケーションがより自然になり、人間の信頼度も上がる。特にヘルスケア領域などでは、キャラクターよりも人のようなもの、より人に近いものと話したい人は多いと考えている」(石井氏)

石井氏は「目線の分析はもはや当然になっていて、より細かな分析へと焦点は移っている」として、バーチャルヒューマンエージェントへの画像認識技術の応用について、こう語った。「クーガーではコンピュータビジョンの分野で強みを持ちながら、バーチャルヒューマンを開発している。またバーチャルヒューマンエージェントのSDKを他社にも提供することで、ユースケースの拡大を図っている。ゆくゆくは今回発表したアイトラッキングの認識技術をSDKにも取り込むつもりだ」(石井氏)