科学者たちが健康な被験者の脳に直接接続を行い、言葉を生成して音声として再生することに成功した。これは深刻な医学的状況にある人たちが、発話できる可能性につながって行く素晴らしい技術だ。この技術は実用からはまだ遠い段階だが、科学的成果は本物で、見込みは確かにある。

カリフォルニア大学サンフランシスコ校の脳神経外科医であり、米国時間4月24日にNatureで発表された論文の共著者でもあるエドワード・チャン(Edward Chang)氏は、プレスリリースの中でチームの成果のインパクトを次のように説明している。「今回初めて、この研究によって、個人の脳の活動から完全な発話の文章が生成できることが示されました。これは、発話機能を失った患者さんに対して、すでに手の届くところにある技術を使って臨床的に実現可能なデバイスを作ることができるということを示す、勇気付けられる証明なのです」。

はっきりさせておきたいのだが、これは単に機械の前に座れば、頭の中の思考をスピーチに変換してくれる魔法の機械ではない。正確に言えばこれは、対象が考えていることではなく、実際に話していることをデコードする、複雑で侵襲的な手法なのだ。

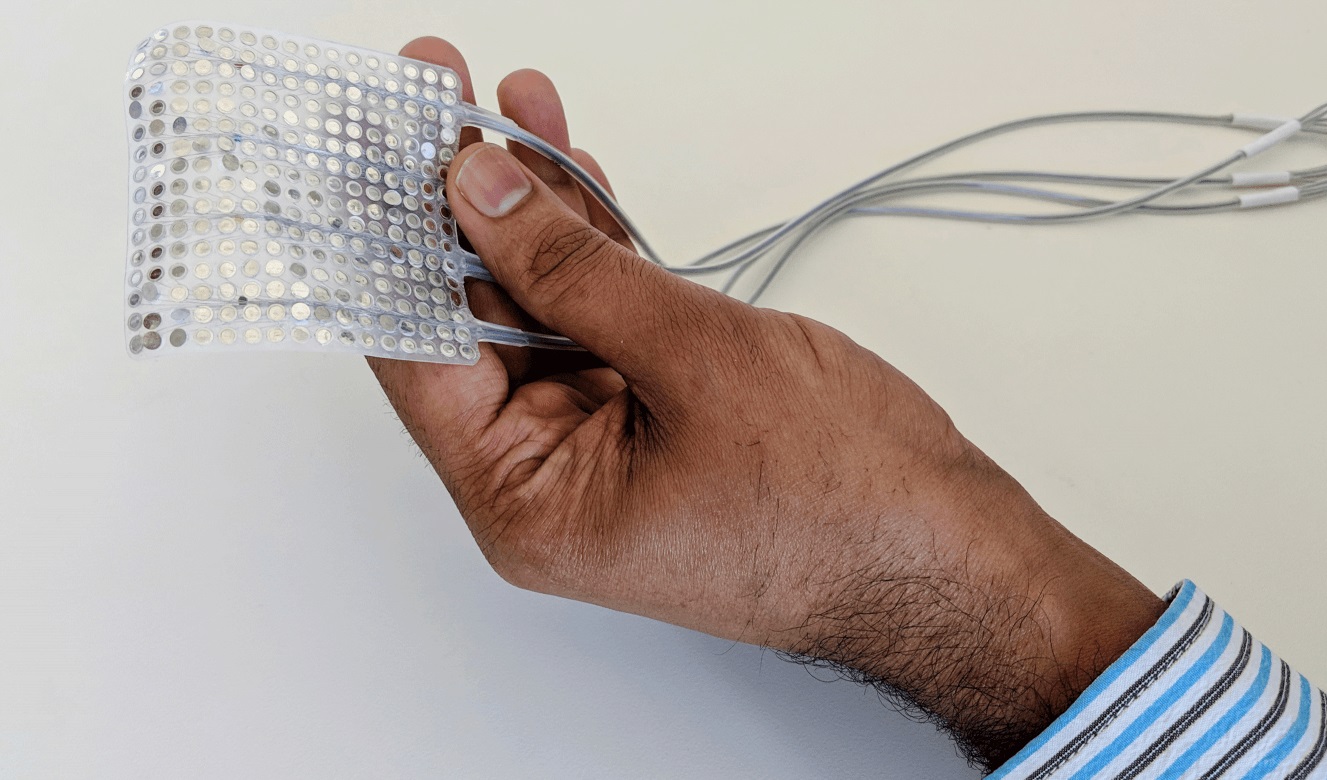

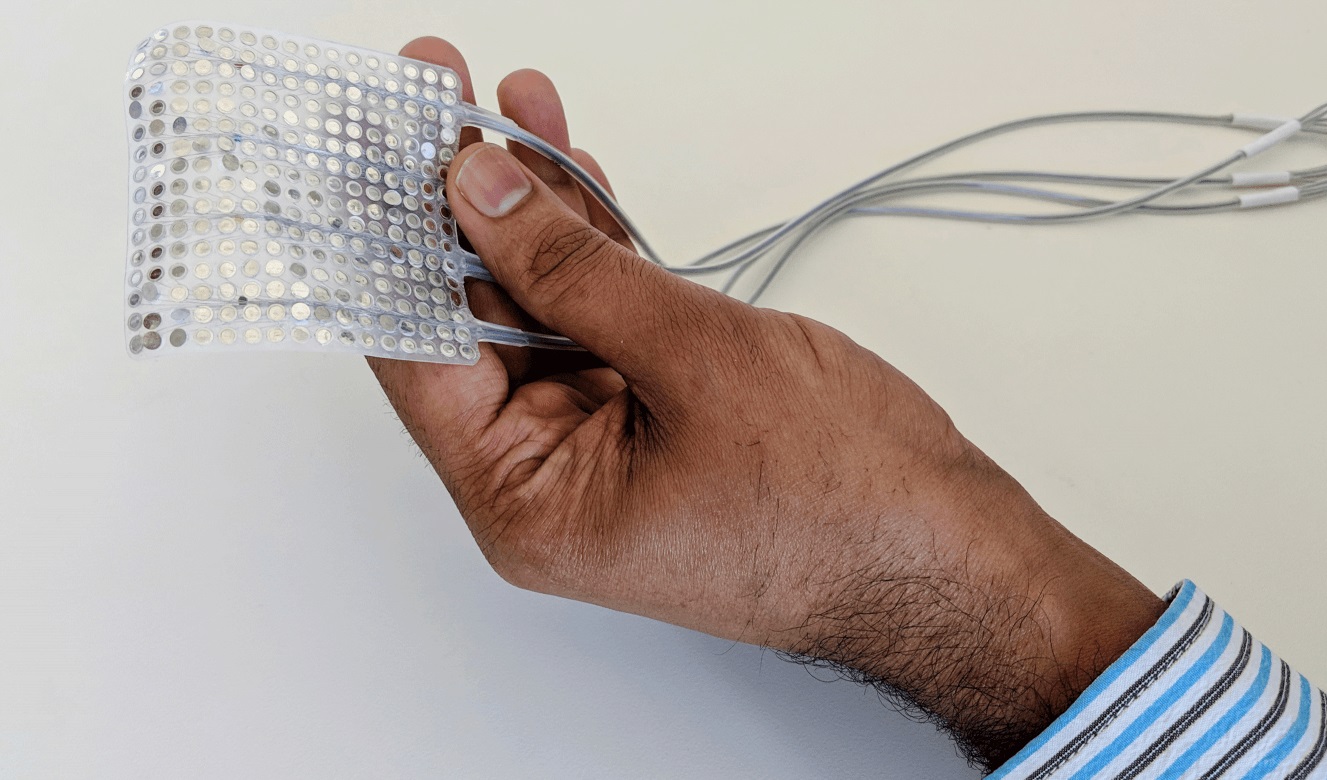

発声科学者のゴパラ・アニュマンチパリ(Gopala Anumanchipalli)氏に主導されたこの実験は、他の医学的処置のために既に脳に大きな電極が埋め込まれていた被験者に対して行われた。研究者たちはこの、運のいい被験者たちに、数百の文を大声で読んでもらい、同時に電極が捉えた信号を詳細に記録した。

脳に装着された電極

すると、言葉を考えて並べようとした瞬間から、最終的に信号が運動野から舌や口の筋肉に送られるまでの間に起きる脳のアクティビティ(ウェルニッケ野やブローカ野などの大脳皮質領域で起きるもの)に、ある種のパターンがあることに研究者たちは気が付いた。アニュマンチパリ氏と彼の共著者である大学院生のヨシュ・シャルティエ(Josh Chartier)氏が、以前解析していたものと関連する信号が存在していたため、彼らはそれを発話の再構成の目的に利用できるかもしれないと考えた。

音声を直接分析することで、チームはどの筋肉と動きがいつ必要になるか(これは良く確立された手法だ)を判断することができ、これを使ってその人物の発声システムの、一種の仮想モデルを構築した。

次に彼らは機械学習システムを利用して、セッション中に検出された脳のアクティビティをその仮想モデルに写像した。すなわち本質的には脳の記録を使って、口の動きの記録を制御することができたということだ。繰り返すが、これは抽象的な思考を言葉にしているのではない、ということを理解することが重要だ。このシステムが理解しているのは脳が顔の筋肉に対して送っている具体的な命令であり、その命令による動きが生み出すであろう言葉を決定しているのだ。これは脳を読んでいるのであって、心を読んでいるのではない。

結果として得られる合成音声は、はっきり明瞭なものではないが、確かに理解することは可能だ。そして正しく設定することで、他の方法ではおそらく話すことができない人から、毎分150ワードを引き出すことが可能になるかもしれない。

「話し言葉を完全に真似るには、まだまだ時間がかかります」とシャルティエは語る。「それでも、私たちがここで生み出した正確さのレベルは、現在使える他のリアルタイムコミュニケーション手法と比べて、驚くほど改善されたものとなるでしょう」。

たとえば進行性筋疾患に罹って苦しんでいる人の中には、視線によって文字を1つずつ入力して単語を綴ることで発話しなければならない人も多い。1分あたり5〜10単語がせいぜいで、より重度の障害者のために使われる他の方法は、さらに遅くなる。コミュニケーションを取ることができるという意味では、それはある意味奇跡だが、こうした時間がかかりあまり自然とは言えない手法は、実際の発話のスピードや表現力と比べると段違いなのだ。

より良い「双方向」脳=コンピューターインターフェイスの研究が進んでいる

もしこの手段を使うことができたなら、完全な正確さは無理かもしれないが、遥かに普通の喋り方に近付くことができるだろう。しかし、これは問題を一撃で打ち砕く魔法の弾丸ではない。

この手法の問題点は、健全な音声システムに近いものから慎重に収集された、脳から舌先に至るまでの大量のデータを必要とすることである。障害が既に起きてしまったひとにとって、このデータを集めることはもはや不可能だし、それ以外の人の場合でもデータ収集のための(脳に電極を装着する)侵襲的なやり方は、医師から推奨されない可能性がある。そして、ある人が話すことをそもそも妨げてきた条件は、この手法が機能することも同様に阻害するだろう。

良いニュースは、これは始まりに過ぎないということで、理論的には上手くいく条件が沢山あるということだ。そして、脳卒中や病気の進行の危険性が高いと考えられる場合には、脳と発話の重要な記録データを、事前に収集しておくことができるだろう。

[原文へ]

(翻訳:sako)