任意団体NPO「ZIAI」は1月13日、SNS上に投稿された自殺関連キーワードを自動で収集し、アカウント名や投稿内容を整理して一覧化、ワンクリックで該当者へのアプローチを可能にする自殺検知システムのβ版をリリースしたと発表した。

令和元年の自殺者総数から逆算すると、日本では毎日55人が自殺しており、自殺死亡率(人口10万人あたりの自殺者数)もG7中で最下位という。特に10代後半から20代の男女では、死亡原因の第1位が自殺という状況が続き、自殺による経済損失は年間数千億円にのぼるとされる。

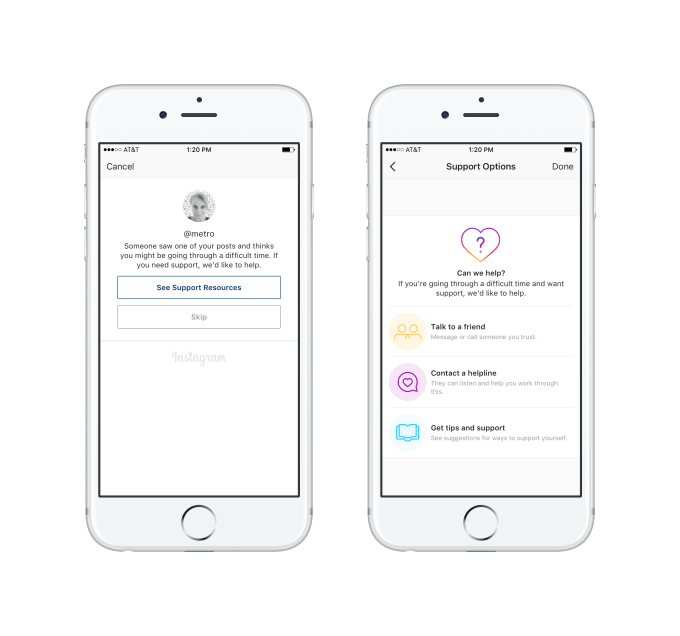

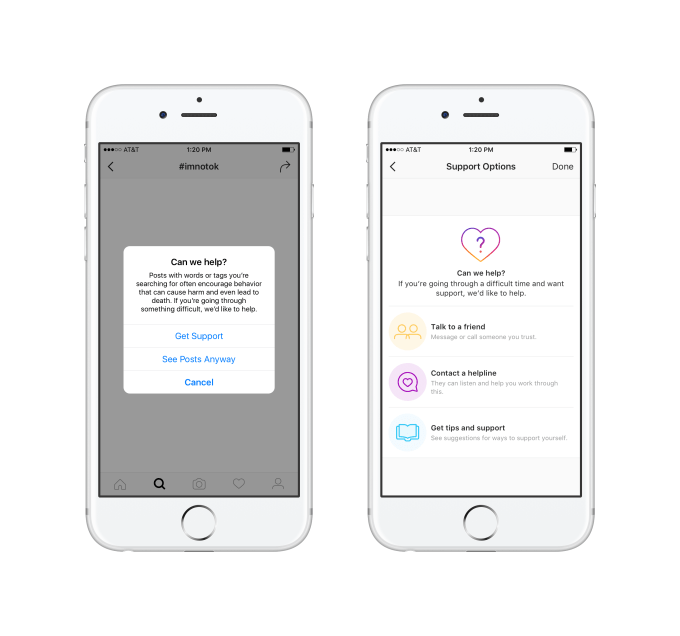

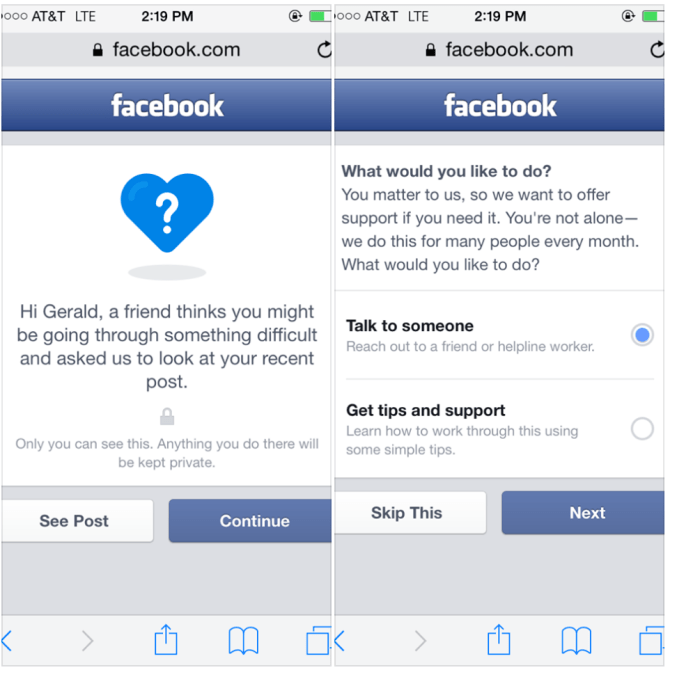

その対策として、現在の日本では、自殺に関連するキーワードを主要インターネットメディアに記載・検索・投稿すると、厚生労働省や関係NGO、各地域の相談窓口が自動的に表示されるものの、これらはいわゆる「プル型」の仕組みとなっている。

政府としてもSNSを活用したオンライン相談の取り組みを強化しているものの、年間53万人とされる自殺未遂者の推計に対し、年間のSNS相談件数は約2万件、つまり全体の4%に過ぎないという。

ZIAIは、SOSを受け身で待つのではなく、社会からその声を拾い上げる「プッシュ型」の仕組みが必要不可欠としている。

AI自殺検知システムは、インターネット上の自殺関連投稿データをリアルタイムで自動収集し、ハイリスク者に対して連絡を行う。アカウント名や投稿内容を整理して一覧化し、AIアルゴリズムとプロのカウンセラーの視点を掛け合わせ、ハイリスク者と判定された方のみにワンクリックでメッセージを送ることが可能。

今後はオンライン相談を実施する関連NGOや教育・医療機関と連携し、返信者に対するオンライン・オフライン双方での介入を進めることで、社会からSOSの声を拾い上げる世界の実現を目指す。

ZIAIは、自分を殺すのではなく、自分を愛せる社会を創ることをミッションとした非営利Tech集団。ハイリスク者の感性分析によるアルゴリズム開発やSNS自殺検知システム開発など、テクノロジーを軸にした自殺予防の仕組み作りを行っている。

メンバーは社会起業家やスタートアップのCTO、海外在住のデータサイエンティストなど、それぞれが本業を持つスペシャリストで構成されている。

自殺行為自体を未然に防ぐことは、この問題の根本的解決ではなく、それに至った背景や原因を取り除いて初めてその対象者にとって意味のある活動になるという。今後もZIAIは、テクノロジーを軸に、国や地方自治体、医療や教育機関、NGOとの有機的な連携を促進し、自殺念慮(死にたい気持ち)を予防するための解決策を模索し続けるとしている。

関連記事

・2021年に最優先すべきはパンデミックから精神的に立ち直るための技術

・自分だけのAIライフパートナーと対話できる「PATONA」アプリのCapexが総額1億円を調達

・AIが思考と感情を分析しメンタルケア手法「ジャーナリング」を支援するmuuteアプリ

・コロナ禍で急成長の瞑想アプリ「Calm」が日本上陸、日本語オリジナルコンテンツも提供開始

・Facebookライブにアップされた自殺動画の拡散防止に失敗した各SNSの理由

・チャット相談サービス「メンヘラせんぱい」がキャバ嬢と臨床心理士に相談できる新プランを提供

・Daybreak Healthが10代向けオンラインメンタルヘルス治療を開始

・メンタルヘルスをタブー視するアジアの文化に挑むIntellect

・Netflixがメンタルヘルス関連の若者向けインスタライブシリーズを開始

・Redditが精神的に追いつめられた人をサポートするメンタルヘルスのCrisis Text Lineと提携

・瞑想の医学的有効性を証明するためHeadspaceが100億円調達