Google(グーグル)のSmartReplyは、4年前にリリースされたAIテクノロジーを利用した省力化ツールで、GmailをはじめAndroidのMessages、Play Storeのデベロッパーコンソール、その他の場所で受信した内容を解析し、ふさわしい返信案の候補を表示する。 この機能をYouTubeのクリエーターも利用できるようになった。

同社の発表によれば、最新版のYouTube向けSmartReplyはビデオのクリエーターがファンのコメントに対して素早く効率的に返信できるようにすることを狙っているという

この機能はYouTubeのオンラインダッシュボードであるYouTube Studioに導入された。これは、クリエーターがビデオを管理し、統計をチェックすることなどによりチャンネルをプロモーションし、ファンとの交流を図るために設けられたツールだ。クリエイターはYouTube Studioのコメント欄からチャンネルのコメント全体を表示し、返信処理ができる。

YouTubeで多数のフォロワーを持つクリエイターにとってコメントへの返信は非常に時間のかかる作業だ。SmartReplyはこの問題の軽減を狙っている。

クリエイターは視聴者からのコメントをいちいち読んで返信を手入力せず、提案された返信案の1つをクリックして返信できる。たとえばファンが「次のビデオのテーマは何?」と尋ねている場合、SmartReply機能は「ありがとう!」や「どんどん続くよ!」といった返信を提案する。

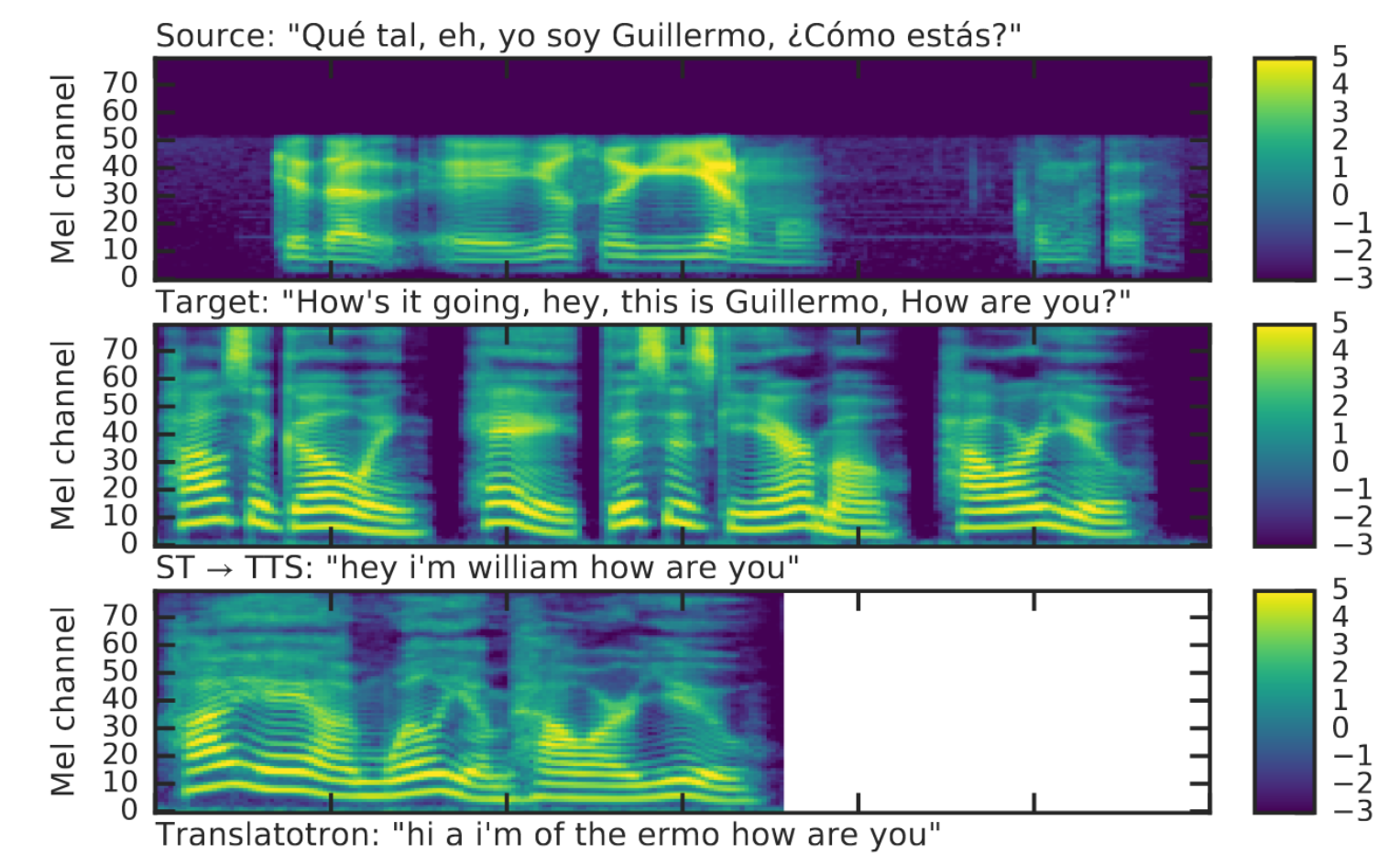

GmailのSmarReplyは単語と短いフレーズを解析できるが、YouTube向けにの新バージョンはさらに幅広い子コンテンツ解析能力が必要だった。グーグルによればYouTubeコメントでは「絵文字、アスキーアート、言語種類の認識などを必要とした」ということだ。YouTubeのコメント投稿には略語、スラング、つづりの揺れなどが頻繁にみられる。このためYouTubeへのSmartReply実装には大きな困難があった。

Google AI Blogの記事に、こうした課題(やその他の課題)をどのように解決したがが詳しく説明されている。

SmartReplyはクリエーターが返信したいと考える可能性が高いコメントを選び、しかも適切な返信内容をを提案する必要があった。コメント内容を正しく認識するために機械学習をトレーニングするシステムが必要だったと同社は述べている。

スタートの時点はSmartReplyは英語とスペイン語のコメントで利用可能となっている。これはSmartReplyとして初のシステム言語の自動切り替えを含む複数言語サポートとなる。言語の種類や絵文字を認識するため文字符号を利用するシステムだという。

「SmartReplyはこうしたアプローチを利用しているため、この機能を今後さらに多数の言語に拡張することが可能となっている」と同社は説明する。

[原文へ]

(翻訳:滑川海彦@Facebook)