Microsoft(マイクロソフト)の主任研究員であるCecily Morrison(セシリー・モリソン)博士が視覚障がい者にとってAIがどう役立つかを研究しているのは、強い個人的な思いによるものだ。博士の7歳の息子が視覚障がい者だからというだけではない。人を助けるパワフルなAI関連テクノロジーは、それぞれの人の環境や能力に応じてサポートするパーソナルなものであるべきだとの信念があるからだ。

Microsoft Research Cambridgeでヒューマン・コンピュータ・インタラクションやAIについて研究しているモリソン博士は「ユーザーが自分の体験をパーソナライズできるような新しいAIテクノロジーが登場するだろう」と言う。「一人ひとり、すべての人が異なる。障がいがあるというラベルは、同じラベルを持つ別の人と同じニーズを持つという意味ではない。それぞれに固有のニーズに合わせて体験をパーソナライズするために、新しいテクニックによって障がい者の情報のニーズをごくわずかなサンプルでAIに教えることができる。テクノロジーは障がいというラベルのためのものではなく、パーソナルなニーズのためのものになる」。

画像クレジット:Cecily Morrison

モリソン博士は12月2日と3日に開催されるバーチャルのグローバルイベント、Sight Tech Globalで講演をする。Sight Tech Globalは、AI関連テクノロジーによって視覚障がい者のアクセシビリティの未来がどのように具体化されるかを考えるイベントだ。先日、TechCrunchで開催が発表され、現在は事前登録を受け付けている。

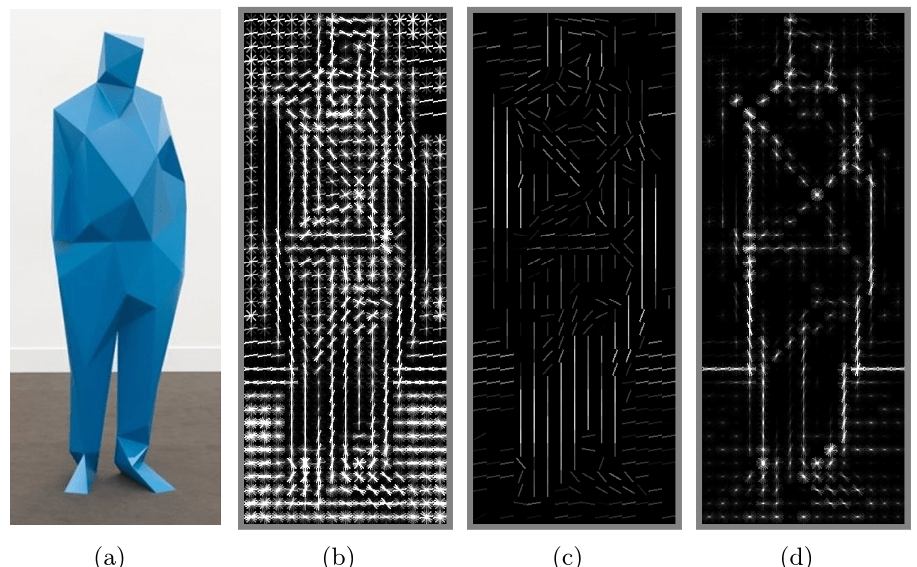

モリソン博士は現在、全盲やロービジョンの人々に対するAIの可能性を探るいくつかの研究プロジェクトに関わっている。例えばProject Tokyo(Microsoft発表)では、周囲の状況に関する情報をリアルタイムで提供し、意味づけのスキルと能力を拡張する方法を研究している。

研究チームは全盲やロービジョンの人々と緊密に連携し、その体験とニーズに基づいて研究をしている。「きわめて重要なのは、全盲やロービジョンの人々の能力を高めるためにテクノロジーは何ができるのかを考えることだ。視覚障がい者の多くは高度なストラテジーをもって周囲を認識し意味づけている。AIテクノロジーは、情報のギャップをカバーすることでこうした高い意味づけのスキルをさらに強化するものでなくてはならない。テクノロジーは視覚の代わりではなく、人が生活の中ですでに持っている情報を補強するものと捉えることが大切だ」。

視覚障がいの子を持つ母親としてモリソン博士は「違う視点で世界を見てきたし、他の立場では見ることも参加することもなかったであろうコミュニティに参加してきた」という。このことは間違いなく博士の研究を後押ししてきた。インクルーシブデザインのプロジェクトであるProject Torino(Microsoftブログ)は、視覚障がいを持つ子どもたちがプログラミングを学ぶというニーズから発想を得ている。このプロジェクトから、視覚の程度を問わず7〜11歳の子どもが計算論的思考と基本的なプログラミングを学ぶための物理プログラミング言語が作られた。この取り組みがCode Jumperというプロジェクトにつながり、視覚障がい者の教育や自立支援に取り組むNPOのAmerican Printing House for the Blindから有料で販売されている。

視覚障がいを持つ7〜11歳の子どもたちと緊密に連携して試行錯誤することで、このプロジェクトが成功した。そしてモリソン博士は、対象となる人々と研究者が緊密に連携する重要性について理解を深めた。さらに博士は、視覚に制限のある人々は一般に、テクノロジーに対して際立ったアーリーアダプターであると指摘する。

モリソン博士は次のように語る。「エージェントを利用した空間で、我々は全盲やロービジョンの人々とともに研究をしてきた。なぜなら、我々がエージェントの研究を始めた時点では、一般の人はエージェントのヘビーユーザーではなかったからだ。それどころか、ほとんどの人がエージェントはおもちゃだと考えていた。その一方で視覚障がい者はエージェント技術のアーリーアダプターでありヘビーユーザーだった。彼らはエージェント技術の可能性を広げるための大きな力になった。テクノロジーを日常的に使っていなければ、今後どうなるかを想像することはできない。能力の高い視覚障がい者のグループと協力して、未来のエージェントが私たちすべてにとってどのようなものになるかを考えることができる。これはインクルーシブデザインの好例だ」。

モリソン博士はケンブリッジ大学でコンピュータサイエンスの博士号を取得し、コロンビア大学バーナードカレッジで民族音楽学の学士号を取得した。パートナーと2人の子どもがいて、子どものうち1人は視覚に障がいがある。

現在、Sight Tech Globalでは事前登録を受け付けている。メインプログラムは無料で視聴できる。

Sight Tech Globalはスポンサードを受けて開催するイベントで、これまでにWaymo、Google、Wells Fargo、TechCrunch、Verizon Mediaがパートナーとなっている。収益はすべてNPOのVista Center for the Blind and Visually Impaireの収入となる。スポンサーシップについての問い合わせはsponsor@sighttechglobal.comまで。

画像クレジット:Sight Tech Global

[原文へ]

(翻訳:Kaori Koyama)