全盲や弱視の子供が成長する過程での難しさは、見える友だちと同じ本を読んだりゲームをしたりすることができないだけではない。視覚は社会的な交流や会話において大きな役割を担っているという問題がある。マイクロソフトのプロジェクトでは、視覚障がいのある子供が話している相手を「見る」ためにARを活用する研究に取り組んでいる。

画像:Jonathan Banks / Microsoft

当然のことながら、視覚障がい者には周囲の人が見えないという難題がある。そのため、晴眼者が会話の際に利用している多くの非言語の手がかりを、視覚障がい者は見つけたり利用したりすることができない。早期にそのような行動を学習していない場合は、特にそうだ。

Project Tokyoは、AIやARといったテクノロジーを障がいのある人も含め「すべての」人に役立てようとする、マイクロソフトの研究者たちの新たな取り組みだ。すべてのケースに当てはまるわけではないが、音声対応のバーチャルアシスタントはタッチスクリーンやマウス、キーボードを使いづらい多くの人の役に立つはずだ。

研究チームは数年前、非公式にアクセシビリティの向上に取り組み始めた。まずリオデジャネイロで開催されたパラリンピックを訪れ、人々を観察した。次に全盲や弱視の人々のコミュニティとともにワークショップを実施した。これらのことからチームが気づいた重要なポイントは、ほぼどんな状況でも視覚から微妙なコンテクストが得られていることだった。

マイクロソフトの研究者のEd Cutrell(エド・カトレル)氏は次のように述べている。「私たちは、人間として、他人とのやり取りに関してとても微妙で複雑な感覚を持っています。部屋にいるのは誰か、何をしているのか、自分との関係はどうか、私にとって重要かどうかをどう判断するか、これらを知るための手がかりは私たちにとって当然に得られるものです。しかし、目の不自由な人々にとってはそうではありません」。

このことは子供たちには特に顕著で、このような手がかりや振る舞いについておそらく学んでいないために、社会性に欠ける傾向を示してしまうことがある。会話中にテーブルに突っ伏したり、話している相手の方を見ないといった傾向だ。

補足すると、こうした行動自体に「問題がある」わけではない。彼らにとって最も適切な行動をとっているだけだ。しかしこうした行動は晴眼者との日々の関係を阻害するおそれがある。そのため、すべての人にとって容易で自然な関係の構築を目指す研究には意義がある。

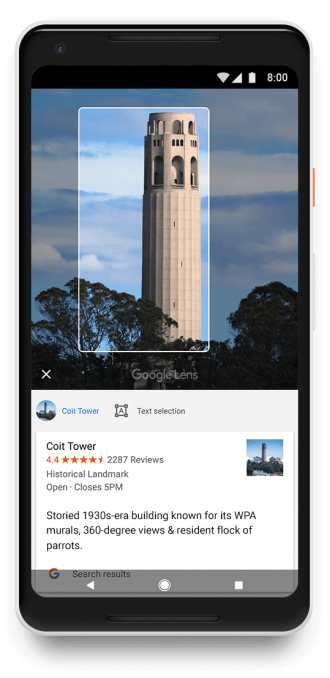

Project Tokyoは、改造してレンズをはずしたMicrosoft HoloLensで実験をしている。HoloLensは、適切な情報を与えられれば物体や人物を識別できるきわめて高度なイメージングデバイスでもある。

ユーザーがこのデバイスをハイテクなヘッドバンドのように装着すると、カスタムのソフトウェアスタックが状況に応じた手がかりをユーザーに提供する。

- 例えば右前方1メートルほどのところに人物を検出すると、ヘッドセットがその方向から鳴っているようなクリック音を発する。

- その人物の顔が既知である場合、先ほどとは別の弾くような音が鳴り、その人物の名前が読み上げられる(前述のクリック音と同様に、この音もユーザーにだけ聞こえる)。

- 未知の顔の場合やうまく認識できない場合は、ゴムバンドが伸びているような音が鳴る。ユーザーの顔の向きに応じて音が変化し、顔を相手に向けるようにガイドする。相手の顔がカメラの中央に来るとクリック音が鳴る(つまりユーザーが相手をまっすぐ見ることになる)。

- 周囲に人がいる場合、ヘッドバンド上のLEDが検出された人物の方向に白く光り、人物が特定されると緑に光る。

ほかの機能も研究されているが、このセットが出発点であり、12歳のTheo(セオ)という少年のケーススタディではこのセットが特に有効と考えられている。

システムやセオとの実験などについてはマイクロソフトの記事に詳しく記されているが、基本的にセオはシステムを詳しく理解し、それにより晴眼者が主に使用している手がかりによって社会的な関係性に対処できるようになっている。例えば、相手に顔を向けて意図的に注目できるようになってきた。また、室内を自分なりの方法でスキャンして周囲の人を常に意識する方法も自ら身につけた。どちらもテーブルに突っ伏していてはできないことだ。

できることが増えるのは良い取り組みだが、もちろんまだ発展途上だ。高価でかさばるハードウェアを一日中身につけたくはないし、ユーザーごとにニーズが異なるのも当たり前だ。表情やジェスチャーについてはどうだろうか? 看板やメニューはどうする? 最終的にProject Tokyoの未来は、AIシステムなどのモダンなツールを構築する際にはほとんど関わりを持たないコミュニティのニーズによって決まるだろう。

[原文へ]

(翻訳:Kaori Koyama)