あの銀河ヒッチハイク・ガイドに出てくる不思議な万能翻訳機「バベルフィッシュ」がどんどん現実に近づいている。 Googleの新しい研究プロジェクトは音声で話しかけられた内容をリアルタイムで音声で通訳できるシステムを目指している。

従来の機械翻訳とは大きく異なった仕組みで、中間にテキスト化の段階を含まず、すべて音声レベルで処理される。これは処理の高速化に役立つのはもちろんだが、もっと重要な点は話者の語調その他の音声的ニュアンスをいっそう正確に処理できることだ。

このプロジェクトはTranslatotronと名付けられており、長年の研究を基礎としているものの、まだ開発の初期段階にあるという。Google他の開発者はスピーチから直接スピーチに変換するリアルタイム通訳の実現を目指して努力を重ねてきたが、見るべき成果が上がり始めたのはほんの数年前からだ。

現在、スピーチのリアルタイム翻訳はいくつかの部分に分割して実行されるのが普通だ。ソースのスピーチを音声認識によりテキストに変換(STT、Speech-To-Text)し、テキストを機械翻訳した後、出力テキストをスピーチに変換(TT、Stext-To-Speech)する。この方式は実際かなりの成果を上げているが、完璧には遠い。各ステップに特有の誤差があり、累積すると大きな誤差となってしまう。

またバイリンガル、マルチリンガルの人々が複数の言語を使う場合のプロセスの研究が示すとおり、テキスト化を挟む機械翻訳」は人間の複数言語思考ともかけ離れている。現段階では大脳でどのような処理が行われているのか正確にいうことはできないが、バイリンガルの話者が外国語を使うときに発話内容をいちいちテキスト化して思い浮かべ、それを翻訳しているのでないことは確実だ。人間の思考プロセスは機械学習アルゴリズムを進歩させる上でガイドないしモデルとして利用できる場合が多い。

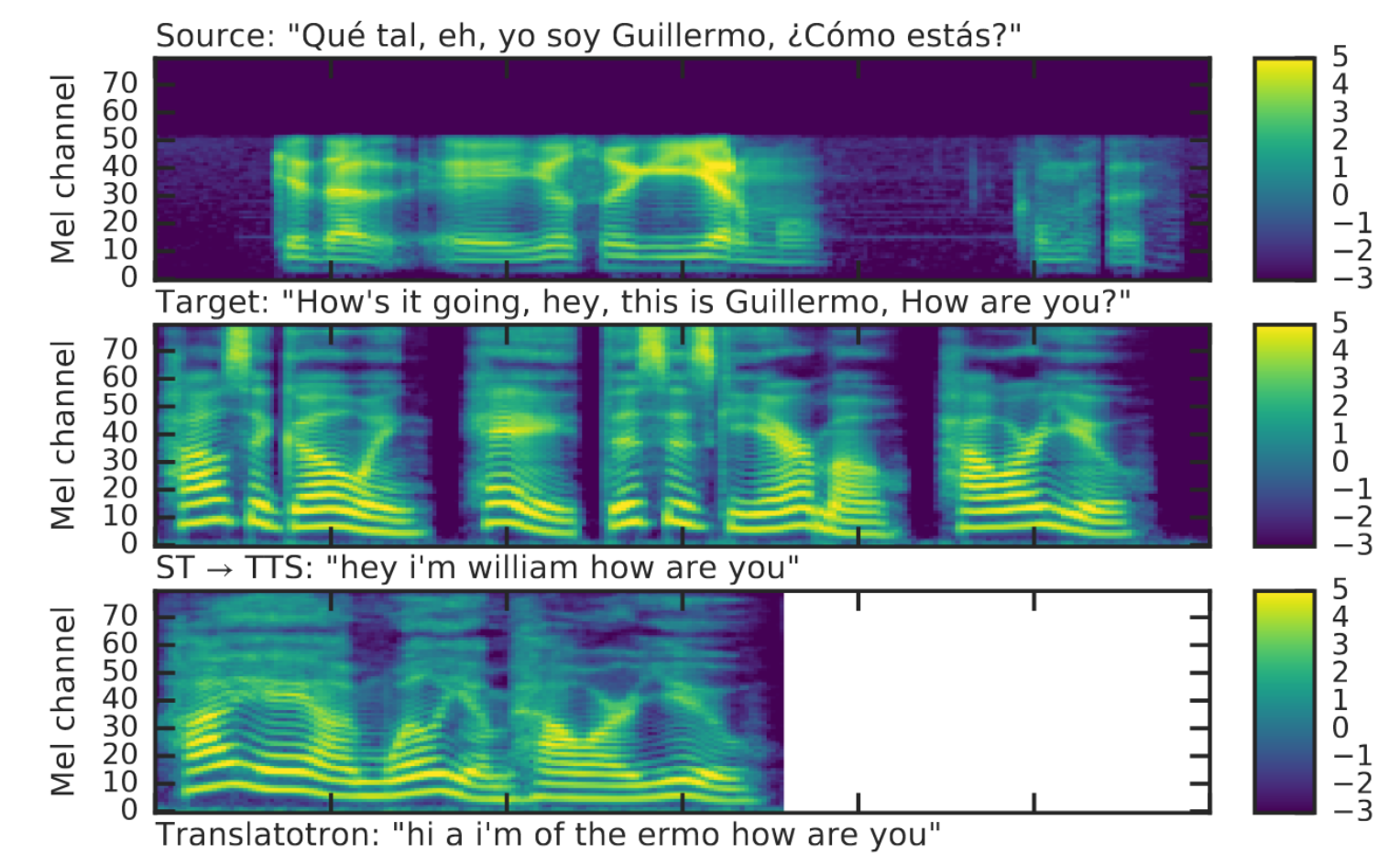

スピーチの音声スペクトル画像。テキストを介した翻訳ではスペイン語の人名「ギェルモ」が対応する英語の人名「ウィリアム」に翻訳されてしまうのに対して、音声直接通訳では「ジエルモ」になっている。これでも正確ではないが、通訳としてベターだ。

これに対して研究者は音声スペクトルを解析して直接対応言語の音声スペクトルを合成しようと努力している。これは伝統的なテキストを介する3段階方式とまったく異なる機械翻訳のアプローチだ。これには弱点もあるが、上の例で示したようにメリットも大きい。

簡単なところでは、十分な計算機資源が用意できるなら現行の3ステップ方式より1ステップのTranslatotronの方が処理が速い。しかしユーザーにとってもっと重要な点は、音声から音声への直接通訳は元の発話の音声の特徴をよく再現できることだ。テキストを介した合成音声がいかにもロボット的に不自然に聞こえるのに対して、Translatatronで生成される文はオリジナルの発話に近いものとなる。

これは意味内容だけが対象言語に翻訳されるのではなく、発話の音声に込められた感情やニュアンスも再現されるという点で、機械翻訳を画期的に進歩させる可能性がある。これは通訳アプリに限らず、音声合成のユーザーは非常に大きな影響を与えるだろう。

今のところ、音声直接翻訳の精度は従来のテキストを介した翻訳に及ばず、この点では改良が必要だという。しかし部分的にせよ、非常に優れた翻訳も生まれている。研究グループは「出発点に立ったところであり、可能性を実証した段階」と控えめに表現しているが、実用化されたときのインパクトの大きさを想像するのは難しくない。

オリジナルの研究論文はArxivで公開されている。またう従来型のテキストを介した通訳とTranslatotronによる通訳のサンプルはこのページにある。これらのサンプルはあくまで音声直接翻訳というアプローチの可能性を試すために選ばれており、翻訳精度のアップそのものをを狙ったものではないという。

画像:Bryce Durbin / TechCrunch

[原文へ】

(翻訳:滑川海彦@Facebook)