【抄訳】

YouTubeは米国時間6月27日、ユーザーの「ホーム」ページや「次の動画」の推薦リストに現れるビデオを、ユーザー自身がもっとコントロールできるようにするための一連の変更を発表した。それらのビデオは、YouTubeのアルゴリズムが勝手に決めているものだ。YouTubeはまた、それらの推薦ビデオがなぜどうやって決まったのかをユーザーが理解できるようにする、と言っている。つまり、YouTubeのアルゴリズムの内部を見せると言うのだ。

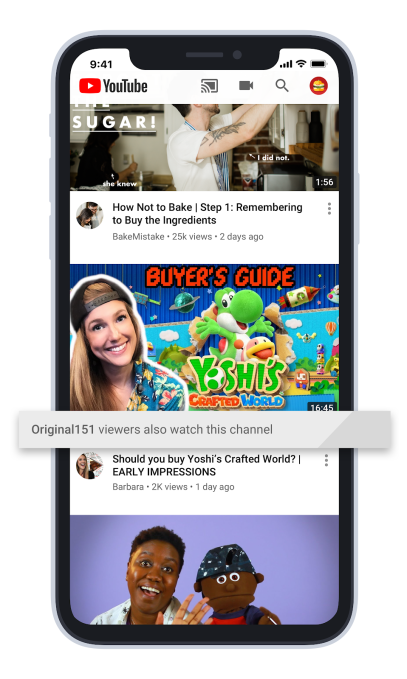

新しい機能として、「ホーム」ページや「次の動画」に登場する推薦ビデオにどんなトピックが関連しているのか、これまでのどんなビデオが関連しているのかがわかるようになる。YouTubeアプリはこれからは、今見ているビデオに関連しているビデオや、ユーザーがウォッチしているチャネルのビデオなど、関心があるとYouTubeが判断したビデオの根拠になっている、個人化された提案を表示し、ユーザーがそれらを見られるようにする。

この機能はAndroidのYouTubeアプリに英語でサインインしているユーザーにまず提供され、iOSやデスクトップ、そしてほかの言語は、もうじきサポートされるそうだ。

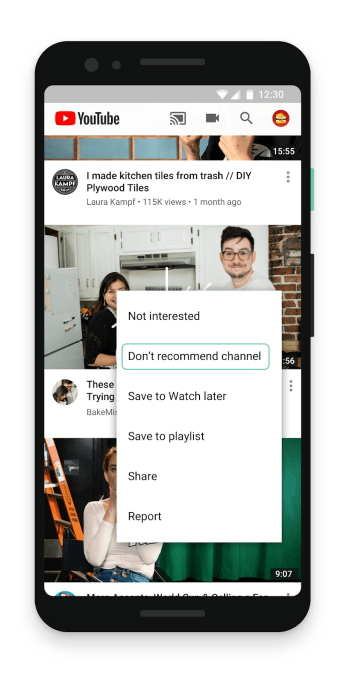

YouTubeの提案がいつものように的外れなら、これからは一連のコントロールにアクセスして、特定のチャネルからの提案をしないよう指示できる。

そのコントロールは、「ホーム」ページや「次の動画」のビデオの隣にある、点が3つのメニューから利用できる。そこで、推薦してほしくないチャネルを指定する。すると次回からは、そのチャネルのビデオが表示されなくなる。

しかし推薦を禁じたチャネルへのサブスクリプション(入会)や検索、そのチャネルのページへの直接の訪問などはできる。YouTubeからの勝手な推薦がないだけで、チャネルの利用方法は前とまったく変らない。そこのビデオがトレンドのタブに出ることもある。

この機能は全世界で利用でき、YouTubeのAndroidアプリに次いで今日からはiOSでも利用可能、デスクトップももうすぐだ。

しかし一番面白いのは、YouTubeがそのアルゴリズムの仕組みをユーザーに少し見せてくれることだ。これまでユーザは、なんでこのビデオが自分に推薦されるのか、まったく理解できないこともあった。今度の新しい機能で、そのビデオがリストに載る理由が詳しくわかる。ビデオの提案の下に、それを選んだ理由が表示される。

YouTubeの発表によるとたとえば、そのユーザーが一度も訪れたことのないチャネルのビデオでも、「関心が共通するほかのユーザーが好きなビデオなら推薦する」というように。「我々の目標は、ビデオを『ホーム』ページで紹介する理由を説明して、ユーザーが気に入るかもしれない新しいチャネルを見つけるお手伝いをする」ことだそうだ。

例えば、その説明は「あなたのお気に入りのチャネルを見ているビューワーが、そのビデオの推薦をしているチャネルも見ている」、と言うかもしれない。YouTubeのアルゴリズムは本当はもっと複雑だが、この「お気に入りの連鎖」は、比較的単純な方だ。

YouTubeなどのソーシャルメディアは、プラットホームの管理について政府の規制当局からも圧力を受けている。プライバシーとセキュリティの問題だけでなくヘイトスピーチや偽情報の拡散などでプラットホームは、不透明なアルゴリズムでユーザーに見せるものを決めていることを批判されている。

【後略】