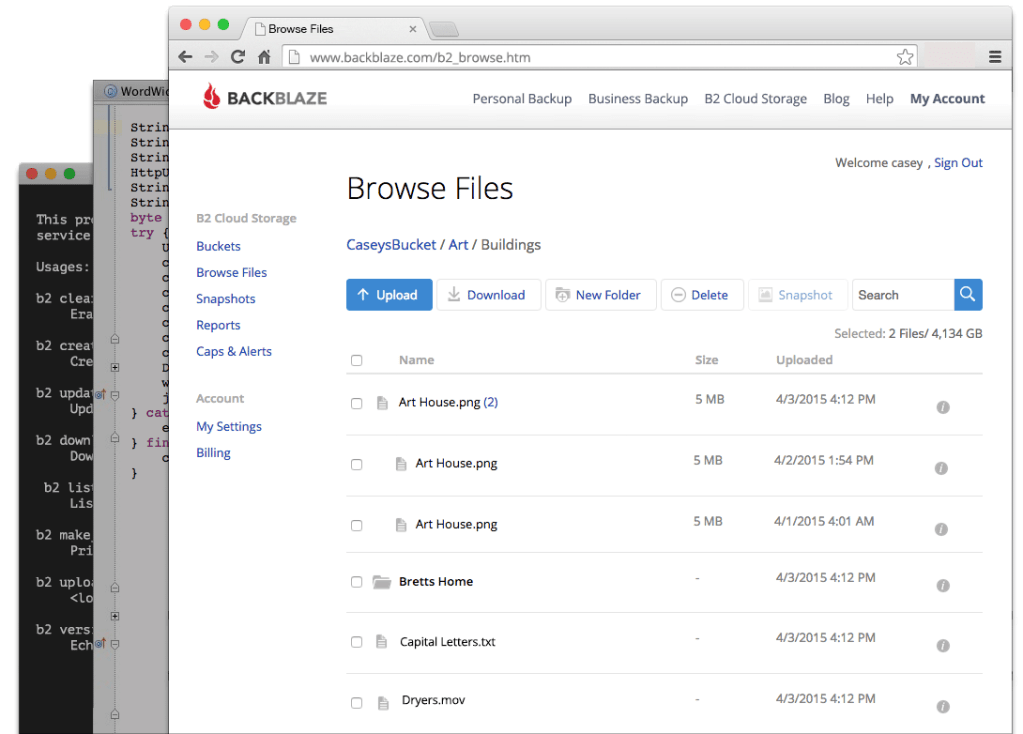

Backblazeは米国時間5月4日、同社のB2 Cloud Storageサービスを、AmazonのS3ストレージサービスとAPI互換にしたことを発表した。

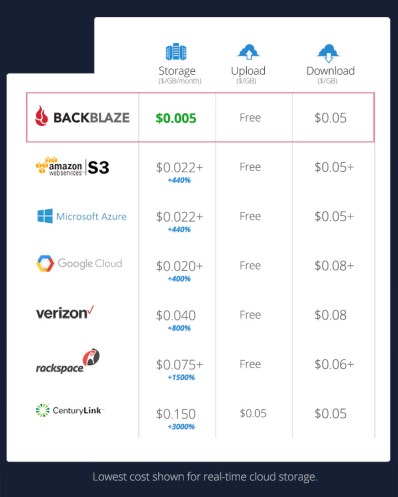

Backblazeは、手頃な価格のクラウドバックアップサービスとして業務を立ち上げた。ここ数年はストレージの専門知識を活用して、デベロッパー向けにB2 Coloud Storageというサービスを立ち上げてきた。大手のクラウドベンダーの同様の機能よりも、大幅に価格が安いのがウリだ。B2の料金は、1GBあたりで毎月0.005ドル(約0.5円)から。ちなみにAWSのS3は1GBあたり毎月0.021ドル(約2.2円)からとなっている。

ただしデベロッパーは、ストレージの料金が安いというだけでは、プロバイダーを切り替えることができない。複数の異なるシステムをサポートするには、それなりのコストがかかる。

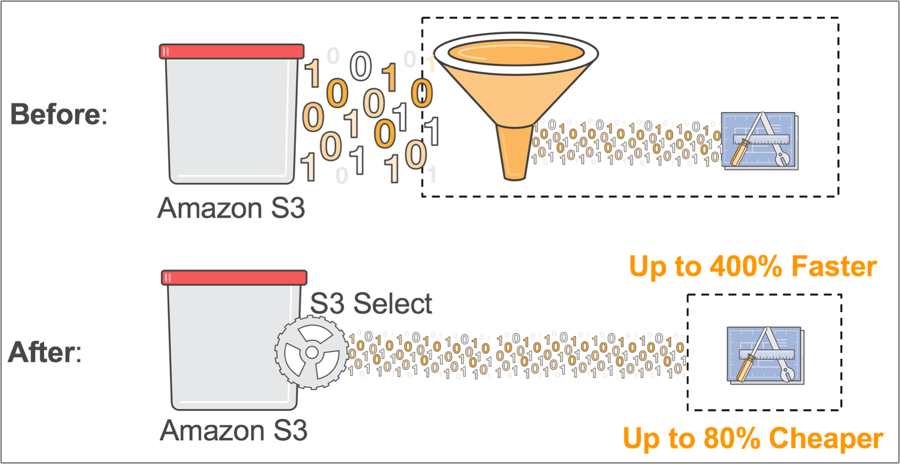

B2をS3に対してAPI互換とすれば、デベロッパーは単にストレージをBackblazeにリダイレクトするだけでいい。大規模なプログラムの書き換えは必要ない。

「ここ数年、多くの企業が、私たちの驚くほど使いやすいクラウドストレージを愛用してきました。それによって信じられないような成果を達成することができたのです」と、Backblazeの共同創立者でCEOのGleb Budman(グレブ・バドマン)氏は述べた。「今回、既存のツールとワークフローをそのまま使えるようにすることで、より多くの企業が私たちのストレージを利用できるようになることに、いっそうワクワクしています」。

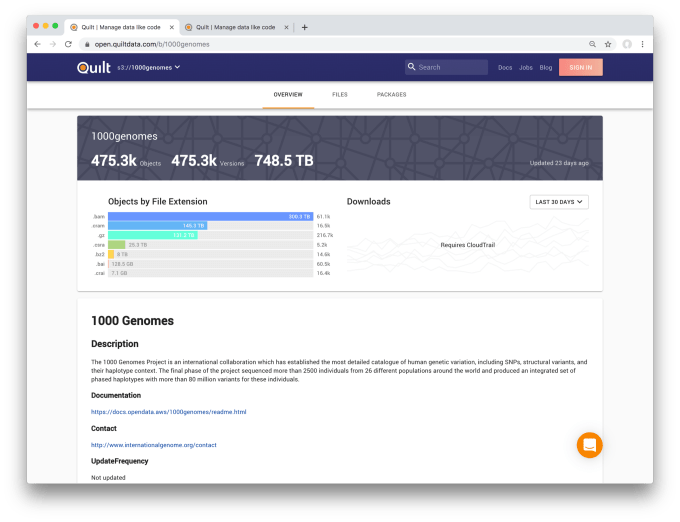

現在のB2の顧客には、American Public Television、Patagonia、Verizon’s Complex Networksといった企業が名を連ねる(編注:VerizonはTechCrunchの親会社であるVerizon Media Groupの盟主)。Backblazeによると、B2サービスには合計で約10万の顧客がいる。今回の立ち上げに最初から参加しているパートナーとしてはCinafilm、ファイル転送およびストリーミングサービスを提供するIBMのAspera、ストレージ専門企業のQuantum、クラウドデータ管理サービスのVeeamなどが含まれている。

「パブリックなクラウドストレージは、ポストプロダクションのプロセスにとって不可欠な要素になっています。最新の機能強化により、ベンダーとしての私たちと顧客の双方にとってBackblazeのB2 Cloud Storageへのアクセス性が向上しました」と、Quantumの製品マーケティング担当上級役員、Eric Bassier(エリック・バシエ)氏は述べている。「新しいS3互換APIを使用して、Backblaze B2をStorNext互換のパブリックなクラウドストレージのターゲットリストに追加できます。それにより、ハイブリッドでマルチクラウドなワークフローを実現するための新たなステップを踏み出すことができるのです」。

[原文へ]

(翻訳:Fumihiko Shibata)