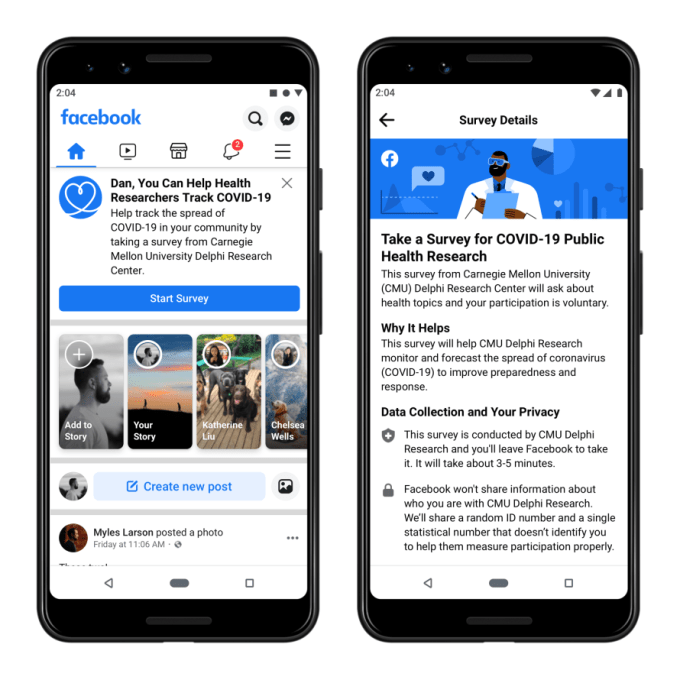

新型コロナウイルス(COVID-19)感染の兆候をモニタするアプリはこれまでも無数に開発されてきたが、今回発表されたFacebookのプロジェクトは影響範囲の広さが桁違いだ。

2020年4月初め、Facebookはカーネギーメロン大学(CMU)のDelphi疫学研究センター(Delphi Epidemiological Research Center)と新型コロナウイルス感染症のモニターに関して提携した。今回、Facebookはこのプロジェクトを全世界に拡大するという。同じく4月上旬から同社は米国のユーザーの一部に対し、新型コロナウイルス感染の自覚症状の有無をCMUの方法により自己チェックしてレポートするよう要請し始めている。これは流行が今後どこに拡大するか政府や医療当局が予測できるようにするプロジェクトだ。

Facebookのプロジェクトの拡大についてはメリーランド大学の研究者が協力する一方、CMUのDelphiチームはすべての研究者がデータを利用できるAPIを開発している。

Facebookは収集した調査データを独自の症候追跡マップに表示する。これにより郡(カウンティ)あるいは担当医療区域ごとに新型コロナウイルス感染症の症状を持つ住民が人口に占める割合を一覧することができる。マップには、新型コロナウイルスとは異なるインフルエンザに対する感染症候も表示される。多くの場所でまだ十分な報告が得られず、能力はまだ限られているが、この調査はウイルス感染拡大のトレンドを示すことで流行を予測可能とすることを目指している。

Delphi COVID-19対策チームの共同責任者、Ryan Tibshirani(ライアン・ティブシラニ)氏「我々が算出したリアルタイムの推定は、新型コロナウイルス流行に関する入手可能な最も確実なデータと高い相関があった。これにより、流行が拡大する可能性が高い地域を数週間前に予測して医療関係者に提供できるようになると確信している」と声明で述べている。

CMU Delphiの調査にオプトインしたFacebookメンバーは咳、発熱、息切れ、または嗅覚の喪失が発生しているかどうかを回答する。これら新型コロナウイルス感染の初期症状であり、治療が必要な重症化の前に現れる可能性が高いため医療関係者にとって重要だ。

CMUが月曜に発表した最初のレポートによれば、 Facebookで収集された新型コロナウイルス感染に関するデータは公衆衛生機関からの確認ずみデータと高い相関があったという。研究チームはCOVIDcastと呼ばれるツールを発表した。これは、新型コロナウイルス関連データを地域別に集約する。 Googleもこの調査に協力を始めているので今週後半にはCOVIDcastはFacebookとGoogle双方のアンケートの結果を統合できる。現在までにFacebookで毎週100万件、Googleのインセンティブ付きアンケートアプリ、GoogleアンケートモニターとAdMobアプリを通じて毎週60万件の近くの回答が得られている。

Washington Postの意見コラムでFacebookのファウンダーであるMark Zuckerberg(マーク・ザッカーバーグ)はこう書いている。

「全米で郡ごとに正確なデータを取得することは難しい事業だ。そうした厳密なデータを全世界から取得するとなると困難さははるかに大きくなる。しかしFacebookは膨大な人たちに対してアンケートを行う上で極めてユニークな立場にある」。

プライバシーやセキュリティー上の問題で長らく批判されてきたソーシャルメディアは、新型コロナウイルスとの戦いを機に自らの重要性を再認識させようと努力している。ことにネガティブな報道に苦しめられてきたFacebookは医療専門家からの新型コロナウイルス情報をプラットフォームに掲載するなどいち早く対応を開始した。しかしFacebookや他のソーシャルネットワークは、新型コロナウイルスの場合でもデマ、火事場泥棒、陰謀論に悩まされ続けており、こうしたノイズを運営者が一掃するのは簡単ではないようだ。

【略】

画像クレジット:Angela Weiss / AFP / Getty Images

[原文へ]

(翻訳:滑川海彦@Facebook)