いまは一部の企業が自分たちが思ってもみなかったほどの規模にまで大きくなることを求められる時代だ。ときには、その利用の増加は突如としてやってくる。常時必要なキャパシティではないから、定額の料金としては払いたくない。Confluent(コンフルレント)は米国時間5月6日、同社のApache Kafka(アパッチ・カフカ)クラウドサービスに、オンデマンドのスケーリング機能を新たに加えた。必要に応じて自動的にスケールアップ・ダウンを可能にする機能だ。

ConfluentのCEOを務めるJay Kreps(ジェイ・クレプス)氏によると、この伸縮性は議論の余地なくクラウドコンピューティングの最も重要な機能であり、このスケールアップ・ダウンが調整可能な機能は企業がクラウドに引かれる主な要因の1とつだ。リソースの伸縮の自動化は、DevOpsから彼らの大きな悩みの種を1つ取り除く。

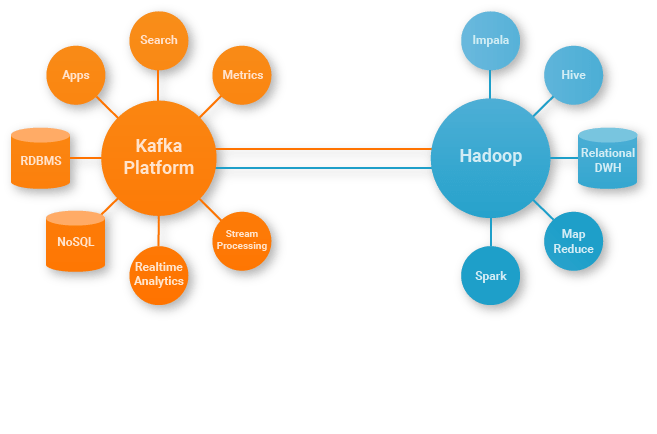

クレプス氏は「この新たな機能でユーザーは、KafkaおよびKSQLやKafka Connectのような、エコシステムの主要な部位を動的にスケールできる。重要な機能でありながら、アプリケーションレベルのサービスでこれをやってるところは、まだほとんどない」と語る。

同氏によるとこの機能は、人々が在宅で仕事をするようになった今、特にに重要だそうだ。システムの負荷はこれまでになく重いため、この自動的な伸縮性がとても役に立つ。そして費用効果と効率を従来になく高める。

「顧客は必要に応じてキャパシティを増やせるし、スケールダウンして経費を節約できる。いずれも、事前の計画はいらない」と同氏。

この新たなスケーリング伸縮機能はConfluentのプラットホームの一連のアップデートの一環だ。それらのアップデートはProject Metamorphosisと総称されており、年内を通して定期的に展開される。

「今年中に展開する一連のリリースで、Confluent CloudのKafkaエコシステムにモダンなクラウドデータシステムの能力を導入する。各月に1つずつ大きな機能を発表するつもりだが、その第一弾が伸縮性だ」とクレプス氏は述べる。

同社は先月、45億ドル(約4782億円)の評価額で2億5000万ドル(約265億6850万円)という巨額の資金調達を発表したが、そのときにクレプス氏は初めてMetamorphosisを発表した。パンデミックで経済が低迷しているにも関わらずConfluentは、本日の発表が証明しているようにプロダクトの構築を継続していくつもりだ。

[原文へ]

(翻訳:iwatani、a.k.a. hiwa)