アーリーステージの企業は、組織全体で扱うデータ量に悩まされることが多い。データが増えてくると、特にそうだ。データソフトウェア、データの混乱、データパイプラインの扱いに多額の費用がかかる。これらはすべてデータウェアハウス、クリーニングツール、視覚化プラットフォームに関わる。

Countは、オールインワンのデータプラットフォームを作ってこの問題を解決しようとしているスタートアップで、アーリーステージのチームに安価なデータパイプライン構築のためのツールを提供している。

Countはこれまでのステルスモードを終了し、240万ドル(約2億5800万円)の資金調達を発表した。この資金調達はLocalGlobeが主導し、Global Founders Capitalが参加した。同社のエンジェル投資家には、Micrrosoft(マイクロソフト)の企業戦略責任者だったCharlie Songhurst(チャーリー・ソンハースト)氏がいる。

Countは2016年に、経営コンサルタントだったOliver Hughes(オリバー・ヒューズ)氏とインペリアルカレッジの物理学者のOliver Pike(オリバー・パイク)氏が創業した。2人は、標準的なデータソフトウェアの複雑さと、業界で容認されている技術や設計上の制限のため、企業はデータドリブンの決定を下すことができないと分析していた。

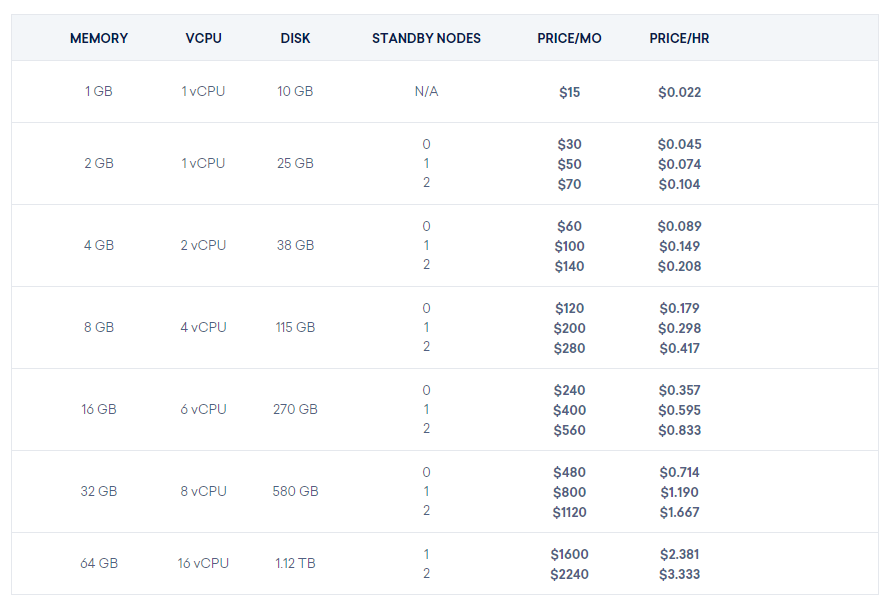

発表の中でヒューズ氏は、同社が解決しようとしている問題について次のように述べている。「大きく成長しているチームは、データを管理するために複数の別々のソリューションに対して多額の投資が必要だった。そのようなソリューションを購入して実装するには1年から1年半かかる。そのため多くのスタートアップは、ツールが自分たちに合わなくなっても長期の契約に縛られる。Countはシンプルな従量課金制モデルなので、プラットフォームを無料で使い始め、チームの成長とデータの増加に伴ってその分だけ支払えばよい」。

LocalGlobeのパートナー、Remus Brett(レマス・ブレット)氏は次のように述べている。「データが極めて重要であることは多くの人が認識しているが、データを扱い、ストーリーを語るのはいまだに難しい。現在では、重要な決定をするためにデータを迅速に処理し分析することの価値は、かつてないほど大きい。Countを利用すれば、ごく初期の企業であってもデータ分析に基づいた意思決定を始められる」。

Countを利用しているTiney.coのCTO、Edd Read(エド・リード)氏は「Countによって我々はデータをすべてまとめてチーム全体の報告書を作れるようになった。同社の製品であるNotebooksを使えば、状況に応じた考察を共有し、SQLを学ばなくてもデータのクエリを利用できる」と述べている。

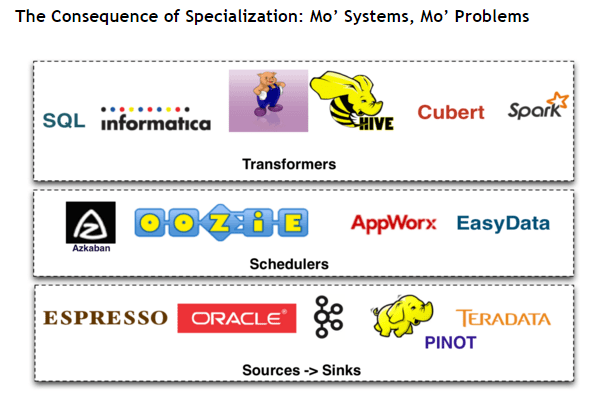

Countには、データウェアハウスではSnowflake、データクリーニングツールではDBT、分析プラットフォームではLookerなど、多くの競合がある。

[原文へ]

(翻訳:Kaori Koyama)