ディープラーニング技術を活用する企業に向けソリューションを提供するLeapMindは10月15日、エッジAIの社会実装に向けた「Efficiera(エフィシエラ) FPGAパートナープログラム」の提供を開始したと発表した。

パートナー企業とともに、顧客課題を解決できるAI搭載製品、ソリューションの開発を共創し、エッジAI領域の市場拡大と機械学習の社会実装の実現を加速する。第1弾の認定パートナーとしては、マクニカ アルティマ カンパニー、PALTEK、ジーニックが参画している。

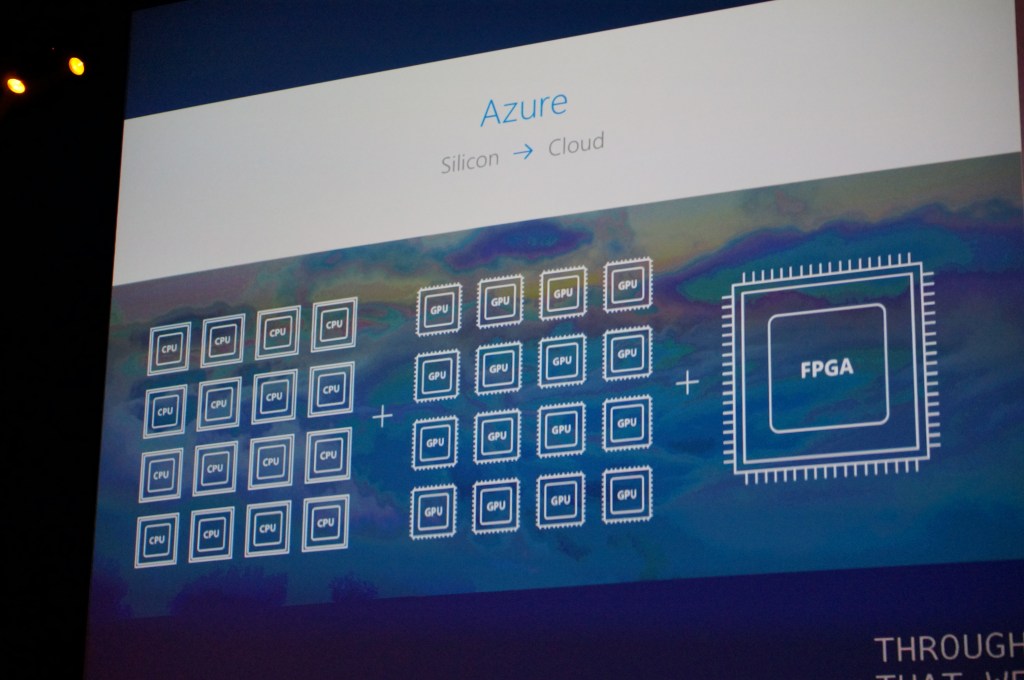

LeapMind開発の「Efficiera」とは、FPGAデバイス上もしくはASICデバイス上の回路として動作する、CNNの推論演算処理に特化した超低消費電力AI推論アクセラレーターIP(今秋正式リリース予定)。量子化ビット数を1~2bitまで最小化する「極小量子化」技術によって、推論処理の大部分を占めるコンボリューションの電力効率と面積効率を最大化する。このため、最先端の半導体製造プロセスや特別なセルライブラリーを使用する必要がないという。

極小量子化技術では、推論モデルを構成するパラメータを、通常用いられる単精度浮動小数点数(32bit)から1bitまたは2bitに置き換えることで、軽量化を達成。一般には、性能の劣化を起こさない限界は8bitまでとされているが、LeapMindは、8bitを大きく下回る1bitのWeight(重み係数)、2bitのActivation(入力)という組み合せでも性能をほとんど劣化させないことに成功した。

また、モジュールやデバイスではなく回路情報をライセンス提供するため、他の回路と同一デバイス上にEfficieraを集積でき、ディープラーニング機能を搭載した量産製品のBoMコスト削減に貢献できるという。同製品を利用することで、家電製品などの民生機器、建設機械などの産業機器、監視カメラ、放送機器をはじめ、従来は技術的に困難であった電力とコスト、放熱に制約のある小型機械やロボットなど、様々なエッジデバイスへディープラーニング機能を組み込めるとしている。

Efficiera FPGAパートナープログラムは、「顧客課題を解決可能なAI搭載製品・ソリューションの共創」を目的とするプログラムとなっている。

同プログラムに参画することで、自社製品・サービスとEfficieraを組み合わせて顧客の要望に応じたサービスやシステムの開発・提供や、Efficieraに付加価値をつけたパッケージサービスの開発が可能としている。

LeapMindは、「機械学習を使った新たなデバイスを、あまねく世に広める」を企業理念に2012年創業したスタートアップ企業。累計調達額は49.9億円に達しているという。ディープラーニングをコンパクト化する極小量子化技術に強みを持ち、自動車産業など製造業中心に150社を超える実績を保有。ソフトウェアとハードウェア両面の開発ノウハウを元に、半導体IPEfficieraを開発している。

関連記事

・Google for Startups Acceleratorが国内でスタート、空やRevcommが選出

・LinkedInが「TOP STARTUPS」ランキング日本版を初公開、どのようなスタートアップが優秀な人材を惹きつけているか?

・エッジ処理向けの深層学習モデルを開発、LeapMindがIntel Capitalなどから11.5億円調達