GoogleとMesosphereが今日(米国時間8/18)、両社のパートナーシップにより、GoogleのCompute EngineプラットホームにMesosクラスタのサポートを導入する、と発表した。MesosプロジェクトとMesosphereはまだよく見かける名前ではないが、アプリケーションのスケーリング(ニーズに応じての規模拡大)で余計な苦労をしたくないと考える企業にとって、このところ急速に、重要なツールになりつつある。それらのアプリケーションの所在は、完全に自社のみのデータセンターの場合もあれば、パブリックなクラウドサービスの場合、あるいはパブリック/プライベートのハイブリッドの場合など、さまざまである。〔*: Mesosphere関連日本語訳記事(1)、(2)。Mesosの’os’はOS(オペレーティングシステム)の意味…クラスタ群を一台のコンピュータへと抽象化する。〕

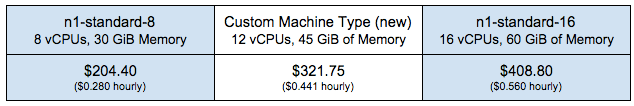

今度の提携によりGoogleのCloud Platformのユーザは、MesosphereのクラスタをGoogleのサーバ上に10分足らずでセットアップできるようになる。その基本的なインストールには二つの形があり、デベロッパはそのどちらかを選ぶ: 1)4インスタンスの開発用クラスタでアプリケーションのプロトタイピング用に8つの仮想CPUと30GBのメモリを提供、2)プロダクション用インストールで18インスタンス36仮想CPUメモリ136GB。この二つのオプションで不満な場合は独自のカスタムクラスタを作れる。

これらのクラスタにはデフォルトでMesosカーネル、Zookeeper、Marathon、およびOpenVPNが含まれる。クラスタの使用を開始するとMesosphereは、クラスタを管理するためのWeb上のわかりやすいダッシュボードを管理者に提供し、それにはGoogleのダッシュボードからアクセスできる。

MesosphereのCEO Florian Leibertによると、Mesosphereの中心的なねらいは、デベロッパがデータセンターをつねに一台のコンピュータのように扱えることだ。そのためにMesosなどのソフトウェアパッケージがDevOpsの主な仕事のほとんどを抽象化する。Leibertは以前TwitterやAirbnbの社員で今やそのTwitterもAirbnbもMesosのユーザだが、両社にオープンソースプロジェクトMesosを紹介したのはLeibert自身だ。

ユーザのハードウェアは実際には複数のハードウェアや仮想マシンやクラウドのインスタンスなどから成るが、Mesosphereという一枚の層がその上にかぶさるとアプリケーションは、多くのCPUやメモリをかかえた単一のリソースプールを使っている、という外見になる。デフォルトではMesosphereのサービスは、ユーザが使っているオペレーティングシステムやクラウドが何であるかを、まったく関知しない(どうでもよい)。ただし今回のGoogleとの提携にあたっては、Googleのクラウドに対しての最適化を図った。Mesosphereの詳細なドキュメンテーションは、ここにある。

Googleとのパートナーシップの中には、Dockerのコンテナを管理するGoogleのオープンソースのサービスKubernetesをMesopshereに統合することも含まれる。同社によるとこれによって、Dockerのワークロードの展開管理がより容易になる。ただしMesopshereのKubernetes統合は、対象がGoogleのCloud Platformに限定されない。Leibertは今日の発表声明の中で、“われわれが織り上げたコンピューティングの織物は、GoogleのCloud Platformだけでなく、そのほか、ユーザ自身のデータセンターやそのほかのクラウドプロバイダでも使用できる”、と言っている。〔Kubernetes関連日本語訳記事(1)、(2)。〕

GoogleでKubernetesなどの次世代クラウドコンピューティングプロダクトを担当しているリードプロダクトマネージャCraig McLuckieによると、GoogleがKubernetesでやりたいことは、Googleが自社のデータセンターを管理するために開発してきた重要なコンセプトの多くを、同社の外部でも利用できるようにすることだ。彼は今回のMesosphereとGoogleの協働関係を、“きわめて相補的である”*と呼び、それら重要コンセプトの一部はMesosにも持ち込まれるだろう、と考えている。〔*: complementary, お互いの足りないところに互いにピッタリとはまり込んで補う、完璧な結婚。〕

MesosphereのシニアVP Matt Trifiro(元HerokuのCMO)によると、KubernetesやMesosのようなプロジェクトは、これらの技術の背後にある非常に高尚な思想を、万人が共有するものにする。現状では、“Webをスケールしなければならないというニーズを抱える企業にとって、ツールが十分にアクセス可能でなかった”。しかし今では、GoogleやMesosの高度なコンセプトとツールを企業も利用できるようになり、デベロッパやDevOps たちは一段高い抽象性のレベルで仕事ができるようになり、アプリケーションを動かしているインフラの具体的な細部を、直接いじらなくてもよくなっている。

Leibertは今日、こう書いている: “Googleと協働することによってGoogleのCloud Platformを、従来からのMesosphereのワークロード、たとえばMarathon、Chronos、Hadoop、Spark、そして新たにKubernetesなどを使用するための最良の場所にしていきたい”。

この協働プロジェクトでは両社の関係がきわめて密だから、いずれGoogleがMesosphereを買収することもありえるかもしれない。現状ではそれは、あくまでも憶測だが、でも実際にそうなったら、その起源がこれだったことを、思い出そう。

[原文へ]

(翻訳:iwatani(a.k.a. hiwa))