マウンテンビューで開催されたGoogle I/Oデベロッパー・カンファレンスでGoogle Pay(以前のAndroid PayとWalletが統合)の大幅アップデートが発表された。今回Googleがオンライン支払プラットフォームに追加した新しい支払機能にはAPIの利用、P2P送金、チケット購入、ボーディングパス発行などが含まれる。

ブラウザやデバイスのサポートの追加が予定されていることはすでに発表されていたが、アップデートの詳細が明らかになったのは今回の I/Oが最初だ。新機能はGoogle Payプラットフォームに順次公開される。

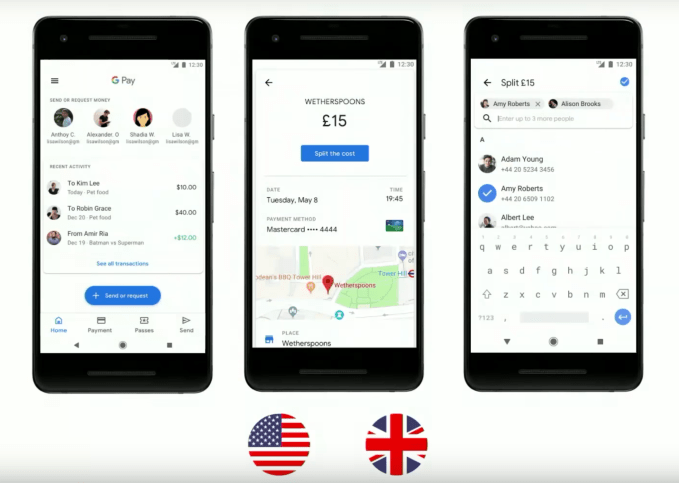

特に目立った新機能の一つはGoogle PayアプリでP2P送金が可能になったことだろう。この機能は当面アメリカとイギリスでリリースされる。

また支払履歴はあちこち探し回る必要なしに、アプリ内から一箇所で確認できるようになった。

Google Payのプロダクト責任者、Gerardo CapielはI/Oのデモセッションで次のように述べた。

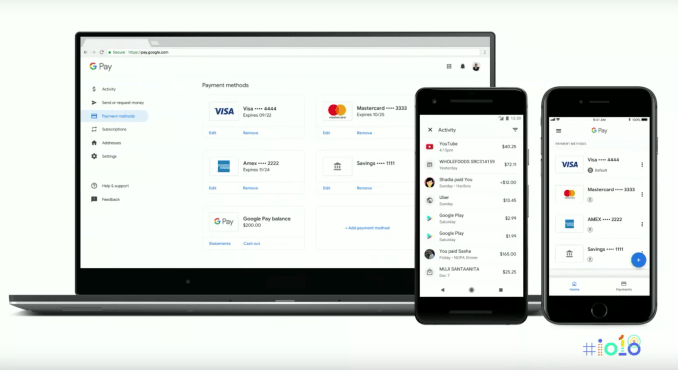

今回アップデートされる新しいGoogle Payでは、Googleを経由するすべての支払が単一のアカウントで処理できるようになる。対応店舗での支払時だけでなく、Playストア、YouTube、サードパーティーの通販会社、Uber、友だちへのP2P送金などすべての支払について全体像が一覧できる。

ユーザーは送金、送金の要請などGoogleアカウントに関連する支払関連の履歴をGoogle PayのiOSアプリでも表示し、確認できる。

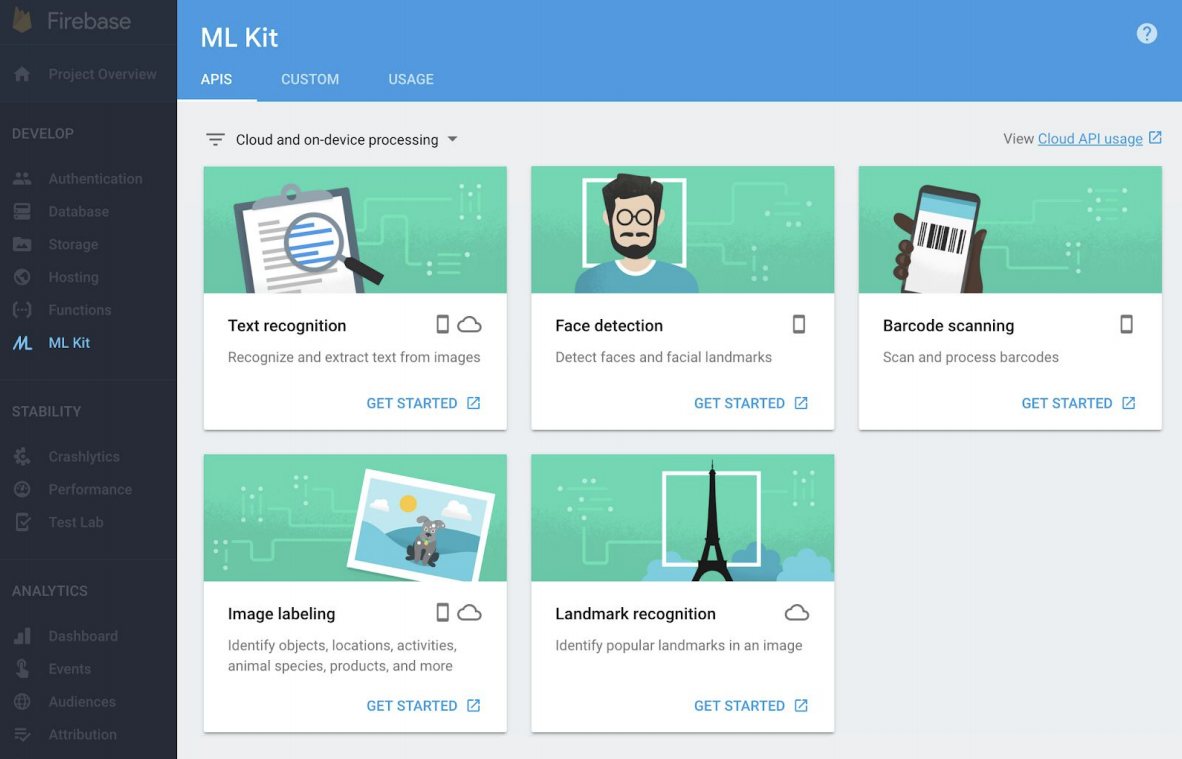

I/Oはデベロッパー・カンファレンスなので、こうした新しい機能はデベロッパーが利用できる新しいAPIという形で紹介された。

デベロッパー向けの努力の第一歩としてGoogle Payをサードパーティーのアプリに組み込むための新しいAPIがリリースされた。

「われわれのAPIセットを使えば、サードパーティーのマーチャントはアプリであれウェブサイトであれ(支払情報がGoogle Payに登録ずみの)準備済みユーザーに関しては簡単に支払を処理できる」とCapielは述べた。

Capielによれば、デベロッパーはGoogle Payをサポートすることによって処理の迅速化とコンバージョン率のアップを図ることができるという。

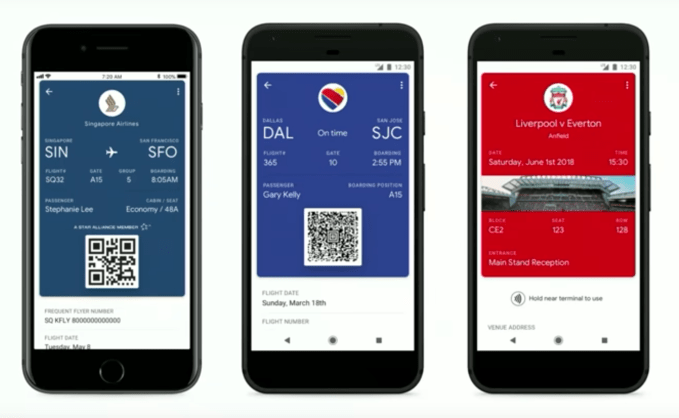

これに加えて楽曲や飛行機のチケットの購入、ボーディングパス発行も、関連する情報をGoogle Pay APIに渡すことで処理できる。この場合、会員カードへのポイント、マイレージの加算

も従来どおりサポートされるという。

これによりiOSアプリ開発のUrban Airshipや送金プラットフォームのDotDashPayなどは顧客企業に提供しているアプリにGoogle Payを利用してチケットや契約をアップグレードする機能を容易に追加できる。

DotDashPayのファウンダー、CEOのSean Ariettaはプレゼンの後でTechCrunchの取材に対して「Google Payがデジタルウォレット機能の強化にこれまで以上に取り組んでいるのは心強い。今回のGoogle PayのアップグレードでわれわれDotDashPayのようなパートナーが提供しているブランドと消費者を結びつける機能がさらにアップグレードされた。支払からNFCによるタップ認証までまでの一連の流れをすべてこなすところがデモされたが、非常に強力だった。Google Payはほぼ完璧な仕上がりになった」と述べた。

Urban Airshipも今週、プレスリリースでアップグレードを発表している。【略】

Google Payがチケット購入をサポートするにあたってのアーリー・パートナー、 Singapore Airlines、Eventbrite、Southwest、FortressGBなどが含まれる。FortressGBはイギリスを始めとする各国でプロサッカーリーグのチケットを扱っている企業だ。

近くGoogle Payを採用する予定の公共交通関係のパートナーにはカナダのバンクーバー、イギリスのバス会社や近くスタート予定のラスベガス、ポートランドの交通機関が含まれる。

今回Google Payの普及度について新しい数字が発表された。それによるGoogle Playストアでのダウンロードは世界18カ国の提供地域で1億回以上となっている。

今回発表されたGoogle Payアプリの新機能の多くは世界で数十億といわれるGoogleユーザー向けに近々公開される。

[原文へ]

(翻訳:滑川海彦@Facebook Google+)