先週末に行われたGoogle I/Oカンファレンスの2時間にわたる基調講演で、Googleは、新しいスマートフォンから次世代型の音声アシスタントなど、この1年間で開発してきたものを大量に発表した。

すべてを見ている暇はない? 大丈夫。そんな人のために駆け足で紹介しよう。

Google Pixel 3aと3a XL

噂のとおり、GoogleはPixel 3の廉価版を発売する。

価格を下げるために、プロセッサーのランクをちょっとだけ下げ(Snapdragon 845をSnapdragon 670に)、ストレージを64GBに制限し、無線充電機能をなくした。その代わりに、空いたスペースに3.5ミリのヘッドフォンジャックが付くという嬉しいオマケがある。

Pixel 3aは399ドル(約4万4000円)より。5.6インチディスプレイ、12.2メガピクセルのリアカメラ、そして、最初からAndroid Pが走る。Pixel 3a XLは479ドル(約5万2800円)から。こちらは画面が6.0インチになる。

TechCrunchのBrian Heaterが、今週初めにこのスマートフォンを試用している。彼のレビュー記事はこちら。

Nest HubとNest Hub Max

Google Home Hubは、Nest Hubと名前を変えて、価格も149ドル(約1万6400円)から129ドル(約1万4000円)に下げられた。

同時に兄貴分も登場した。Nest Hubの画面を7インチから10インチに拡大してカメラを追加した、その名もNest Hub Maxだ。Nest Hub MaxはNestアプリに接続できるため、Nestの他のカメラと同じように使える。Googleによると、背面のスイッチでカメラとマイクをオフにできるという(残念ながらカメラかマイクのどちらかを生かすというのはダメみたい)。価格は229ドル(約2万5000円)。今年の夏に出荷予定だ。

Nest Hub Maxに搭載された新しいFace Match機能は、顔認証ができ、その反応をカスタマイズできる。この機能に関するGoogleのブログ記事には「Face Matchの顔認証は、デバイスに内蔵された機械学習機能によりローカルで処理されるため、カメラのデータは一切外に出ません」とのことだ。

検索に拡張現実

一部の検索結果、たとえばあるモデルの靴や「大きなホワイトシャーク」などでは3Dモデルが見られるようになる。モデルをタップすれば、AR(拡張現実)を使って現実の映像の上にそれを重ねて見ることができる。

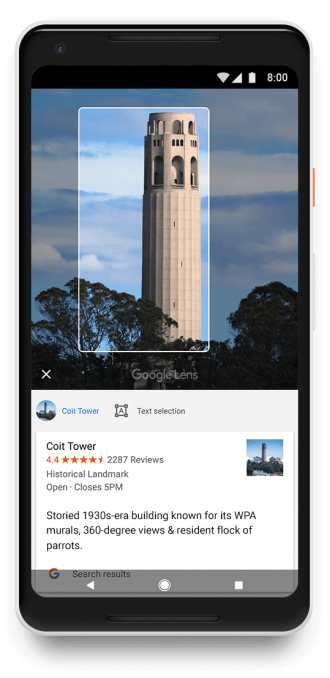

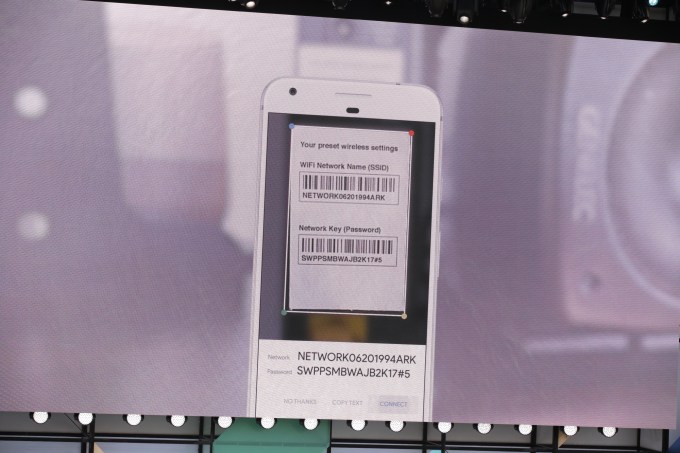

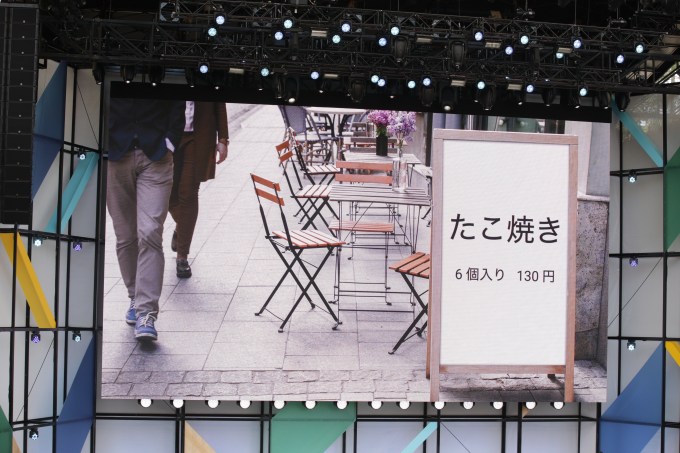

Google Lensのアップグレード

Google Lensにも、いくつか新しい機能が増える。レストランのメニューにGoogle Lensを向けると、人気の料理がハイライトされる。レシートに向ければ、チップや合計金額を自動的に計算してくれる。

ウェブ上でDuplex

昨年のI/Oで、GoogleはDuplexを発表した。スモールビジネス(レストランや美容院など)向けのAIを使った顧客サービスツールで、大量の電話に対応したり、よくある質問に応答したり、予約を管理したりできる。

今年はこれを拡大して、ウェブ上で公開する。例として示されたのが、インターネットによるレンタカーの予約だ。「(レンタカー会社)のレンタカーが欲しい」と言うと、そのレンタカー会社のウェブサイトが開かれ、自動的に予約が行われる。そこには、カレンダーに書き込んだ出張の日程がすでに入力されていて、Gmailに残っている前回のレンタカー予約確認のメールをもとに、好きな車種が選択されていた。

Googleの「次世代」アシスタント

Googleは、音声認識モデルのサイズを数百ギガバイトから500メガバイトほどに圧縮することができた。スマートフォンに搭載できる十分に小さいサイズだ。

音声認識モデルをローカルで持つことで、クラウドとのPingのやりとりによる遅延がなくなる。アシスタントとの会話も、ほぼ瞬間的に行えるようになる。デバイス上で走っているため、機内モードでも使える。Googleは、矢継ぎ早に命令(「Lyftを呼んで」や「懐中電灯を点けて」など)を連発してその様子を披露していたが、しっかりと応答していた。

Googleによれば、この次世代の音声アシスタントは、今年の後半に新型Pixelに搭載されるという。

GoogleアシスタントがWazeに

GoogleアシスタントがWazeに組み込まれ、「ほんの数週間以内」に使用可能となり、事故や道の陥没の通報などが声で行えるようになる。

Googleアシスタントのドライビングモード

「ヘイ、Google、ドライブしよう」と言えば、アシスタントはドライビングモードに切り替わる。画面には、チラッと見てわかるように、目的地の方向や音楽の操作系など、運転中に必要最低限の情報だけが表示される。

Googleマップのシークレットモード

ブラウザーのシークレットモードと同様に、Googleマップに追加されるシークレットモードでは、場所の検索結果や経路がGoogleアカウントの履歴に残らないようになる。

ライブ字幕とライブ筆記

Androidには、間もなく、スマートフォンで再生したメディアにその場で字幕を入れる機能が追加される。保存したポッドキャストや録画した動画にも字幕が付けられる。

Live Relay(ライブ中継)とGoogleが名付けた機能を使えば、電話での会話をリアルタイムで筆記させたり、文字で応答したりできるようになる。

下の動画は、Live Relayで実際に会話している様子だ。

https://platform.twitter.com/widgets.js

声に出したり耳で聞いたりしなくても電話ができるように、Live Relayは、デバイスに内蔵された音声認識と文章音声変換を使って、電話の音声のやりとりを代行します。

Project Euphonia

Googleは、そのAI音声アルゴリズムを使って、ALSや脳卒中の後遺症などのためにうまく話ができない人を支援する研究を続けてきた。それぞれの人の話し方にモデルを調整することで、コミュニケーション能力を向上させることができる。

https://platform.twitter.com/widgets.js

非営利団体とボランティアの協力のもとで行われているProject Euphoniaは、音声による会話に障害がある人たちのコミュニケーションを迅速化し自立を支援する活動です。

ダークなテーマ

Android Qにダークモードが追加される。手動で切り替えることもできるが、省電力モードになったときに自動的に切り替わるようにもできる。

集中モード

仕事が忙しい? それならFocus Mode(集中モード)だ。仕事の邪魔になるアプリの一覧を作って、スイッチを切り替えれば、集中モードをオフにするまで、それらのアプリは表示されなくなる。今年の秋にAndroidに搭載される。

PixelのGoogleマップにARモードが登場

数カ月前、GoogleはGoogleマップで使える新しいAR(拡張現実)モードを披露した。その目的は? 確実に正しい方向に歩行を開始できるようにするためだ。スマートフォンを目の位置に掲げると、画面に目の前の光景が映し出される。Googleマップはその映像とストリートビューのデータとを照合して、現在位置と方向を正確に割り出す。GPSだけを使った場合よりも確かだ。そして、正しい方向に矢印を表示する。

しばらくベータ版だったが、今日からPixelに搭載される。

消費者向けの基調講演の後、Googleはこれとは別に、開発者向けの基調講演を行った。内容は次のとおりだ。

- Android開発の主要プログラミング言語はKotlinになったとGoogleは話した。

- Kotlinでの開発用の新しいUIツールキットJetpack Composeを発表。

- 今回発表されたNest Hub Maxなど、Googleのスマートディスプレイ・デバイス用のゲーム開発が可能になった。

- 速度と安定性を向上させたGoogleのAndroid Studio IDEの新バージョンを発表。

- Androidの開発者は、作動を続ける前にアプリの更新をユーザーに要請できるようになった。去年発表されていた機能だが、やっと実現した。

[原文へ]

(翻訳:金井哲夫)