昨日(米国時間2/28)、Amazonのバージニア州北部データセンターに障害が発生し、 AWS S3クラウド・ストレージ・サービスが4時間近くダウンしたというニュースはご存知のことと思う。その結果、有名なウェブサイトやサービスが停止し、大きな混乱が起きた。

念のため断っておけば、今朝、Amazonのダッシュボードはすべて正常に動作中であることを示している。

影響を被ったサイトやサービスにとっては大事件だったものの、Amazon S3は長年にわたって信頼性が高いサービスだったことは指摘しておくべきだろう。またバージニア州北部データセンターがダウンしても他の13のリージョンではS3は正常に作動した。

今回のS3のダウンのようなクラウド・サービスのダウンをモニターしているCloudHarmonyによれば、S3の動作記録はサービスレベル合意書((SLA)が保証する基準を上回っていたということだ。SLAによればS3は99.9%の稼働を約束しており、下回った場合については返金に応じるとしている。CloudHarmonyの調査では、同社が2014年にクラウド・サービスのモニターを開始して以來、AWS S3は年間でほぼ100%の稼働率を達成している。S3の目立った障害は2015年8月のダウンだった。

CloudHarmonyはMicrosoft Azureの仮想マシンとオブジェクト保管も2月19日に5時間にわたってダウンしたが昨日のS3の場合のような注目は集めていないと指摘する。

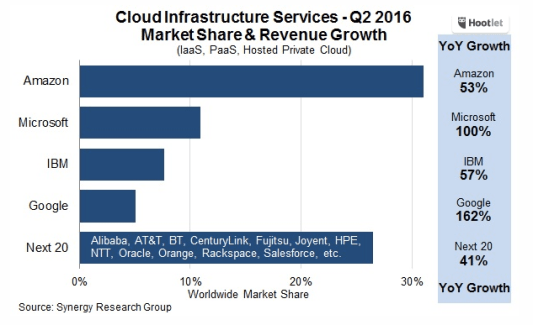

クラウド・コンピューティングの専門家、ジャーナリストのBen Kepesは「シアトルのAWS本社では夕べは誰も眠れなかっただろう。しかしこの種のダウンはときおりどうしても起きてしまう」と述べた。Kepesによれば、「AWSは他の同種のサービスと比較して隔絶して大きいパブリック・クラウド・サービスだ。そのためダウンすると各方面に非常に大きな影響を与える。昨日のダウンはいかに多くのサードパーティーがAWSのインフラに依存していたかを印象づけた。残念ながら、こうしたサービスはときおりダウンすることがある。ユーザーはこうした場合に対処する方法を準備しておく必要がある」という。

Kepesは「どんな場所であろうとダウンが起きることはITのプロなら誰でも知っている」 と付け加えた。しかしクラウドは通常地味なサービスでありダウンしても関係者以外には注目を引かない。「世間では大騒ぎしているが、事実はどんな公共サービスであろうと落ちるときは落ちる」という。

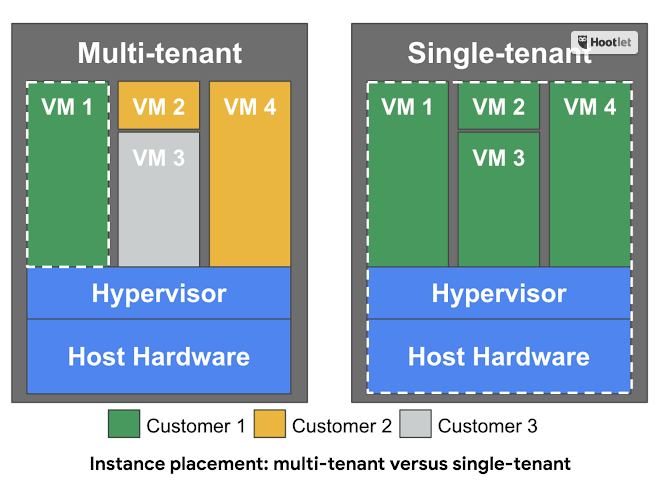

Forresterのアナリスト、Dave Bartolettiも同意見だ。彼は今回の事件はクラウド・サービスのユーザーに警鐘を鳴らすものだという。「ストレージに冗長性を持たせることが必要だ。ユーザーはクラウドにデータを保管してサイトやサービスを構築する場合、複数のレイヤーを利用する必要がある。ストレージはS3の特定のリージョンのみに依存してはならない」という。

ただしこれらのアナリストも今回のダウンで被害を受けたユーザーを非難しているわけではない。しかし冗長性というのはIT専門家がシステムに組み込むことを必須としてきた要素で、クラウドの場合でもなんら事情は変わらないという指摘だ。

しかしMoor Insight & Strategyのアナリスト、Patrick Moorheadは今回のダウンについてもっと厳しい意見を持っている。今回のダウンタイムはけっきょくのところ数百万ドルの損害をもたらしたはずで、Amazonは顧客の貴重なデータを保管するサービスを提供するからにはもっと高い冗長性をシステムに組み込んでいる必要があったという。

「パブリック・クラウドだからといってこうしたダウンが起きていい理由にはならない。銀行オンラインでダウンがほとんど起きないのは障害耐性が高いアーキテクチャを組み込んだシステムが構築されているからだ」という。

こうした批判の当否はともあれ、インハウスであろうとAWSのようなクラウドであろうとデータセンターの事故はサイトやサービスにとって死活問題だということは明らかになった。どんなアプローチであれ「これで絶対安全」とはならない。だからといってAWSの責任が否定されるわけではないが、少なくとも過去の運用記録からみればS3はきわめて信頼性の高いサービスの一つであったことは間違いない。

t画像: Drew Angerer/Getty Images

[原文へ]

(翻訳:滑川海彦@Facebook Google+)