「量子(quantum)」という言葉は、20世紀後半になって、他の一般的な形容詞では表せない、何かとても重要なものを識別するための表現手段となった。例えば、「Quantum Leap(量子の跳躍)」は劇的な進歩のことを意味する(Scott Bakula主演の’90年代初頭のテレビシリーズのタイトルでもあるが)。

もっとも、それは面白いとしても、不正確な定義だ。しかし、「量子」を「コンピューティング」について使うとき、我々がまさに劇的な進歩の時代に入ったことを表す。

量子コンピューティングは、原子と亜原子レベルで、エネルギーと物質の性質を説明する量子論の原理に基づいた技術だ。重ね合わせや量子もつれといった理解するのが難しい量子力学的な現象の存在によって成立する。

アーウィン・シュレディンガーの有名な1930年代の思考実験は、同時に死んでいて、かつ生きているという一匹の猫を題材にしたもので、それによって「重ね合わせ」というものの明らかな不条理を浮き彫りにすることを意図していた。重ね合わせとは、量子系は、観察、あるいは計測されるまで、同時に複数の異なる状態で存在できる、という原理だ。今日の量子コンピュータは、数十キュービット(量子ビット)を備えていて、まさにその原理を利用している。各キュービットは、計測されるまでは0と1の間の重ね合わせの中に存在している(つまり、0または1になる可能性がいずれもゼロではない)。キュービットの開発は、膨大な量のデータを処理し、以前には不可能だったレベルの計算効率を達成することを意味している。それこそが、量子コンピューティングに渇望されている潜在能力なのだ。

シュレディンガーはゾンビの猫について考えていたが、アルバート・アインシュタインは、彼が「離れた場所の奇妙な相互作用」と表現した、光速よりも速く通信しているように見える粒子を観察していた。彼が見ていたのは、もつれ合った電子の作用だった。量子もつれとは、同じ量子系に属する複数の粒子の状態は、互いに独立して描写することができない、という観測結果のことだ。かなり遠く離れていても、それらはやはり同じ系に属している。もし1つのパーティクルを計測すると、他のパーティクルの状態も直ちに判明するように見える。もつれ合った粒子の観測距離の現時点での最長記録は、1200キロメートル(745.6マイル)となっている。量子もつれは、量子システム全体が、その部分の合計よりも大きいことを意味する。

ここまでの話で、そうした現象がなんとなくしっくりこないというのであれば、シュレディンガーの言葉が、その居心地の悪さを和らげてくれるかもしれない。彼は量子理論を創出した後で「私はそれが好きではありませんが、申し訳ないことに私にはどうすることもできないのです」と言ったと伝えられている。

様々なグループが、それぞれ異なる方法で量子コンピューティングに取り組んでいる。従って、その仕組みについて1種類の説明で済ますのは現実的でないだろう。しかし、読者が従来のコンピューティングと量子コンピューティングの違いを把握するのに役立つかもしれない1つの原理がある。それは、従来のコンピュータは2進数を扱う、ということ。つまり、各ビットは0または1の2つのうちのどちらかの状態しか取れない、という事実の上に成り立っている。シュレディンガーの猫は、亜原子の粒子が同時に無数の状態を示すことができることを説明した。1つの球体を想像してみよう。その2進数的な状態は、北極では0、南極では1になると仮定する。キュービットの世界では、その球全体で無数の他の状態を保持することができる。そして、複数のキュービット間の状態を関連付けることで、ある種の相互関係が生まれる。それによって、量子コンピューティングは、従来のコンピューティングでは達成できない、さまざまな分野のタスクに適応することができるのだ。こうしたキュービットを生成し、量子コンピューティングのタスクを遂行するために十分な時間だけ存在させておくことが、現在の課題となっている。

IBM研究者で、同社のTJワトソン研究所の量子コンピューティング研究室に所属するJerry Chow

量子コンピューティングを文明化する

こうしたことは、量子力学の奇妙な世界の入り口に過ぎない。個人的には、私は量子コンピューティングに心を奪われている。技術的な奥義から人類に利益をもたらす潜在的なアプリケーションに至るまで、さまざまなレベルで私を魅了しているのだ。しかし、今のところ、量子コンピューティングの仕組みに関しては、うまく説明しようとすればするほど混乱を招くのが実情だ。そこで、より良い世界を作るために、それがどのように役立つのかを考えてみることにしよう。

量子コンピューティングの目的は、従来のコンピューティングの能力を補助し、拡張することにある。量子コンピュータは、ある種のタスクを、従来のコンピュータよりもはるかに効率的に実行する。それによって、特定の分野で我々に新しいツールを提供してくれる。量子コンピュータは、従来のコンピューターを置き換えるものではないのだ。実際、量子コンピュータが得意分野で能力を発揮するためには、たとえばシステムの最適化などについては、これまでのコンピュータの手助けを必要とする。

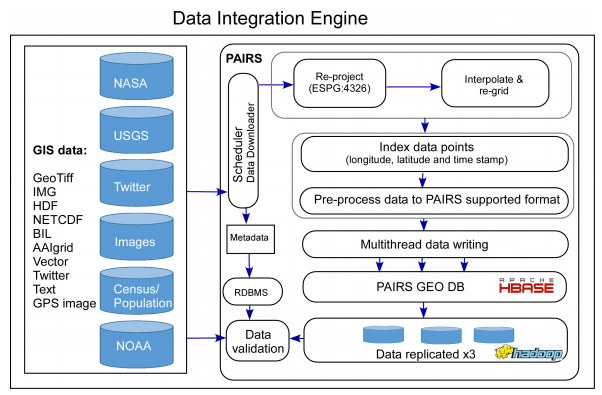

量子コンピュータは、エネルギー、金融、ヘルスケア、航空宇宙など、多くの異なった分野での課題の解決を促進するのに有効だ。その能力は、病気を治し、世界の金融市場を活性化し、交通をスムーズにし、気候変動に対処したりするための手助けとなる。たとえば、量子コンピューティングは、医薬品に関する発見と開発をスピードアップさせ、気候変動とその悪影響を追跡して説明するための大気モデルの精度を向上させるための潜在能力を備えている。

私をこれを、量子コンピューティングの「文明化」と呼ぶ。そのような強力な新技術は、人類に利益をもたらすために使うべきだからだ。そうでなければ、我々は船に乗り遅れてしまうだろう。

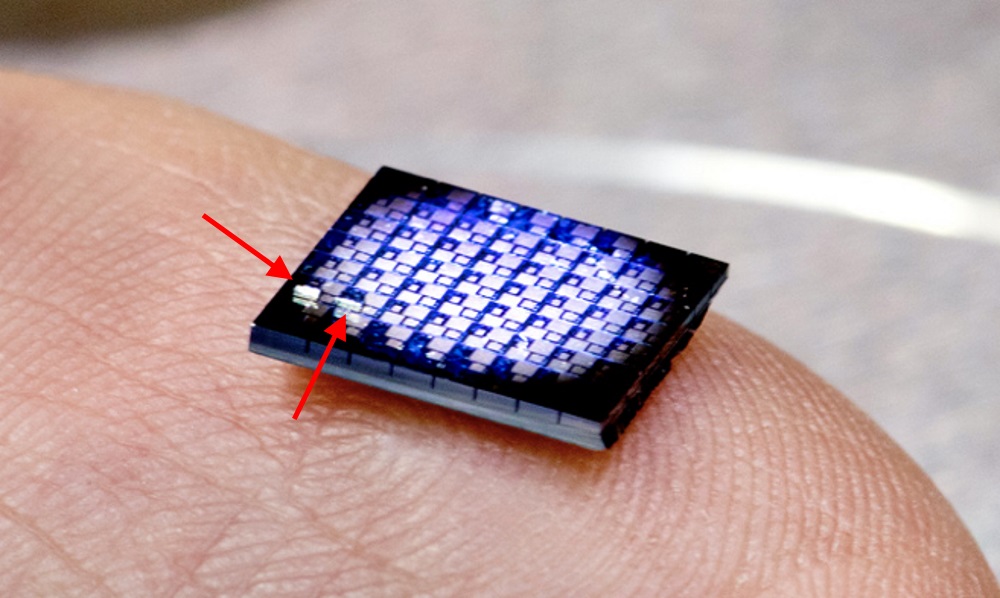

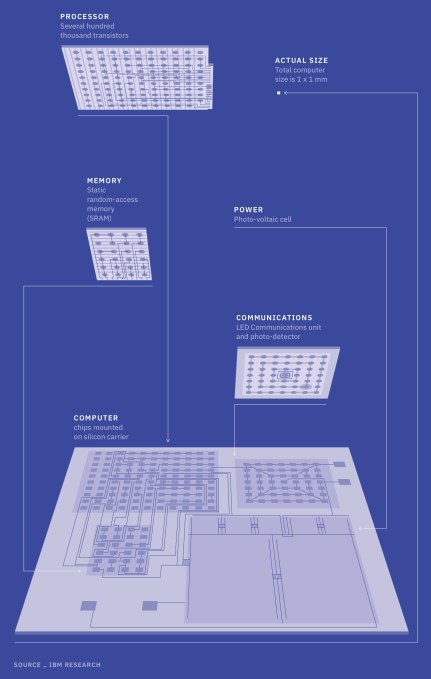

Intelの量子コンピューティング用17キュービットの超伝導テストチップは、接続性を向上させ、電気的および熱力学的な特性を向上させるためのユニークな特徴を備えている。(クレジット:Intel Corporation)

投資、特許、スタートアップなどの上昇傾向

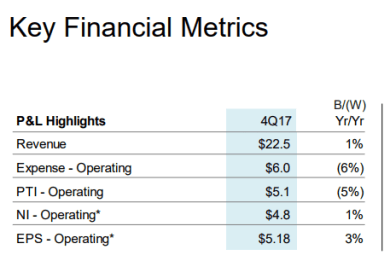

これは、私の内なるエヴァンジェリストの主張だ。しかし事実を見ても、投資と特許出願に関する最新の検証可能な世界規模の数字は、両分野における上昇傾向を反映している。そしてそのトレンドは今後も継続するものと思われる。エコノミスト誌によれば、2015年には、機密扱いされていない各国の量子コンピューティングへの投資の世界的な総計は、約17.5億ドルに達している。欧州連合が6億2300万ドルで全体をリードしている。国別では米国がトップで4億2100万ドル、中国がそれに続く2億5700万ドル、次がドイツの1億4000万ドル、英国の1億2300万ドル、カナダの1億1700万ドルの順だ。20の国が、少なくとも1000万ドルを量子コンピューティングの研究に投資している。

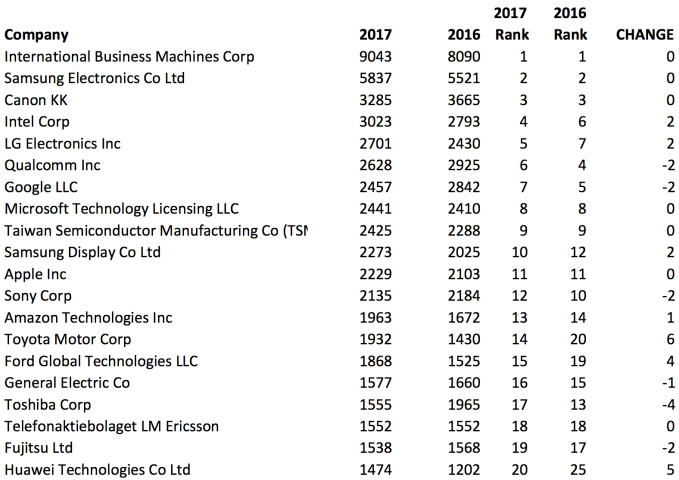

Thomson Innovation社が提供する特許検索機能によれば、同時期の量子コンピューティング関連の特許出願件数では、米国がトップで295件、次いでカナダが79件、日本が78件、英国が36件、中国が29件となっている。量子コンピューティングに関連する特許の件数は、2017年末までに430%増加すると予想された。

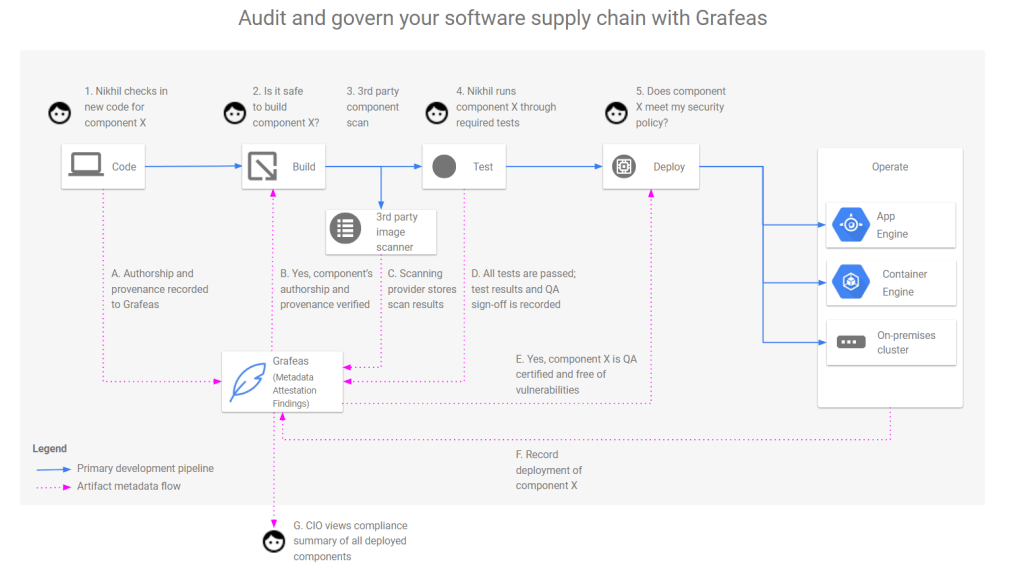

結局のところ、国、巨大テクノロジー企業、大学、スタートアップが、こぞって量子コンピューティングと、その潜在的な応用範囲を模索しているというわけだ。安全保障と競争上の理由で、量子コンピューティングを探求している国家、および共同体もある。量子コンピュータは現在使われている暗号化方式を破り、ブロックチェーンを殺し、他の暗黒面の目的にも有効だと言われてきた。

私はその独占的で凶暴なアプローチを否定する。オープンソースの協調的な研究開発のアプローチをとれば、量子コンピューティングには、より広範囲の善良な用途があることは明らかだ、と私には思える。この技術へのより広いアクセスが得られるようになれば、それも十分可能だろうと私は信じている。私は、クラウドソーシングによる量子コンピューティングの応用が、より大きな善のために勝利を得ることを確信している。

もし関わりを持ちたいのであれば、IBMやGoogleなどのように一般家庭にも浸透しているコンピューティングの巨人が用意している無料のツールを探してみるといい。また、大企業やスタートアップによるオープンソースの提供もある。量子コンピュータはすでに現在進行形のものであり、アクセスの機会は拡大の一途をたどっている。

独占的なソリューションは、オープンソース、協調的な研究開発、普遍的な量子コンピューティングの価値の提案に屈服するだろうという私の見立てに沿って、北米だけですでに数十社ものスタートアップが、政府や研究機関と並んで、量子コンピューティングのエコシステムに飛び込んだことを指摘させていただこう。たとえば、Rigetti Computing、D-Wave Systems、1Qbit Information Technologies、Quantum Circuits、QC Ware、Zapata Computingといった名前は、もう広く知られているかもしれないし、すでに大企業に買収されているかもしれない。このような発生期にはなんでもアリなのだ。

量子コンピューティング標準の策定

関わりを持つもう1つの方法は、量子コンピューティング関連の標準を策定する活動に参加することだ。技術的な標準は、結局は技術の開発を促進し、経済的なスケールメリットをもたらし、市場を成長させる。量子コンピュータのハードウェアとソフトウェアの開発は、共通の用語からも、結果を評価するための合意された測定基準からも、恩恵を受けるはずだ。

現在、IEEE Standards Association Quantum Computing Working Group(IEEE規格協会の量子コンピューティング作業部会)は2つの標準を策定中だ。1つは量子コンピューティングに関する定義と用語であり、それによってみんなが同じ言語で話すことができる。もう1つは、従来のコンピュータに対する量子コンピュータの性能を評価し、両者を比較するためのパフォーマンスの測定法とベンチマーキングに関するものとなっている。

さらに標準を追加する必要があれば、おいおい明らかになるはずだ。

画像のクレジット:VICTOR HABBICK VISIONS

[原文へ]

(翻訳:Fumihiko Shibata)