今年のI/Oのキーノート講演がGoogle史上最も派手だったと言う人はいないだろう。もしあなたが、飛行船から新型のGoogle Glassを持った人々が飛び出してくることを期待していたなら、間違いなく失望していただろう。代わりにGoogleは、比較的控え目なキーノートの中で、Androidをモノのインターネットに対応させる段階的なモバイルOSの改善や、デベロッパーの収益化、広告、アプリの分析などをやりやすくするための新しいツールの数々を発表した。

しかし、私を引きつけた3つの消費者向けGoogle新製品は、Google Photos、Android MのNow On Tap、そして ― キーノート講演にはなかったが ― Inbox for Gmailの最新アップデートだった。いずれも、自然言語、高度な機械学習、およびこの数年Googleが注力してきた知識グラフデータベースを一定レベルで活用している。

例えばGoogle Photosは、現時点で最高の写真検索エンジンと呼べるものを塔載している。単に “trees”、”flowers”、”mountains” 等を検索すれば、自分の写真集の中からそれを見つけてくる。Photosは、Google+の写真機能を独立させたスタンドアロン版で、大部分の機能を既に実現していたが、今回Googleは検索機能を改善した。

Google “Now on Tap” は、アプリの中で起きていることを理解して追加のコンテキスト情報を提供し、それに関するユーザーの質問に答える。Googleのデモは大きな賞賛を浴びた。実演者がSpotifyで(なぜかGoogle Musicではなく)スクリレックスの楽曲を流し、Now on Tapを立ち上げて「彼の本名は?」と尋ねる。Googleがこれに答えるためには、アプリで何が演奏されているかを理解し、「彼」が誰を指しているかを理解した上で知識ベースを深く堀り下げなければならない。

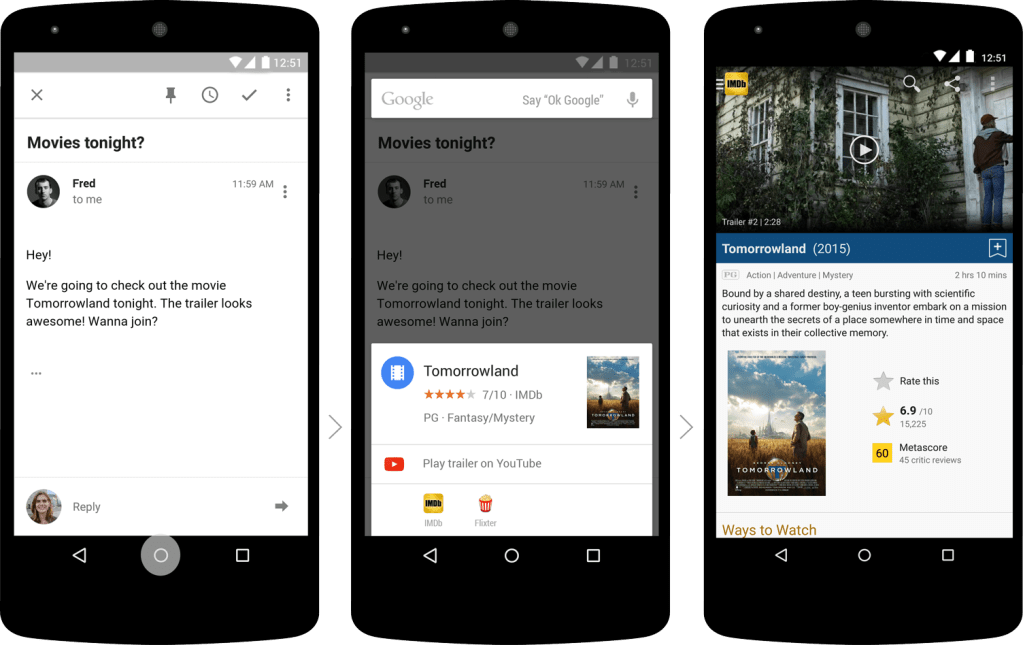

Inboxは、なぜかキーノートでは触れられなかったが、今やこの知識と自然言語を理解することによって、誰かがあなたに何かをして欲しいことに気付くと、自動的にリマインダーを生成する。さらに、今後の旅行に関する複数のメールを認識して、一つのグループにまとめることもできる。

Microsoftは、Cortanaでこの一部をやり始めており、Appleも似たようなツールを考えているに違いないが、Google製品が他を一歩リードしていると感じた。つまるところ、10億以上の項目に関するデータの知識グラフを利用できる会社は他にいない。そして良くも悪くも、Google以上にあなたやあなたのオンライン習慣(おそらくオフラインも)を知り、そのすべての情報にコンテキストを与えられる人はいない。

Google I/Oのキーノートは、いわゆるサプライズには欠けていたが(ただし翌日のATAPキーノートは補って余りあった)、上記3つの機能だけでも、ことユーザーを理解することに関してGoogleがライバルを大きく引き離していることを示している。

[原文へ]

(翻訳:Nob Takahashi / facebook)