D-Wave Systemsは米国時間12月10日、NECとのパートナーシップを発表した。NECのハイパフォーマンスコンピューター(HPC)とD-Waveの量子システムを組み合わせて「ハイブリッドアプリケーションとサービス」の開発を目的としている。

また、両社はNECがD-Waveへ1000万ドル(約10億900万円)を投資することも発表した。Crunchbaseのデータによると、D-Waveがこれまで獲得した資金調達総額は2億400万ドル(約222億)だ。

今週、1月1日付けで同社のCEOに就任すると発表されたD-Waveのプロダクト最高責任者でR&D担当執行副社長Alan Baratz(アラン・バラツ)氏によると、同社はすでに日本で多くのビジネスを行っており、今回の大きな契約によってその技術をさらに広めることができるという。声明中で彼は、「世界的にもパイオニアであるNECとのコラボレーションは、商用の量子アプリケーション研究における大きな節目だ」と述べている。

同社によると今回の契約は、量子ベンダーとNECほどの人員/業域規模の多国籍IT企業との協働、その最初期における例の1つだという。両社が最初に取り組むのは、NECのスーパーコンピューターやそのほかの伝統的システムと、D-Waveの量子技術を組み合わせたハイブリッドサービスの共同開発だ。古典的システムと量子システムを組み合わせることで、古典的システムだけだった場合よりも低いコストで高いパフォーマンスが得られるのではないかと期待されている。

また、両社はNECの顧客と共同で、このハイブリッド方式を活かせるアプリケーションを作る。さらにNECは、D-Waveが提供するクラウドサービスの公認再販業者になる。

1999年に世界で初めて量子ビットデバイスのデモをしたと主張するNECにとって、今回のパートナーシップは、商用の量子コンピューティングを前進させるための道を見つける努力のひとつだ。NEC Corporationの執行副社長でCTOの西原基夫氏は、「現在の最も複雑な問題の解決に取り組んでいるあらゆる業界の未来で、量子コンピューティングの開発は重要である。ハイブリッドアプリケーションと、量子システムへのアクセス増大により、真に商用利用できる量子ソリューションの実現が可能になるだろう」と述べている。

この度のパートナーシップ契約は、両社をそんな目標に向けて前進させるものになるだろう。

関連記事: D-Wave sticks with its approach to quantum computing(D-Waveは量子コンピューティングのアプローチを固持、未訳)

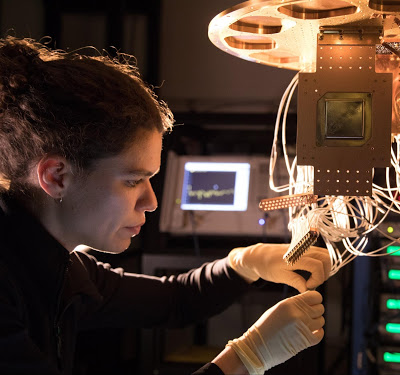

画像クレジット: D-Wave Systems

[原文へ]

(翻訳:iwatani、a.k.a. hiwa)