我々の海に満ちている微細な生物を観察することは重要な作業だが、野生の状況下でそうした生物を観察し続けることは実際には難しい。また実験室の平たい皿の中で観察することは野生状況とは異なる。だがこの「流体力学式トレッドミル」を使えば、野生と実験室との両者を織り交ぜたベストの観察環境を提供することができる。これは水中生物が泳ぎ続けることができる終端のない水の入ったチューブで、同時に自動化された顕微鏡による観察を継続的に行える仕掛けだ。

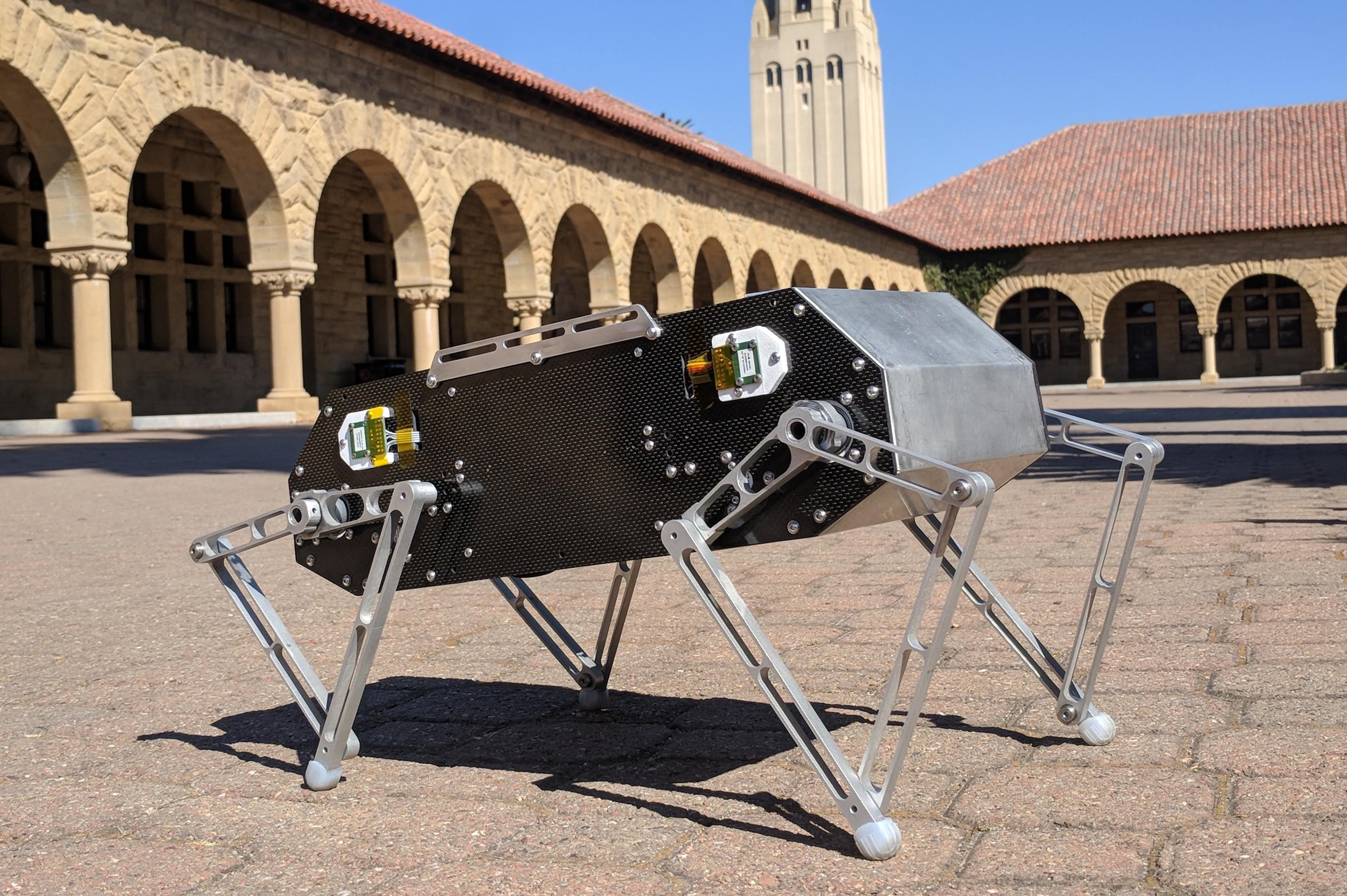

The Gravity Machine(グラビティ・マシン)という名のその機械は、生物工学者であるManu Prakash(マヌ・プラカシュ)教授の下で、スタンフォード大学の研究者たちが生み出したものだ。教授と一部の学生たちは、マダガスカルへの調査旅行中に、生物が上下に動くのを追跡できる顕微鏡が取り付けられた、少し不格好な1mほどの長さのチューブを作った。しかし、こうした微生物は、太陽や水中の栄養素を追いかけるために、1日数百m移動することがある。

「こうした生き物を、それらの生息環境で観察することはできていませんでした。ここ200年ほどの間ずっと。私たちは限定された環境を顕微鏡で覗いて観察していただけなのです。例えば、1km以上にわたって移動するある生物を追跡したいなら、1kmのチューブを用意しなければならなかったのです」とプラカシュ教授はいう。「ひらめいたのは、その問題についてあれこれと考えていた最中でした。『アハ!』の瞬間です。長いチューブを使う代わりに、チューブの端同士を連結してしまったらどうだろう?」。

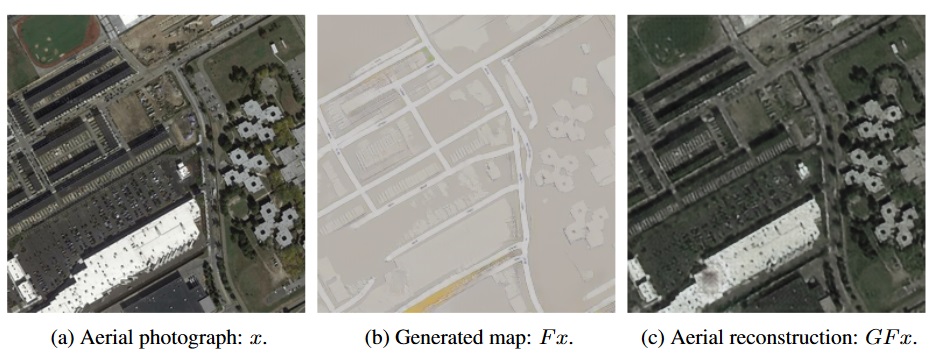

できてしまえば、この仕掛はほとんど明らかなものに思える。浅い水の中で生き物が泳ぎ回っている皿に向けて、顕微鏡を上から向けるのではなく(そうした状況は自然には存在しない)、水と観察対象の生物が入った閉じたガラスのループ状のチューブを、横から観察するのだ。生き物は自由に上下に向かって泳ぐことができ、それに伴ってループがゆっくりと回転して顕微鏡のフレーム内に対象を保ち続ける。

できてしまえば、この仕掛はほとんど明らかなものに思える。浅い水の中で生き物が泳ぎ回っている皿に向けて、顕微鏡を上から向けるのではなく(そうした状況は自然には存在しない)、水と観察対象の生物が入った閉じたガラスのループ状のチューブを、横から観察するのだ。生き物は自由に上下に向かって泳ぐことができ、それに伴ってループがゆっくりと回転して顕微鏡のフレーム内に対象を保ち続ける。

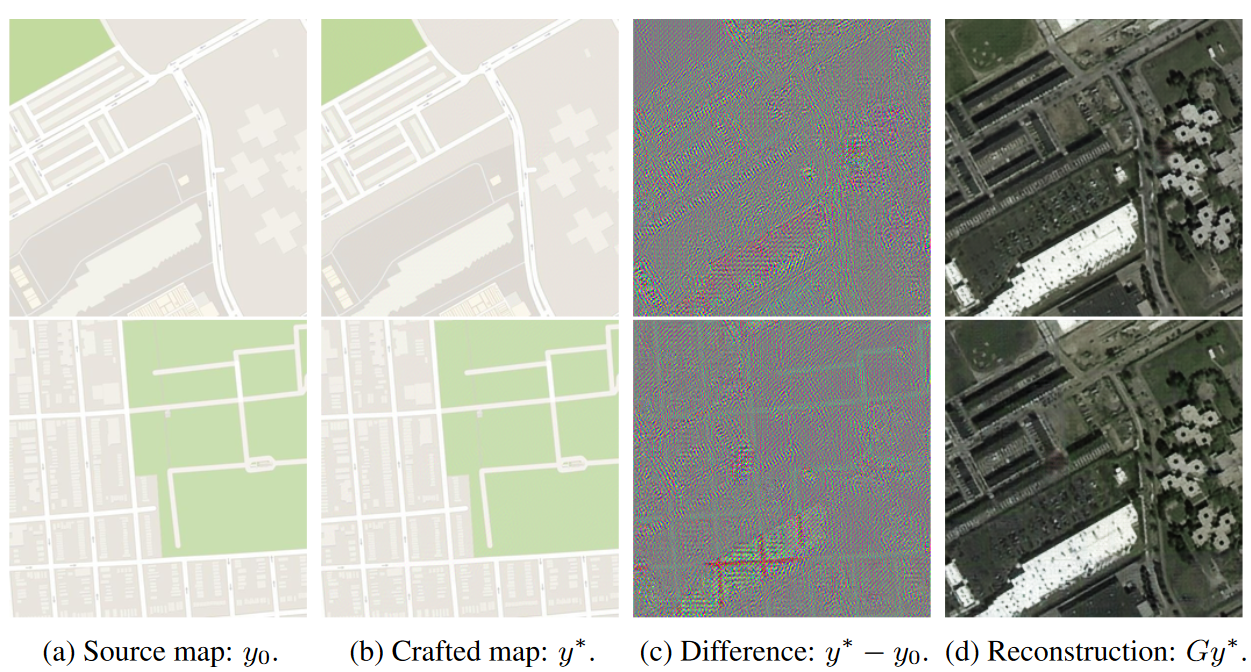

3D顕微鏡に接続されたコンピュータービジョンシステムが、対象となる生き物の位置を注意深く追跡して焦点を合わせ続けるが、その傍らで補助システムが移動した正確な距離やその他の数値を記録している。

チームはこのデバイスを使用して、微視的生物たちの、あらゆる種類の美しく科学的に興味深い行動を捕らえることができた。「なにかの生物をこの器具に入れるたびに、新しい発見があったと言っても過言ではありません」とプラカシュ教授は語った。

例えば、目新しいものの1つは、こうした生き物をこのような形で観察していることから明らかになったことだが、流動的な環境でミクロン単位の大きさで生活しているにもかかわらず、重力がかれらの生活の大きな要素を占めているという事実だ。「彼らはみな重力(グラビティ)を認識していますし、みな重力を気にしています」とプラカシュ教授はいう。生き物の振る舞いを科学者たちが直接観察できるようにするこのマシンが作成されるまでは、それが正確にどのようなものかと言うことはとても難しかった。それこそがこの機械の命名の理由だ。

機器が生み出した画像は、一般の人にとっても視覚的に引きつけられる興味深いものだ。普通海洋微生物学の分野では、一般市民の関心を引くことは非常に困難だ。渦鞭毛藻目に属する海生プランクトンの、日中の行動習慣について言葉で説明しようとしても、聞き手の目はどんよりしてしまうのが普通だ。だがこうした美しい生き物たちが一生懸命何かやっている様子を、それが何にせよ、クローズアップされピントの合った状態で見せられるのは単純に魅力的なのだ。

水はループ内に留まっているものの、それは完全に閉じたシステムであることを意味していない。ちなみに理想的にはそうなのだが「実験室で水をぶちまけてしまったこともあります」とプラカシュ教授は語る。

「我々は生き物が何をしているかに基づいて、さまざまな要素を追加することができます」と語るのは大学院生のDeepak Krishnamurthy(ディーパック・クリシュナムマーシー)氏だ。「我々は栄養素を投入し、光の強度を変えることもできます。それは、生物とその環境の間のフィードバックループとなります。また我々はは、圧力、温度、その他の海洋の性質の側面からも取り組んでいます」。

私は以前このようなものを見たという記憶を振り払うことができなかった、実際Gravity Machineの開発に際しても、プラカシュ教授自身が1950年代にあった似たようなアイデアに出合っていたのだ。それはHardy(ハーディ)氏という名前の海洋生物学者が、クラゲを無限に泳がせるために使っていた、はるかに大きなループ水槽である。もちろん、現在の装置は、我々はが現在持っている高度な機械学習とロボット技術があるからこそ可能になったものだが、プラカシュ教授は「歴史的な背景は、実際非常に美しいものです。我々はは実験室の中で、そこから大事な要素を引き出したのです」という。

スタンフォード大学のこのGravity Machineは、史上初のものというわけではないものの、チームはそれがこの先も受け継がれていくように、機器をどのように開発し運用するかについての詳細な文書を公開する。

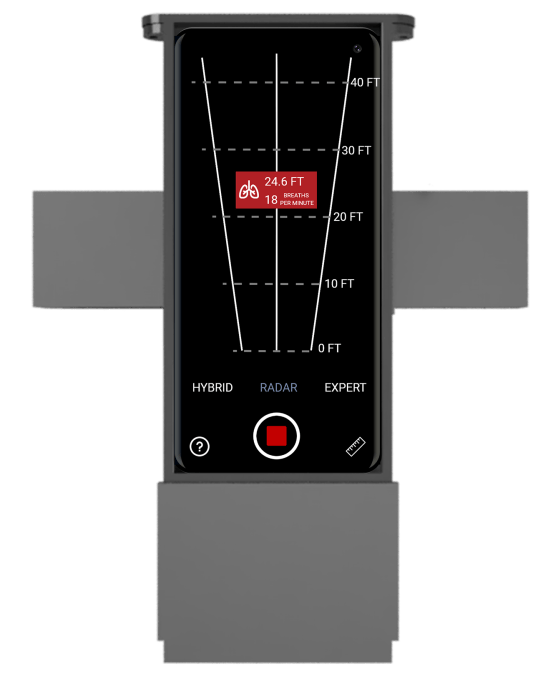

「我々はそれができる限りオープンになるように注意しました、それはハードウェアとソフトウェアに対する我々はの選択にも影響を与えました」とクリシュナムマーシー氏は語る。「その目的は、この機器を研究目的のために完全にオープンソースにすることです。追跡にはオープンソースのアルゴリズムを使用し、ピントを維持するためのコントロール、データを監視および収集するためのUIは自作しました」。

「我々は、gravitymachine.orgサイトに、これを作るための一連の説明を置くつもりです」とプラカシュ教授は付け加えた。通常の顕微鏡を、少しばかり改造して、容易に手に入る部品を使うことで利用することができる。いずれにせよそれは、各研究室が自身で利用する機器を自作する手間と、あまり変わるものではない。彼は、好奇心の強いユーザー向けに、無限に続く水柱の中で、生き物が何をしているのかを観察できる「家庭版」の作製さえほのめかした。シーモンキーのライブショーをテレビの上で見るようなものだ。

Gravity Machineの正確な仕様はまもなく公開され、チームがデバイスを使用して発見した新しくてとても奇妙な事実に関する論文もまもなく発表される。それは自発的に密度を制御して水柱の中を上昇したり下降したりする珪藻についての論文だ。デバイスのさらに詳細については、そのサイトまたはスタンフォードのニュース投稿(スタンフォード大サイト)で読むことができる。

画像クレジット: Stanford University

[原文へ]

(翻訳:sako)