映画制作がアートと同じくらいサイエンスになってきた今、映画会社は観客の反応を測定するためにかつてない方法を必要としている。喜んでくれたのだろうか? どのくらい…正確には?42分の時点で? カリフォルニア工科大学とDisney Researchは、表情認識ニューラルネットワークを使って、観客の反応を知り、予測しようとしている。次世代のニールセンレーティングの基盤になるかもしれない。

この研究プロジェクトは、ハワイで行われたIEEEコンピュータービジョンおよびパターン認識会議で発表され、劇場での表情を確実かつ比較的簡単にリアルタイムで追跡する新しい方法を演示した。

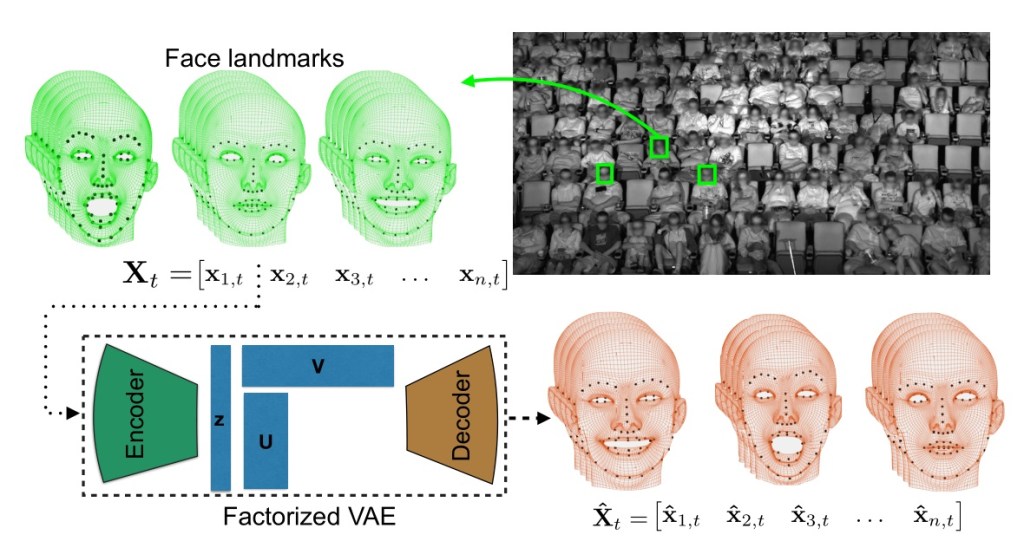

認識には、factorized variational autoencoderと呼ばれるものを使う。数学的背景は説明しようとも思わないが、動きのある表情のように複雑なものの本質を抽出することに関して、従来の方法よりも優れている。

研究チームは映画(もちろんDisney作品)を見ている観衆を録画することで、大量の表情データを収集した。高解像度赤外線カメラで観客の動きと顔を撮影し、得られたデータ(約1600万個のデータポイント)をニューラルネットワークに送り込む。

システムの訓練が終わったら、映画を見ている観客をリアルタイムで追跡して、様々な時点で見せる表情を予測する。研究チームによると、システムが観衆に慣れるのに10分ほどかかり、その後は笑いや微笑みを確実に予測できるようになるという(泣き顔や恐怖はまだ追えていないようだ)。

システムの訓練が終わったら、映画を見ている観客をリアルタイムで追跡して、様々な時点で見せる表情を予測する。研究チームによると、システムが観衆に慣れるのに10分ほどかかり、その後は笑いや微笑みを確実に予測できるようになるという(泣き顔や恐怖はまだ追えていないようだ)。

もちろんこれは、この種のテクノロジーの応用例の1つにすぎない ―― 群衆の監視や、その他の複雑なデータをリアルタイムで解釈する場面にも適用できるだろう。

「人間の行動を理解することは、行動的社会的に優れた知識を持つAIシステムを開発する上で基礎をなす」と同大学のYisong Yueはニュースリリースで言った。「例えば、高齢者を見守り世話をするAIシステムを開発するには、ボディーランゲージのわずかな動きを捕らえる能力が必要だ。人間は不満足であったり問題を抱えていることを明示的に言うとは限らないのだから」。

[原文へ]

(翻訳:Nob Takahashi / facebook )