ロボットや各種自動化装置の普及とともに、それらに3次元の視力を持たせることがますます必要になってきた。しかし、iPhoneのノッチが示すように奥行きを感知するカメラはどうしてもかさばる。ここでご紹介する蜘蛛が獲物までの距離を検知する仕組みは、この状況を変えるかもしれない。

ハエトリグモの小さな頭には、光を照射する仕組みなどを収めるだけのスペースはない。それでも彼らは、巧妙な捕食動物として獲物を正しく見つけて、そっち方向へ正しく進み、正しく獲物を捕らえる。どうやっているのだろう?節足動物の例に漏れず彼らもまた、非常に不可思議なおもしろい方法でそれをやってのける。

人間などは、複数の目が捉えた画像から立体像を作っているが、蜘蛛の目はひとつひとつが奥行きを感知する。個々の目が多層構造になっていて、透明な網膜がそれぞれの層の、距離によって異なる像のぼけ具合を見分ける。蜘蛛の小さな神経系は複数の目の複数の層を比較して距離を正しく測る。そのとても小さなハードウェアで。

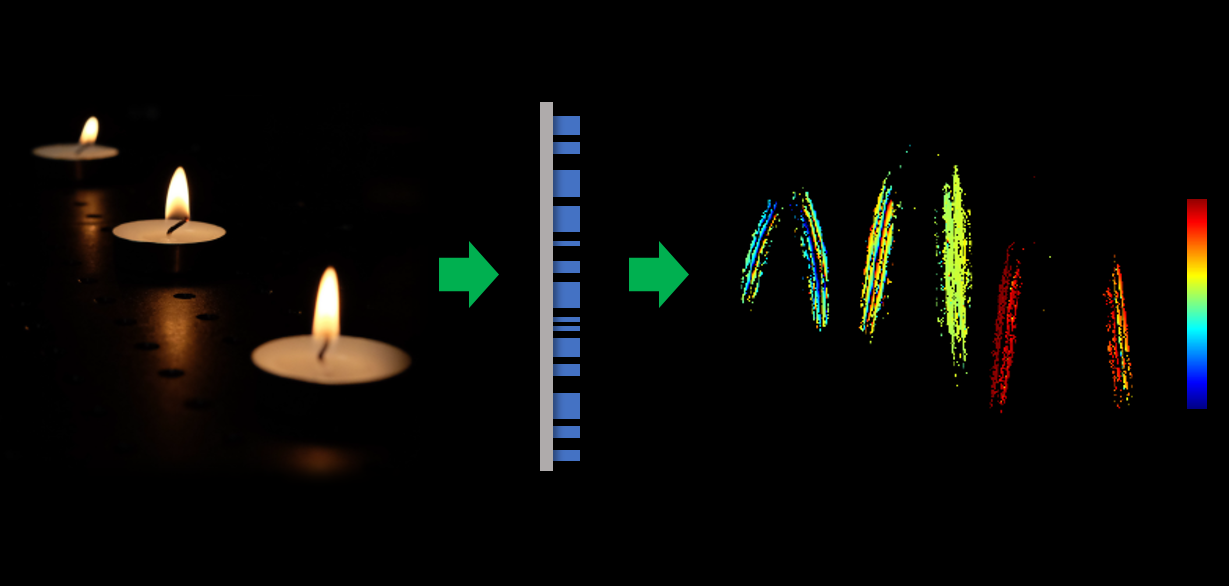

ハーバード大学の研究者たちは、蜘蛛のこのやり方を真似たハイテクのレンズシステムを作り、これまでのような光学系がなくても奥行きを感知できるようになった。

電気工学のFederico Capasso(フェデリコ・カパソ)教授らが作ったその「メタレンズ」は、蜘蛛の目のように、入力視像をぼけ具合の異なる2つのほぼ同じ像として捕らえる。そして同じく蜘蛛の目のようなアルゴリズムで2つの像を素早く瞬時に比較する。それにより、リアルタイムで像全体の奥行きが計算される。

必要な計算力とそのためのハードウェアが微小である、という意味では効率的な処理だが、それだけでなく視覚系もとってもコンパクトだ。実験に使われたメタレンズは直径がわずか3mmだった。

小さいから、自動運転車や工業用ロボットだけでなく、小さなガジェットやスマートホームのアイテム、それにもちろんスマートフォンなどにも楽に組み込める。Face IDを駆逐することはないだろうが、でもその始まりかもしれない。

このメタレンズシステムを記述している研究論文は、米国時間10月28日に発行される「Proceedings of the National Academy of Sciences」(米国科学アカデミー紀要)に掲載される。

画像クレジット: Harvard SEAS

[原文へ]

(翻訳:iwatani(a.k.a. hiwa)