アバターの作成。いったい誰が、そんなことに使える時間を持っているというのだ?もちろんその「誰が」はコンピューターだ。もしこのFacebookも研究が製品化されたら、髪型や、肌の色や、ヒゲの長さを選ぶのにただの1秒も無駄に使う必要はなくなる。

コンピュータービジョン国際会議(International Conference on Computer Vision)で発表された論文(PDF)で、Lior Wolfたちが報告したのは、入力した実際の顔から、絵文字ジェネレーターによる最高の出力結果を生み出す、機械学習システムの構築だ。

読者はおそらくこう思っているかもしれない。待て待て、確か今年の始めにGoogleが同じことをやっていなかったか?と。ある意味その通り。しかし、両者には重要な違いがある。Googleのバージョンもクールだが、様々な顔に共通する様々な特徴に関するランク付けと説明を人間の作業に頼っていた。例えば巻き毛、鼻のタイプ、目の形などなど。そして、これらは特定の特徴の表現としてイラスト化されていた(非常によくできていたと私は思う)。

読者はおそらくこう思っているかもしれない。待て待て、確か今年の始めにGoogleが同じことをやっていなかったか?と。ある意味その通り。しかし、両者には重要な違いがある。Googleのバージョンもクールだが、様々な顔に共通する様々な特徴に関するランク付けと説明を人間の作業に頼っていた。例えば巻き毛、鼻のタイプ、目の形などなど。そして、これらは特定の特徴の表現としてイラスト化されていた(非常によくできていたと私は思う)。

本質的には、コンピューターが目立つ特徴、例えばそばかす、を見つけて、それに対応する部分アートをデータベースから引き出してくる仕掛けになっている。それは上手く行くものの、その結果は特徴を定義する人間の入力に大きく依存している。

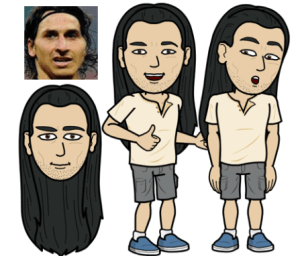

Facebookのアプローチはこれとは異なっている。ここで追求されているアイデアは、手元にある道具(顔の部品や調整手段)を総動員して、与えられた顔を最高にそれっぽく表現できるシステムを追求することだった。つまり既存のツールである、emojiでも、Bitmoji(shudder)でも、Miiでも、VRフェイスジェネレーターでも何でも、そうしたタスクを達成するために使うことが可能だということだ。研究者の言葉を言い換えれば、これらはいつでも人間がやっていることだ、ならばなぜAIを使わないのか?ということになる。

システムは、元の顔と生成された表現の両方に対して、あたかも同じ人物の2枚の写真であるかのように、同じ分析と特徴同定アルゴリズムを使用することによって、このことを(ある程度)達成している。結果として、2つの顔から得られた数値が似通っている場合には、それは2つの顔が視覚的にも十分似通っていることを意味している。(この漫画的な顔を使う限り、ある程度以上は良くはならないということでもある)。

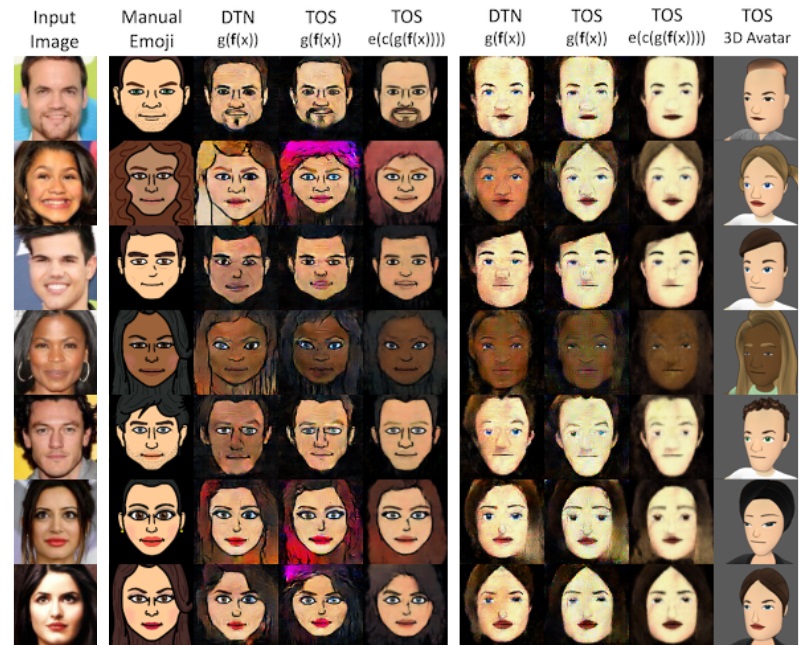

論文に掲載されたこの図では、一番左に元の顔の画像があり、左から2番目に手で作成されたemojiがあり(比較のために置かれていて、システムでは利用されない)、そして今回のシステムの異なるアルゴリズムによる例が示されて、さらに3Dアバターシステムによる例が続く。

この技法の優れている点は、特定のアバタータイプに結び付けられていないため、(理論的には)いずれのアバタータイプに対しても動作するということだ。システムは様々な表現を実際の顔と一致させ、どれが良いものかを判定する。

Facebookはこの情報を多くの有用な目的のために使用することができる——おそらく直近に考えられるのは、専用絵文字システムだ。ユーザーが新しい髪型やヒゲを整えた写真をアップロードするたびに、プロファイルが自動的に更新される可能性さえある。しかし、アバターマッチング機能は、他のサイト向けにでも行うことができる——例えばFacebookから他のVRゲームにサインインした際に、即座に説得力のある自分のアバターを登場させることができる。少なくとも、自分の絵文字の肌の色のディフォルトが黄色ではなくて実際の色に近くなることには、多くの人は反対しないだろう。

完全な論文は、AI会議で発表されたものなので、当然ながらかなり技術的なものだ。

[ 原文へ ]

(翻訳:Sako)