今日(米国時間5/17)、Google本社に隣接するショアラインアンフィシアター野外劇場で開幕した Google I/Oデベロッパー・カンファレンスのキーノートで、CEOのスンダー・ピチャイはGoogle Lensという新しいテクノロジーを発表した。

これはGoogleのコンピューター・ビジョンと人工知能を統合し、スマートフォンのカメラからダイレクトに有益な情報を得ることができるシステムだ。Googleの説明によれば、スマートフォンのカメラは単に目に見える情報を撮影するだけでなく、写された対象を理解してユーザーが適切な行動を取るために役立つ情報を提供する。

Googleはユーザーが花を撮影しようとしてカメラを向けるとLensが即座に花の種類を教えてくれるところなどをデモした。

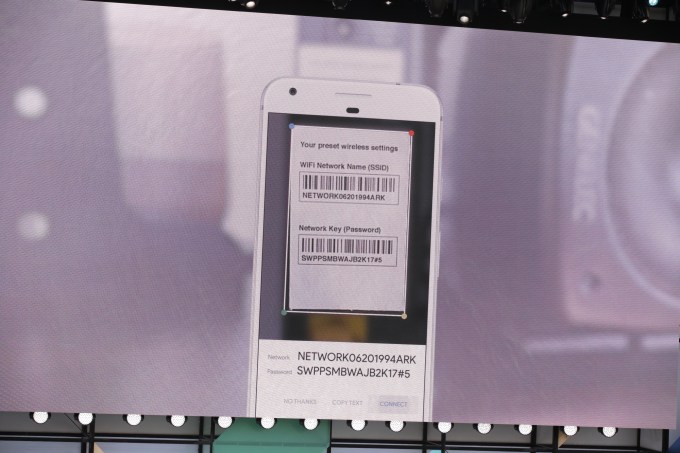

ピチャイはLensは日常のタスクでも役立つ例も挙げた。たとえばスマートフォンでルーターのラベルを撮影するだけで簡単にWiFiに接続できる。 Google LensはルーターのIDとパスワードを読み取り、タップするだけで自動的にそのWiFiに接続するアイコンを表示してくれる。

その次の例では 通りがかりの店舗を撮影すると、Google Lensが店名を読み取り、ウェブを検索して各種のビジネス情報をカード形式で表示する。

このテクノロジーはスマートフォンのカメラを撮影だけでなくモニタに写った対象に関する情報を得ることができるツールに変える。

Pichaiの説明の後、 Scott HuffmanはGoogle Homeのデモ中でGoogle Assistantに組み込まれたLensの能力を示した。Assistantアプリに追加された新しいボタンをタップするとLensを起動し、Assistantを通じてLensと会話し、写真の内容を尋ねることができる。

Scott HuffmanがカメラをStone Foxesのコンサートのポスターに向けるとGoogle Assistantはチケット・セールスを含めてコンサートに関する情報を表示した。Huffmanがオンラインでチケットを購入し「これをカレンダーに追加」と命じるとその通りにスケジュールが設定された。

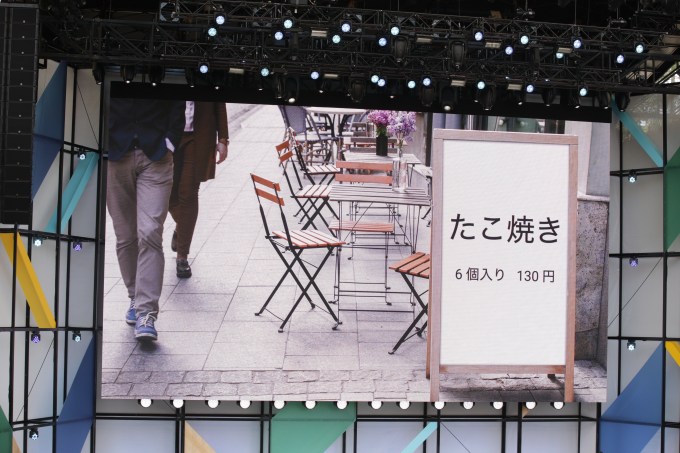

LensとAssistantの統合は翻訳にも威力

Huffmanがカメラを〔「たこ焼き 6個 130円」という〕日本語の看板に向けて「これは何?」と尋ねるとGoogle Assistantは即座に正しく英語に翻訳した。

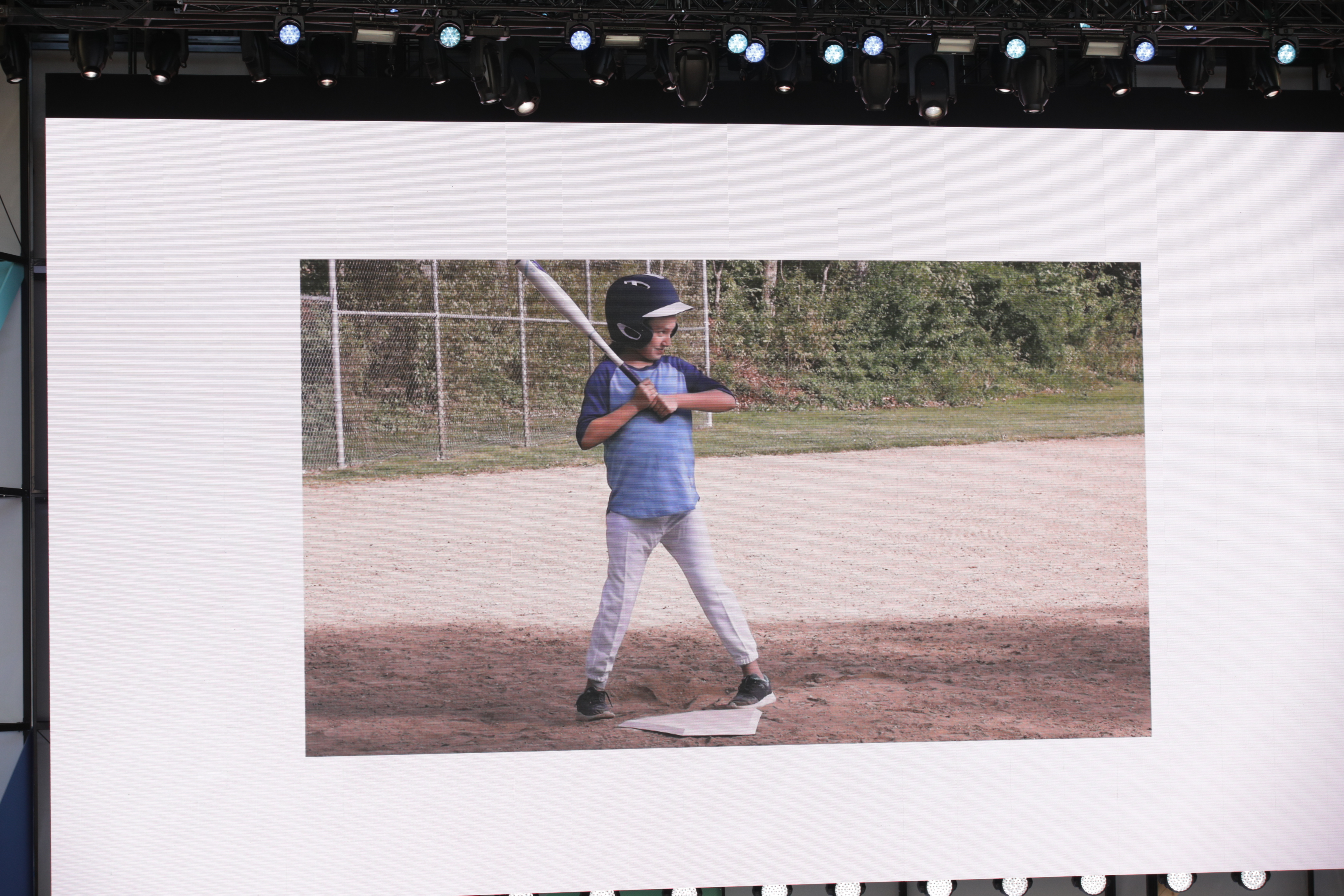

ピチャイはまたGoogleのアルゴリズムが写真の質を改善することができることも示した。たとえば金網越しに子供の野球試合のシーンを撮影したような場合だ。Googleの人工知能は目障りな金網を自動的に取り除いてくれる。また暗い場所で撮影した場合、Googleはピクセルノイズやブレを補正し、写真を見やすくしてくれる。

GoogleはI/OカンファレンスではLensがいつ一般公開されるか日時は明らかにしなかった。しかし「すぐに」手に入るようになるという。

[原文へ]

(翻訳:滑川海彦@Facebook Google+)