スタンフォード大学とGoogleのこの共同体研究は、見る人によって怖かったり、素晴らしかったりするだろう。航空写真から街路地図を作ったり、その逆もやる機械学習のエージェントが、“人間にはほとんど感知できない高周波の信号”を画像中に隠しておくことによって、ある種の騙し技(だましわざ)ができるようになるのだ。すごく賢い子に!

この現象は、コンピューターに最初からつきまとっている問題をあらためて思い出させる。コンピューターは、やれと言われたことを、そのとおりにやってしまうのだ。

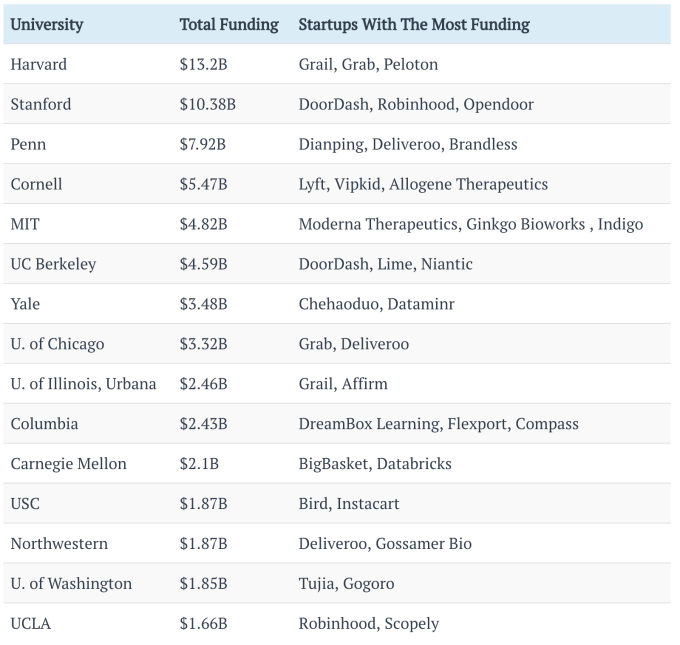

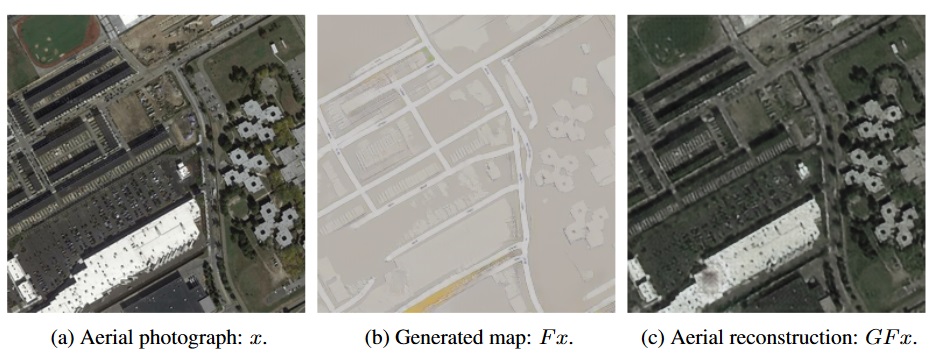

研究者たちの意図は、読者にもすでにお分かりだろう。衛星画像をGoogleの正確なことで有名な地図に換える処理を、彼らはもっと速くしたいのだ。そのためにチームが作ったニューラルネットワークCycleGANは、大量の実験を経て、タイプXの画像(例: 航空写真)をタイプYの画像(例: 街路地図)に、正確かつ効率的に変換する。

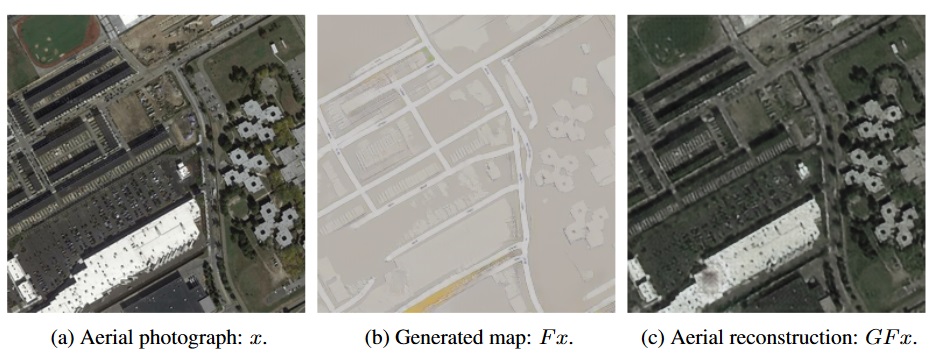

初期の結果は、良好だったが、どこかがおかしかった。気になったのは、街路地図から元の航空写真を再構築するとき、前者(街路地図)にはない細部が大量に再現されてしまうことだ。たとえば、屋根からの太陽光の反射は街路地図を作るとき排除されるが、再構築された航空写真には魔法のように再現されている。

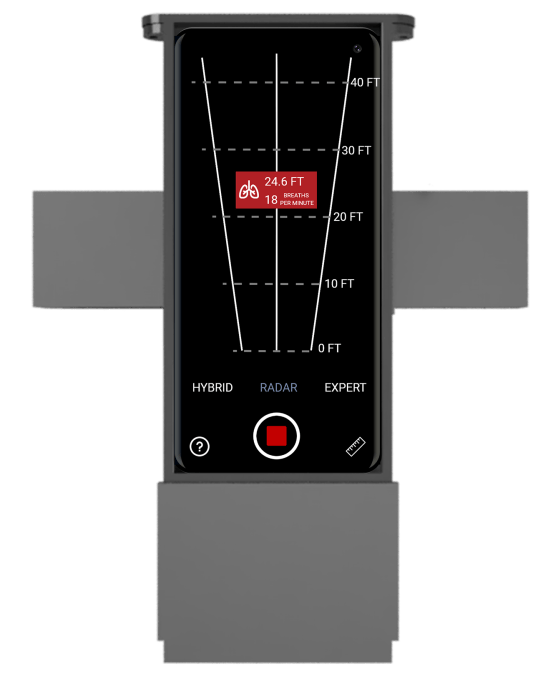

左が最初の航空写真、中央がそれから生成された街路地図、右は街路地図だけから生成された航空写真。どちらの航空写真にもあるドットが、街路地図にはない。

ニューラルネットワークが行なう処理の内部を覗き見することはきわめて困難だが、それが生成するデータを調べることは容易にできる。そしてささやかな実験から分かったのは、CycleGANが実は、人を騙していることだった。

エージェントに期待されているのは、各タイプのマップの特徴を正しく解釈して、それらを他方のマップの正しい特徴へマッチさせることだ。しかしエージェントの実際の評価では、再構築された航空写真がオリジナルに近いことと、街路地図の明確さが重視される。その重視のもとに、ニューラルネットワークの訓練も行われる。

そこでエージェントが学習したのは、XからY、YからXを作ることではなく、元の画像の特徴を変換後の画像のノイズパターンへと秘かにエンコードすることだった。航空地図の細部が、街路地図の視覚的データの中へこっそりと書き込まれた。それらは、人間の目には気づかない何千もの小さな色の変化として書き込まれたが、コンピューターはそれらを容易に見分けることができる。

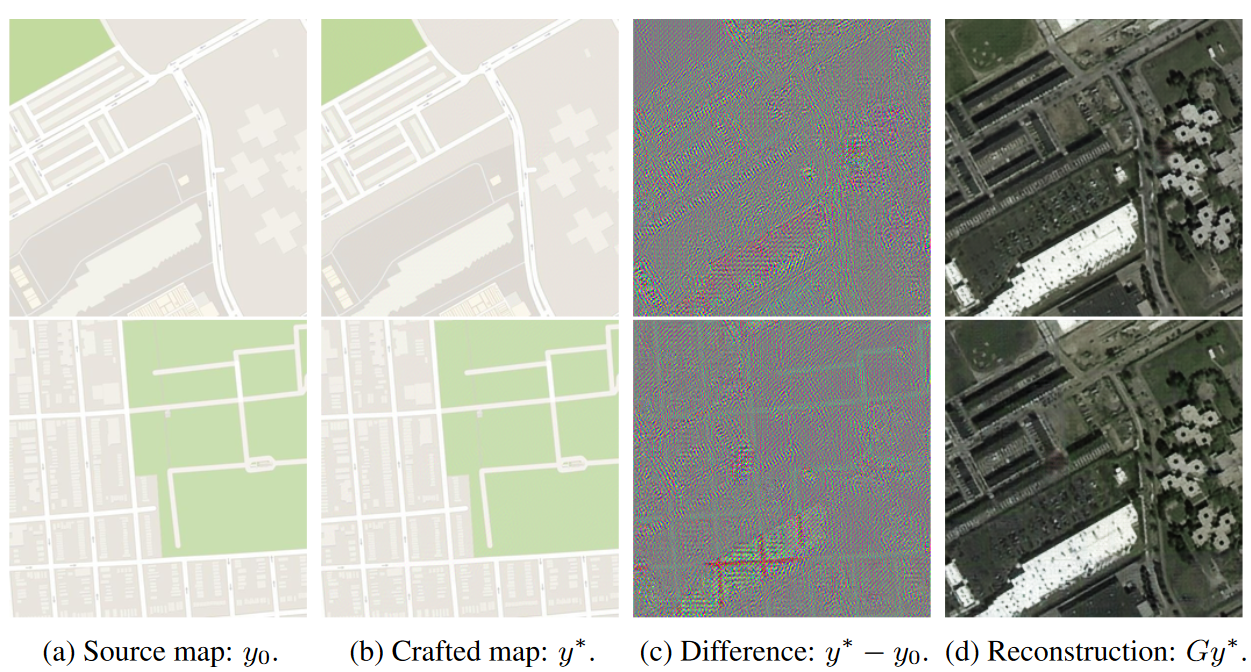

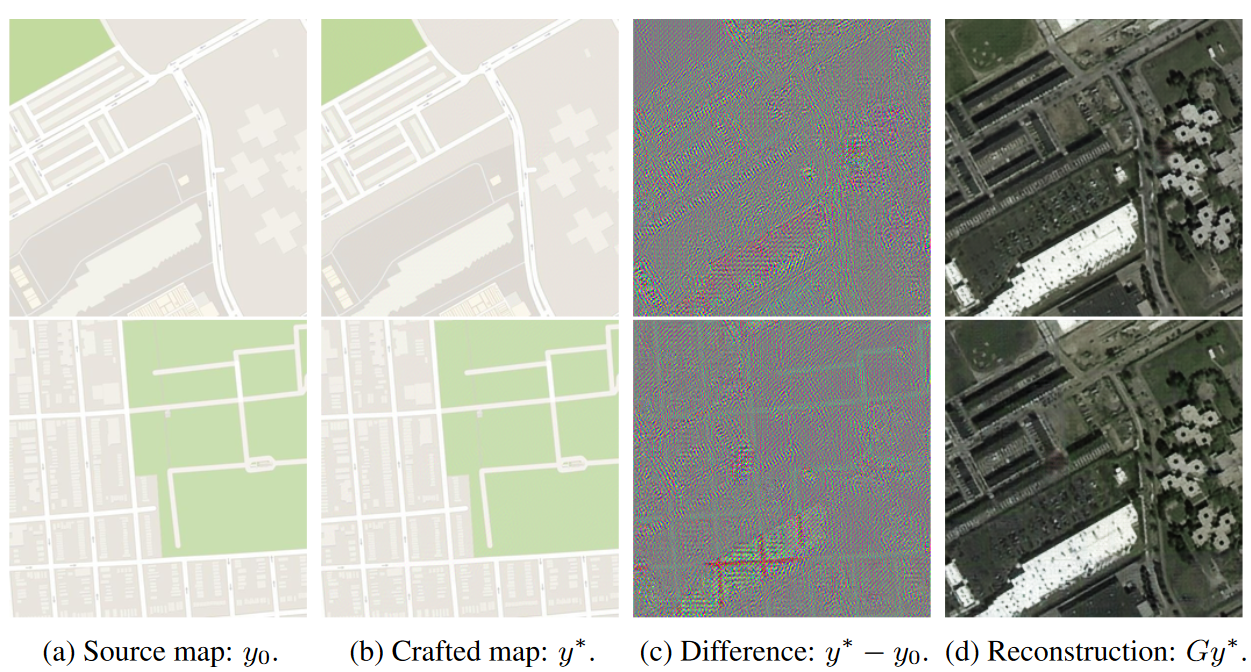

そういう細部情報を街路地図の中へ忍ばせることはコンピューターの得意技のひとつだから、それは、“航空地図を街路マップの中へエンコードする”ことを学習した!。もはや、“リアルな”街路地図を作ることなど、彼の念頭にはない。航空地図の再構築に必要なすべてのデータを、完全に別の街路地図の上にも無害に書き込めることを、研究者たちは確認した:〔下図の下が“完全に別の街路地図”〕

右の航空写真が、変更や加工なしで左の地図の中へエンコードされた。

上の’c’のカラフルなマップは、コンピューターが意図的に導入したわずかな違いを視覚化している。どちらも航空地図の形を維持していることが分かるが、それは誇張や強調など、特殊な視覚化処理をしたから人間の目にも見えるだけである。

データを画像中にエンコードする技術は、ステガノグラフィ(steganography)と呼ばれ、画像の透かしや写真のメタデータ(撮影データ)として前から利用されている。しかし、コンピューターが自分に課せられた学習から逃れるために自分でステガノグラフィ作るのは、これが初めてではないか。この研究が発表されたのは昨年(2017)だから、‘最新’とは言えないかもしれないが、相当新しいことは確かだ。

これを、“機械が自力で賢くなった”として、もてはやす人もいるかもしれないが、実態はむしろその逆だ。機械は、高度な画像の各種タイプを互いに変換する難しい仕事ができるほど賢くはないから、人間にばれないような騙し技を見つけたのだ。エージェントの結果を、もっと厳しく評価していたら、それは避けられたかもしれない。研究者たちは、その方向へ進んだ。

例によって、コンピューターは求められたことを正確に行なう。だから、コンピューターへの指示は、きわめて詳細でなければならない。今回の場合、コンピューターが見つけたソリューションは、このタイプのニューラルネットワークの弱点に光を当てたという意味で、興味深い。コンピューターは、明示的に禁止されていないかぎり、詳細情報を自分に伝える方法を見つけて、与えられた問題を迅速簡単に解こうとするのだ。

実はこれは、コンピューティングの古い格言、PEBKACが教えていることでもある。“Problem Exists Between Keyboard And Computer”…問題はキーボードとコンピューターの中間にある*。人間に反逆するコンピューターHALも、“問題はすべて人間のエラーが原因だ”と言っている。〔*: 正しくは、Problem Exists Between Keyboard and Chair, キーボードと椅子の間、すなわち人間。〕

彼らのペーパー“CycleGAN, a Master of Steganography,”(ステガノグラフィの達人CycleGAN)は、2017年のNeural Information Processing Systemsカンファレンスで発表された。Fiora EsotericaとRedditのおかげで、このちょっと古いけどおもしろいペーパーを知ることができた。

[原文へ]

(翻訳:iwatani(a.k.a. hiwa)