イギリスの児童コミッショナーは、その報告書で、民間公共を問わず、子どもたちのデータが収集され拡散されている状況に懸念を示している。

『Who knows what about me?』(自分の何を、誰が知っているのか?)と題されたその報告書で、Anne Longfieldは、ビッグデータが子どもたちの人生にどう影響するかを「立ち止まって考える」べきだと社会に訴えている。

ビッグデータの使い方によっては、子ども時代の足跡によって将来が決められてしまうデータ劣位世代が生まれると、彼女は警告している。

大人になる前の子どもたちをプロファイリングすることが、長期的にどのような影響を及ぼすかは、まだわかっていないと彼女は書いている。

「子どもたちは、ソーシャルメディアだけでなく、人生のさまざまな場面で『データ化』されています」とLongfieldは言う。

「今、成長中の子どもたちと、それに続く世代は、個人データの収集量が単純に増えることから、プロファイリングの影響をより強く受けることにります」

子どもが13歳になるまでの間に、その両親は、平均1300点の写真や動画をソーシャルメディアで公開していると、報告書は伝えている。その子どもたち自身がソーシャルメディアを使い始めると、1日平均で26回投稿するようになり、そのデータ量は「爆発的」に増えて、18歳になるまでには、総計でおよそ7万点に達する。

「今、これが子どもたちの人生にとって何を意味するのか、大人になったときの未来の人生に何をもたらすのか、立ち止まって考えるべきです」とLongfieldは警鐘を鳴らす。「こうした子どもたちに関する情報が、どのような結果をもたらすかは、はっきり言ってわかっていません。そんな不確実性の中で、私たちはこのままずっと、子どもたちのデータを収集し拡散していってよいのでしょうか?」

「子どもと親は、何を公開するか、その結果として何が起きるかを、もっと真剣に考えるべきです。アプリやおもちゃなど、子どもが使う製品のメーカーは、トラッカーを使った子どもたちのプロファイリングを停止し、子どもにわかる言葉で利用規約を示す必要があります。とりわけ、政府は、こうした状況を監視し、子どもたちを守るために、とくに技術が進歩してゆくことを考慮して、データ保護法を改正することが重要です」と彼女は言う。

報告書は、子どもに関するどのような種類のデータが収集されているのか、どこで誰が集めているのか、それが短期的または長期的にどう利用されるのか、それが子どもにどのような利益をもたらすのか、またはどのような危険性が隠れているのかを注視している。

有用性について、報告書は、子どものデータを有用に使えるであろものとして、まだ早期の実験段階にあるアイデアをいつくか紹介している。たとえば、データが問題ありと指摘した部分に焦点を当てて調査する、子どものためのサービスがある。自然言語処理技術で大きなデータセット(英国児童虐待防止協会の国営事例調査データベースなど)の解析が速くなれば、共通の課題の検出や、「危害を予防して有益な結果を生み出す」ためにはどうすればよいかという理解も深められる。子どもと大人から集めたデータを使って予測解析ができれば、「子どもを保護するための潜在的危険を社会福祉指導員に伝える」ことが、より低コストに行えるようになる。また、子どものPersonal Child Health Record(個人健康記録)を今の紙ベースからデジタル化すれば、子どもに関わるより多くの専門家が閲覧できるようになる。

Longfieldは、データが蓄積され利用できるようになることで「多大な恩恵」が得られると説明しながらも、大きなリスクも現れてくると明言している。それには、子どもの安全、福祉、発達、社会的な力学、身元詐称、詐欺などが含まれ、さらに長期的には、子どもの将来の人生のチャンスに悪影響をもたらすことも考えられる。

実質的に子どもたちは、「大勢の大人たちがそれに気がつくより先に、またはそれを緩和する戦略を立てる前に、その問題に直面する、社会全体のための、いわゆる炭鉱のカナリア」なのだと彼女は警告する。「私たちはその問題への意識を高め、対策を立てなければなりません」

透明性が欠けている

この報告書から明確に学べることに、子どものデータがどのように収集され使われているかが不透明であるという点があり、そのことが、リスクの大きさを知る妨げにもなっている。

「収集されたあとの子どものデータがどう使われるのか、誰が集めて、誰に渡され、誰が集約しているのかをよく知ることができれば、そこから将来に何が起きるかを推測できます。しかし、そこの透明性が欠けているのです」とLongfieldは書いている。新しいEU一般データ保護規制(GDPR)の構想の中で、もっとも重要な原則となっているのが透明性の確保であるにも関わらず、それが現実だと言う。

この規制は、ヨーロッパでの子どもの個人データの保護を強化するよう改定されている。たとえば、5月25日からは、個人データの利用に同意できるのは16歳以上とするといった規制が施行された(ただしEU加盟国は、13歳を下限として、この年令を変更できる)。

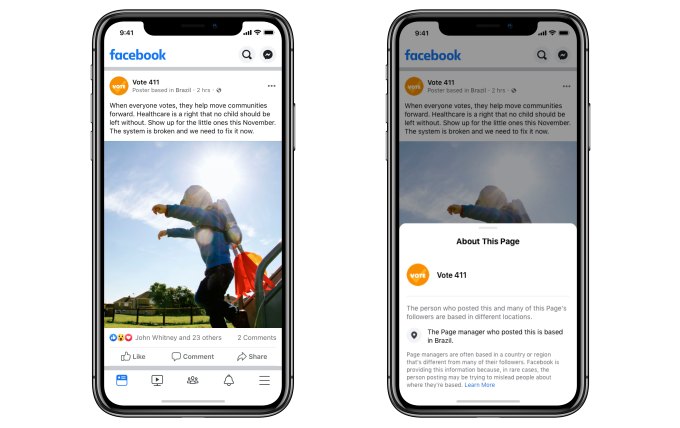

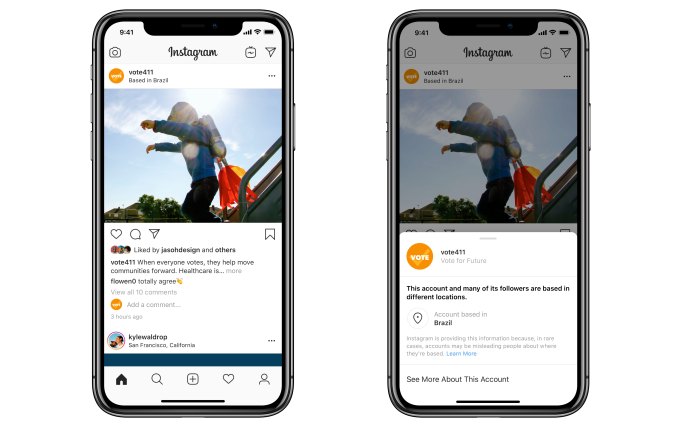

FacebookやSnapchatなどの主要ソーシャルメディア・アプリは、EU内での利用規約を改定したり、製品を変更したりしている(しかし、以前我々が報じたように、GDPRに準拠したと主張されている保護者の同意システムは、子どもに簡単に破られてしまう)。

Longfieldが指摘するように、GDPRの第5条には、データは「個人に関して合法的に公正に、透明性をもって扱われなければならない」と記されている。

ところが、子どものデータに関して透明性はないと、児童コミッショナーの彼女は訴える。

子どものデータ保護に関して言えば、GDPRにも限界があると彼女は見ている。たとえば、子どものプロファイリングをまったく規制していない(「好ましくない」と言ってるだけだ)。

第22条には、法的またはそれに準ずる多大な影響を被る場合には、子どもは、自動処理(プロファイリングを含む)のみに基づく意思決定に従わない権利を有する、とあるが、これも回避可能だ。

「これは、どこかで人が介在する判断には適用されません。その介在がどんなに小さなものであってもです」と彼女は指摘する。つまり企業には、子どものデータを回収するための回避策があるということだ。

「自動処理による意思決定に『それに準ずる多大な影響』があるかどうかを見極めるのは困難です。その行動が何をもたらすのか、私たちはまだ、完全にわかっていないからです。子どもの場合は、さらに見極めが難しいでしょう」と彼女は言う。

「第22条が子どもにどのような効力を発揮するかは、まだまだ不確実です」と彼女は懸念する。「この問題の核心は、広告、製品、サービス、そしてそれらに関連するデータ保護対策に関するあらゆる制限に関わってきます」

提案

報告書でLongfieldは、政策立案者にいくつかの提案を行っており、学校に対しては「自分たちのデータがどのように回収され利用されているか、自分のデータの足跡をどのように自己管理するかを教える」よう訴えている。

彼女はまた、政府に対しては、18歳未満の子どもから集めたデータに関しては、「自動処理による意思決定に使用されるアルゴリズムと、アルゴリズムに入力されたデータを透明化するよう、プラットフォームに義務付けることを考えて欲しい」と要求している。

コンテンツを作成しプラットフォームで大々的に配信するAIの仕組みがまったく不透明な主流のソーシャルメディア・プラットフォームこそ、その対象となるべきだ。18歳未満のデータは保有しないと公言しているプラットフォームは、あるにはあるが、非常に少ない。

さらに、子どもをターゲットとする製品を扱う企業は、もっと説明の努力をするべきだと彼女は主張し、次のように書いている。

子ども向けのアプリやおもちゃを作っている企業は、子どもの情報を集めているあらゆるトラッカーについて、より透明にするべきです。とくに、子どもの動画や音声を収集するおもちゃにおいては、パッケージにそのことをよくわかるように明記するか、情報を公表すべきです。そのおもちゃの中に、または別の場所に映像や音声が保存される場合、またそれがインターネットで転送される場合は、その旨を明記する必要があります。転送される場合、保護者にはそれが送られるとき、また保存されるときに暗号化されるのか、そのデータを誰が解析し、処理し、何の目的で利用されるのかを知らせなければなりません。その情報が与えられない場合、または不明確な場合は、保護者はメーカーに問い合わせるべきです。

もうひとつの企業への提案は、利用規約を子どもがわかる言葉で書くということだ。

(とは言え、技術業界の利用規約は、大人が表面的にざっと読むだけでも難しい。本気で読もうとすれば何時間もかかってしまう)

写真: SementsovaLesia/iStock

BuzzFeed Newsに掲載された最近のアメリカの研究では、子ども向けのモバイルゲームは、たとえばアプリ内の有料アイテムを購入しないと漫画のキャラクターが泣き出すといったふうに、巧妙に子どもの心を操るようになっているという。

データ処理にまつわる重要で際立った問題は、それが見えないという点にある。バックグランドで処理されるため、その危険性はなかなか見えづらい。人々(そしてまさに子どもたち)の情報に何をしているのかを本当に知っているのは、データ処理機能だけだ。

しかし、個人データの取り扱いは、社会的な問題になってきた。それは、社会のあらゆる場所や場面に関わるようになり、子どもが危険に晒されていることへの関心も、明確に高まってきた。

たとえば、この夏、イギリスのプライバシー監視団体は、一般の人たちがそうと知り、受け入れる前に、データが利用されてしまう危険性が大きいことを示し、政治キャンペーンでのインターネット広告ターゲティング・ツールの使用は倫理的に止めるべきだと呼びかけた。

また同団体は、政府に対しても、長年保ち続けた民主主義の基準が失われないように、デジタルキャンペーンの行動規範を作るべきだと訴えている。

つまり、児童コミッショナーNatasha Lomasの、みんなで「立ち止まって考えよう」という主張は、政策立案者に向けた、データ利用に関する懸念を叫ぶ声のひとつに過ぎない。

ただ言えるのは、社会にとってのビッグデータの意味を定量化して、強力なデータマイニング技術が、すべての人にとって倫理的で公正に使われるようにと願う方向性は、変わらないということだ。

[原文へ]

(翻訳:金井哲夫)

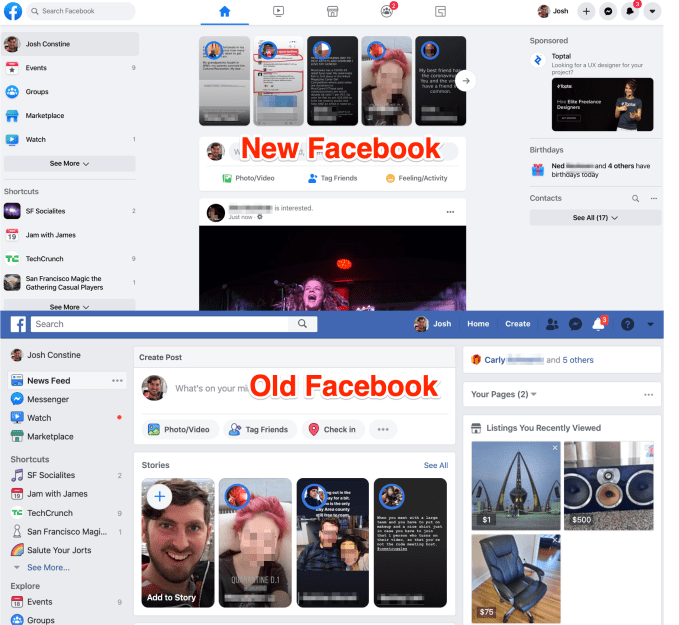

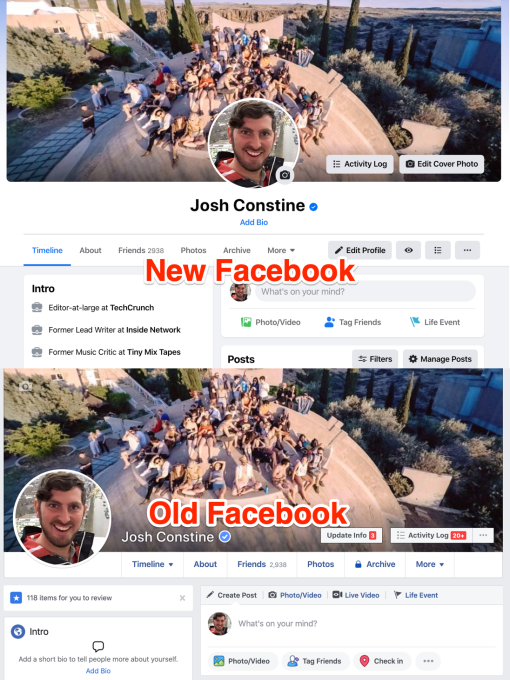

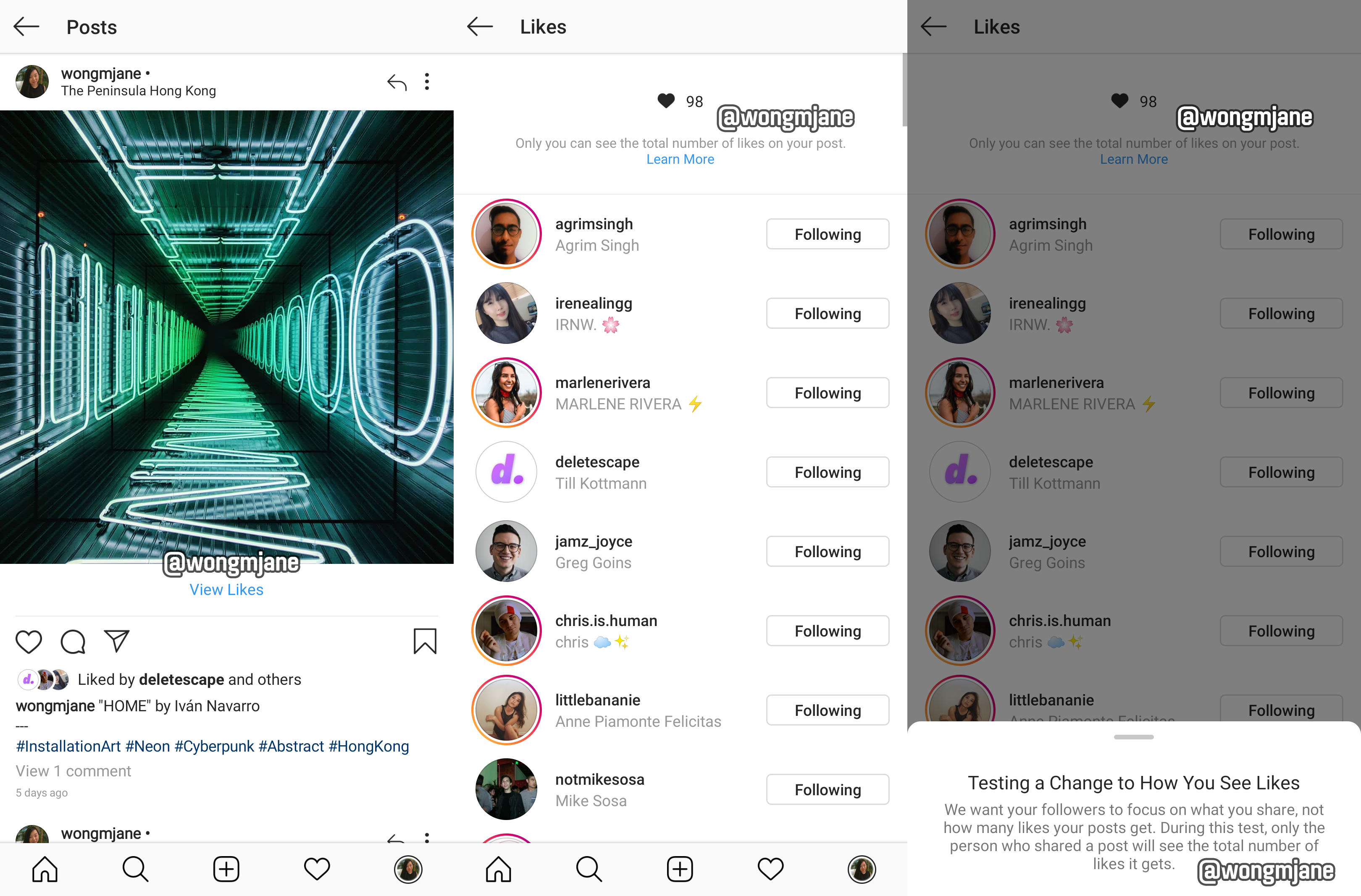

新しいUIデザインがテストされていることはリバース・エンジニアリングのプロ、

新しいUIデザインがテストされていることはリバース・エンジニアリングのプロ、