衛星画像には産業、科学、人道上の問題解決に役立つ情報が豊富に含まれている。ただ従来の大きな課題は多様なデータを特定の用途に活用する効果的な方法がなかったことだ。

良質な分析を求める声は常にあった。その声に応える分析技術を開発するスタートアップが事業拡大に向けた資金調達ラウンドを発表した。米国ニューメキシコ州サンタフェを拠点とする地理空間画像分析のスタートアップであるDescartes Labs(デカルトラボ)は10月11日、2000万ドル(約22億円)の資金調達完了を発表した。CEO兼創業者のMark Johnson(マーク・ジョンソン)氏は筆者に、今回のラウンドは次の大規模ラウンドまでのつなぎ資金を得ることが目的だと語った。

資金調達はUnion Grove Venture Partners(UGVP)がリードし、Ajax Strategies、Crosslink Capital、March Capital Partners(前ラウンドをリード)も参加した。Descartes Labsの資金調達総額は6000万ドル(約65億円)となった。ジョンソン氏はバリュエーションを公表しないと述べているが、PitchBookによるとポストマネーで2億2000万ドル(約240億円)、プレマネーで2億ドル(約220億円)とのことだ。

比較の対象としては、同じく地理空間情報分析のスタートアップであるOrbital Insightが4億3000万ドル(約470億円)のバリュエーションで資金調達中との情報がある。この情報は今年1月のもので、資金調達が完了したかどうか、TechCrunchは同社に問い合わせている。

退職者に人気があり観光が最大の産業であるサンタフェでハイテクスタートアップを見つけることはまずない。Descartes Labsがサンタフェにあるのは、その近くに拠点を置くロスアラモス国立研究所から同社がスピンオフしたためだ。

サンタフェに本社を置くのは創業後半年程度だろうと思っていた、とジョンソン氏は言う。同氏は以前サンフランシスコに住んでいて、Descartes Labsの立ち上げ支援のためにサンタフェに来た。彼は以前メディア用アプリのZiteの開発に関わった経験があるため、ロスアラモスの科学者たちはDescartes Labsが検索エンジンの会社だと思ったようだ。

従業員がより多様な場所から働く傾向があること(及びそれを可能にするクラウドコンピューティング)、多くのエンジニアが物価の高いサンフランシスコに代わる場所で仕事を探していること、シリコンバレーで人材獲得競争が熾烈になっていることが、Descartes Labsの本社をサンタフェに置く要因となった。

独創的な哲学者かつ数学者であったルネ・デカルトにちなんで名付けられたDescartes Labsは、自身を「データ精製所」と形容する。意味するところは次のような内容だ。まず地球に関する大量の画像と非構造化データを取り込む。データソースは主に衛星だがセンサー類もある(ジョンソン氏によれば、データソースには一般に利用が公開されている衛星からのデータ、NASAおよび欧州宇宙機関からのデータ、企業からのデータがあるという)。次に、コンピュータービジョン分析や機械学習などのAIベースの手法を適用して、粒度の低い画像を意味のある情報に変換する。最後に情報の精度を高めて、地球で何が起こっているのか、今後はどうなりそうなのかについて洞察を得る。

地球の表面だけでなく上空で起こっていることも捉える。Descartes Labsは、油田のメタンガスレベル、山火事の広がり、特定の地域で作物がどのように成長するか、また、そうしたものに気象が与える影響などを情報として抽出するプロジェクトに取り組んでいる。

Descartes Labsの顧客は政府(上記のメタンガスの調査をニューメキシコ州の温室効果ガス排出削減の取り組みの一環として委託した)、エネルギー大手企業、アグリビジネス、トレーダーなど多様だ。

「オンラインで利用可能になる全てのデータを顧客が活用できるようにしたい」とジョンソン氏は言う。例えば、銀行が商品作物の取引価格や、もっと踏み込んで作物の土壌組成の変化が価格にどう影響するか予測できるようになる。

Descartes Labsの研究がエネルギー産業と結びついたことが、「データ精製」という言葉に深みを与えている(石油やガスの精製を連想させる)。ただデータが倫理的に正しい目的のためにのみ使用されるのか疑問に思っている人もいるかもしれない。ジョンソン氏は、同社が潜在顧客を事前に調査し、提供するデータが前向きな目的のためかどうかを判断すると説明した。

ジョンソン氏は「顧客の効率性追求を支援できると思う。地球のデータを見る人は、地球のことを気にかけているし、持続可能性を高めるよう努力している」と述べた。

またジョンソン氏は筆者の質問に対して、これまでDescartes Labsが特定の国や顧客との仕事を禁止されたことはなかったが、データが現代の油田であり力の源泉となりえる以上、将来は問題になる可能性があると答えた。例えば、Orbital InsightはCIAのベンチャー部門であるIn-Q-Telの支援を受けている。

将来に向けて、Descartes Labsは地球のデジタルツイン(物理的な空間の情報をコンピューター上で再現したもの)を構築している。画像をうまくモデル化し、さまざまな地域からのデータをきれいにつなげるためだ(結局、世界のある地域での気候変動は必然的に別の地域に影響を与えるものだ)。デジタルツインは、企業がAIによる精度の高い将来予測を行う際に適用する一般的な概念だ。例えば、Forward Networksが企業のネットワークのモデルを構築してアプリの動作や停止の背後にある理由を特定するときに採用するアプローチだ。

Descartes Labsは資金調達ラウンドの発表のほかに、Phil Fraher(フィル・フレイハー)氏を新しいCFOに指名し、エネルギーイノベーションディレクターのVeery Maxwell(ベリー・マックスウェル)氏と、UGVPを共同設立したPatrick Cairns(パトリック・ケアンズ)氏を取締役会に迎えると発表した。

[原文へ]

(翻訳:Mizoguchi)

「薬のない人に薬を、薬の効かない人に薬を」をミッションに掲げ、AIによる創薬の効率化を目指すスタートアップ。

「薬のない人に薬を、薬の効かない人に薬を」をミッションに掲げ、AIによる創薬の効率化を目指すスタートアップ。 オフィス探しをAIによって効率化するスタートアップ。

オフィス探しをAIによって効率化するスタートアップ。 ウェブサイトのアクセスログ分析に機械学習を組み合わせることで、ユーザーの行動を解析するためのツール「CACICA」を開発。

ウェブサイトのアクセスログ分析に機械学習を組み合わせることで、ユーザーの行動を解析するためのツール「CACICA」を開発。 マンガを高精度で自動翻訳するサービスを開発。AIによる画像認識より、マンガ内の吹き出しの位置やテキストを自動認識して該当部分を抽出する。

マンガを高精度で自動翻訳するサービスを開発。AIによる画像認識より、マンガ内の吹き出しの位置やテキストを自動認識して該当部分を抽出する。 素材産業向けに、実験計画を効率化するサービスを提供する。

素材産業向けに、実験計画を効率化するサービスを提供する。 カプセル内視鏡の読影支援AIを開発。

カプセル内視鏡の読影支援AIを開発。 地球観測衛星のデータをAIで解析する事業を展開。

地球観測衛星のデータをAIで解析する事業を展開。 AIによるプロファイリング技術を活用したデジタルマーケティングツールを開発・販売。

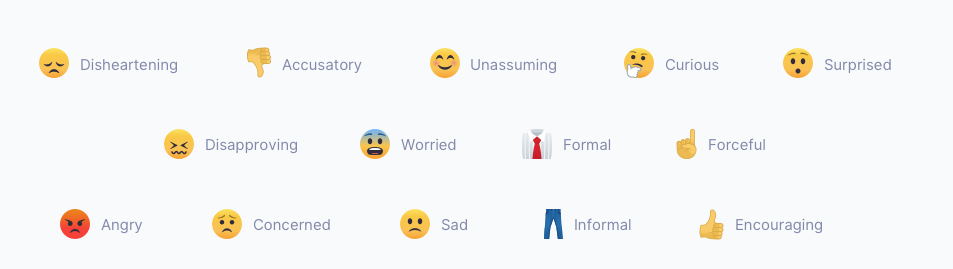

AIによるプロファイリング技術を活用したデジタルマーケティングツールを開発・販売。 人をデジタル定量化するツールを開発。人間の行動や感情の認識、物の検知などを行う画像認識のAIアルゴリズムを提供している。

人をデジタル定量化するツールを開発。人間の行動や感情の認識、物の検知などを行う画像認識のAIアルゴリズムを提供している。 AI搭載型クラウドIP電話サービス「Miitel」を開発。

AI搭載型クラウドIP電話サービス「Miitel」を開発。 不在配達の削減や書籍の返本率の改善などを独自のAIアルゴリズムを活用して実現。

不在配達の削減や書籍の返本率の改善などを独自のAIアルゴリズムを活用して実現。 AIを活用した画像解析と独自の3Dプリンターを組み合わせた低価格義足の開発・販売をフィリピンで展開。

AIを活用した画像解析と独自の3Dプリンターを組み合わせた低価格義足の開発・販売をフィリピンで展開。