Docker(ドッカー)のエンタープライズビジネスを最近買収したMirantis(ミランティス)は米国時間8月13日、Kubernetes(クーバネティス)のためのIDE(統合開発環境)の1つと言われているデスクトップ環境のLens(レンズ)を買収すると発表した。Mirantisはすでに、Lensをもともと開発していたフィンランドのスタートアップであるKontena(コンテナ)を買収(Mirantisプレスリリース)していた。

とはいえLens自体は、ここしばらくLakend Labs(ラケンド・ラボ)によって所有・管理されていた。なおLakend Labsは自身を「コンテナ(Kontena)の生み出したオープンソースソフトウェアとしての製品の保存と維持に力を注いでいる、クラウドネイティブコンピューティングの熱烈な支持者と技術者の集まり」だと説明している。LakendはLensを数カ月前にオープンソースにしていた。

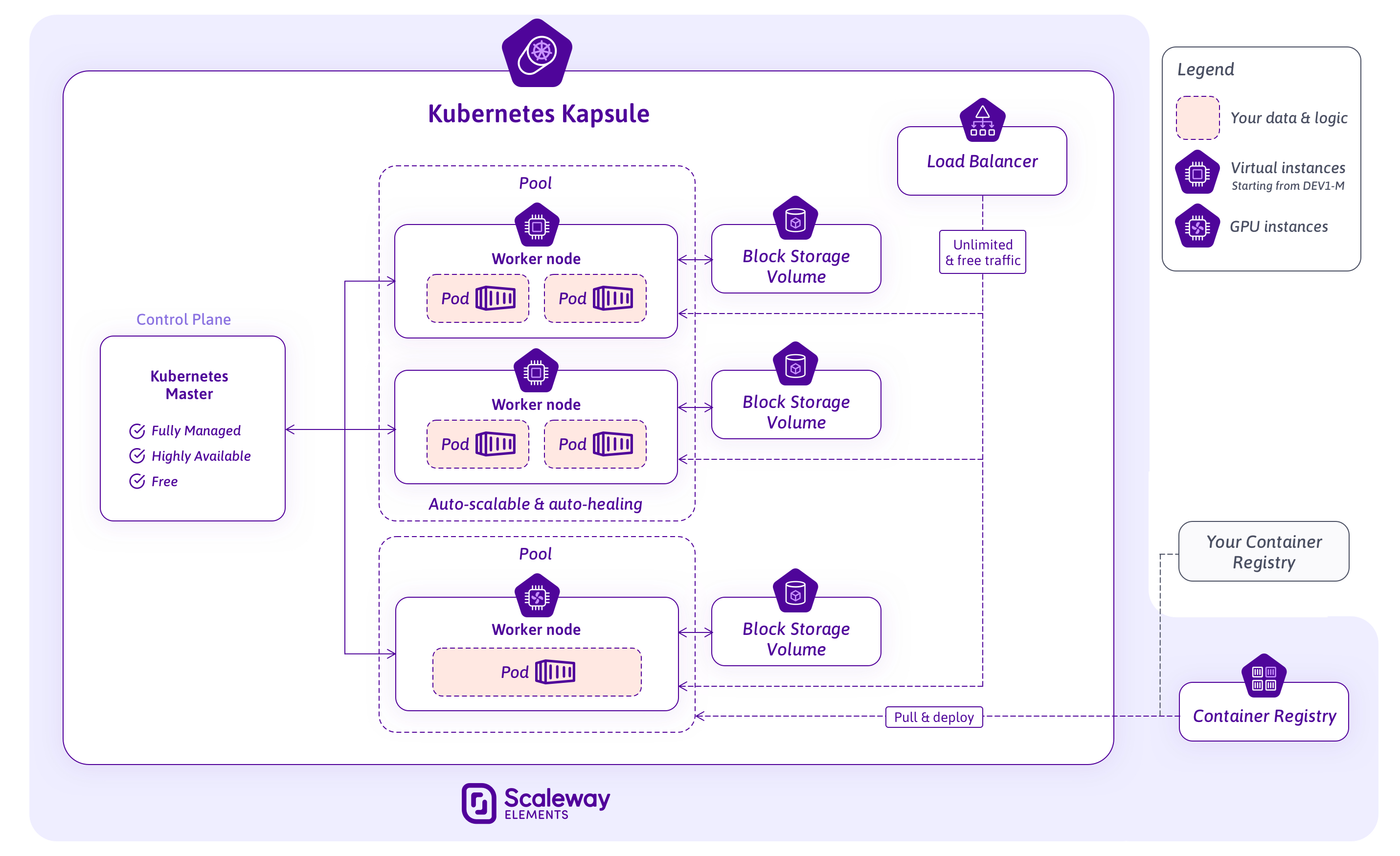

画像クレジット:Mirantis

「Mirantisのミッションは非常にシンプルです。最新のアプリを大規模に構築できる最速の手段を、企業に提供するということです」こう私に語ったのは、MirantisのCEOであるAdrian Ionel (エイドリアン・アイオネル)氏だ。「わたしたちは企業が常にアプリケーションの構築方法を、次々に最新のものにしようとしていることを知っています。私たちはそうした企業に対して、その実現をお手伝いするようなプロダクトをお届けしたいのです」。

現在、それが意味しているのは、企業が大規模なクラウドネイティブなアプリケーションを構築することを支援するということであり、それはほぼ間違いなく、そうした企業に対して、あらゆる種類のコンテナ基盤サービスを提供するという意味になる。

「しかし、私たちの頭の中では常に別のストーリーが流れています。それは、どのようにすれば、開発者をより中心に据えて焦点を当てることができるのかということです。なぜなら、過去10年間に私たちが目にしてきたように、開発者たちは自分たちが実際に使っていたサービスやインフラとは違うものへの責任を負わされるようになってきたからです」とアイオネル氏は説明した。そこにマッチしたのがKontenaとLensの買収だ。結局のところKubernetesの管理は簡単なものではない。今でも開発者はしばしば、開発したアプリケーションが企業のインフラとどのように相互作用しているのかを、管理し監視する必要に迫られる。

「Lensを使うことで、開発者はKubernetesで作業することや、Kubernetesでアプリケーションを構築ならびにデプロイすることが非常に簡単になります。LensはKubernetesの複雑さによって立ち止まった人びとのために、障害を取り除きより多くの価値を引き出す存在なのです」と彼は付け加えた。

「私たちはこのクラウドネイティブテクノロジーの世界の中に、どのようにLensを組み込むのか、そしてどのように開発者たちの仕事をより楽しくしていくのかに対して、エイドリアンとの共通のビジョンを見いだせたことに、とても興奮しています」と私に語るのは、Kontenaの元CEOで、現在はMirantisのエンジニアリングディレクターのMiska Kaipiainen(ミスカ・カイピアイネン)氏だ。

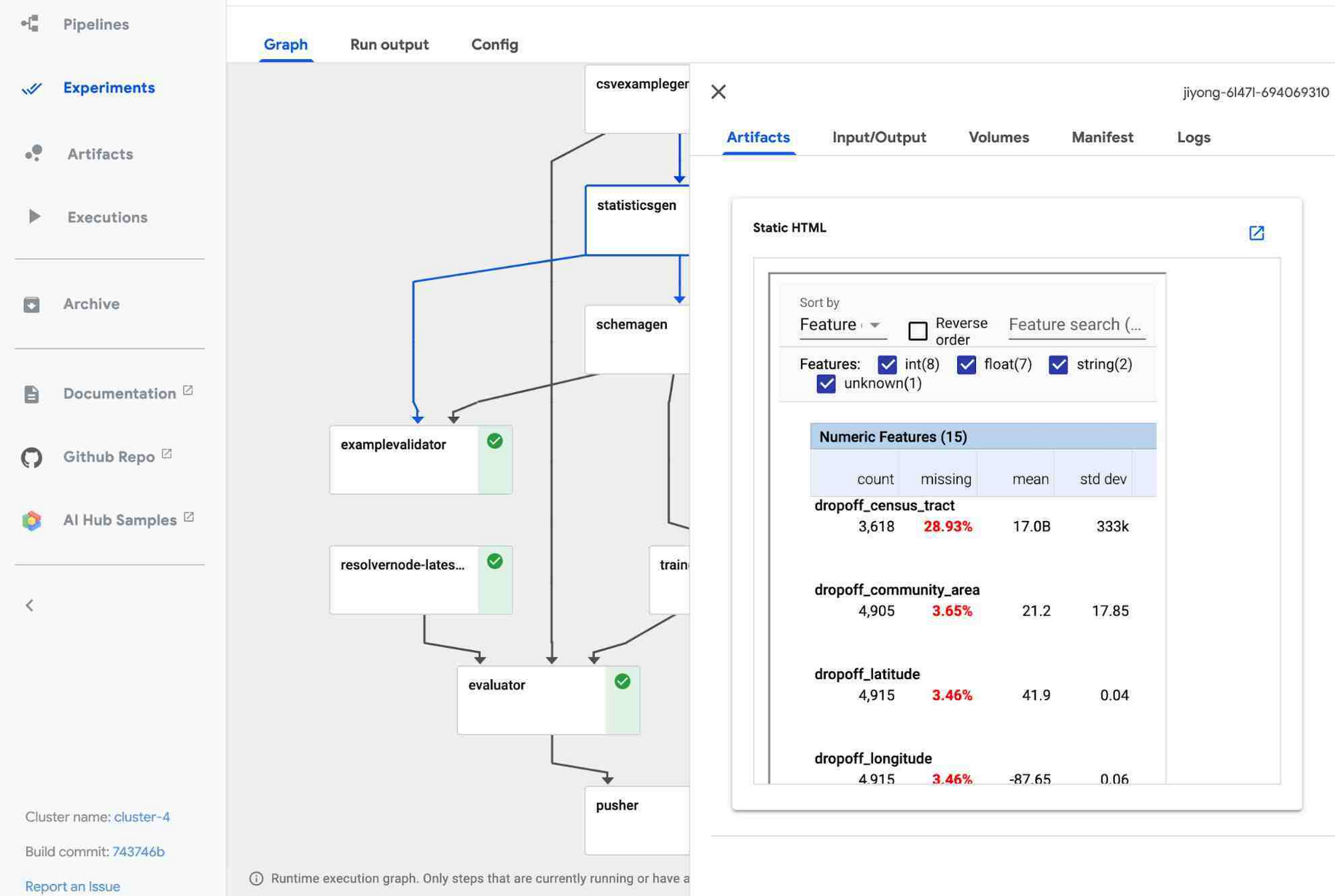

彼はLensをKubernetesためのIDEとして説明する。カイピアイネン氏は、Lensの機能を既存のツールの組み合わせで実現することは可能だが、それを行うには20もの異なるツールが必要だと主張する。「たとえば監視機能、そしてまた別にログ機能なども必要です。そしてさらにコマンドラインの設定も必要になりますし、その先もキリがありません」と彼はいう。「私たちがLensで試みてきたことは、これらすべてのテクノロジーをまとめて、単一の統一された使いやすいインターフェースで開発者に提供することです。こうすることで開発者は、集中力と彼らが取り組んでいるもののコンテキストを失うことなく、ワークロードとクラスターで作業を続けることができるようになります」。

特にLensには、コンテキストを理解して振る舞う端末機能、クラウドの種類を問わず機能するマルチクラスター管理機能、オープンソースであるPrometheusのモニタリングサービス(Prometheusサイト)などのサポートが含まれている。

MirantisにとってLensは非常に戦略的な投資であり、同社は引き続きこのサービスを開発していく予定だ。実際、アイオネル氏によれば、Lensチームの使えるリソースには基本的に制限はないという。

計画としては、カピアイネン氏は、今後数か月以内にAPIを介してLensに拡張機能を追加することを検討していると語った。「この拡張APIを使用することで、私たちはクラウドテクノロジー業界内の他のテクノロジーベンダーと実際に緊密に連携して作業できるようになります。彼らはLensのUIに直接プラグインしてそのコンポーネントかたのデータをビジュアライズすることができるようになるのです。このことでシステムはとても強力なものになるでしょう」。

アイオネル氏はまた、現在シングルユーザー製品であるLensに、より大規模なソフトウェアチーム向けの機能を追加することに、同社が取り組んでいると付け加えた。結局のところ、すでに多くのユーザーが、非常に大規模な開発チームのコンテキストですでにレンズを使用している。

コアのLensツールは引き続き無料で、オープンソースのままだが、Mirantisは、それらを管理するために必要な集中型サービスを提供する新機能に、課金することになるだろう。しかし、それがどのようなものかはまだはっきりしない。

Lensを試してみたい場合には、Windows、macOS、Linuxのバイナリをダウンロードできる。

画像クレジット: bugto / Getty Images

[原文へ]

(翻訳:sako)