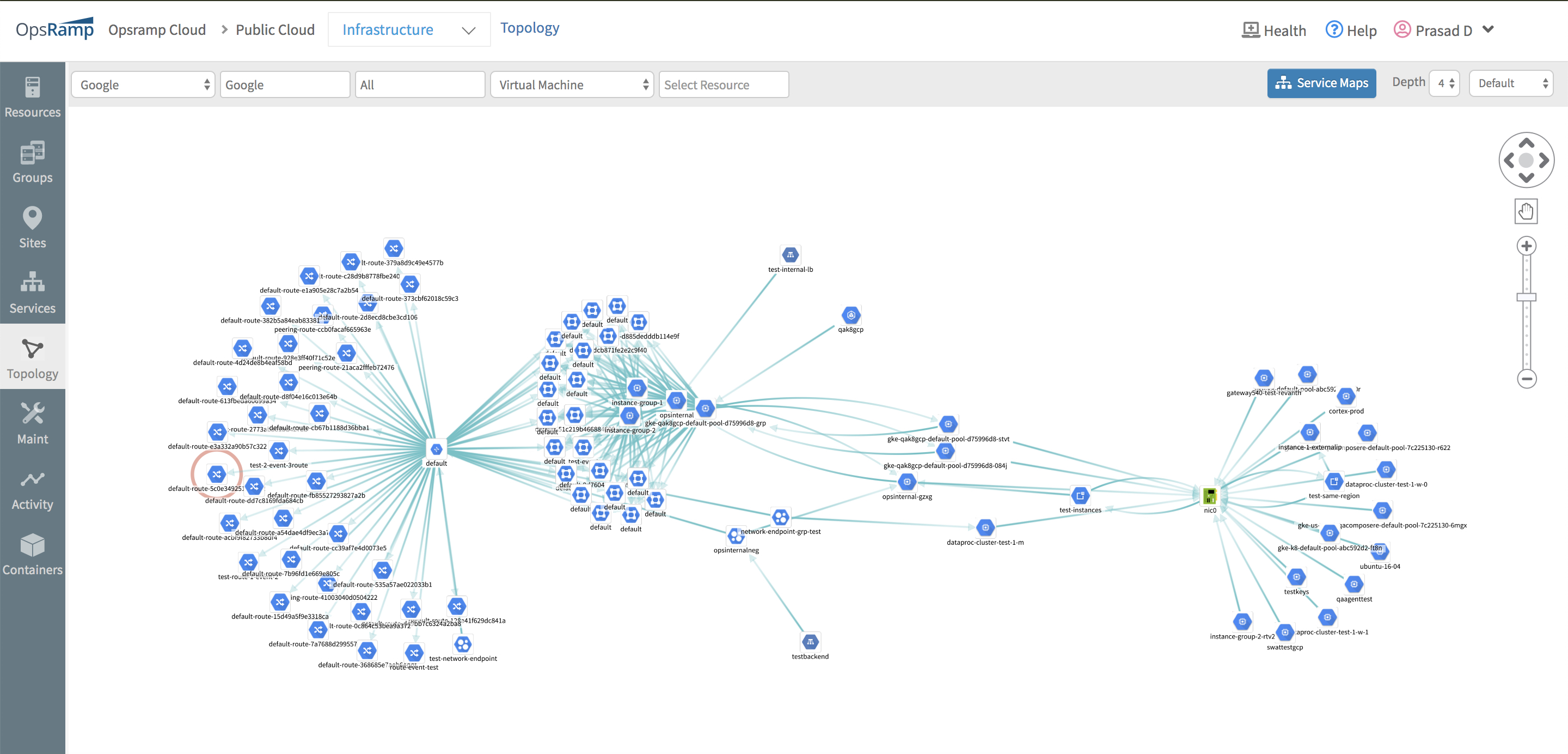

DockerとAWSは米国時間8月9日、DockerのComposeとDesktopの開発者ツール、およびAWSのElastic Container Service(ECS)とECS on AWS Fargateの深い統合を発表した。これまでComposeファイルを取り込んでECS上で実行するワークフローは、開発者にとって困難なことが多かったと両社は指摘している。今回両社はこのプロセスを簡素化し、ローカルで実行中のコンテナとECS上で実行中のコンテナの切り替えを容易にした。

「Dockerと協力して、コンテナ化されたアプリケーションの構築とAWSへのデプロイに関する開発者の経験を単純化できることに非常に興奮している」 と、AWSのCompute Services担当VPであるDeepak Singh(ディーパック・シン)氏は語った「これにより顧客は、コンテナ化されたアプリケーションをローカルのDocker環境からAmazon ECSに直接デプロイすることが容易になった。このようにアプリケーション開発とデプロイメントが迅速になることで、顧客はアプリケーションの独自の価値に集中することが可能になり、クラウドへデプロイする方法を考える時間を削減できる」。

なお意外なことにDockerは昨年、エンタープライズ事業をMirantisに売却し、クラウドネイティブの開発者体験にのみ注力していた。

DockerのCEOであるScott Johnston(スコット・ジョンストン)氏は今年、TechCrunchのRon Miller(ロン・ミラー)に対し、「11月には業務や経営幹部、直販モデルに重点を置いていたエンタープライズ事業を切り離し、Mirantisに売却した」と語った。「その時点で残りのビジネスに開発者を注力させることが、2013年と2014年におけるDockerの本当の目的だった」。

このパートナーシップによって解決されるワークフローの問題は、すでにかなり前から存在していたことを考えると、本日の動きは新しい提携の一例といえるだろう。

Dockerは最近Microsoft(マイクロソフト)と戦略的パートナーシップを結び、Dockerの開発者エクスペリエンスをAzureのContainer Instancesと統合したことも注目に値する。

[原文へ]

(翻訳:塚本直樹 Twitter)

ジャシー氏は「AQUAは求められるコンピューティングのパワーをストレージレイヤーに直接もたらす。Amazonの標準的なS3サービスの上位にキャッシュが置かれるため、必要な数のノードに必要なだけスケールできる」と説明した。

ジャシー氏は「AQUAは求められるコンピューティングのパワーをストレージレイヤーに直接もたらす。Amazonの標準的なS3サービスの上位にキャッシュが置かれるため、必要な数のノードに必要なだけスケールできる」と説明した。