クラウド・コンピューティングに意外なニュースが飛び込んできた。MicrosoftはCrayと提携し、同社のスーパーコンピューターとストレージをAzure から利用できるようにする。

Crayと聞けば、多くの読者は70年代から80年代にデザイン過剰のスーパーコンピューターを作っていた会社を思い浮かべるかもしれない(あの円筒形のタワー状本体の周囲にベンチが設置されたモデルだ)。

Crayは90年代には何度か浮沈を繰り返し、所有者も変わったが、その後、XCやCSシリーズの成功で地位を取り戻した。最新モデルはNvidia GPUとIntelのCPUを採用し標準規格のスーパーコンピューターとなっている(一部のマシンはFPGAも採用している)。単一キャビネットのピークパフォーマンスがペタフロップ級のマシンに仕上がっている。

当然ながら、こうしたマシンは非常に高価だ。Crayのターゲットは現在もハイパフォーマンスを必要とする大学や研究機関だ。最近Crayのマシンは機械学習関連の作業で使われることが多い。

そうはいっても、数分で完了するようなバッチ・ジョブ1本のためにCrayをレンタルすることはできない。そこでMicrosoftとCrayはスーパーコンピューター・システムをMicrosoftのデータセンターに設置し、ユーザーがAzureクラウドサービスを通じてCrayのマシンに容易にアクセスできるようにしようと準備中だ。同様に、今後スーパーコンピューターを必要とするかもしれないユーザーも、Azureを利用すればCrayシステムを利用できる。Microsoftの広報担当者が私に語ったところでは、「Crayマシンはそれぞれが顧客のニーズに合わせて設定をカスタマイズできるようにする」ということだ。

今日(米国時間10/23)、Azure担当のMicrosoftコーポレート・バイスプレジデント、Jason Zanderはブログに 「Microsoft Azureは数多くのエンタープライズで採用され、その能力を十分に証明してきた。ユーザー各社はわれわれのクラウド環境で戦略的にもっとも重要度の高いタスクを実行している。今回は新たにCrayと共同することにより、Azureには専用のスーパーコンピューター能力が与えられる【略】」と書いている。

実はCrayがデータセンターにマシンを設置するのはこれが2度目だ。1991年ごろからCrayはMarkleyというあまり有名でないデータセンターに設置されている。Markleyはアメリカとヨーロッパでトータルで27万平方メートルにもなるデータセンターを運用している。

画像: Yiming Chen/Getty Images

〔日本版〕トップ画像はCrayfish(ザリガニ)とCrayをかけたもの。

[原文へ]

(翻訳:滑川海彦@Facebook Google+)

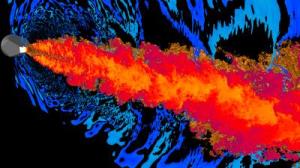

スタンフォードの研究チームが、スーパーコンピュータの利用について新たな地平を切り拓いた。利用したスーパーコンピュータはローレンスリバモア国立研究所のSequiaだ。研究チームはこのスーパーコンピュータを使ってリアルタイムでの乱流シミュレーションを行なってきた。Sequoiaは最速のマシンというわけではないが、100万コアを同時に利用して計算を行うことができるのだ。

スタンフォードの研究チームが、スーパーコンピュータの利用について新たな地平を切り拓いた。利用したスーパーコンピュータはローレンスリバモア国立研究所のSequiaだ。研究チームはこのスーパーコンピュータを使ってリアルタイムでの乱流シミュレーションを行なってきた。Sequoiaは最速のマシンというわけではないが、100万コアを同時に利用して計算を行うことができるのだ。