新モデルは魅力的だが、すでに所有している人にとってはそうでもない

過去18カ月間、iPad Proは私の自宅から持ち出した唯一のマシンである。私は最近まで世界中で開かれるイベントに参加するため、またサンフランシスコ、ニューヨーク、ロンドンにある当社のオフィスを訪れるため、自宅を離れて何度も国内外を移動した。自宅のデスクにいないときは、常にiPad Proが私のメインのポータブルマシンであった。

乗り換えたのは、カンファレンスとStartup Battlefieldコンテストへ参加するためにブラジルへ旅行した時だった。それはほんの気まぐれだった(話は逸れるが、そのコンテストが最高だったのは、コンピュータービジョンによる牛の体重測定が優勝したことだ)。この1週間の旅行において、iPad Proが仕事用デバイスとして機能するかどうか実際に使って確かめたかった。その後、また信頼のおける13インチMacBook Proに戻ると思っていた。

ところがこの旅でTechCrunchの運営をタブレットからできるかという点において、私の考え方はすっかり変わってしまった。軽くてスムーズに手早く簡単に仕事ができ、いたるところで私のMacBookよりも進んでいることがわかったのだ。私はもう元には戻れなくなってしまった。

iPad Pro、2018年、ブラジル

初めのうち、iPadと私の双方にとって悩みの種が尽きなかった。その時点では共有シート、自動化ツール、新しく導入されたショートカットなどをつなぎ合わせてワークフローを再構築したことが、実用的な作業用マシンとして生まれ変わらせるのに大きな役割を果たした。また、Slide Over(スライドオーバー)、Split View(スプリットビュー)、ホーム画面などを刷新したiPadOSに伴う変更は、デバイスをより柔軟に感じられるものであり、歓迎すべきものであった。

過去の1年半もの間、iPad Proの絶対的な目玉機能について多くのことを学ぶことができた。その一方で、ラップトップよりも軽くて高速なマシンを持ち運ぶことで、得られるものと失うもののトレードオフについて知ることができた。

新しいマシンで過ごした1週間のうちにこれらはすべて整えた。

この新しい2020年のiPad Proは、2019年に発売されたモデルと大部分においてほとんど同じに見える。正方形のカメラアレイ以外は、ほとんどそっくりだといっても過言ではない。その中でも良いニュースは、初めてApple(アップル)がID認証を行って2年経った今でも超サクサクと未来的な感じがすることだ。まさにコンピューターの理想的なかたちである。軽くて、手に持てる大きさで、強力で、機能的なのだ。

私がテストした12.9インチのiPad Proには、私が今まで使用していたモデルとほぼ同じレベルで動作する新しいA12Zチップが搭載されている。Geekbench 4では、5015超のシングルコアと1万8000超のマルチコアスコアを記録した。クラスに関係なく、所有可能で最も強力なポータブルコンピューターの1つであることに変わりはない。1TBモデルには引き続き6GBのメモリーが搭載されているようだが、それより下のモデルでは4GBなのかもしれず、詳細は不明だ。

このバージョンには追加のGPUと「強化されたサーマルアーキテクチャ」が追加された。負荷がかかった状態では熱分散に優れているかもしれないが、iPad Proはめったに熱くならないので、私にとってはよくわからなかった。私は分解した結果が気になった。おそらく新しい排気口、配線、部品などが配置されているのだろう。もしくは何らかの回路かもしれない。

当然のことであるが、このプロセッサーが(少なくともCPUレベルでは)A12X Bionicチップに非常に近い性能を持つことは興味深い。GPUにおいても、AppleはA12Xよりも高速だというのみで、いつものように具体な倍数について言及していなかった。

このことからわかるのは、これがiPad Proを本当に「リフレッシュ」したものだということだ。新しい機能を次に紹介するが、全体的に見るとこれはある意味で「新しいモノ」であり、めったにあるものではない。ただし、ときにはアップルデバイスの真実ともいえる機能だ。ご覧いただくのは、ハードウェアの設計や実装を大幅に見直しなくても、現在ハードウェアから学び、実行できることばかりだということだ。

私がここで注意するとするなら、A12Xがいまだに非常に早く、それほどパワーが欲しいと思ったことがないことであろう。私は使いやすさを犠牲にして、スピードアップを図ることにずっと反対してきた。だからこそ今はその議論を重ねるときであるし、うまく機能しているものに不満をいうべきではないと思っている。

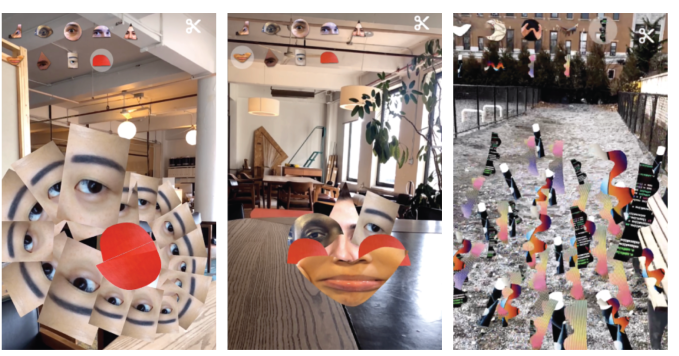

カメラとAR

新しいiPad Proで最も大きく変わったところは、もちろんカメラアレイだ。1000万画素の超広角と1200万画素の広角の2つを備えている。これらの機能は仕様どおりであるが、最も興味深いのは新しいLiDARスキャナの追加である。

これによって我々は、世界を一度に何層もの奥行きをもって体感できるようになるのは間違いない。我々が認識している物理的な層は、レッドウッドの年輪のようなデータの輪によって増強される。

実際のところ、その未来は我々にも到来している。たとえそれを気付いているかどうかが問題ではない。これらの層の存在を要求することにより、今すぐそのほとんどを非同期で体験することができる。どこに行くべきか伝えるために、データオーバレイが必要だって?ターンバイターンで地図を呼び出してみよう。言葉や天候の定義を知りたいって?ボイスアシスタントに聞いてみよう。

ただし、これを超えた次の時代は、受動的なコンテクストに応じた情報レイヤーが視覚的かつ聴覚的に、積極的に提示される時代なのだ。

我々はこれを拡張現実とかMR(複合現実)などと呼んでいるが、どちらも最終的にどうなるかを明らかに説明しているわけではない。拡張ヒューマンエクスペリエンスはスマートフォンから始まったが、スクリーンから透明なディスプレイ、レンズ、義眼、脳幹の結合までをチェーンでつなぐかのように、ゆっくりと小脳に近づいている。

あなたがこの現実を受け入れられなくても、私は責めはしない。ただ、私が正しくないという意味でもない。この記事をブックマークして、2030年に議論しようではないか。

ただし、短期的にはARテクノロジーの発達は主にスマートフォンのエクスペリエンスによって前進することになるだろう。そしてそれらはGoogle(グーグル)とアップルによって急速に発展している。ARをアプリやデバイスに合うハードウェアに組み込むように開発者にフレームワークを提供しているのだ。

AR体験を非常に現実的なものにするための最大のハードルはオクルージョンだ。これはあるオブジェクトが別のオブジェクトと現実的に交差することを可能にするエフェクト。「これはそれより後ろにある」と脳に伝えるためにオブジェクトを不明瞭にしたり、隠したりする。オクルージョンは共有されたエクスペリエンス、リアルな世界とデジタルな世界の相互作用、一般的な信憑性といった面白さにつながる。

これこそがiPad ProのLiDARの見せ場でもある。LiDARを使用すると、ARアプリケーションで2つの大きな前進が可能になる。

- 初期化の時間はほぼ一瞬:LiDARは光の速さで動作するため、放った光のパルスを読み取り、その「飛行」時間を測定することで対象物または環境の形を判定する。これはとても速い。典型的な「アプリを開いて、端末をかざして周りを見渡すが、使えるかどうかは運次第」といったAR特有のユーザーエクスペリエンスの悪さは、LiDARによって理論的に取り除くことができる。

- オクルージョンは自動:オブジェクトの形や相互関係を「推測」するためにカメラ、小さな手の動き、コンピュータービジョンを使用して計算を行う必要がなくなった。開発者は基本的にこれを無料で、しかも驚きの速さで手に入れることができる。LiDARがたくさんの自動運転自動車システムや半自動運転システムに使われていることには理由がある。高速で比較的信頼性が高く、強力なマッピングツールだからだ。

ARKit 3.5には、平面と表面を検出することにより、環境の完全なトロポジカル3Dメッシュを作成する機能がある。しかも、シンプルなカメラファーストのアプローチよりも高い精度で提供されているのだ。

残念ながら、私はこのシステムをテストすることができなかった。Appleによると、多くはHot LavaのようなゲームからIKEAのような家具販売用アプリへと移行しつつあるとのことだが、それを活用したアプリケーションはまだないとのことだ。2020年か遅くとも次のiPhoneに搭載される可能性が高いため、この追加機能がどれほどiPadに効果的であるのか私は興味がある。

唯一、iPad Proの背面カメラがポートレート写真を撮れないことには驚いたが、大きなショックは受けなかった。フロントカメラのTrueDepthだけが、このポートレートモードを搭載している。

iPad Proには、はるかに正確なポートレートモードが搭載される予定であり、LiDARアレイとカメラを利用するが、まだ準備ができていないようだ。アップルがテーマと背景との関係を理解しているにもかかわらず、ポートレートスタイルの撮影を実行できないようにする理由はない。

LiDARは非常に有望で、たくさんの将来性のあるアプリを生み出すテクノロジーだ。デバイスに外部の世界を取り込むためのより正確な方法があれば、そのうちAppleと開発者にいろいろなチャンスが広がるであろう。しかし、私はそれが一気に広がるのではなく、今後数年にわたって徐々に行われることになると考えている。

TrueDepthカメラの位置が変更されていないことには失望した。iPad Proのデザインに関してアップルが選択したものの中で、カメラを横向きモードのときに手で覆われる場所に配置したのは実にもったいない。

私がiPad Proをポータブルマシンとして使ってきた間、ポートレートモードにしたことはほんの数回しかない。たいていはアプリが単に横向きに対応していなかったからだ。

このデバイスは横向きが前提であり、カメラにもそれを反映すべきだ。5月に出荷される「フローティング」デザインの新しいMagic Keyboardは、カメラを浮き上がらせて手元から離すことができるようになり、私はそれによってかなり使い勝手は良くなるのではないかと思っている。

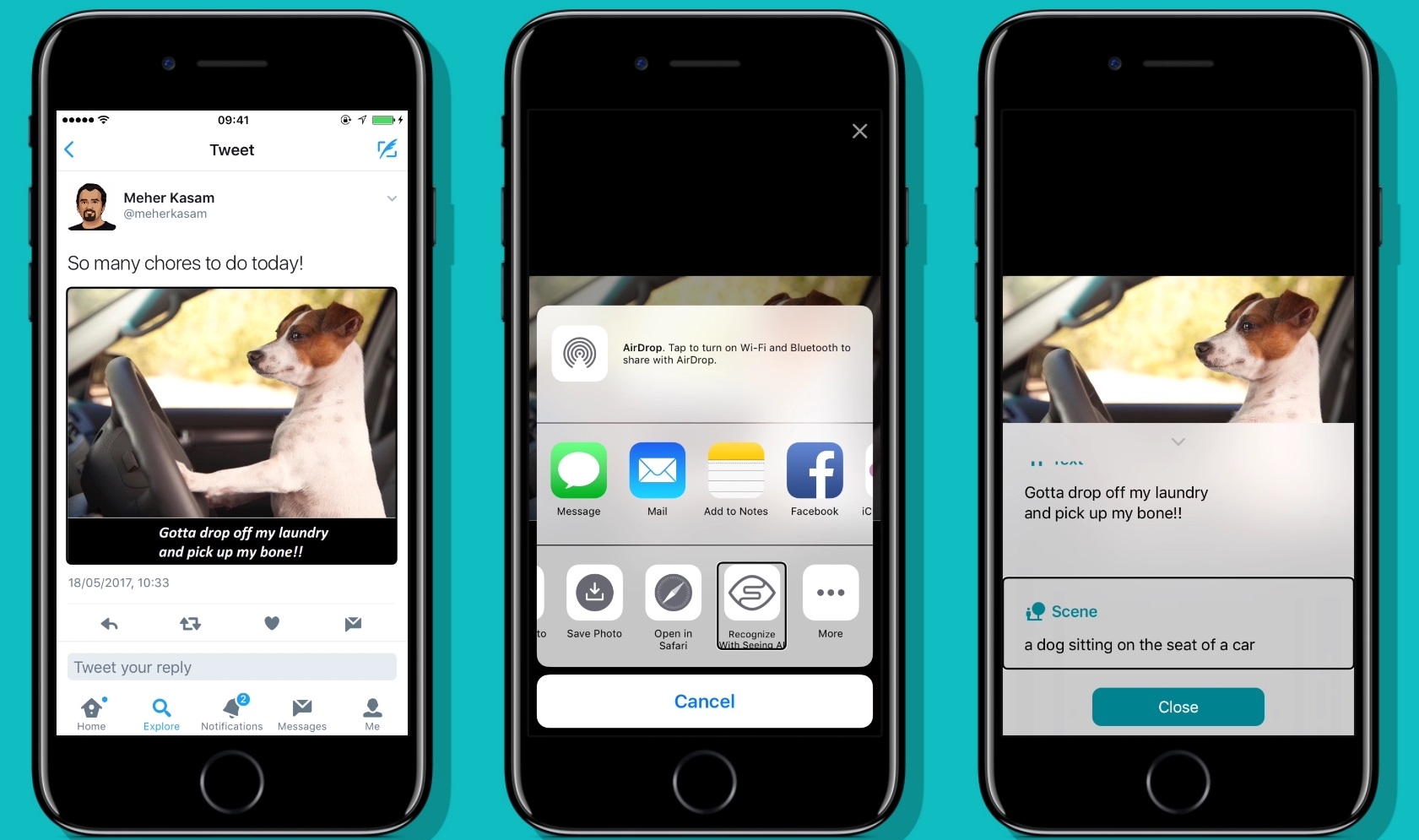

キーボードとトラックパッドに対応

マウスとトラックパッドへの対応については、現時点でもかなりの人がいくつかの意見を述べている。一般的に反応は非常に好意的であり、私もその評価に同意する。アップルがボタンやアクションをカーソルに合わせる際にどれほど柔軟性があるかにはやや疑問があるのだが、全体的な効果としては信じられないほど快適で便利である。

カーソルを鋭い矢印や手のアイコンではなく、順応性のあるオブジェクトで再現したことは、タッチ環境において大いに納得できる。我々は、自分の指が鉛筆や消しゴム、ときにはボタンを押す道具として必要なツールになることに慣れている。iPadのカーソルも状況に応じて認識されるのだが、それは理にかなっている。

いまのところはMagic Trackpadしか使えないのだが、Magic Keyboardが発売されたときには、これが通常の作業フローになってくれることを期待している。

そしてキーボードのデザインについては、以前よりもはるかに高い位置にあるスクリーンを、キーボードを使いながら指で突かずに済むのは素晴らしいことだ。

Surfaceとの比較

iPad Proにトラックパッドが追加されたことで、「結局のところSurfaceは正しかったのでは?」という直感が正しかったことが証明されたようだ。今となってはほとんど毎日iPadを触っているので、私はこのことについてある時期から2、3年は考えていたことである。

この議論については2018年に評価をしたことがあるので、ここでは端的にそれを引用させていただこう。

関連記事:iPad Proレビュー:Appleの新しいタブレットは、成熟の予兆を見せ始めた

簡単にまとめると、Microsoft(マイクロソフト)はラップトップのタブレット化に、アップルはタブレットのラップトップ化に取り組んでいて、他はよくわからないことをしようとしている。

まずはOSを切り離し、先にタブレットを開発してから元に戻る必要がある。そのことをマイクロソフトは理解することができないでいる。マイクロソフトは以前のマイクロソフトよりもはるかに有能だと思うが、しかしそれは他で議論すべき問題である。

アップルはOS Xをかなり早いタイミングで切り離し、それ以来、別の方向にゆっくり向かっている。しかし、Surface ProがiPadと同じくらい満足できるレベルのタブレット体験を提供してくれたことはない。

たしかにSurfaceのほうがより柔軟性があるかもしれない。しかし、それは統一感と確かな機能性の犠牲の上で成り立っている。それは冷蔵庫やトースターでも同じである。

今でも私はそう思っている。

基本的に、iPadがSurfaceのすぐそこまで追いついていると考えるようになった。なぜならiPadはハードウェアに焦点を当てているのでアプローチが広い。そしてWindowsはタッチ操作向けに適切に調整されたことはない。アップルは先にタッチ操作に合わせており、その後でカーソルのサポートを追加した。

前述したことを繰り返すが、私はここで「Surfaceのアプローチが悪い」と言っているわけではないので、その点は信じて読み進めていただきたい。業界のほぼ全体が別の方向に向かっていたときに、SurfaceのチームがコンバーチブルPCに最大限尽力していたことは、非常に賞賛すべきことだと思う。しかし、iPadが「Surface」化するという意見には絶対に同意しない。なぜならSurfaceのタッチエクスペリエンスはタブレットの中でも最悪であり、iPadのそれは(インターフェイスの欠点も含めて)間違いなく最高だからだ。

これは最近のコンピューターデザインにおいて、異なる両端から同様の問題を解決しようとする明確な例の1つである。

ただし、iPad Proを数年間使用して、何も問題がなかったというわけではない。

iPadへの期待

2020年の1月のこと、アップルに関するライター兼評論家のJohn Gruber(ジョン・グルーバー)は、iPadがその潜在能力を完全に引き出されていない理由について詳しく解説した。アップルがソフトウェアのマルチタスクの部分で失敗したというのが大筋の結論だった。その当時、ジョンや他の追随する人たちから良い指摘をされていたように思う。私にも意見があったが、思いを表明するまでには至っていなかった。しかし、今なら言える。私の意見は次のとおりだ。

iPad Proは、使いやすさよりもスピードと能力に焦点を合わせているに違いない。

MacBookやラップトップを1日か2日、もしくは10日間も置いたままにしたことがなかったか思い出してみてほしい。開けてみたら一体どうなっただろうか? アラート、通知、アップデート、メッセージの数々がお出迎えしてくれたのでは? マシンから離れていた時間の長短に関係なく、開いてすぐに作業を開始できただろうか?

iPad Proなら、どこにいても何をしていてもパカッと開いて上方向にスワイプすれば、数秒以内に最初の指示を出すことができる。めまぐるしい業界で、荒々しいビジネスをしている私たちにとって、その確かな動作は文字どおりプライスレスだ。

一方で、私が使いやすさを望んだことは一度もない。

あなたはハンマーがもっと使いやすかったらなどと思ったことはあるだろうか?そんなことはないだろう。正しく持ち、正確に打つことを覚えるだけだ。iPadの場合はもっと複雑なことにも利用できる。

現在、iPadOSは批判を許されないレベルにまでシンプルさが高められている。皮肉なことに、iPadソフトウェアチームに代わって物事をシンプル(同じアイコン、同じグリッド、同じアプリスイッチングパラダイム)に維持し、元の意図に忠実にであろうとする努力が、打って変わって一種の複雑さをもたらした。

iPad Proのマルチタスクシステムを取り巻く問題のほとんどは、プロフェッショナルのユーザーに対してアプリやワークスペースを不変に固定する方法を提供することで解決することができると思う。つまり、何年にもわたってiPadの役割であった自分のワークスペースを所有しているようなマルチタスクの方法論を「ぶち破る」能力をユーザーに提供すればいいのだ。ドックを完全に捨て去り、タップで移動できる固定されたスペースのリストを作成しよう。アプリアイコンを保護するステータスをなくし、そのスペースでまさに起こっていることを反映させよう。

これらはひどいアイデアかもしれないが、私の議論の核心はしっかりしている。タッチインターフェイスは70年代に初めて登場した。そして少なくともここ十数年間は非常に人気だ。

今日のiPad Proユーザーはタッチベースのインターフェイスには慣れており、タッチインターフェイスのないコンピューティングライフを知らない可能性が高まっている。

信じられないのなら、子供たちが6つの異なるアプリを操って、簡単なミームやメッセージをまとめて友達に送る様子を観察してみて欲しいい。子供たちはそれを1日に数十回も行うような名人なのだ。こういったユーザーはまさにタッチネイティブである。肉の味を知ってしまった子どもたちは、もうミルクを飲めなくなってしまっているのだ。

このデバイスは依然として絶賛せずにはいられない。とにかく、私が2018年に挙げた理由すべてにおいて、現在でも同じように強く感じている。しかしこれまでのところ、2018年のiPad Proから最新モデルにアップグレードする理由はほとんど見当たらない。Magic Keyboardに下位互換があることを考慮しても、結論は変わらないであろう。

現在iPad Proを所有しておらず、仕事に使えるか悩んでいる人には、可能だと私は答えるし、実際に私はそうしているとお伝えしよう。複雑で多面的な論説、イベント、サブスクリプションビジネスの編集面を管理しながら、さまざまな大陸やタイムゾーンで働く30人もの従業員と話している。

iPad Proとともに(飛行機で)16万kmを移動したが、一度も不具合を起こすことがなかった。バッテリーは常に十分であった。スピードは常に一定だ。キーボードは素晴らしいだけではなく、液体をこぼしても大丈夫で、さらに耐衝撃性能を備える。私がこれまで所有していたどのラップトップにも当てはまるものではない。アップル製品であったとしてもしかりである。

統合されたトラックパッドの将来性とiPadの存在理由のレベルアップにより、Magic Keyboardと新しいiPad Proは、現在の市場に出回っている中で最も魅力的なパッケージの1つになっている。

私はMacBook Airが大好きで、いくつかのモデルを壊れるまで何年も使用したことがある。現在、自分の仕事のスタイルを考えるとラップトップに戻るという選択肢はありえない。高速で信頼性が強く、強力だからだ。

タイピング、スワイプ、スケッチで入力することができ、地球上のあらゆる主要なビジネスソフトウェアを強力にサポートするマルチモードマシンを所有しているというのは尋常ではない。常によく動き、高速で、まるでイタリアのレーシングカーのように組み立てられているマシンだ。

誰が反論できるだろうか?

[原文へ]

(翻訳:Dragonfly)