先ほど開幕したWWDC19でApple(アップル)は、iOS 13のプレビューを紹介した。製品版はこの秋に一般公開される。

ダークモード始め、大小さまざまなアップデートが発表された。ソフトウェアエンジニアリング担当副社長のクレイグ・フェデリギ氏は「iOS 13には多数の新しい機能が追加され、非常に大規模なアップデートになる」と述べた。

フェデリギ氏はこれに続いて、パフォーマンスの改善の詳細を説明した。Face IDは30%速くなる。App Storeからの新規ダウンロードはサイズが小さくなる。しかもiPhoneはアップデートのたびに全体をダウンロードするのではなく、必要な部分だけ取得するので、サイズは平均60%も小さくなるという。アプリのローンチまでの時間は半分に短縮されるなどなど。

ダークモードとシステムレベルの改善

すでの多数のアプリがダークモードを採用している。しかし今回アップルは、iOS 13ではダークモードがシステムレベルで実装されることを明かした。コントロールセンターからワンタッチでUIをダークモードに設定できる。音楽、カレンダー、メッセージなどネイティブアプリはすでにダークモードをサポートするようアップデートされている。

通知、ウィジェットの外観が変わり、全体として暗めのデザインになった。アプリを開くと背景は純粋黒になる。OLEDモニターはまったく光を発しないようにできるので黒がすっきり締まって見える。

ネイティブキーボードは、キーからキーへスワイプして入力できるようになった。共有をコントロールするシェアシートのデザインがアップデートされ、ユーザーの活動履歴をベースに最適と思われる連絡相手がシェアの候補に表示される。音楽アプリではスクロールして歌詞を表示できるようになった。

純正アプリのアップデート

アップル自身が提供するアプリについてだが、Safariにはウェブサイトごとにテキストサイズを設定できるオプションが加わった。メールもリッチテキストが利用できる。メモ(Notes)にはギャラリー表示とフォルダーが加わった。

リマインダーもまったく新しいデザインになった。タスクを追加するためのクイックタイプバーが新設された。タスクをネストさせて下位のタスクをインデントできる。連絡相手をタグ付けすると、iMessageで通知が行く。

アップルのメグ・フロスト氏は、新しいマップをデモした。地図データが改良されたのはもちろんだが、アップルの地図にGoogleのストリートビューに似たLook Aroundという機能が追加された。同機能による地点間の移動は驚くほどスムーズだ。

このほか、マップには友だちとの待ち合わせの予定到着時間(ETA)を表示する、お気に入りの場所を記録する、リストを友だちと共有するなどの機能も追加された。

米国については、年末までにアップル独自の地図データが利用できるようになるという。他の国では来年以降になる。

プライバシー強化

アップルは位置情報の取扱を厳格化するアップデートを行う。ユーザーはワンタッチでロケーション情報の共有設定ができるようになる。

これによりサードパーティーのデベロッパーはユーザーが利用しているWi-FiやBluetoothについての情報を得られるなる。こうした情報からユーザーの位置がリークされるというスキャンダルの防止に役立つはずだ。

アップルはまた「Facebookでログイン」に対抗して「アップルでログイン」というという機能を追加する。ユーザーは個人情報を明かす心配なしに新しいアカウントを作成できる。またアカウントがメールアドレスを必要とする場合、ランダムな文字列によるアドレスを生成し、アカウントへのメールを受信することができる。メールは本当のアドレスに自動的に転送される。

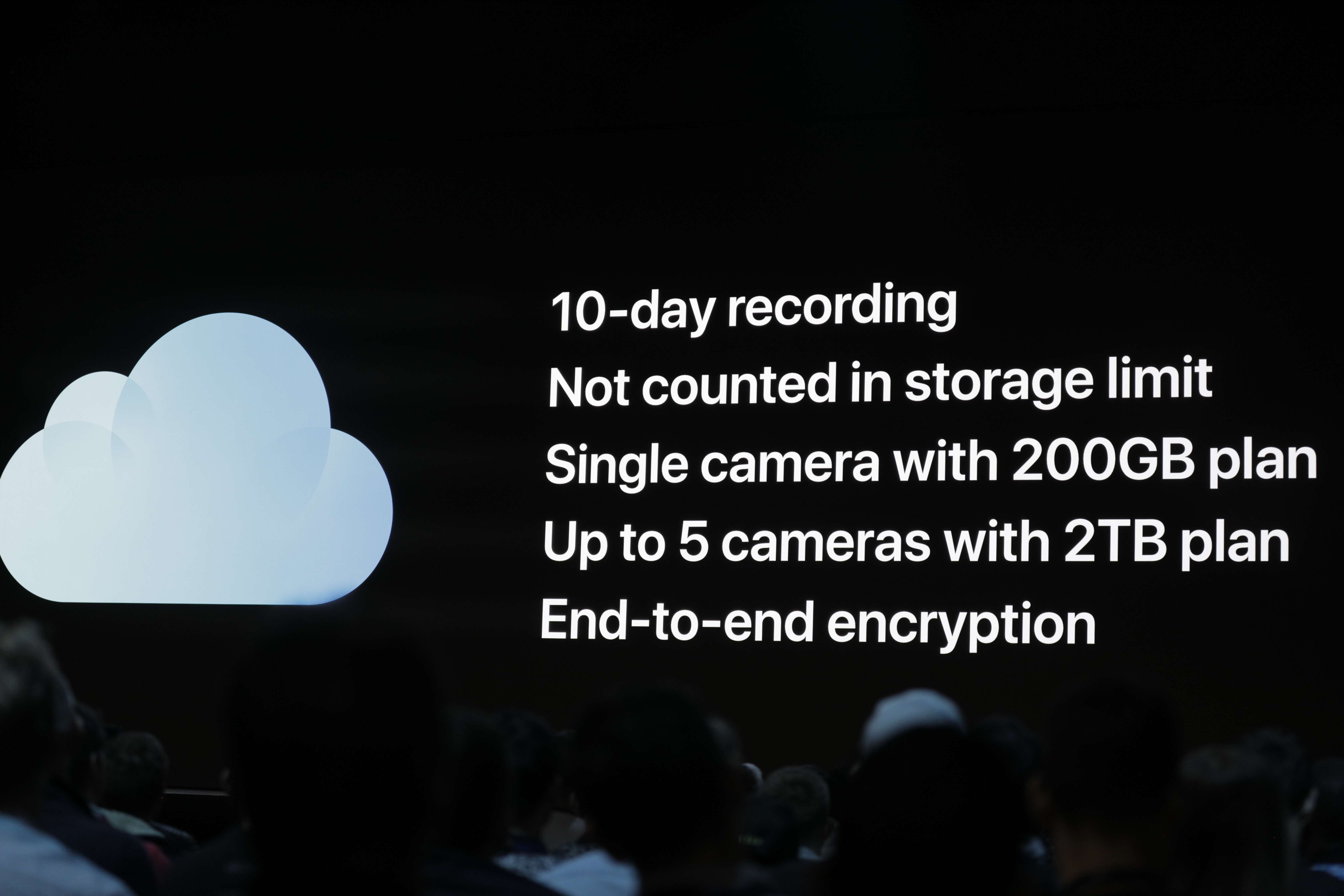

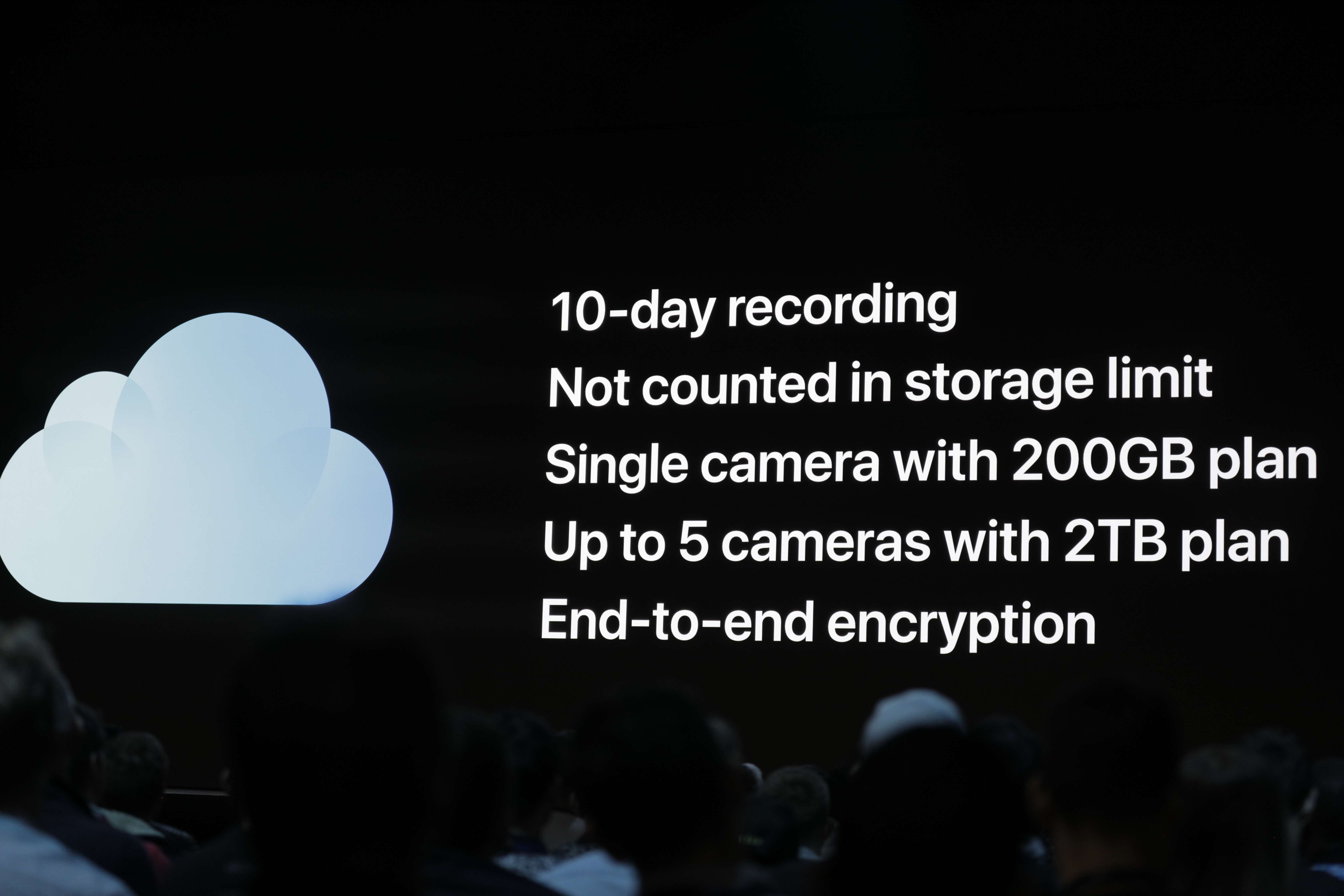

スマートホーム関係ではHomeKitのプライバシーも強化された。セキュリティカメラの映像10日ぶんをiCloudのHomeKit Secure

Videoに保存できるようになった。再生するためのキーはアップル自身ももっていない。またセキュリティカメラのデータはiCoudの容量にカウントされない。Logitech、Netatmo他の有力メーカーは今後、新しいHomeKitをサポートするという。

HomeKitデバイスのセキュリティをさらに強化するため、アップルはHomeKitにルーターを経由させる機能を加えた。これを利用すればHomeKitデバイスはファイアウォールで切り離され、インターネットに直接アクセスできなくなる。

iMessageがさらにパーソナルに

iMessageにはどうしても強化版のSMSというイメージがつきまとっていた。iOS 13ではもっとWhatsApp的になる。ユーザーはプロフィール画像を登録し、選択した連絡相手に表示できるようになる。

アップルはこの機会に、人の顔のアニ文字、ミー文字のカスタマイズ機能も強化した。ミー文字をオリジナル絵文字のビット文字やスタンプに利用することもできるようになる。

写真

写真まわりではアップルはポートレートに新しい照明効果を追加した。ポートレートモードでの撮影がプロフェッショナルなレベルまでカスタマイズできるようになる。

カメラアプリにはサチュレーション、ハイライト、シャドウなどをコントロールするボタンが追加された。これらの機能は静止画だけでなく動画でも利用できる。ビデオが回転できるのはInstagramのユーザーには朗報だ。

写真ライブラリの管理では、iOSは同一写真を自動的に検出し、最もよく撮れている写真を選んでくれる。写真ライブラリをナビゲートするための新しいタブも追加された。写真のブラウズはよりスムーズになり、ビデオは周囲が暗く表示される。新しいタブバーで年、月、日ごとにハイライトを見ることができる。

Siriもさらに賢くなった

AppleはSiriの音声機能を強化した。例えば、AirPodsを装着しているときにメッセージを受信するとSiriはそれを読み上げる。ユーザーは音声で返信ができる。

iPhoneとAirPodsを持っている友だちと音楽を共有することもできる。具体的には、1台のiOSデバイスから2台のAirPodsに音楽をストリーミングできる。

スマートスピーカーのHomePodに関してはiPhoneをタップしてHomePodに音楽を送れるようになった。またインターネットラジオをライブで再生できるようになったというのだが、これは正直、今までできなかったことを知って驚いている。また、マルチユーザーでの利用が可能になり、カレンダー、メッセージなどをユーザーごとに呼び出せるようになった。

CarPlayもアップデートされ、Siriの新機能が利用できる。ユーザーは車内で音声でPandoraの音楽やカーナビのWazeをコントロールできる。SiriにアニメがCarPlayのスクリーンを占領してしまうこともなくなった。

iOS 13ではSiriのショートカットアプリが標準でインストールされる。ユーザーは簡単な操作でSiriの音声ショートカットを設定でき、ひと言で複雑な動作を行わせることができる。またお勧めのショートカットの候補も推薦される。Siriの音声も改良され、自然さがアップした。

これ以外にもiOS 13には多数の新機能が登場する。特にiPad独自の機能が拡充され、iPadOSという独自の名称となった。詳しくはこちらの記事を参照。

[原文へ]

(翻訳:滑川海彦@Facebook)