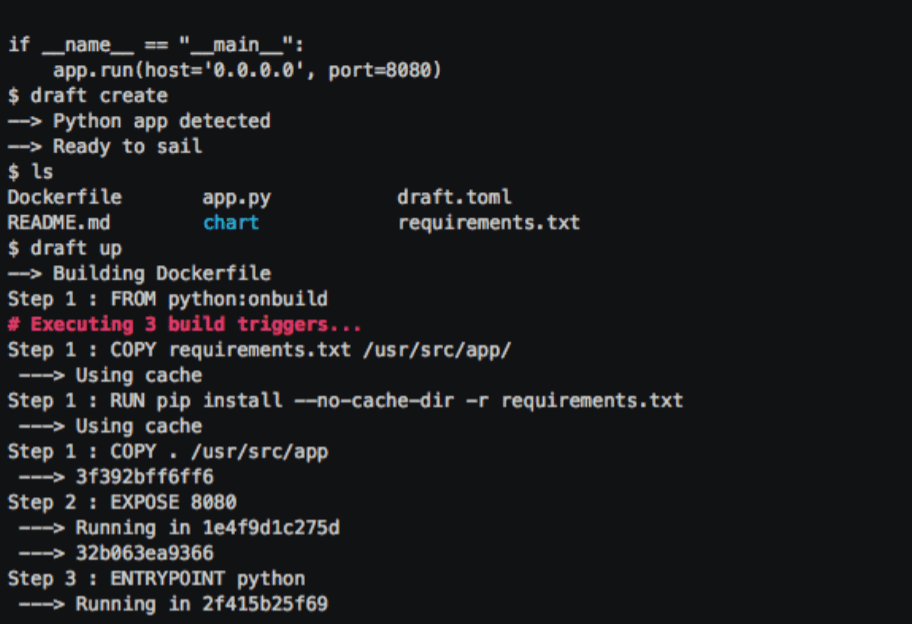

Driverless AIはH2O.aiの最新のプロダクトで、企業におけるデータサイエンスの活用の、敷居を低くすることをねらっている。このツールは、非技術系の社員たちを助けて、データの準備、パラメータの調整、当面の問題に対する最適アルゴリズムの判断などのタスクを、機械学習を利用して行う。

機械学習で解こうとする問題は、研究者のレベルでは複雑で予測不可能なものが多い。前例のないユースケースでGANや強化学習などの新しい技法を使っていくためには、高い技術力が必要だ。しかし企業が機械学習を使っていく場合は、比較的予測可能な問題が多い。たとえばサポートベクターマシンを使ってデフォルト率を評価する、など。

でも、そんな比較的簡単な問題でも、非技術系の社員の手には負えないことがある。企業は営業や人事など、データ分析とは無縁だった分野でも、最近ますますデータサイエンスを利用しようとしているが、そのために彼らを再教育するのはコスト的にたいへんすぎる。

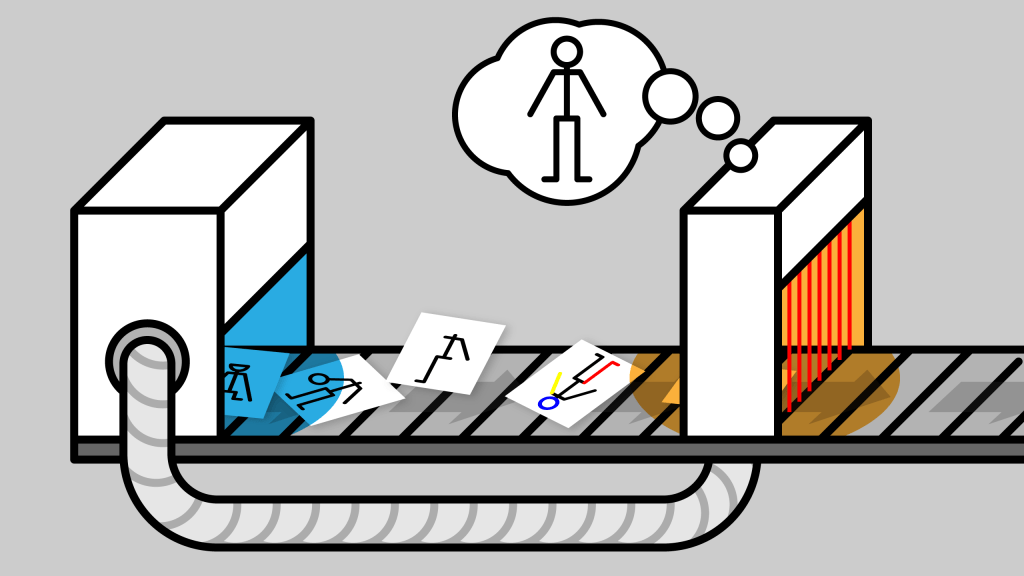

H2O.aiのプロダクトはどれもAIを使いやすくしてくれるが、でもDriverless AI(運転者不要のAI)はさらに一歩進んで、モデルを準備するときに必要な難しい決定の多くを自動化する。Driverless AIは、feature engineering(特徴量工学、特徴量の選択・作成・変換)を自動化する。特徴量とは、いろんな変数/変量がある中で、モデルの構築に利用すべき重要な変数変量のことだ。

Driverless AIにはよく使われるユースケースが組み込まれているが、どんな機械学習の問題でも解ける。うまくいけば標準的なモデルを見つけて十分にチューニングし、そのロングテールの少なくとも一部を自動化する。

同社は1月にDeep Waterをローンチしたとき、今日のリリースを暗示した。Deep Waterは、ディープラーニングとGPUを一般ユーザーが利用するためのプラットホームだ。

機械学習による自動化は、まだまだ初期的段階だ。GoogleのCEO Sundar Pichai は今年のI/Oカンファレンスで、試行錯誤と大量の計算処理で機械学習の問題を解くための、最良のモデルと特徴を自動的に選び出すAIツールを作っていると述べて、会場をどよめかせた。

Driverless AIはAIを非技術系ユーザーのために民主化し抽象化する旅路の第一歩だ。ダウンロードして実験してみたい人は、ここからどうぞ。