【編集部注】著者のCarl Andersonは、“Creating a Data-Driven Organization”の著者。以前はWarby ParkerとWeWorkでデータ分析、データサイエンスを担当していたが、現在はWeWorkのプロダクト研究部門のメンバーである。もう一人の著者のTianhui Michael Liは、PhDたちやポストドクたちの、学界から産業界への移行を支援する8週間のフェローシップであるThe Data Incubator創業者。以前はFoursquareでデータサイエンスの収益化を指揮しており、Google、Andreessen Horowitz、JP Morgan、DE Shawでの勤務経験がある。

組織はデータを戦略的資産としてどのように活用できるだろうか?データとは高価なものだ。企業は、データの収集とクレンジング、ホスティングとメンテナンスを行い、データエンジニアや、データサイエンティスト、そしてデータアナリストの給与を支払い、様々な違反のリスクなどに備えなければならない。

必要なものは積み上がるばかりだ。しかし、もし成功すれば、繁栄するデータ駆動型組織は、大きな見返りを得ることができる。他の要因を補正した上で、MITのSloan School of ManagementのErik Brynjolfssonたちは、データ駆動型の企業は、データ駆動の不足している企業よりも、5〜6%高い生産量と生産性を備えていることを発見した。また、資産利用率、株主資本利益率および市場価値も高いことが分かった。また他の調査によれば、データアナリシスは1ドルの投資に対して13.01ドルの見返りがあるという。データ駆動型であることは十分に引き合うのだ!

データ駆動型であるためには、高品質のデータ、広範なアクセス、データリテラシー、適切なデータ駆動型の意思決定プロセスなど、多くの要素を結びつける包括的なデータカルチャーが必要だ。この記事では、こうしたいくつかの主要なビルディングブロックについて説明する。

事実の単一情報源

事実の単一情報源(a single source of truth)こそ、会社全体から参照することのできる、中心的で、コントロールされ、「恵まれた」データの源だ。それがマスターデータとなる。そのようなデータを持たず、スタッフたちが異なるシステムから似たようなメトリックを引き出すことができてしまうなら、必然的にそれらのシステムからは異なる数字が生成される。そうなると議論になってしまう。「あちらはああ言った、こちらはこう言った」という議論に巻き込まれて、それぞれの立場からの「事実」を引き出して自らの立場を守ろうとするシナリオに入るのだ。あるいは(そしてより残念なケースでは)よりましな情報源を使える筈だったのに、古くて品質の低い、あるいは間違ったデータや指標を知らずに使ってしまい、悪い決定を下すチームも出てしまうかも知れない。

事実の単一情報源を持っている場合には、アナリストや他の意思決定者といったエンドユーザーたちに、優れた価値を提供することができる。彼らは組織内でデータを探す時間が少なくて済むようになり、データの利用により多くの時間を割くことができるようになるからだ。さらに、データソースはさらに整理され、文書化され、統合される可能性が高くなる。したがって、関心のあるエンティティについてより豊富なコンテキストを提供することによって、ユーザはデータを活用し、応用可能な洞察を見つけることがやり易くなる。

データの入手先を知り、質の高いデータを提供することは、要素の1つにすぎない。

データ管理者側からみても、事実の単一情報源は望ましい。これによって、文書化を行うこと、テーブル間での名前の衝突を防ぐこと、データ品質チェックを実行して、基礎となるIDがテーブル全体で一貫していることを保証することが容易になる。また、さまざまな情報源からもたらされる可能性のある、主要な関係やエンティティに対する、俯瞰可能で簡単に作業できるビューを提供することもより簡単になる。

たとえば、コワーキングスペースのグローバルプロバイダであるWeWorkでは、アナリストたちに「アクティビティストリーム」と呼ばれるコアテーブルを提供している。これはWebページビュー、オフィス予約、ツアー予約、支払い、Zendeskチケット、キーカードのスワイプ履歴などを提供する、1つの絞り込まれたテーブルだ。このテーブルは、会員やロケーションに従って、ユーザーたちがスライスしたり細切れにするといった作業が容易にできるようになっている。実はこうしたデータは実際には様々な異なるシステムからやって来ているのだ。さらに、ビジネスのこの集中化された、全体的な視点を持つことで、これらのデータの上にさらに多くの自動化されたツールを構築して、多数の異なるセグメントの中にパターンを探すことができることを意味している。

大規模な組織では、歴史的な理由でデータがサイロ化されている場合が多い。例えば、大企業は、企業買収によって他社のデータシステムを取り込む可能性が高く、その結果独立したシステムが追加されていく。したがって、事実の単一情報源のためには、大規模で複雑な投資が必要となる可能性がある。しかし、そうした作業を進めている最中にも、中央データチームまたはオフィスは、公式な指針を提供することによって、大きな違いを生み出すことができる。例えば何がデータとして存在しているのか、それは何処にあり、また複数の情報源がある場合何処が一番取得するのに適した場所かなどだ。「お客様の注文データが必要な場合は、システムXまたはデータベーステーブルYを使用すること」そしてそれ以外には存在しないこと。が全員に徹底していなければならない。

データ辞書

データの入手先を知り、質の高いデータを提供することは、要素の1つにすぎない。利用者はデータフィールドとその値(メトリクス)の意味を知る必要がある。データ辞書が必要だ。これは多くの組織を躓かせる視点だ。メトリクスとその定義の明確なリストがない場合、人びとは心の中に仮定を持つことになる、おそらくそれらはそれぞれ、他の同僚が心に描いている仮定とは異なっている可能性があるだろう。そして議論が紛糾する。

ビジネスは明快で、曖昧さがなく、そして合意された定義に基く用語集を作り出す必要がある。このためには、全ての主要なステークホルダーとビジネスドメインの専門家との議論が必要だ。まず第1に、それらを公式な定義として賛同を取り付ける必要がある。各チームがそれぞれの秘密のメトリクスを使って裏作業をすることは望まないはずだ。第2に、人びとの理解が異なるのは、核になる定義ではなく、その周辺のエッジケースである場合が多い。このため、「注文受付」メトリクスについては全員が理解しているとしても、キャンセル、注文分割、不正についてどのように処理するかについての認識は、ズレている可能性がある。

これらのシナリオは、提示され、議論され、そして解決される必要がある。ここでの目標は、複数の類似したメトリクスを単一の共通メトリクスにまとめることだ。あるいは多くの側面に対応するために、ある1つのメトリクスを、2ないしそれ以上のメトリクスに分割する状況を具体化することだ。

中心的な情報源から明確なメタデータと共に、クリーンで高品質なデータが得られるとしても、もし担当者がアクセスできない場合には効果的ではない。

たとえばWeWorkでは、メンバーシップを検討している人たちは、ツアーに申し込むことで、施設内容を見学することができる。重要なことだが、複数のロケーションを見学したり、実際に契約を結ぶ前に同僚に見せようと2度目のツアーに申し込んでくる人もいる。私たちの様々なダッシュボードには、「ツアー」というメトリクスが表示されていたが、それらはチーム間で一貫してはいなかった。データ辞書を作成するプロセスで、2つの異なるメトリクスの具体化に繋がった。

- “Tours completed-Volume”(ツアー終了数)は、ツアーの絶対数を記録している。このメトリクスは、ツアーを担当するコミュニティチームがチェックしている。

- “Tours completed-People” (ツアー終了人数)は、ツアーに参加した重複を省いた人間の数をキャプチャしたものだ。これにより、営業チームとマーケティングチームが追跡する、リードコンバージョンメトリクス(成約率メトリクス)が得られる。

ここでは、適切に選択された名前の特定性と、例を伴った曖昧さのない定義が重要だ。ユーザーがわかった気になる短い名前よりも、”non_cancelled_orders”(取り消されなかった注文)や、”Tours Created To Tours Completed Conversion%”(予約に対して実施されたツアーの比率)」といった、長くても説明的な名前をよく考えてつけることが推奨される。

広範なデータアクセス

中心的な情報源から明確なメタデータと共に、クリーンで高品質なデータが得られるとしても、もし担当者がアクセスできない場合には効果的ではない。データ駆動型の組織は、すべてを取り込む傾向があり、データが助けとなるところであれば、どこへでもアクセスを提供する。ただし、これは全てのデータに対する鍵を、全てのスタッフに渡すことを意味するものではない。CIOがそんなことを許可することはない!そうではなく、これが意味するのは、アナリストや重要意思決定者に限らず、現場の最前線にまで及ぶ組織全体に渡って、個々人のニーズを評価するということだ。

例えば、処方箋眼鏡やサングラスの小売業者であるWarby Parkerは、小売店のフロアに入る提携会社たちに、店舗全体だけでなく、個別の業績の詳細を提供するダッシュボードも提供している。サンフランシスコの宅配業者であるSprigでは、注文された食事を分析したり、人気のある(あるいは不人気な)食材や味を理解し、メニューを改善するために、シェフたち自らが分析プラットフォームにアクセスすることもできる。

The Data Incubatorのフェローシップから、データサイエンティストを雇用しているある大規模なFortune 100金融コングロマリットは、データサイエンスチームへの広範なアクセスを許可することが、Google、Facebook、Uberなどの「セクシー」なシリコンバレー企業にも負けない、雇用上の魅力を保つことができている一因になっている。そしてそのアクセスは何もデータサイエンティストたちだけに止まるものではない。私たちの元同僚が取り組んでいたプロダクトの1つは、カスタマーサービス担当者たちに顧客との電話でのやりとりの履歴を視覚化して示す、サマリダッシュボードだった。

データ駆動型組織では、個々人がどんなデータが存在しているのかを知っているような文化を醸成する必要がある。

怒っている顧客に対面しているカスタマーサービスや、損傷したプロダクトを載せたパレット(荷物台)を目の前にした倉庫係といった現場のスタッフ自身が、データを即座に活用して、最善の次のステップを決めることができるようになるのだ。適切な権限を与えられれば、現場のスタッフは、状況を解決したり、ワークフローの変更を判断したり、顧客の苦情を処理したりするのに最適な立場にいるのだ。

データ駆動型組織では、個々人がどんなデータが存在しているのかを知っているような文化を醸成する必要がある。良いデータ辞書と、日々意思決定に使われるデータを見ていることがその役に立つ。そしてもし心から必要とするユースケースがあるのなら、データのアクセスを要求することでスタッフたちのやる気が高まることになる。適切な承認プロセスと監督機能があり、必要に応じてアクセス権限を簡単に取り消すことのできるようなシステムがあるならば、スタッフが飛び越える必要のある多すぎるハードルと不要な長すぎる遅延を取り除くために、お役所仕事は改めるべきなのだ。

最後に、より広範なアクセスと、分析ツールのユーザーを増やすことで、組織はトレーニングとサポートの提供に取り組まなければならない。WeWorkでは、Slack、電子メール、そしてサービスデスクのチケットを利用してデータチームを利用できる一方で、ビジネスインテリジェンスツール、SQLクエリ、およびデータに関するその他の側面について、ユーザーを支援するための物理的なオフィス開放時間を、毎週決まった時間に提供している。

データリテラシー

広範なデータアクセスを持つデータ駆動型組織では、スタッフは頻繁にレポート、ダッシュボード、分析結果を見ることになり、データ自体を分析するチャンスも得られる。それを効果的に行うには、十分なデータリテラシーを持っていなければならない。

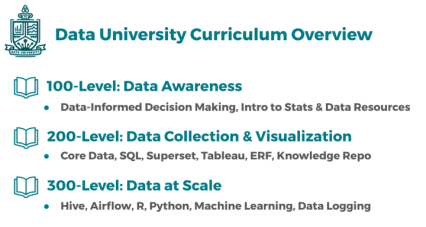

データリテラシーは、多くの場合多面的な取り組みだ(このトピックに関する優れた閲覧可能なオーバービューに関しては、Brent Dykesのこの記事を参照)。The Data Incubatorでは、さまざまなスキルレベルを持つ従業員と顧客を、それぞれに合ったアプローチで結びつけている。

最もエキサイティングな分野の1つは、データサイエンストレーニングだ。これは、レコメンドエンジンやその他の予測モデルなどのデータプロダクトを作成するだけではなく、データから洞察を引き出すための、先進的計算型データマイニングならびにマシンラーニングアプローチへの導入をカバーしている。これはより先進的なユーザーたちが、その競争領域の中で、ピラミッドの最高レベルのスキルへと集中する傾向になりやすい。私たちの多くのクライアントにとって最も素早く結果のでるものの1つは、既にデータサイエンティストの道を半分まで進んできた者たちに対して、残りの半分の部分を訓練することだ。

例えば、医薬品や金融の顧客は、データサイエンスの統計的側面には精通しているものの、計算機の活用の最前線には疎い統計学者たちを抱えている傾向がある。一方多くのテクノロジー企業は、統計的厳密さには欠けているプログラミング能力を、豊富に持っている。統計学者をプログラミングで訓練したり、プログラマに統計学者の訓練を施すことは、より広い範囲に適用することができる、素晴らしい「迅速な勝利」なのだ。

データは、既に行われた意思決定を支えたり(あるいは覆したり)するためにあるのではなく、将来の決定を助けるために存在している

そのようなスキルを持っていない人たちには、データリテラシーを高める機会が沢山用意されている。企業はデータリテラシー訓練をすべての人に必要なものと見始めており、過去12ヶ月間には「管理者向け入門データサイエンス」コースの需要が倍増している。最も簡単で簡単なレベルは、記述統計学の基本スキルを高めることだ。これらは、平均、パーセンタイル、レンジ、標準偏差といったデータを要約するための基本的な方法で、基礎となるデータの形が適切かあるいは不適切かを判別できる。

例えば、住宅価格や収入のようにデータに大きな偏りがある場合、平均値よりも中央値の方がデータを要約するのに適したメトリクスだ。ただ人びとを、想像上の思い込みを減らし、データをプロットして調べ、適切な要約メトリクスを使用するように訓練するだけで、大いなる成功となるだろう。

また別の成功がデータの視覚化スキルからやってくる。あまりにもしばしば、チャート上にはゴミが溢れかえっている。つまり、要点を損なう不必要な乱雑さや注釈などだ。あるいは、不適切なタイプのチャートが使われていることもある。多数のセグメントを持つ複数の円グラフや、解釈がほぼ不可能に近い色分けが選択されているものなど。

膨大な努力をデータの収集と分析だけに費やすのは悲劇だ、失敗が待っているだけだし、最終的なデータのインパクトも減じてしまう。ほんのわずかのデータ視覚化トレーニングだけでもとても役に立ち、人びとのプレゼンテーションスキルを大幅に改善し、洞察をより明確にし、より理解しやすく、そして最終的には利用される可能性を引き上げてくれる。

次に複雑なレベルのものは、推測統計学だ。これは、例えば週毎のウェブサイトのトラフィックの傾向や差異が、本物なのか、あるいは単なるランダムな変化なのかかどうかを検出するために使用される、標準的で客観的な統計的テストだ。ここでの目的は、マネージャや顧客サービス代理店がこれらのテストを実行できるようにするのではなく、彼らが統計がどのように使用できるかを認識し、相関関係と因果関係の違いを知り、予測には常に不確実性が伴うことを正しく理解させることだ。意思決定者やマネージャーにとっては、これはまた粗雑な仕事や、データから結論が導かれないような結果を、差し戻すための強力なスキルとなる。

意思決定

データは意思決定プロセスに実際に組み込まれている場合にのみ、影響を与えることができる。組織は、高品質、タイムリー、そして関連性が高いデータと、洞察と推奨を与えてくれる素晴らしいレポートを慎重に作成することができる、高いスキルのアナリストを揃えることができる。しかし、そのレポートが開かれないまま机の上に鎮座していたり、受信トレイで未読のままであったり、意思決定者がデータの内容にかかわらず、何をするのかを既に決めてしまっていたとしたら、すべては無駄である。

Avinash Kaushikによって提唱されたされた用語、HiPPO (“highest paid person’s opinion”:最高額報酬取得者の意見)はデータ駆動性へのアンチテーゼだ。全員にとってお馴染みのことだろう。彼らは何十年もの経験を持つ専門家だ。特にデータが彼らの先入観に反する場合には、データが何を言っているかは気にせず、彼ら自身の計画に執着する。なにしろ彼らは最善を知っているのだ、そして何はともあれ、彼らは上司なのだ。フィナンシャル・タイムズが説明しているように:

HiPPOは、ビジネスのためには致命的なものになる可能性がある。何故なら良く理解されていないメトリクスか、あるいは純粋に想像に基づいた決定を行なうことになるからだ。顧客インタラクションの全範囲から意味を抽出し、あるアクションの裏の動き、タイミング、場所、そして理由を評価するインテリジェントなツールを、HiPPOのアプローチは利用しないので、企業にとって重大な障害を与える可能性があるのだ。

しばしは組織というものは直感に価値が置かれたり、説明責任が欠如した文化が蔓延していることがある。ある調査によれば、意思決定者たちが組織における意思決定に説明する責任を負っていると答えたのは、わずか19%だけだった。HiPPOが繁栄しているのはそのような生態系だ。

HiPPOに対抗する1つの方法は、A/B試験などの客観的実験の文化を育むことだ。これらのシナリオでは、ウェブサイトのデザインやマーケティングメッセージの変更などにかかわらず、可能な限りコントロールを行い、成功判定のメトリクスと必要なサンプルサイズを決定し、要素の1つを変更して実験を行なう。ここで重要な点は、明確な分析計画を立てて、実験を実行する前に成功のメトリクスと予測値を設定することだ。言い換えれば、計画を立てるによって、結果が出た後にHiPPOがいいとこ取りをすることを防ぐのだ。これはどんなパイロットプログラムでも同じだ。

幅広いデータリテラシー訓練の価値の一部は、ビッグデータに対して認識された脅威から生じる恐れを、和らげてくれることだ。データは、既に行われた意思決定を支えたり(あるいは覆したり)するためにあるのではなく、将来の決定を助けるために存在している。それはマネージャーの仕事を脅かすことはしない、むしろそれを無視することで、脅かされることになるだろう。データサイエンスの訓練は、データの働きを解明することで、データに対するマネージャの自信を深め、企業におけるデータ駆動型の意思決定を高めることができる。

おわりに

私たちは雇い主とクライアントの両方の仕事を通して、データ駆動型の文化は一晩で達成できるものではなく、複数のステップのプロセスの一部であることを学んだ。第1に必要なのは、分析対象となる、クリーンで単一のデータソースである。次に、データアナリストとデータサイエンティストたちは、データ辞書とそのデータの意味に同意する必要がある。次に、データ分析に対してビジネスの専門知識を適用するためには、データサイエンティストたちだけでなく、組織全体がこのデータに幅広くアクセスする必要がある。データへのアクセス権が与えられると同時に、データリテラシーを強化するための適切なトレーニングが必要となる。そして最後に、意思決定に影響を及ぼすために、これらのすばらしいデータ分析をすべて、データを信頼するマネージャーの手に渡す必要があるのだ。

[ 原文へ ]

(翻訳:Sako)