私たちは皆アートについて何らかの意見がある(例えその意見がただ、理解できない、というものであるとしても)。しかし投資対象としてのアートについてはどうだろうか?

YCombinatorに、現在在籍しているスタートアップの1つであるArthenaは、投資家がアートから確かな収益を挙げることを助けることができると言う。創業者兼CEOの Madelaine D’Angeloによれば、Arthenaは当初アートを買い付ける、投資型クラウドファンディング(equity crowdfunding)として立ち上げられた。そして最近「アート市場に対する量的戦略に対応する」ファイナンスツール群を追加した。

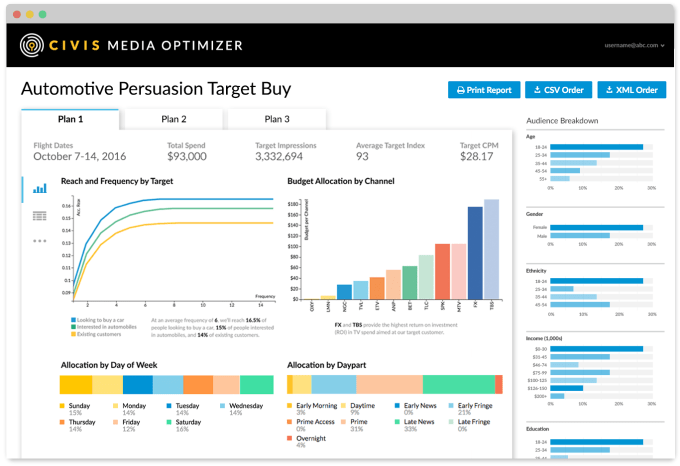

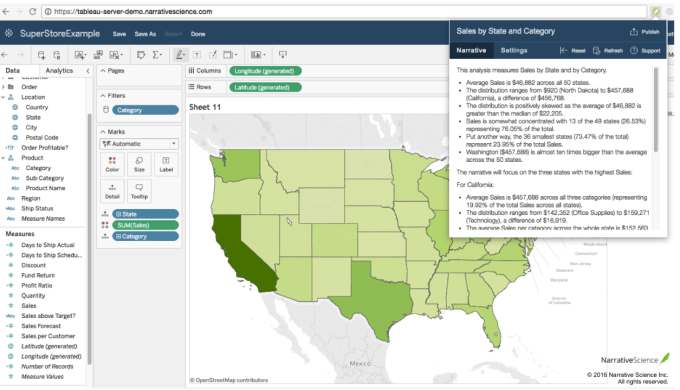

特に、Arthenaは、作品の作家自身、作家のキャリアと活動年数などの要素に着目して、アートオークションの結果と組み合わせ、ある作品に対するリスクと投資利回りを予測する。この分析により、投資家たちは自身のリスク許容度に基いて、異なるArthenaのファンドに投資することが可能になる。

D’Angeloによれば、Arthenaはこれらのツールを必要に迫られて作ったのだという。ウェルスマネージャーたちや、有力な投資家たちが興味を持ってくれたものの、何より先に「ヘッジファンド相当の分析結果」を提供する必要があったのだ。

D’Angeloは、美術界がArthenaの数字を基にしたアプローチに懐疑的だろうと認めた。しかし彼女は、同社はいつでも「その最終決定を助けるループの中に人間を介在させる」と語った。また彼女は、彼女自身の目標は、アートバイヤーやアーティストの価値を貶めようとするものではなく、「市場の規模を大きくしたい」というものだと語った。

「収集と投資は完全に別々の2つの活動ですが」と彼女は語る。「その情緒的側面を切り離すことはとても難しいことです。もしそれを、数字に基かない視点から眺めていたら、市場の本当に素晴らしい機会を見落とすかもしれません。あるいは、自分が引き付けられるものに対して、過剰に払いすぎてしまうかもしれません」。

結局、なぜアートに投資するのだろうか?D’Angeloは、アート市場の魅力は、株式市場の上下動にあまり縛られずに、印象的なリターンを提供してくれるところだと語った。

Arthenaは、アート市場の標準的な年間利回りである10%を、倍にすることが可能だと言う。そして投資家たちの興味を確かに引いているようだ。同社は数ヶ月前に現在のアプローチに切り替えてから、既に2000万ドルのコミットメントを受け取っている。

D’Angeloはまた、他のアートスタートアップは通常「アートの世界世界のみ、あるいはテクノロジーの世界のみ」の出身者で占められているが、Arthenaは両者を兼ね備えていると語る。アートの世界におけるD’Angeloの経験と、彼女の兄弟でありデータサイエンスのバックグラウンドを持つCTOのMichael D’Angeloが、彼らを「この問題に取り組むためのユニークな資質」を提供しているのだ。

[原文へ]

(翻訳:sako)