幅広い人工知能ベースのスタートアップが市場に参入してくるのを眺めていると、果たしてAIシステムというものは人間と同様の意思決定ができるのだろうかという、拭えないそして大きな疑問が湧いてくる。

ケンブリッジ大学からのスタートアップであるProwler.ioは、確率的モデリング、強化学習、ゲーム理論に基づいた新しい種類の意思決定プラットフォームを開発している。上の疑問に対してAIコミュニティが肯定的な回答をすることを期待してのことだ。

Prowler.ioは、また別のAI企業であるVocalIQの元従業員である2人の人物によって創業された(VocalIQはローンチの13ヶ月後にAppleによって買収されている)。同社は本日(米国時間9月4日)その拡大のために1000万ポンド(1300万ドル)を調達したことを発表した。

新しい投資者であるCambridge Innovation Capitalに主導された今回のラウンドには、Atlantic Bridgeだけでなく、昨年の200万ドルのシードラウンドにも参加したPassion Capital、Amadeus Capital Partners、そしてSG Innovateも参加している。

人工知能はますます混み合った領域になりつつある。CB Insightsは、2016年には550社のスタートアップが658件の取引を行い、50億ドルの資金調達を行ったものと推定している。この数字は、わずか160件の取引しかなかった2012年に比べて60%増加している。これらのスタートアップに加えて、さらに立ち上がろうとする企業たちや、Google、 Apple、Amazon、Facebook、Baidu、そしてMicrosoftのような大きなテクノロジー企業がAIテクノロジーに投資を進めている。

AIはまた買収に向けての成熟も遂げている領域だ。多くの大規模テクノロジー企業は、新しいタレントを取り込み、彼らが既に作り上げたものを手に入れるために、AIスタートアップたちを買収している。CB Insightsによれば、2012年以降AIに焦点を当てたスタートアップが、250社以上買収されていることを指摘している。

Prowler.io自身は、そうした競合相手たちからは距離を置いていると認識している。何故なら現在AIの最大領域である認知機能(コンピュータービジョンや画像認識に関係)には焦点を当てず、意思決定の領域に注力しているからだ。

「当社にとって重要なことは、他の大きなAI企業が何に取り組んでいるのかではなく、何に取り組んでいないのかということです」と語るのはCEOのVishal Chatrathだ。ChatrathはProwlerをVocalIQのキーメンバーであったDongho Kim博士(現在はProwlerのCTO)と一緒に創業した。

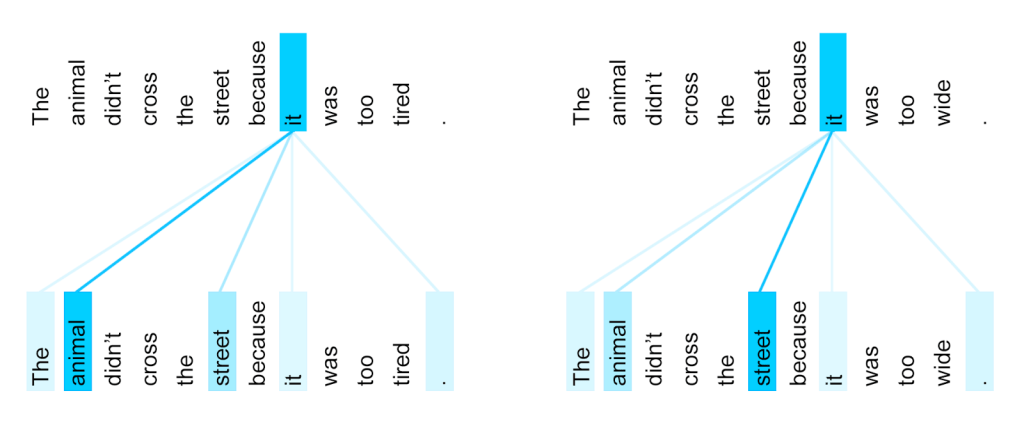

“Big 5″(Google、Apple、Amazon、Facebook、Microsoft)や機械学習を採用する企業たちを眺めると、彼らは皆膨大なデータを利用したディープニューラルネットワークに集中している、とChatrathは言う。「これらは分類と知覚の問題を解決するためないは素晴らしい力を発揮します。これを使えば犬を犬であると言うことができるのです。そうやって、あなたが一旦世界を分類したら、何が何かはわかってしまいます。しかし、意思決定のギャップは残されたままなのです」。

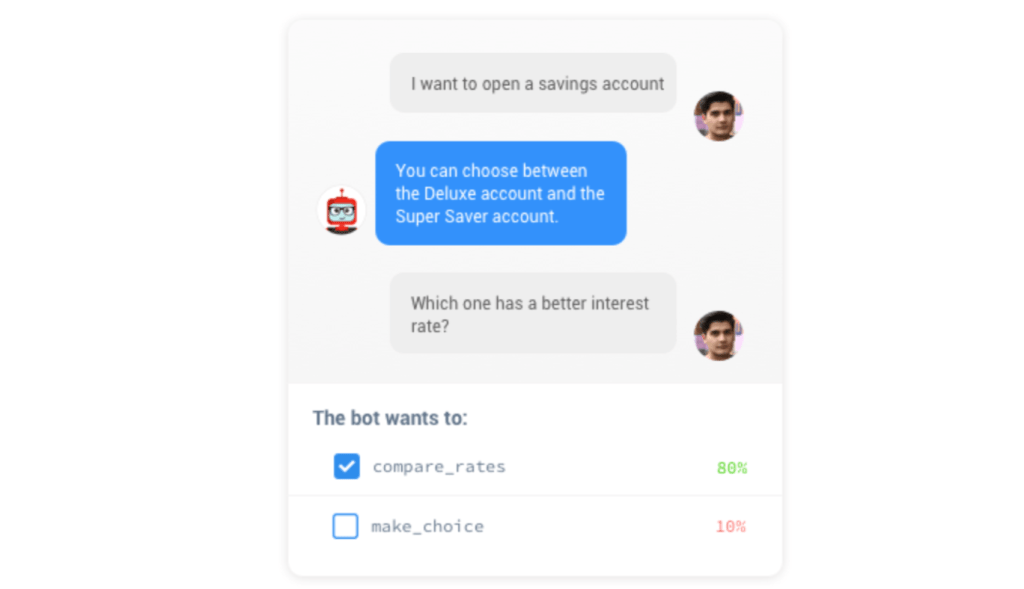

問題は、ディープニューラルネットワークにはある種の意思決定を教えることはできるものの、それらは依然としてシステムを訓練するために多くのデータに依存しているということだ。「現実世界では、何千万ものデータを得るという贅沢は考えられません。あなたが行なうすべての選択には、ダイナミックな環境におけるマイクロ意思決定が含まれています」。

(かつてはNokiaの自動車関連部門の責任者でもあった)Chatrathが説明しているように、自動運転システムは車の周囲で起きる全てのことを検知することは可能だが、その中でシステムが何に注目し、運転上の決断をする際に何を評価をすべきかは遥かに難しい問題だ。また、知覚と評価に関する同様の課題は、他の多くのシナリオにも適用できる。

Prowler(直訳では「餌などを求めて徘徊する者」という意味:という名前は、この問題を解決するために、あらゆる角度からの挑戦を行なうという姿勢を表したものだ)は、この問題に対して、従来の機械学習の上に構築される数学と統計からの学びに着目している。

そのプラットフォームが利用するものは「新しい状況に対して一般化され、データ駆動を用いることで戦略を洗練し変化する環境に適応していく」確率的モデル、不確定性を推定し考慮する強化学習アルゴリズム、そしてマルチエージェント環境で他の人間やAIがどのように振る舞おうとしているのかを推定するゲーム理論だ。

ゲームチェンジャーとしての可能性は秘めているものの、その開発はそれほど迅速には進んでいない。Prowlerは、著名な学者たちをたくさん雇っているものの、まだ製品化は行われておらず、契約した顧客もいない(Prowlerそのものの話を始める前から、インタビューの最中にもChatrathが誇らしげに語ったことは、同社が際立つ実績を持つ教授や研究者たちを、その50人の従業員のなかに擁しているということだった)。いずれにしても、見込み客の中には開示できない潜在的な顧客が複数含まれている。

「NDAを交わして契約を締結するための複数の交渉に入っているところです、ゲーム業界の中の1つとは最終段階に差し掛かっています」と彼は語った。配車業界や金融業界からも多くの問い合わせが寄せられて来ている。注目すべきことに、これまで寄せられた問い合わせはすべて、先方から自発的に送られてきたもので、口コミに基くものであったということだ。

Prowlerが現在取り組んでいることの1つは、学習エンジンと意思決定エンジンという2つの部分からなるプラットフォームのための最高のアーキテクチャの構築だ。スタートアップは学習エンジン自身は自社で抱え、意思決定部分を顧客と構築する考えだったが、データを変更できるようにサンドボックス化を望む企業もある。

一方、同社は投資家たちの支援を受け続けており、このプラットフォームを立ち上げて、現在世の中にある意思決定のための他のソリューションよりも、意思決定を本当に効果的に進めることができるかどうかを示す必要に迫られている。

Cambridge Innovation Capitalの投資責任者であるAndrew Williamsonは、その声明の中で次のように述べている「PROWLER.ioは、現在最も扱いにくい問題に挑戦するために、世界レベルの研究者たちを集めました。ケンブリッジ大が擁する、確率的モデリング、機械学習とゲーム理論の専門知識を活用できることは、非常にエキサイティングです。重要問題の解決に適用される、PROWLER.ioのチームとテクノロジーの組み合わせは、同社にとって大きな商業チャンスを生み出すことでしょう」。

[ 原文へ ]

(翻訳:Sako)