今年のI/O開発者カンファレンスでGoogleが自社の仮想現実ヘッドセットをローンチするかはまだ分からないが、最新バージョンのモバイルOS「Android N」ではVRアプリ専用モードを搭載することが分かった。

このモードでは、VRアプリをフォアグランドで使用する時、アプリが端末のコアプロセッサーへの独占的なアクセスを確保する。センサーパイプラインを改良したこと、そしてAndroidのVulkanグラフィックAPI対応を行ったことで、GoogleはNexus 6PにおけるVRモードのレイテンシーをおよそ20ミリ秒にまで短縮することができたという。この数値はモバイルVRで最も高い水準だと言える(Gear VRの駆動する水準と同等だ)。

「Androidの開発を始めた時、このように多様なユースケースまで想定していませんでした」とAndroidの開発VPであるDavid Burkeは私には話した。VRではレイテンシーが最も大きな課題だったという。 Burke が「モーションとフォトンの比率」と呼ぶこの問題は、VRヘッドセット、特にモバイルのVRにとって長いこと課題だった。ユーザーの頭の動きと画面上の映像との遅延が大きいほど、ユーザーはそのシーンの中にいるように感じられなくなる(酔って気分が悪くなってしまうこともある)。

改良の余地はいつでも残っているものだが、レイテンシーを20ミリ秒に抑えることが快適に使用するために重要な水準だと考えられてきた。OculusのCTOであるJohn Carmackは、この水準での遅れなら「たいてい感じられない」と言う。他のOculus、HTC、Sonyといった高価格帯のヘッドセットではより高度なグラフック要件が必要だが、レイテンシーの水準はだいたい同じくらいだ。

この新たなVRモードでは、アプリはスマホのCPUとGPUにおける全ての処理能力にアクセスがあり、画像を可能な限り素早くレンダリングする。また、Googleのチームは単一のバッファーを使用し、アプリが画面上でスキャンラインを追うようにすることで、画像のバッファー方法を変更した。

また、VRモードはOculusのTime Warpingと似た手法を採用している。画像を表示する直前にユーザーの頭の動きを検出して画像を構築し、随時現在の頭の位置を確認して、素早くその位置に合うように画像を調整している。

もし手持ちのスマホディスプレイが残像を最小にできないのなら、この機能は役立たないだろう。なぜならピクセルの色が十分な速度で変わることができず、動きがほとんどぼやけてしまうからだ。

今回Googleが注力したのはパフォーマンスの改良であることは明らかだが、Googleのチームはこのモードに他の機能も付け加えた。例えば通知の他にアラームや着信も確認することができる。これらは全てステレオ投影3Dでレンダリングしたカードで通知する。

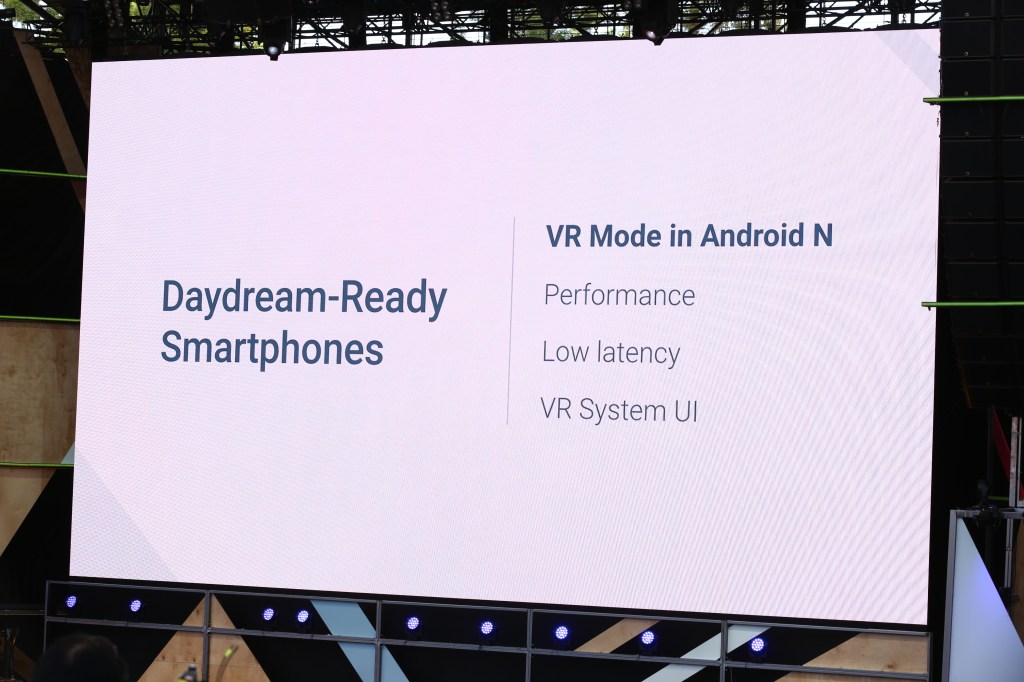

GoogleはこのVRプラットフォームを「Daydream」と名付けた。GoogleはVRモードの他に、これに対応するヘッドセットやコントローラーなどのハードウェアを認定していくという。Googleは、VR体験の中で利用できる特別なPlayストアを構築し、すでにNew York TimesやNetflixといった複数のアプリ開発者と協力して、Daydreamアプリを開発している。Googleは自社のPlayアプリ、 StreetView、YouTubeとGoogle Photosもこのプラットフォームに持ち込む計画だ。

Daydreamプラットフォームは今年の秋にローンチ予定だ。

GoogleはAndroid VRに最初から対応しているスマホ端末も認定する。もちろん、Googleのフラグシップ端末であるNexus 6Pに最初の認定レーベルが付く。Googleは、Samsung、HTC、LG、Huawei、ZTEからもVR対応のスマホを提供し、他のスマホも認定していく予定だという。

[原文へ]