GoogleがGlassの実証研究を再検討するなか、スタンフォードの研究者らはこの端末を自閉症の子供が感情を認識し、識別するのを助けるために活用している。

スタンフォード大学の事務所ビル内にひっそりと存在する小さなオフィスでCatalin VossとNick Haberは、自宅でも自閉症の治療を続けられるよう、顔を認識してトラックする技術と機械学習を組み合わせる研究を行っている。この Autism Glass Project(自閉症治療のGlassプロジェクト)は、スタンフォード医科大学院のWall Labの取り組みの一つで、月曜日の午前中に研究の第2フェーズをローンチしたと伝えた。

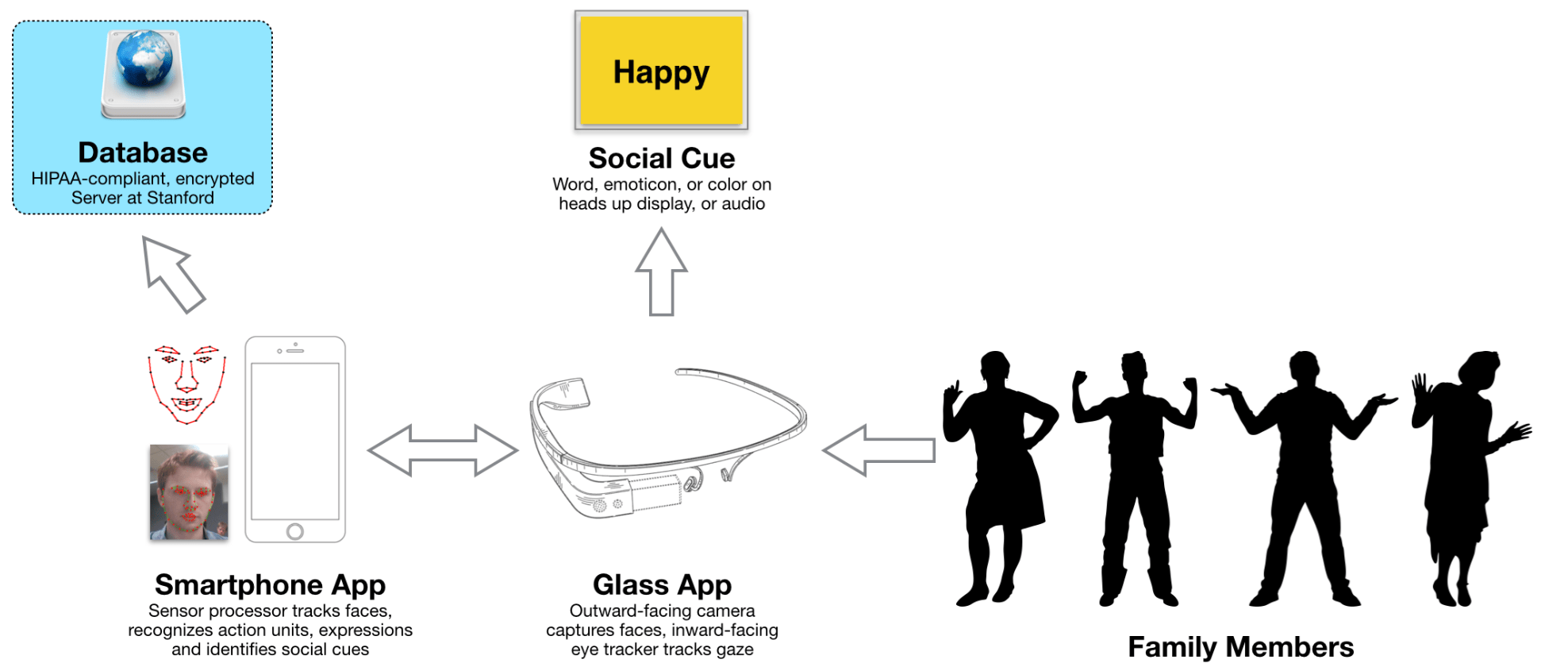

このソフトウェアは機械学習を活用して、Vossが顔の「アクション・パーツ」と呼ぶ特徴を検知して抽出する。

プロジェクトの第2フェーズでは、100人の子供を対象とし、自閉症を自宅で治療するためのシステムの有効性を調査する。Autism Glass Projectのソフトウェアは、端末が向けられた人の顔の感情を識別し、端末を装着しているユーザーに対してその人の表情を言葉で表す。

画像認識を活用して感情を子供たちのために翻訳することは、ほんの最初のハードルに過ぎない。チームが取り組んでいるさらに大きな課題は、子供たちが端末から学び、最終的に端末がなくても良いようにすることだ。

「いつも装着していなければならないものにはしたくありませんでした」とHaberは強調する。

端末がない状態での学習を検証するため、チームはプロジェクトの第1フェーズを昨年ローンチした。その間、研究所内で40の研究を行った。当初、Wall Labは一台のGoogle Glass端末しか所有しておらず研究には制限があったが、Google がさらに35台の端末を寄付したこと、そして今年の6月初旬にはPackard Foundationが37万9408ドルをこのプロジェクトを補助金として寄付したことで状況は好転した。

![Screen_Shot_2014-09-15_at_5.27.53_PM[1]](https://tctechcrunch2011.files.wordpress.com/2015/10/screen_shot_2014-09-15_at_5-27-53_pm1.png?w=1024&h=604)

子供たちとコンピューター画面とのインタラクションを研究した後、チームは子供たちが「周囲の環境と関わる」ことができる第2フェーズを設計したとVossは話す。彼らのチームは、MITのMedia Labが開発した「Capture the Smile(笑顔をつかまえよう)」というゲームを研究に採用した。

このゲームでは、Glassを装着した子供たちは特定の表情の個人を探す。このゲーム内のパフォーマンス、そして動画分析とクイズ内容を合わせてモニタリングすることで、各研究参加者の持つ自閉症の「数量的な自閉症状の表現形」を導き出すことができる。自閉症状の身体的な表れを数値的に観察することで得られるものだ。それを長期間トラックしていくことで、チームは端末を利用することで子供たちの感情認識を助けていることを実証することができるだろう。

研究の第2フェーズは数ヶ月間に渡って行う予定だ。このプロジェクトの独自のテクノロジーにより自閉症の治療プロセスに保護者が深く関わることが可能となる。

「子供が母親にどれくらいの割合で話をしているかや、子供が母親を見ている時間などを知ることができます」とVossは言う。

この研究で子供たちは、Google Glassの端末を日に3回、毎回20分ほど装着する。Wall Labの研究者にとってそれだけの時間でも、子供たちが何を見ているかを分析することで視覚的な関わりが感情を認識するプロセスにどのような役割を果たしているかを深く理解にすることにつながるという。

プロジェクトの第2フェーズはおおがかりのようだがVossと彼のチームにとってこれはまだ多くあるステップの内の最初の方だという。Wallはこの治療法が補償され、広く利用できるようにするためには、臨床データを集め、米国医師会の承認を得る必要があるという。

Wall はこのテクノロジーが広く臨床の場で使用が認められれば、このチームの自閉症治療のボトルネックを広げるという目標を達成できると話す。現在この研究には100名ほどの参加者がいるが、研究を続けることでこれまでにない広範なデータセットを獲得し、ソフトウェアと技術を改良していくことができるだろう。今日から彼らのウェブサイトで、プロジェクトの参加希望者の受け付けを開始している。

彼らのテクノロジーが広まるのはもう少し先のことだが、この技術は自閉症のスーパーヒーローを描いた小説のシリーズにも取り上げられている。Alexei Russell著の「Trueman Bradley」シリーズの2つ目の本で、主人公は感情を「見る」ことができる眼鏡を受け取る。これは、Voss、Haberと彼のチームへの賞賛だ。

「考えてみると、私たちは自閉症の子供たちにスーパーパワーを与えているのとそう違わないようです」とVossは話す。

[原文へ]