高齢者をたくさん乗せた自動運転車は、横断歩道上の子犬たちを避(よ)けるために、障害物に衝突すべきか?(上図左)。一人の医師を救えるなら、二人の犯罪者を轢(ひ)いても構わないか? どちらの命が重要か?7歳の子どもたちか、高齢者たちか?

この、MITの研究者たちが作った“Moral Machine”というゲームは、有名な“トロッコ問題”の決断を迫り、あなたの倫理観をテストする。今エンジニアたちが、このような状況における決定を、自動運転車に実装しようとしているなら、問題はさらに深刻だ。その選択の責任を、誰が追うべきか? 運転に関わっていない乗客か? AIを作った企業か? それとも誰も責任を追わないのか?

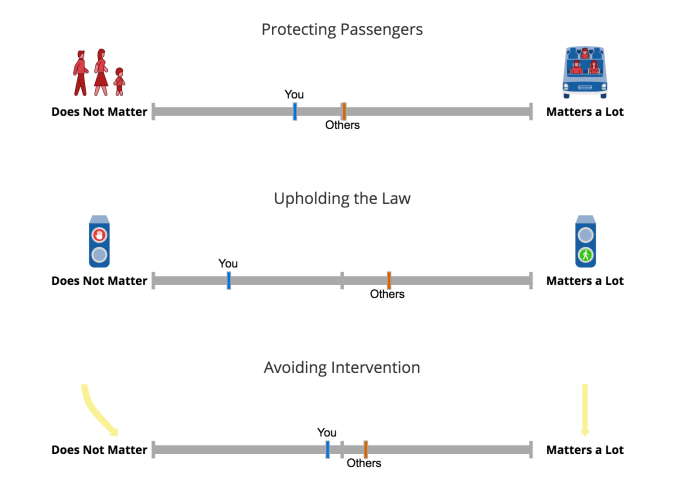

Moral Machineがつきつける選択は、そもそもAIは、より多くの人名を救えるなら介入すべきか、それとも、誰かの死がAIの責任にならないために、積極的には何もすべきでないか?という問だ。

しかしこのシナリオの状況は、もっと難しい。乗客は本質的に危険な、高速の金属箱に、それと知りつつ乗っているのだから、歩行者の方を救うべきか? 無防備な歩行者に突っ込むよりは、エアバッグなどの安全装置に期待して障害物に衝突すべきか?

こんな単純で分かりやすい状況でも、人間にとって決断が難しいなら、混乱した路上における自動運転車にとっては、なおさらだろう。