SEOの基礎は、過去15年間、大きく変化したことはない。それでは、合言葉「質の高いコンテンツを作り、質の高いリンクを得る」も変化していないのだろうか、あるいは、変わったのだろうか?

SEOの基礎は、過去15年間、大きく変化したことはない。それでは、合言葉「質の高いコンテンツを作り、質の高いリンクを得る」も変化していないのだろうか、あるいは、変わったのだろうか?

今回は、2013年に使命を終え、永遠の眠りについた5つのSEOの「基礎」を挙げていく。いまだに利用しているものがあるなら、今こそ卒業し、2014年に見合う取り組みに改めるべきである。

1. キーワードは検索結果にとって鍵になるワード

2013年に9月23日、グーグル経由のリファラーの文字列内のキーワードが反映されなくなり、「not provided」化が完了すると発表されると、大勢のウェブマスターが一斉に落胆した。しかし、検索において、キーワードではなく、意図が最も重要である点を見過ごしている人達が多い。過去においても、意図は重要であったものの、SEOの関係者は、キーワードを意図の代わりに用いていた。

誰かがキーワード「buy」(買う)を使っているなら、そのビジターは、何かを買おうとしているはずである。これは理に叶った推測である。しかし、検索エンジンのアルゴリズムが進化を遂げる中、平均的な検索エンジンのユーザーは、クエリに「買う」を入れなくてもよい点に気づくようになった。都合よく表示された買い物の結果をクリックする、あるいは、いっそのこと、検索エンジンをスキップし、Nextag等の(買い物)専門の検索エンジンを用いればよい。

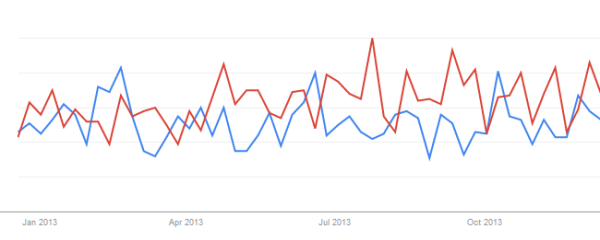

まだ信じられないなら、グーグルトレンドを確認してもらいたい。キーワード vs 買う + キーワードを比較すると、製品(キーワード)に対する関心は高まっているものの、製品に「買う」を加える傾向は下火であることが分かる。以下に分かりやすい例、「power tool」(赤)と「buy power tools」(青)を紹介する。その気になれば、このようなデータは容易に掘り起こすことが出来る。

「Buy Power Tools」と「Power Tools」をグーグルトレンドで確認

2. ジオロケーションのキーワードは重要

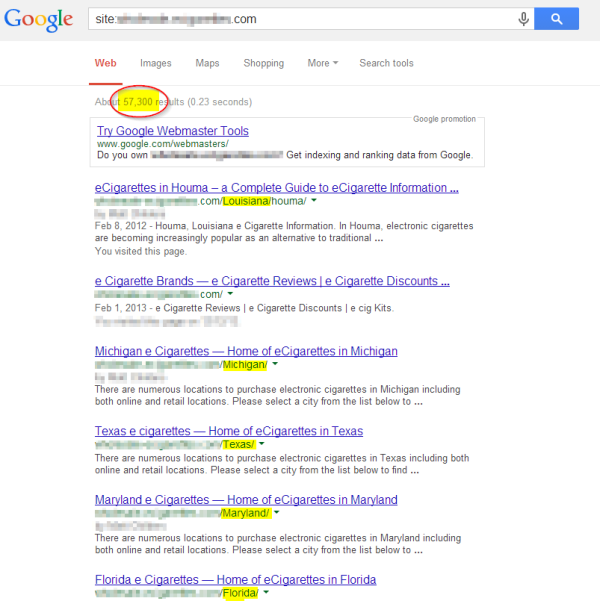

サイトを特定の街の検索結果に表示させたい場合は、キーワードを使って街、または、街と州を特定するページを作ればよかった。その結果、次のようなページが、インターネット上に次々と姿を現すことになった:

この手法は、「薦められない」どころではなくなった。パンダアルゴリズムに、狙われるようになったのだ。そのため、今後は、地域の認証した住所に対するプロフィール(グーグルプレイス/ページ等)を用意しなければならない。

また、schema.orgのタグ(またはHcard等)を使って、住所をマークアップする作業も求められる。どういう風の吹き回しか、検索エンジンは、オフィスの住所が、ノースカロライナ州のローリーだと、その他の地域よりもこの場所に対して関連性が高いと考えるようになった — クライアントの大半は、ノースカロライナ州の会社ではないにも関わらず。そのため、ここでも常識が通じなくなっている。

この問題がすぐに解決されることを望む。やはり、検索エンジンのユーザーは、さらに経験を積み、街の名前を入力することなく、地域の結果を得る方法を習得しつつあるためだ — ただし、当然ながら、現在の場所とは異なる地域の結果を求めている場合は、話は別である。…少し脱線してしまったようだ。この問題はやがて解決されるとは思うが、今のところ、有益な代わりの解決策は見当たらない。

3. 302 リダイレクトはSEOの役に立つ

かつて、検索エンジンは、四六時中サイトをクロールしているわけではなかったため(現在のように1日に数回ではなかった)、302 リダイレクトがSEO目的で使われることがあった。長期間にわたって維持するつもりではない変更をページに加える際は、302 リダイレクトを投稿して、検索エンジンが、過去のURLに戻る前に、リスティングを変えないように指示していた。

検索エンジンに新しいURLに全ての被リンクを更新してもらいたくないことが、SEOにおける本当の理由であった。この点は、w3.orgでも示唆されている: 「302 Found… リクエストされたリソースは一時的に別のURLに格納されている。リダイレクトは、時折変わることがあるため、クライアントは、今後のリクエストのためにRequest-URIの利用を継続するべきである。Cache-Controlヘッダーフィールド、または、Expiresヘッダーフィールドで指示されている場合のみ、このレスポンスはキャッシュ可能になる。」

その後、今度は、グーグルが、2012年の8月、ジョン・ミューラー氏の発言を通して、302に関する処理を明言した: 「302には今でもページランクを回すことがある。要するに、リダイレクトされたURLを維持し、リダイレクトされたURLのコンテンツを利用する可能性がある。」

2013年では、サイトに質の低いリンクが向けられていることを理由にペナルティーを課されるサイトが増え、実際にこの取り組みの成果が表面化するようになった(特に目立ったのは、302を使って、ページランクの流れを止めようとすることが多いアフィリエイトリンク)。

4. 404 エラーページは期限切れのページに取っておくべき

スパマーの息の根を止めるグーグルの取り組みにおいて、これもウェブマスターにとって迷惑な展開の一つに数えられる。多くのサイトが、コントロールすることの出来ない被リンクに対処し、目的地のページを404または410の結果に向かわせなければならなくなった。グーグルの強制的なペナルティーにより、ウェブ上には大量のリンク切れが発生するようになった。

ユーザー体験においては好ましくないものの、サイトに入ってくるリンクをコントロールすることが出来ないなら、そして、ウェブマスターに削除してもらえないなら、グーグルに再び認めてもらうには、404ページを利用するしかない。質の低いリンクを否認することが出来るとグーグルは言うが、その一方で、リンクを削除するために、まずは努力しなければならないとも言っている — しかも、経験上、スプレッドシートで「反応なし」を立て続けに報告するだけでは、十分な努力とは認めてもらえない。

site: レベルで検索結果を見てみると、この問題がどれだけ大きくなっているのかが、よく分かる — とりわけ、多数のプレスリリースを配信したものの、後になって、そもそもプレスリリースを同時配信した側のウェブマスターからプレッシャーを受け、削除せざるを得なくなったニュースサイトはひどい目に遭っている。

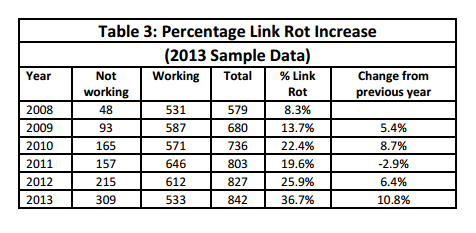

リンク切れは深刻な問題であり、グーグルがさらにこの問題に拍車をかけている。リンク切れの数が、今後の数ヶ月間でどのように変化するのか興味深い。しかし、(今月リリースされたばかりの)この調査結果から、ハッキリとした傾向を見ることが出来る:

Chesapeake Digital Preservation Groupが行ったリンク切れ調査 2013年度版

5. 被リンクは害にはならない

これは2012年および2013年に姿を消したSEOの常識の中で、恐らく最も規模が大きいと言えるだろう。2007年10月、Wysz(当時有名なグーグルのスタッフ)は、このように述べていた : 「スパムサイトにリンクを向けられることで、ランクが落ちるのではないか?と心配する必要はない。(大方)サイトにリンクを張る行為をコントロールすることが出来ない点は、グーグルもよく理解している。」

しかし、今週、グーグルのスパム対策を統括するマット・カッツ氏は、次のように指摘していた: 「スパムを本気で止めたいなら、少し意地悪に思えるかもしれないが、スパマーを再起不能になるまで叩きのめす必要がある。」このメッセージに対して、「hGn」が分かりやすいコメントを残していた: [グーグル]の実験の巻き添えを食らった犠牲者は、アルゴリズムが止めようとした、あるいは、失望させようしたスパマーだけではない。

SEOコンサルタントとしての立場から言わせてもらうなら、徹底的に打ちのめされたのは、何をするのか分からない状態で、スパマーを雇ってしまった会社である。スパマーはとっくに次の犠牲者にターゲットを移している。

と言うわけで、今回は、憂慮すべき2013年のSEOの変化を紹介した。確かに、ビジターが活用し、シェアしたくなるような質の高いコンテンツを作る取り組みは、美しく、利他的で、理想的な目標ではある。しかし、検索エンジン(特にグーグル)が、新たなSEOのベストプラクティスが、意図した通りの効果を発揮するまで、スパマーとの抗争を中断してくれるとは、私にはどうしても思えない。2014年こそは、良い年になることを願っている。

イメージはライセンス契約の下Archology Inc.から利用した。

この記事の中で述べられている意見はゲストライターの意見であり、必ずしもサーチ・エンジン・ランドを代表しているわけではない。

この記事は、Search Engine Landに掲載された「5 “Foundations” Of SEO That Were Torched In 2013」を翻訳した内容です。